2025. 4. 25. 10:10ㆍDiffusion

Rich Human Feedback for Text-to-Image Generation

Google Research

Abstract

Stable Diffusion 및 Imagen과 같은 최근 Text-to-Image (T2I) 생성 모델은 텍스트 설명을 기반으로 고해상도 이미지를 생성하는 데 상당한 진전을 이루었습니다.

그러나 생성된 많은 이미지는 여전히 아티팩트/불합리성, 텍스트 설명과의 불일치, 낮은 미적 품질과 같은 문제를 겪고 있습니다.

대규모 언어 모델에 대한 Reinforcement Learning with Human Feedback (RLHF)의 성공에 영감을 받아, 이전 연구들은 생성된 이미지에 대한 피드백으로 인간이 제공한 score를 수집하고 reward 모델을 학습하여 T2I 생성을 개선했습니다.

이 논문에서는 (i) 텍스트와 일치하지 않거나 일치하지 않는 이미지 영역을 표시하고, (ii) 텍스트 프롬프트에서 어떤 단어가 잘못 표현되었거나 누락되었는지 주석을 달아 피드백 신호를 풍부하게 합니다.

우리는 18K 생성 이미지 (RichHF-18K)에 대한 풍부한 인간 피드백을 수집하고, 멀티모달 트랜스포머를 학습시켜 풍부한 피드백을 자동으로 예측합니다.

우리는 예측된 풍부한 인간 피드백이 이미지 생성을 개선하는 데 활용될 수 있음을 보여줍니다, 예를 들어, 고품질 학습 데이터를 선택하여 생성 모델을 파인튜닝하고 개선하거나, 예측된 히트맵이 있는 마스크를 만들어 문제가 있는 영역을 인페인팅함으로써 가능합니다.

특히, 개선 사항은 인간 피드백 데이터가 수집된 이미지 (Stable Diffusion 변형)를 생성하는 데 사용된 것을 넘어 모델 (Muse)에도 일반화됩니다.

RichHF-18K 데이터 세트는 GitHub repository에서 공개될 예정입니다

1. Introduction

Text-to-image (T2I) 생성 모델 [12, 17, 41, 42, 56, 58, 59]은 엔터테인먼트, 예술, 디자인, 광고 등 다양한 분야에서 콘텐츠 제작의 핵심이 되고 있으며, 이미지 편집 [4, 27, 44, 50], 비디오 생성 [23, 35, 53] 등 다양한 응용 분야에서도 일반화되고 있습니다.

최근의 상당한 발전에도 불구하고 출력물은 여전히 아티팩트/불합리성, 텍스트 설명과의 불일치, 낮은 미적 품질과 같은 문제를 겪고 있습니다 [30, 52, 54].

예를 들어, Stable Diffusion 모델 변형에 의해 생성된 이미지로 주로 구성된 Pick-a-Pic 데이터셋 [30]에서는 많은 이미지(예: 그림 1)에 왜곡된 인간/동물의 몸 (예: 다섯 손가락 이상의 손을 가진 인간의 손), 왜곡된 물체 및 플로팅 램프와 같은 불가능성 문제가 포함되어 있습니다.

우리의 인간 평가 실험에 따르면, 데이터셋에서 생성된 이미지 중 약 10%만이 아티팩트와 불가능성이 없는 것으로 나타났습니다.

마찬가지로 텍스트 이미지 불일치 문제도 흔합니다, 예를 들어, 프롬프트는 "a man jumping into a river"이지만 생성된 이미지에는 그 남자가 서 있는 모습이 표시됩니다.

그러나 잘 알려진 IS [43] 및 FID [20]을 포함한 생성된 이미지에 대한 기존의 자동 평가 지표는 이미지 분포를 통해 계산되며 개별 이미지의 뉘앙스를 반영하지 않을 수 있습니다.

최근 연구에서는 생성된 이미지의 품질을 평가하기 위해 인간의 선호도/등급을 수집하고 평가 모델을 학습하여 이러한 등급을 예측했습니다 [30, 52, 54], 특히 ImageReward [54] 또는 Pick-a-Pic [30].

더 집중적으로 다루어지는 동안에도 이러한 지표들은 여전히 하나의 이미지 품질을 하나의 숫자 점수로 요약합니다.

프롬프트-이미지 정렬 측면에서 CLIP-Score [19] 및 최근 질문 생성 및 응답 파이프라인 [8, 10, 24, 57]과 같은 중요한 단일 점수 지표도 있습니다.

더 보정되고 설명하기 쉽지만, 이들은 여전히 이미지의 정렬 불량 영역을 식별하지 못하는 비싸고 복잡한 모델입니다.

이 논문에서는 단일 스칼라 점수보다 이미지 품질에 대한 훨씬 더 풍부한 이해를 제공하는 해석 가능하고 귀인 가능한 세밀한 다면 평가 데이터셋과 모델을 제안합니다 (예: 아티팩트/불신뢰성 또는 이미지-텍스트 정렬 오류가 있는 영역).

첫 번째 기여로, 우리는 Rich Human Feedback on 18K images (RichHF-18K) 데이터셋을 수집했습니다, 여기에는 (i) 이미지의 부정확성/아티팩트 및 텍스트-이미지 불일치를 강조하는 점 주석, (ii) 생성된 이미지에서 누락되거나 잘못 표현된 개념을 지정하는 프롬프트에 라벨이 붙은 단어, 그리고 (iii) 이미지 타당성, 텍스트-이미지 정렬, 미학 및 전반적인 평가를 위한 네 가지 유형의 세분화된 점수가 포함되어 있습니다.

RichHF-18K를 탑재한 우리는 멀티모달 트랜스포머 모델을 설계하여 생성된 이미지와 관련 텍스트 프롬프트에서 이러한 풍부한 인간 주석을 예측하는 방법을 배우기 위해 Rich Automatic Human Feedback (RAHF)으로 코인화합니다.

따라서 우리 모델은 신뢰할 수 없는 영역과 정렬되지 않은 영역, 정렬되지 않은 키워드, 그리고 세밀한 점수를 예측할 수 있습니다.

이는 신뢰할 수 있는 평점뿐만 아니라 생성된 이미지의 품질에 대한 더 상세하고 설명 가능한 인사이트를 제공합니다.

우리가 아는 한, 이것은 SOTA text-to-image 생성 모델을 위한 최초의 풍부한 피드백 데이터셋이자 모델로, T2I 생성을 평가할 수 있는 자동이고 설명 가능한 파이프라인을 제공합니다.

이 논문의 주요 기여는 아래에 요약되어 있습니다:

1. 18K Pick-a-Pic 이미지에서 생성된 이미지 (세분 점수, 신뢰할 수 없음(아티팩트)/오정렬 이미지 영역, 오정렬 키워드로 구성된)에 대한 최초의 Rich Human Feedback 데이터셋 (RichHF-18K)입니다.

2. 생성된 이미지에 대한 풍부한 피드백을 예측하기 위한 멀티모달 트랜스포머 모델 (RAHF)로, 테스트 세트의 인간 주석과 높은 상관관계가 있음을 보여줍니다.

3. 또한 RAHF가 예측한 풍부한 인간 피드백이 이미지 생성을 개선하는 데 유용하다는 것을 입증합니다: (i) 예측된 히트맵을 마스크로 사용하여 문제가 있는 이미지 영역을 인페인팅하고, (ii) 예측된 점수를 사용하여 이미지 생성 모델 (예: Muse [6])을 파인튜닝하는 데 도움을 줌으로써, 예를 들어 파인튜닝 데이터를 선택/필터링하거나 보상 지침을 제공합니다.

우리는 두 경우 모두 원래 모델보다 더 나은 이미지를 얻을 수 있음을 보여줍니다.

4. 학습 세트에서 이미지를 생성한 모델과 다른 Muse 모델의 개선은 RAHF 모델의 우수한 일반화 능력을 보여줍니다.

2. Related Works

Text-to-image generation

Text-to-image (T2I) 생성 모델은 딥러닝 시대에 여러 인기 있는 모델 아키텍처를 통해 진화하고 반복되었습니다.

초기 연구로는 Generative Adversarial Network (GAN) [3, 16, 26]이 있습니다, 이 신경망은 이미지 생성을 위한 생성기와 실제 이미지와 생성된 이미지를 구별하기 위한 판별기를 병렬로 학습합니다 (참고로 [32, 38, 47, 55, 60, 62] 등 참조).

또 다른 유형의 생성 모델은 이미지 데이터의 likelihood에 대한 evidence lower bound (ELBO)을 최적화하는 variational auto-encoders (VAE) [21, 29, 48]에서 발전합니다.

가장 최근에는 Diffusion Models (DM) [22, 36, 41, 46]이 이미지 생성을 위한 state-of-the-art (SOTA)으로 부상했습니다 [13].

DM은 랜덤 노이즈로부터 점진적으로 이미지를 생성하도록 학습되며, GAN보다 더 많은 다양성을 포착하고 우수한 샘플 품질을 달성할 수 있습니다 [13].

Latent Diffusion Models [41]은 더 효율적으로 압축된 잠재 공간에서 디퓨전 과정을 수행하는 추가적인 개선 작업입니다.

Text-to-image evaluation and reward models

최근 여러 차원에서 text-to-image 모델을 평가하는 연구가 많이 진행되었습니다 [9, 25, 30, 31, 37, 51, 52, 54].

Xu et al. [54]은 사용자에게 여러 이미지의 순위를 매기고 품질에 따라 평가하도록 요청하여 인간 선호도 데이터셋을 수집합니다.

그들은 인간 선호 학습을 위한 reward 모델 ImageReward를 학습시켰고, ImageReward 모델을 사용하여 디퓨전 모델을 조정하기 위한 Reward Feedback Learning (ReFL)을 제안했습니다.

Kirstain et al. [30]은 생성된 이미지 쌍 중에서 더 나은 이미지를 선택하도록 사용자에게 요청하여 인간의 선호도를 수집하는 웹 애플리케이션을 구축했으며, 그 결과 Stable Diffusion 2.1, Dreamlike Photoreal 2.05, Stable Diffusion XL 변형과 같은 T2I 모델에서 생성된 50만 개 이상의 예제를 가진 Pick-a-Pic이라는 데이터셋이 생성되었습니다.

그들은 인간 선호도 데이터셋을 활용하여 인간 선호도를 예측하기 위해 CLIP 기반 [39] 점수 함수인 PickScore를 학습시켰습니다.

Huang et al. [25]은 text-to-image 모델을 평가하기 위해 T2I-CompBench라는 벤치마크를 제안했습니다, 이는 속성 바인딩, 객체 관계 및 복잡한 구성을 설명하는 6,000개의 텍스트 프롬프트로 구성되어 있습니다.

그들은 CLIP [39] 및 BLIP [34]와 같은 여러 사전 학습된 비전-언어 모델을 사용하여 여러 평가 지표를 계산했습니다.

Wu et al. [51, 52]은 생성된 이미지에 대한 대규모 인간 선택 데이터셋을 수집하고, 이 데이터셋을 활용하여 Human Preference Score (HPS)를 출력하는 분류기를 학습시켰습니다.

그들은 HPS로 Stable Diffusion을 튜닝함으로써 이미지 생성 능력이 향상되었음을 보여주었습니다.

최근에 Lee [31]는 여러 세분화된 지표를 사용하여 T2I 모델에 대한 전체적인 평가를 제안했습니다.

이러한 귀중한 기여에도 불구하고, 대부분의 기존 작품들은 피드백/reward를 구성하기 위해 이진 인간 평점이나 선호도 순위만을 사용하며, 생성된 이미지의 신뢰할 수 없는 영역, 정렬되지 않은 영역 또는 정렬되지 않은 키워드와 같은 세부적인 실행 가능한 피드백을 제공하는 능력이 부족합니다.

우리 연구와 관련된 최근 논문 중 하나는 Zhang et al. [61]입니다, 이 논문은 이미지 합성 작업을 위해 아티팩트 영역 데이터셋을 수집하고, 아티팩트 영역을 예측하기 위해 세그멘테이션 기반 모델을 학습했으며, 해당 영역에 대한 영역 인페인팅 방법을 제안했습니다.

그러나 그들의 연구의 초점은 아티팩트 영역에만 맞춰져 있으며, 본 논문에서는 아티팩트 영역뿐만 아니라 정렬되지 않은 영역, 정렬되지 않은 키워드, 그리고 여러 측면에서 네 가지 세밀한 점수를 포함하는 T2I 생성에 대한 풍부한 피드백을 수집했습니다.

우리가 아는 한, 이것은 text-to-image 모델을 위한 이질적인 풍부한 인간 피드백에 대한 첫 번째 연구입니다.

3. Collecting rich human feedback

3.1. Data collection process

이 섹션에서는 RichHF-18K 데이터셋을 수집하는 절차에 대해 논의합니다, 여기에는 두 개의 히트맵 (아티팩트/불신뢰성 및 불일치), 네 개의 세분화된 점수 (유연성, 정렬, 미학, 전체 점수), 그리고 하나의 텍스트 시퀀스 (잘못 정렬된 키워드)가 포함됩니다.

생성된 각 이미지에 대해 주석자는 먼저 이미지를 검토하고 생성에 사용된 텍스트 프롬프트를 읽도록 요청받습니다.

그런 다음 이미지에 포인트를 표시하여 텍스트 프롬프트에 대한 신뢰할 수 없거나 아티팩트하거나 정렬이 잘못된 위치를 나타냅니다.

주석자들은 각 표시된 지점이 "effective radius" (이미지 높이의 1/20)을 가지고 있으며, 이는 표시된 지점을 중심으로 가상의 디스크를 형성한다고 말합니다.

이와 같이, 우리는 이미지 영역을 결함으로 덮기 위해 비교적 적은 양의 포인트를 사용할 수 있습니다.

마지막으로, 주석자들은 부정확한 키워드와 네 가지 유형의 점수를 각각 신뢰성, 이미지-텍스트 정렬, 미적 품질, 그리고 전체 품질에 대해 5점 리커트 척도로 라벨링합니다.

이미지의 신뢰할 수 없음/아티팩트 및 불일치에 대한 자세한 정의는 보충 자료에서 확인할 수 있습니다.

우리는 데이터 수집을 용이하게 하기 위해 그림 1과 같이 웹 UI를 설계했습니다.

데이터 수집 과정에 대한 자세한 내용은 보충 자료에서 확인할 수 있습니다.

3.2. Human feedback consolidation

생성된 이미지에 대한 수집된 인간 피드백의 신뢰성을 높이기 위해 각 이미지-텍스트 쌍에는 세 명의 주석자가 주석을 달았습니다.

따라서 각 샘플에 대한 여러 주석을 통합해야 합니다.

점수의 경우, 이미지에 대한 여러 주석자의 점수를 평균 내어 최종 점수를 얻기만 하면 됩니다.

정렬되지 않은 키워드 주석의 경우, 키워드에 대한 가장 빈번한 레이블을 사용하여 정렬/오정렬 지표의 최종 시퀀스를 얻기 위해 다수결 투표를 수행합니다.

포인트 주석의 경우, 먼저 각 주석에 대한 히트맵으로 변환하고, 각 포인트를 히트맵의 디스크 영역 (마지막 부분에서 설명한 대로)으로 변환한 다음 주석자 간의 평균 히트맵을 계산합니다.

명확한 불가능성이 있는 영역은 모든 주석자가 주석을 달 가능성이 높으며 최종 평균 히트맵에서 높은 값을 가질 수 있습니다.

3.3. RichHF-18K: a dataset of rich human feedback

데이터 주석을 위해 Pick-a-Pic 데이터셋에서 이미지-텍스트 쌍의 하위 집합을 선택합니다.

비록 우리의 방법이 일반적이고 생성된 이미지에 적용될 수 있지만, 그 중요성과 더 넓은 응용 범위 때문에 대부분의 데이터셋을 사진-사실적인 이미지로 선택합니다.

또한 이미지 전반에 걸쳐 균형 잡힌 카테고리를 제공하고자 합니다.

균형을 보장하기 위해 PaLI visual question answering (VQA) 모델 [7]을 활용하여 Pick-a-Pic 데이터 샘플에서 몇 가지 기본 피쳐를 추출했습니다.

구체적으로, 우리는 Pick-a-Pic에서 각 이미지-텍스트 쌍에 대해 다음과 같은 질문을 했습니다.

1) 이미지가 사진사실적인가요?

2) 이미지를 가장 잘 설명하는 카테고리는 무엇입니까?

‘human’, ‘animal’, ‘object’, ‘indoor scene’, ‘outdoor scene’ 중 하나를 선택하세요.

이 두 가지 질문에 대한 PaLI의 답변은 일반적으로 수동 검사를 통해 신뢰할 수 있습니다.

답변을 사용하여 Pick-a-Pic에서 다양한 하위 집합을 샘플링하여 17K개의 이미지-텍스트 쌍을 생성했습니다.

우리는 17K 샘플을 랜덤으로 두 개의 하위 집합으로 나누었습니다, 16K 샘플로 구성된 학습 세트와 1K 샘플로 구성된 검증 세트입니다.

16K 학습 샘플의 속성 분포는 보충 자료에 나와 있습니다.

또한, 우리는 Pick-a-Pic 테스트 세트에서 얻은 독특한 프롬프트와 해당 이미지에 대한 풍부한 인간 피드백을 수집합니다.

총 18K 이미지-텍스트 쌍에 대한 풍부한 인간 피드백을 Pick-a-Pic에서 수집했습니다.

우리의 RichHF-18K 데이터셋은 16K 학습, 1K 검증, 그리고 1K 테스트 샘플로 구성되어 있습니다.

3.4. Data statistics of RichHF-18K

이 섹션에서는 점수의 통계를 요약하고 점수에 대한 주석자 일치 분석을 수행합니다.

우리는 점수 s를 공식 (s-s_min)/(s_max-s_min) (s_max = 5 및 s_min = 1)로 표준화하여 점수가 [0, 1] 범위에 있도록 합니다.

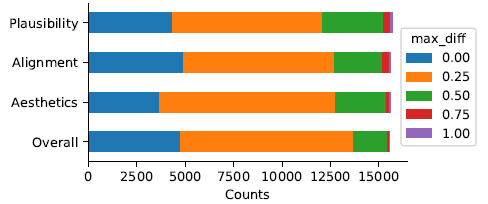

점수의 히스토그램 그래프는 그림 2에 나와 있습니다.

점수 분포는 가우시안 분포와 유사하며, 타당성 점수와 텍스트-이미지 정렬 점수는 점수 1.0의 비율이 약간 더 높습니다.

수집된 점수의 분포는 좋은 reward 모델을 학습하기 위해 합리적인 수의 부정적 및 긍정적 샘플을 확보하도록 보장합니다.

이미지-텍스트 쌍에 대한 주석자 간의 평가 일치도를 분석하기 위해 점수 간의 최대 차이를 계산합니다: max_diff = max(scores) - min(scores) 여기서 점수는 이미지-텍스트 쌍의 세 가지 점수 레이블입니다.

우리는 그림 4에 max_diff 히스토그램을 표시합니다.

샘플의 약 25%가 완벽한 주석자 일치도를 가지고 있으며, 약 85%의 샘플이 좋은 주석자 일치도를 가지고 있음을 알 수 있습니다 (표준화 후 max_diff는 0.25 이하 또는 5점 리커트 척도에서 1).

4. Predicting rich human feedback

4.1. Models

4.4.1 Architecture

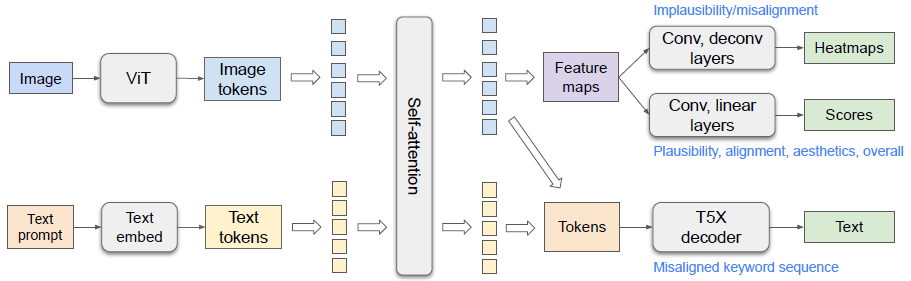

우리 모델의 아키텍처는 그림 3에 나와 있습니다.

우리는 Spotlight 모델 아키텍처 [33]에서 영감을 받아 ViT [14] 및 T5X [40] 모델을 기반으로 한 비전-언어 모델을 채택하지만, 모델과 사전 학습 데이터셋을 모두 수정하여 작업에 더 적합하게 만듭니다.

우리의 작업은 양방향 정보 전파를 필요로 하기 때문에 PaLI [7]과 유사하게 연결된 이미지 토큰과 텍스트 토큰 중에서 셀프-어텐션 모듈 [49]을 사용합니다.

텍스트 정보는 텍스트 불일치 점수와 히트맵 예측을 위해 이미지 토큰으로 전파되며, 비전 정보는 텍스트 불일치 시퀀스를 디코딩하기 위해 더 나은 비전-인식 텍스트 인코딩을 위해 텍스트 토큰으로 전파됩니다.

더 다양한 이미지에서 모델을 사전 학습시키기 위해 WebLI 데이터셋 [7]의 자연스러운 이미지 캡셔닝 작업을 사전 학습 작업 혼합물에 추가합니다.

구체적으로, ViT는 생성된 이미지를 입력으로 받아 이미지 토큰을 고수준 표현으로 출력합니다.

텍스트 프롬프트 토큰은 밀집된 벡터에 임베되어 있습니다.

이미지 토큰과 임베디드 텍스트 토큰은 T5X의 트랜스포머 셀프 어텐션 인코더에 의해 cancat되고 인코딩됩니다.

인코딩된 융합 텍스트와 이미지 토큰 외에도 세 가지 종류의 예측기를 사용하여 서로 다른 출력을 예측합니다.

히트맵 예측을 위해 이미지 토큰은 피쳐 맵으로 재구성되어 컨볼루션 레이어, 디컨볼루션 레이어, 시그모이드 활성화함수를 통해 전송되며, 신뢰할 수 없는 히트맵과 정렬되지 않은 히트맵을 출력합니다.

점수 예측을 위해 피쳐 맵은 컨볼루션 레이어, 선형 레이어, 시그모이드 활성화를 통해 전송되며, 그 결과 스칼라가 세밀한 점수로 나타납니다.

키워드 불일치 시퀀스를 예측하기 위해 이미지 생성에 사용된 원본 프롬프트를 모델의 텍스트 입력으로 사용합니다.

수정된 프롬프트가 T5X 디코더의 예측 타겟으로 사용됩니다.

수정된 프롬프트에는 정렬되지 않은 각 토큰에 대해 특수 접미사 ('_0')가 있습니다, 예를 들어, 생성된 이미지에 검은 고양이가 포함되어 있고 yellow라는 단어가 이미지와 정렬되지 않은 경우 yellow_0_cat이 표시됩니다.

평가 중에 특수 접미사를 사용하여 정렬되지 않은 키워드를 추출할 수 있습니다.

4.1.2 Model variants

히트맵과 점수의 예측 헤드에 대한 두 가지 모델 변형을 살펴봅니다.

Multi-head

여러 히트맵과 점수를 예측하는 간단한 방법은 각 점수와 히트맵 유형에 대해 하나의 헤드가 있는 여러 예측 헤드를 사용하는 것입니다.

이를 위해서는 총 7개의 예측 헤드가 필요합니다.

Augmented prompt

또 다른 접근 방식은 각 예측 유형에 대해 단일 헤드를 사용하는 것입니다, 즉, 히트맵, 점수, 오정렬 시퀀스에 대해 각각 총 세 개의 헤드를 사용하는 것입니다.

모델에 세밀한 히트맵 또는 점수 유형을 알리기 위해 출력 유형으로 프롬프트를 보강합니다.

보다 구체적으로, 우리는 한 예시의 각 특정 작업에 대한 프롬프트에 작업 문자열 (예: 'implausibility heatmap')을 미리 추가하고 해당 레이블을 학습 타겟으로 사용합니다.

추론 중에 프롬프트를 해당 작업 문자열로 보강하면 단일 히트맵 (점수) 헤드가 서로 다른 히트맵 (점수)을 예측할 수 있습니다.

실험에서 보여주듯이, 이 증강 프롬프트 접근 방식은 작업별 비전 피쳐 맵과 텍스트 인코딩을 생성할 수 있으며, 이는 일부 작업에서 훨씬 더 나은 성능을 발휘합니다.

4.1.3 Model optimization

히트맵 예측을 위해 픽셀 단위 mean squared error (MSE) loss를, 점수 예측을 위해 MSE loss를 사용하여 모델을 학습시킵니다.

정렬되지 않은 시퀀스 예측을 위해, 모델은 teacher 강제 크로스 엔트로피 loss로 학습됩니다.

최종 loss 함수는 히트맵 MSE loss, 점수 MSE loss, 그리고 시퀀스 teacher 강제 크로스 엔트로피 loss의 가중 조합입니다.

4.2. Experiments

4.2.1 Experimental setup

우리 모델은 16K RichHF-18K 학습 샘플로 학습되었으며, 하이퍼파라미터는 1K RichHF-18K 검증 세트의 모델 성능을 사용하여 튜닝되었습니다.

하이퍼파라미터 설정은 보충 자료에서 찾을 수 있습니다.

Evaluation metrics

점수 예측 작업의 경우, 우리는 점수 예측의 대표적인 평가 지표인 Pearson linear correlation coefficient (PLCC)와 Spearman rank correlation coefficient (SRCC)를 보고합니다 [28].

히트맵 예측 작업의 경우, 결과를 평가하는 간단한 방법은 NSS/KLD [5]와 같은 표준 중요도 히트맵 평가 지표를 차용하는 것입니다.

그러나 이러한 지표는 모든 지표가 실제 히트맵이 비어 있지 않다고 가정하기 때문에 우리의 경우 직접 적용할 수 없습니다; 그러나 우리의 경우, 실제 히트맵이 비어 있을 수 있습니다 (예: 아티팩트/불합리성 히트맵의 경우 이미지에 아티팩트/불합리성이 없음을 의미합니다).

따라서, 우리는 모든 샘플과 비어 있는 실제 샘플에 대해 각각 MSE를 보고하고, 비어 있지 않은 실제 샘플에 대해 NSS/KLD/AUC-Judd/SIM/CC [5]와 같은 중요도 히트맵 평가 지표를 보고합니다.

정렬되지 않은 키워드 시퀀스 예측을 위해, 우리는 토큰 수준의 precision, recall, 그리고 F1-score를 채택합니다.

구체적으로, 모든 샘플에서 정렬되지 않은 키워드에 대한 precision/recall/F1-scores가 계산됩니다.

Baselines

비교를 위해, 우리는 점수와 히트맵을 각각 예측하기 위해 여러 개의 완전히 연결된 레이어와 디컨볼루션 헤드를 가진 두 개의 ResNet-50 모델[18]을 파인튜닝합니다.

우리는 또한 기성 PickScore 모델 [30]을 사용하여 PickScore를 계산하고 네 가지 ground truth 점수 각각에 대한 지표를 계산합니다.

우리는 기성 CLIP 모델 [39]을 베이스라인으로 이미지와 텍스트 임베딩의 코사인 유사성을 계산하고, 이를 사용하여 텍스트-이미지 정렬 메트릭을 계산합니다, CLIP 코사인 유사성은 이미지와 프롬프트 간의 정렬을 반영하도록 설계되었기 때문입니다.

또한 학습 데이터셋을 사용하여 네 가지 유형의 점수를 예측하기 위해 CLIP 모델을 파인튜닝합니다.

불일치 히트맵 예측을 위해 CLIP gradient [45] 맵을 베이스라인으로 사용합니다.

4.2.2 Prediction result on RichHF-18K test set

Quantitative analysis

우리의 모델 예측 실험 결과는 RichHF-18K 테스트 세트에서 네 가지 세밀한 점수, 신뢰할 수 없는 히트맵, 불일치 히트맵, 불일치 키워드 시퀀스에 대한 것입니다, 이 결과는 각각 표 1, 표 2, 표 3, 그리고 표 4에 제시되어 있습니다.

표 1과 표 3 모두에서 제안된 모델의 두 가지 변형 모두 ResNet-50 (또는 텍스트-이미지 정렬 점수에 대한 CLIP)을 크게 능가합니다.

하지만, 표 2에서 우리 모델의 멀티헤드 버전은 ResNet-50보다 성능이 떨어졌지만, 우리의 증강 프롬프트 버전은 ResNet-50보다 성능이 뛰어납니다.

주된 이유는 멀티헤드 버전에서는 프롬프트에서 예측 작업을 증강하지 않고 모든 7가지 예측 작업에 동일한 프롬프트가 사용되므로 모든 작업에 대해 피쳐 맵과 텍스트 토큰이 동일하게 사용되기 때문일 수 있습니다.

이러한 작업들 사이에서 좋은 절충안을 찾는 것이 쉽지 않을 수 있으며, 따라서 아티팩트/불가능성 히트맵과 같은 일부 작업의 성능이 악화되었습니다.

그러나 예측 작업을 프롬프트로 보강한 후, 피쳐 맵과 텍스트 토큰을 각 특정 작업에 맞게 조정하여 더 나은 결과를 얻을 수 있습니다.

또한, 비정렬 히트맵 예측이 아티팩트/불안정성 히트맵 예측보다 일반적으로 더 나쁜 결과를 보인다는 점에 주목합니다, 이는 비정렬 영역이 덜 명확하기 때문에 주석이 더 노이즈가 많을 수 있기 때문일 수 있습니다.

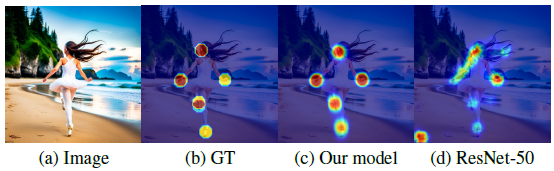

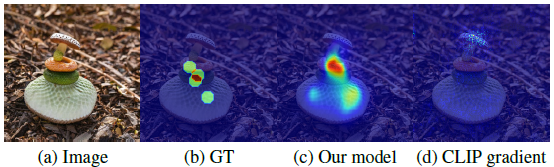

Qualitative examples

우리는 우리의 모델이 아티팩트/불신뢰성이 있는 영역을 식별하는 불가능성 히트맵 (그림 5)과 불일치 히트맵 (그림 6)에 대한 몇 가지 예시 예측을 보여줍니다, 여기서 우리의 모델은 프롬프트에 해당하지 않는 객체를 식별합니다.

그림 7은 몇 가지 예시 이미지와 그 실제 값 및 예측 점수를 보여줍니다.

추가 자료에는 더 많은 예시가 있습니다.

5. Learning from rich human feedback

이 섹션에서는 예측된 풍부한 인간 피드백 (예: 점수 및 히트맵)이 이미지 생성을 개선하는 데 사용될 수 있는지 조사합니다.

RAHF 모델의 이점이 생성 모델 패밀리 전반에 걸쳐 일반화되도록 하기 위해, 우리는 주로 마스크드 트랜스포머 아키텍처를 기반으로 하여 RichHF-18K 데이터셋의 Stable Diffusion 모델 변형과 다른 Muse [6]을 타겟 모델로 사용하여 개선합니다.

Finetuning generative models with predicted scores

먼저 RAHF 점수로 파인튜닝하면 Muse를 개선할 수 있다는 것을 설명합니다.

먼저, 사전 학습된 Muse 모델을 사용하여 12,564개의 프롬프트 각각에 대해 8개의 이미지를 생성합니다 (프롬프트 세트는 PaLM-2 [1, 11]을 통해 생성되며 일부 시드 프롬프트도 포함됩니다).

각 이미지에 대한 RAHF 점수를 예측하며, 각 프롬프트에서 이미지의 최고 점수가 고정된 임계값을 초과하면 파인튜닝 데이터셋의 일부로 선택됩니다.

Muse 모델은 이 데이터셋으로 파인튜닝됩니다.

이 접근 방식은 직접 선호 최적화의 단순화된 버전으로 볼 수 있습니다 [15].

그림 8 (a)-(b)에서 우리는 예측된 타당성 점수(threshold=0.8)로 Muse 파인튜닝의 한 예를 보여줍니다.

Muse 파인튜닝의 이득을 정량화하기 위해 100개의 새로운 프롬프트를 사용하여 이미지를 생성하고, 6명의 주석자에게 원본 Muse와 파인튜닝된 Muse의 두 이미지를 나란히 비교 (타당성을 위해)하도록 요청했습니다.

주석자는 이미지 A/B를 생성하는 데 사용되는 모델을 알지 못한 채 다섯 가지 가능한 응답 중에서 선택합니다 (이미지 A가 이미지 B보다 유의미하거나 약간 더 낫습니다, 거의 동일하게, 이미지 B가 이미지 A보다 약간/상당히 더 낫습니다).

표 5의 결과는 RAHF 타당성 점수가 있는 파인튜닝된 Muse가 원래 Muse보다 훨씬 적은 아티팩트/불합리성을 가지고 있음을 보여줍니다.

또한, 그림 8 (c)-(d)에서 우리는 RAHF 미적 점수를 잠재 디퓨전 모델에 대한 분류기 지침으로 사용하는 예시를 보여줍니다 [41], Bansal et al. [2]의 접근 방식과 유사하게, 각 세분화된 점수가 생성 모델/결과의 다양한 측면을 개선할 수 있음을 보여줍니다.

Region inpainting with predicted heatmaps and scores

우리는 우리 모델의 예측된 히트맵과 점수를 사용하여 생성된 이미지의 품질을 향상시키기 위해 지역 인페인팅을 수행할 수 있음을 입증합니다.

각 이미지에 대해 먼저 신뢰할 수 없는 히트맵을 예측한 다음, 임계값과 확장을 사용하여 히트맵을 처리하여 마스크를 만듭니다.

마스킹된 영역 내에서 Muse 인페인팅 [6]을 적용하여 텍스트 프롬프트와 일치하는 새로운 이미지를 생성합니다.

여러 이미지가 생성되며, 최종 이미지는 RAHF에서 가장 높은 예측 가능성 점수로 선택됩니다.

그림 9에서 우리는 예측된 불가능성 히트맵과 타당성 점수로 여러 인페인팅 결과를 보여줍니다.

그림에서 볼 수 있듯이, 인페인팅 후 아티팩트가 적은 더 그럴듯한 이미지가 생성됩니다.

다시 말하지만, 이는 RAHF가 RAHF를 학습하는 데 사용되는 이미지와는 매우 다른 생성 모델의 이미지에 잘 일반화된다는 것을 보여줍니다.

더 자세한 내용과 예시는 보충 자료에서 확인할 수 있습니다.

6. Conclusions and limitations

이 연구에서는 이미지 생성을 위한 최초의 풍부한 인간 피드백 데이터셋인 RichHF-18K를 제공했습니다.

우리는 풍부한 인간 피드백을 예측하기 위해 멀티모달 트랜스포머를 설계하고 학습시켰으며, 풍부한 인간 피드백을 통해 이미지 생성을 개선하는 몇 가지 사례를 시연했습니다.

우리의 결과 중 일부는 매우 흥미롭고 유망하지만, 우리의 작업에는 몇 가지 한계가 있습니다.

첫째, 비정렬 히트맵의 모델 성능이 비정렬 히트맵의 노이즈로 인해 신뢰할 수 없는 히트맵보다 떨어집니다.

이미지에 없는 객체와 같은 일부 정렬 불량 사례를 라벨링하는 방법이 다소 모호합니다.

불일치 라벨 품질을 개선하는 것은 앞으로의 방향 중 하나입니다.

둘째, Pick-a-Pic (Stable Diffusion)을 넘어서는 생성 모델에 대한 더 많은 데이터를 수집하고 RAHF 모델에 미치는 영향을 조사하는 것이 도움이 될 것입니다.

또한, 우리는 T2I 생성을 개선하기 위해 우리 모델을 활용하는 세 가지 유망한 방법을 제시하지만, 풍부한 인간 피드백을 활용하는 방법은 무수히 많습니다, 예를 들어, 예측된 히트맵이나 점수를 reward 신호로 사용하여 강화 학습을 통해 생성 모델을 파인튜닝하는 방법, 예측된 히트맵을 가중치 맵으로 사용하는 방법, 또는 인간 피드백을 통해 학습할 때 예측된 정렬되지 않은 시퀀스를 사용하여 이미지 생성을 개선하는 방법 등이 탐구될 수 있습니다.

우리는 RichHF-18K와 초기 모델이 향후 연구에서 이러한 연구 방향을 조사하기 위한 퀘스트에 영감을 주기를 바랍니다.

'Diffusion' 카테고리의 다른 글

| Generative Image Dynamics (CVPR 2024 Best Paper) (0) | 2025.03.17 |

|---|---|

| Scalable Diffusion Models with Transformers (0) | 2024.09.09 |

| Adding Conditional Control to Text-to-Image Diffusion Models (0) | 2024.07.30 |

| IP-Adapter: Text Compatible Image Prompt Adapter for Text-to-Image Diffusion Models (0) | 2024.07.08 |

| Improving Diffusion Models for Authentic Virtual Try-on in the Wild (0) | 2024.06.27 |