2024. 1. 2. 20:24ㆍDeep Learning

Deep Generative Filter for Motion Deblurring

Sainandan Ramakrishnan, Shubham Pachori, Aalok Gangopadhyay, Shanmuganathan Raman

Abstract

이미지에서 카메라 흔들림으로 인한 블러를 제거하는 것은 잘못된 특성으로 인해 컴퓨터 비전 문헌에서 항상 어려운 문제였습니다.

3D 공간에서 카메라와 객체 간의 상대적인 움직임으로 인한 모션 블러는 전체 이미지에서 공간적으로 변화하는 블러 효과를 유도합니다.

본 논문에서는 이 문제를 해결하기 위해 전역 스킵 연결 및 고밀도 아키텍처와 통합된 Generative Adversarial Network (GAN) 아키텍처 기반의 새로운 심층 필터를 제안합니다.

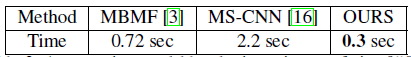

저희 모델은 블러 커널 추정 프로세스를 우회하면서 실제 응용에 필요한 테스트 시간을 크게 단축합니다.

벤치마크 데이터 세트에 대한 실험은 SOTA 블라인드 디블러링 알고리즘을 양적, 질적으로 능가하는 제안된 방법의 효과를 입증합니다.

1. Introduction

모션 블러는 휴대폰과 같은 경량 장치를 사용하여 이미지를 캡처할 때 주로 발생하는 일반적인 문제입니다.

유한한 노출 간격과 캡처 장치와 캡처된 객체 간의 상대적인 움직임으로 인해 획득한 이미지가 종종 블러됩니다.

[19]에서는 고품질 이미지에서만 학습된 표준 네트워크 모델이 디포커스 또는 피사체/카메라 움직임으로 인해 블러로 저하된 것에 적용될 때 성능이 크게 저하되는 것으로 나타났습니다.

따라서 이미지의 블러 문제를 해결할 필요성이 심각합니다.

이미지의 움직임으로 인해 유도되는 블러는 공간적으로 균일하지 않고 블러 커널을 알 수 없습니다.

깊이 변화로 인해 객체의 세그멘테이션 경계와 카메라와 장면 객체 간의 상대적인 움직임으로 인해 공간적으로 변화하는 불균일 커널을 추정하는 것은 상당히 어렵습니다.

본 논문에서는 이 어려운 문제를 해결하기 위해 generative adversarial network (GAN) 기반 딥러닝 아키텍처를 도입합니다.

저희는 이미지 디블러링 문제를 해결하기 위해 제안된 SOTA 알고리즘보다 훨씬 나은 결과를 얻습니다.

2. Related Work

문헌의 대부분의 이전 연구는 카메라 디셰이킹 문제를 블라인드 디콘볼루션 문제로 모델링하고 이미지 통계를 priors 또는 정규화기로 사용하여 블러 커널을 얻음으로써 해결합니다.

이러한 방법은 벤치마크 데이터세트에서 큰 성공을 거두었지만 방법과 알고리즘의 제한적인 가정은 실제 적용 가능성을 제한합니다.

또한 문헌에서 이러한 작업의 대부분은 블러 커널이 공간적으로 균일하다고 가정하는 블라인드 디콘볼루션 문제를 해결하는 데 전념해 왔습니다.

공간적으로 변화하는 블러 커널을 사용하여 이 문제를 해결하기 위해 제안된 작업은 거의 없습니다.

균일하지 않은 블라인드 디블러링 문제를 해결하기 위해 이전 연구에서는 이미지를 더 작은 영역으로 나누고 각 영역에 대한 블러 커널을 별도로 추정합니다 [4].

이미지의 각 로컬 영역에 대해 커널을 얻으면 OLA (Overlap Add) 방법을 사용하여 디블러링하고 결합하여 최종 디콘볼루션 이미지를 생성합니다.

딥러닝 방법을 활용하는 제안된 작업은 먼저 주어진 이미지의 작은 영역에서 모션 블러 정보의 확률적 분포를 예측한 다음 이 블러링 관찰을 활용하여 샤프한 이미지를 복구하려고 합니다 [18].

저희가 아는 한 주어진 블러된 이미지에서 샤프한 이미지를 직접 복구하려고 시도한 작업은 단 한 건뿐입니다 [16].

그러나 저자가 디블러된 이미지를 얻기 위해 멀티 스케일 프레임워크를 활용하기 때문에 계산 비용이 많이 듭니다.

따라서 멀티 스케일 프레임워크를 사용하지 않고 아티팩트가 없는 이미지를 직접 복구하는 것을 목표로 합니다.

블라인드 디블러링 알고리즘에 대한 철저한 조사는 [11]에서 확인할 수 있습니다.

3. Proposed Method

저희 모델에서 저희는 심층 네트워크의 모든 컨볼루션 유닛이 하위 레벨 활성화함수의 전체 어레이를 기반으로 독립적인 결정을 내릴 수 있도록 합니다.

더 높은 레벨의 출력으로 하위 레벨 활성화함수의 요소별 합산을 통해 잔차 블록을 기본 작업마로 사용하는 [12] 및 [16]과 달리, 저희는 다양한 시멘틱 레벨의 정보가 네트워크 전체에 변경되지 않고 흐르기를 원합니다.

이를 위해 저희는 조밀하게 연결된 'generative network'를 제안합니다.

3.1. Model Architecture

저희 아키텍처는 조밀하게 연결된 생성기와 판별기로 구성됩니다.

생성기의 작업은 여러 수용 스케일에 걸쳐 있는 피쳐를 재활용하여 판별기가 생성된 이미지가 타겟 분포에서 왔다고 생각하도록 속이는 이미지를 생성하는 것입니다.

따라서 블러된 이미지가 주어지면 시각적으로 매력적이고 통계적으로 일관된 디블러된 이미지를 생성할 수 있습니다.

판별기의 작업은 각 이미지의 서로 다른 패치를 분석하여 결정을 내림으로써 입력 이미지 각각이 어떤 분포에서 왔는지를 올바르게 식별하는 것입니다.

저희는 생성기 모델과 판별기 모델을 자세히 설명합니다.

3.1.1 The Generator

[6]과 달리 저희는 정보의 차원을 줄이지 않고 네트워크 전체에서 정보를 일정하게 유지합니다.

이는 메모리 제약을 초래하지만 시각적으로 매력적인 이미지를 생성하기 위해 디컨볼루션에 의존하는 네트워크에서 일반적으로 발견되는 바둑판 아티팩트를 생성하지 않도록 네트워크를 보호합니다 [7].

대신, 생성기 네트워크의 모든 레벨에서 피쳐 재사용을 통해 저희 모델은 불균일한 모션 디블러링에 사용되는 다른 CNN 기반 방법보다 훨씬 작은 네트워크 깊이로 높은 생성 성능을 보여줍니다 [16], [3], [18].

이를 통해 보다 부드러운 학습과 더 빠른 테스트 시간 및 효율적인 메모리 사용이 가능합니다.

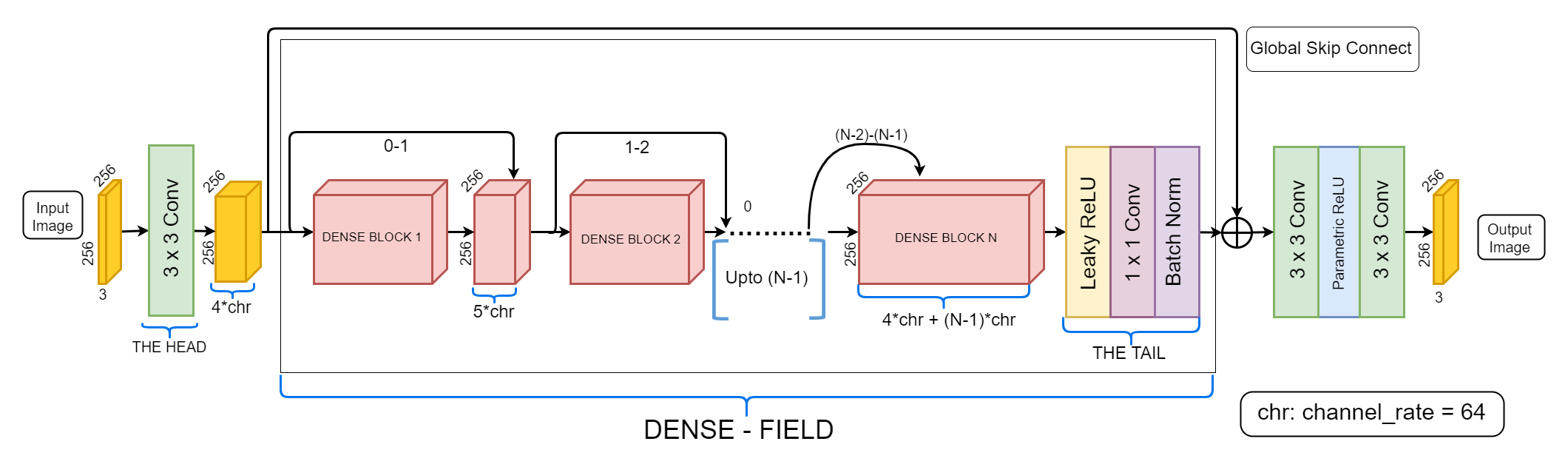

그림 1과 같은 저희의 생성기 모델은 헤드, 조밀 필드, 테일 및 전역 스킵 연결의 4가지 부분으로 구성됩니다.

아래에서 각 부분에 대해 자세히 설명합니다.

a) The Head:

저희는 하이퍼 파라미터 'channel-rate' (chr)를 각 컨볼루션 레이어에서 출력되는 활성화함수 채널의 일정한 수로 정의합니다.

channel-rate의 값은 64입니다.

헤드는 raw 입력 이미지 위에서 컨볼루션하고 4배 channel-rate (256) 피쳐 활성화함수를 출력하는 간단한 3x3 컨볼루션 레이어로 구성됩니다.

이는 조밀하게 연결된 레이어 스택을 트리거하기에 충분한 첫 번째 레벨 활성화함수 맵을 제공합니다.

b) The Dense Field:

이 섹션은 순차적으로 배치된 N개의 컨볼루션 'blocks'로 구성되며, 모든 출력은 앞에 있는 레이어의 출력과 완전히 연결됩니다.

조밀한 연결은 조밀한 필드에 있는 모든 i번째 레이어의 출력 활성화함수 맵을 (i+1)번째 레이어의 출력 맵과 연결하여 실제로 효율적으로 달성됩니다.

따라서 m번째 밀집 블록에 입력되는 활성화함수 맵의 수는 '4 x chr + (m - 1) x chr'과 같습니다.

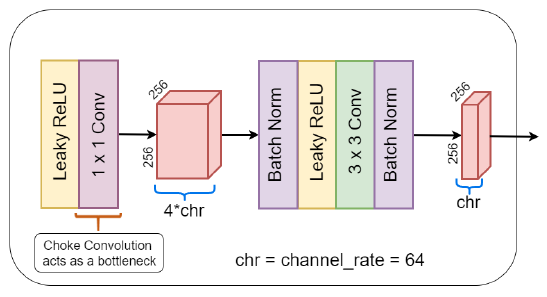

밀집 블록의 구조는 그림 2에 나와 있습니다.

첫 번째 작업은 들어오는 활성화함수에 비선형성을 추가할 뿐만 아니라 GAN 학습 안정성을 손상시킬 수 있는 희소 그래디언트 사용을 피하는 Leaky ReLU [15]입니다.

1x1 컨볼루션은 나중에 컨볼루션되는 활성화함수 맵의 수를 '4 x chr'과 동일한 최대로 'chokes'합니다.

이는 들어가는 raw 활성화함수 채널의 수가 6 x chr(384) 이상일 때 밀집 필드의 더 깊은 레이어에서 매개 변수와 데이터 메모리를 보존합니다.

각 밀집 블록의 마지막 레이어에서 컨볼루션은 3 x 3 x (4 x chr) 필터의 'chr' 수를 사용하여 각 밀집 블록의 끝에서 'chr' 수의 활성화함수 맵을 생성합니다.

밀집 필드를 따라 있는 3x3 컨볼루션은 'spatial' 컨볼루션과 'dilated' 컨볼루션 사이에서 교대로 확장 계수가 선형적으로 증가합니다 [22].

저희는 조밀 필드 내의 모든 짝수 레이어에서 확장 컨볼루션 [22]를 사용합니다.

저희는 확장 계수가 조밀 필드의 중심까지 최대로 선형적으로 증가한 다음 테일에 도착할 때까지 대칭적으로 감소합니다.

이는 매개변수 공간이 선형적으로 증가하는 동안 모든 레이어에서 지수적인 속도로 수용 필드를 증가시키는 데 도움이 되며, 따라서 후속 조밀 레이어에 도착하는 여러 스케일의 활성화함수 맵 간에 더 높은 불균형을 초래합니다.

저희는 네트워크 전체에서 출력 맵의 차원을 일정하고 동일하게 유지하기 위해 풀링 및 스트리드 컨볼루션 작업을 피합니다.

각 블록 끝에 드롭아웃을 추가하면 G가 순수 델타 분포 이외의 쉐이크 분포를 맹목적으로 모델링하여 GAN 붕괴 문제를 방지하는 생성기(G)의 각 레이어 입력에 가우시안 노이즈를 효과적으로 추가하는 데 도움이 됩니다.

c) The Tail:

테일은 비선형성을 추가하고 1x1 컨볼루션을 통해 피쳐 맵의 수를 4 x chr로 증가시킵니다.

d) The Global Skip Connection:

심층 생성 CNN은 일반적으로 여러 컨볼루션 연산을 사용하여 첫 번째 레벨 피쳐에 대해 일반화하는 것이 사소하지 않기 때문에 종종 높은 레벨의 에지 표현을 실수로 암기하는 문제에 직면합니다.

이로 인해 네트워크가 흔들린 이미지에서 올바른 위치에서 샤프한 경계를 검색할 수 없게 됩니다.

저희는 네트워크 헤드의 출력을 테일의 출력과 연결합니다.

이는 이제 그래디언트가 테일에서 첫 번째 레벨 컨볼루션 레이어로 곧장 흘러가고 하위 레이어의 업데이트에 영향을 미칠 수 있기 때문에 생성 성능이 크게 향상됩니다.

그러나 더 중요한 것은 이 단일 연결이 중앙의 전체 조밀 필드를 'drives'하여 이미지의 'full knowledge'을 ground truth와 블러된 이미지 사이의 잔차를 이해하는 데 사용한다는 것입니다.

한편, 또한 생성기 끝에 입력된 ground truth에서 직접 CNN의 가버와 같은 피쳐를 최적화합니다 [23].

그러나 이미지 복원 모델에 사용되는 기존의 잔차 네트워크와 달리 계단식 스킵 합산을 사용하지 않습니다.

대신, 저희는 조밀한 연결을 통해 하위 레벨의 지식을 상위 레이어로 전달하고 전체 조밀 필드를 지시하여 전역 잔차만 계산합니다, 실험에서 알 수 있듯이 저희 네트워크가 더 빨리 학습하고 더 나은 수렴을 달성하고 훨씬 더 나은 디블러링 성능을 보여줄 수 있습니다.

3.1.2 The Discriminator

저희 GAN 프레임워크에서 판별기는 생성기가 복원된 이미지를 생성하기 위해 사용하는 통계를 안내하는 주요 에이전트입니다.

또한 판별기 네트워크 깊이가 더 쉬운 분류 작업을 기억할 정도로 원하지 않습니다.

저희는 10개의 컨볼루션 레이어가 있는 Marcovian 패치 판별기 [13]를 사용하는데, 이는 여러 로컬 패치에서 잘 정의된 구조적 피쳐를 찾는 경향이 있는 비중첩 슬라이딩 창과 유사합니다.

또한 생성된 자연 이미지 [7]에서 풍부한 색상을 적용합니다.

3.2. Loss Functions

a) l1 and Adverserial Loss:

전통적으로 학습 기반 이미지 복원 작업은 ground truth와 수정된 이미지 사이의 l1 또는 l2 loss를 주요 objective 함수로 사용했습니다 [1].

이러한 목적으로 사용되는 적대적 프레임워크의 경우 이 loss는 판별자를 속이는 것과 관련하여 생성기가 얼마나 잘 수행하고 있는지 측정하는 adverserial loss와 통합됩니다.

그러나 픽셀 단위 오류 함수는 불확실성 [1]에 직면할 때마다 이미지 매니폴드에서 가능한 모든 솔루션의 평균에 수렴하는 경향이 있기 때문에 심층 CNN 모델에서만 l1 loss를 사용하면 지나치게 부드러운 이미지가 생성됩니다.

이는 샤프한 에지가 많지 않으며 가장 중요하게는 엣지와 모서리에 여전히 블러가 크게 손상되지 않은 칙칙한 이미지를 생성합니다.

동시에 adverserial loss를 사용하는 것만으로 에지가 유지되고 보다 현실적인 색상 분포가 생성됩니다 [1].

그러나 두 가지 점에서 타협합니다: 여전히 구조에 대한 추상적인 개념이 없으며 블러 입력과 관련 없이 출력 이미지만으로 판별자가 생성기 성능을 판단할 뿐입니다.

perceptual loss를 활용하여 식 4에 주어진 순 loss 함수에 추가함으로써 이러한 한계를 제거합니다.

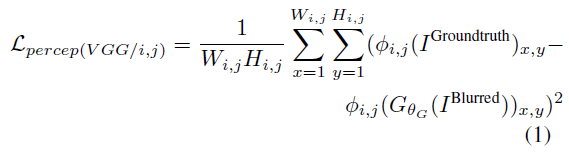

b) Perceptual Loss:

Markovian 판별기의 패치별 판단에 대응하기 위해 구조적 지식을 생성기에 증강해야 합니다.

[8]에 소개된 바와 같이 이러한 loss 함수 중 하나는 'perceptual loss'라고도 하는 생성된 잠재 이미지와 ground truth의 심층 컨볼루션 활성화함수 사이의 유클리드 차이입니다.

이 loss 항은 식 1에 나와 있습니다,

여기서, W_(i,j), H_(i,j)는 VGG-16 네트워크 [17]의 (i,j)^번째 ReLU 레이어의 폭 및 높이이고, ɸ_(i,j)는 VGG-16 네트워크를 통한 ReLU 3_3 레이어까지의 순방향 패스입니다.

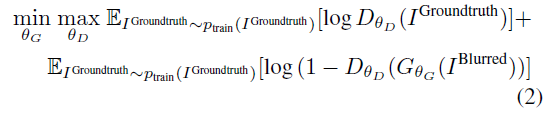

3.2.1 Conditional adversarial framework

저희는 GAN 프레임워크의 판별기에 두 개의 이미지 쌍을 입력합니다.

한 쌍은 입력 블러된 이미지와 생성기에서 생성된 해당 출력 이미지로 구성되는 반면, 다른 쌍은 입력 블러된 이미지와 해당 ground truth 디블러된 이미지로 구성됩니다.

이는 입력 이미지가 주어진 상태에서 잠재 이미지의 조건부 분포를 모델링하는 생성기와 수렴되며, 이 결과는 생성된 이미지가 주어진 입력과 출력 사이에 높은 통계적 일관성을 유지하는 데 도움이 됩니다.

저희는 'G'가 다양한 종류와 양의 흔들림 블러를 수용하고 판별기를 속이려는 노력으로 너무 멀리 흔들리는 것을 방지하기 위해 블러된 입력에 대한 출력 의존성을 유지하기를 원하기 때문에 이것이 본질적으로 우리가 필요한 것입니다.

따라서 저희는 조건부 GAN을 이미지 네트워크에 대한 이미지의 'relevance regularizer'로 볼 수 있습니다.

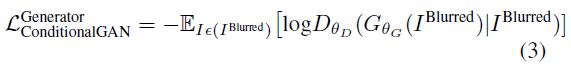

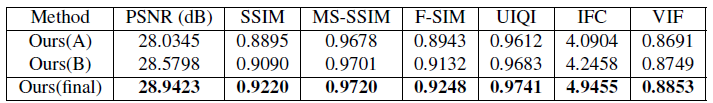

수학적으로, 이것은

에 의해 주어진 원래 GAN 최적화 문제를

에 의해 주어진 조건부 loss 함수로 변경할 것입니다.

따라서 저희 네트워크의 결합 loss 함수는

이며, 여기서 K_1과 K_2는 실험에서 각각 145와 170으로 설정된 하이퍼미터입니다.

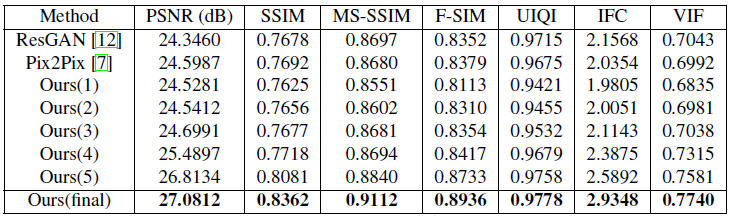

표 3에서 저희는 이 기술을 도입함으로써 모든 메트릭에서 성능이 크게 향상되었음을 알 수 있습니다.

이 단계에서 저희 네트워크는 작업에 맞게 수정되고 학습된 두 가지 기본 모델을 이미 능가했습니다: [12]에서 사용하는 매우 심층적이고 순차적인 ResNet 모델과 [7]에서 사용하는 모래시계, U-net 모델입니다.

훨씬 적은 레이어(10개의 조밀한 블록)를 가진 저희의 조밀한 모델은 성능이 뛰어날 뿐만 아니라 15개의 잔여 블록을 가진 [12]의 모델보다 더 빠르게 수렴하여 모델과 프레임워크가 훨씬 더 잘 공진하는 것을 보여주었다는 점에 주목할 필요가 있습니다.

4. Experiments

4.1. Experimental Settings

torch7 라이브러리로 모델을 구현했습니다.

모든 실험은 i7 프로세서와 NVIDIA GTX Titan X GPU가 있는 워크스테이션에서 수행되었습니다.

Network Parameters:

저희는 ADAM 체계[9]를 통해 loss 함수를 최적화하고 stochastic gradient descent (SGD)를 사용하여 수렴합니다.

실험 내내 학습을 위한 배치 크기를 3으로 유지하고 기본 학습 속도와 운동량을 각각 0.0002와 0.9로 고정했습니다.

[7]과 유사하게 테스트 시간 동안 배치 통계를 학습하는 대신 인스턴스 정규화를 사용합니다.

Experiments for further architectual considerations:

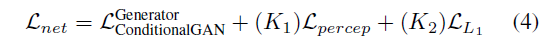

또한 완전히 진화된 모델의 아키텍처에 대해 간단한 ablation 연구를 수행하여 조밀한 그물망의 어떤 연결이 이미지 복원을 향해 더 중요한지 분리하여 자체 모델을 추가로 탐색합니다.

저희는 이를 위해 'A'와 'B'라는 두 개의 하위 조밀한 아키텍처를 사용합니다.

ablation 연구의 결과는 표 1에 나와 있습니다.

A) 이 모델에서 'dense field'의 세 개의 하위 및 상위 극단 레이어는 [12] 및 [16]의 연속 잔차로 대체되는 반면 중간 레이어는 밀도가 높습니다.

그렇게 함으로써 최종 모델에 비해 성능이 크게 저하되었음을 발견했습니다.

이는 중앙 부분에 헤드와 테일 사이의 전역 잔차를 계산하는 데 중요한 'forgotten' 엔트리 레벨 피쳐가 있기 때문입니다.

B) 잔차와 조밀 레이어의 위치를 전환하면 완전 잔차 네트워크 [12]와 중앙 조밀 네트워크 (A)를 모두 갖는 것보다 성능이 향상됩니다.

최종 모델에서는 약간 능가하지만 많은 데이터 연결을 줄임으로써 GPU 메모리를 극적으로 절약할 수 있습니다.

따라서 가장 먼 레이어 간의 연결이 달성될 때 조밀한 연결이 가장 효과적입니다.

이를 통해 네트워크가 상위 레이어의 지식을 전역화하기 위해 하위 피쳐를 계속 재활용할 수 있습니다.

4.2. Datasets

모델을 학습시키기 위해 GoPRO 데이터 세트에서 256x256x3 크기의 패치를 추출하고 MS-COCO [14] 및 ImageNet 데이터 세트 [2](256x256x3 크기)에서 랜덤으로 샘플링된 이미지와 결합하여 학습 데이터 세트를 생성했습니다.

그런 다음 MS-COCO 및 ImageNet 데이터 세트에서 샘플링된 이미지에 [11]과 유사한 불균일한 블러를 적용합니다.

또한 이동 및 회전 플립을 사용하여 데이터 증강을 수행하여 블러되고 디블러된 이미지의 0.5백만 개의 학습 이미지 쌍으로 구성된 최종 데이터 세트를 생성합니다.

저희는 저희가 합성적으로 생성한 한 데이터 세트에서 점진적 모델을 비교하고 세 가지 다른 벤치마크 데이터 세트에서 다른 SOTA 방법과 방법의 성능을 비교합니다.

Lai et al. [11]에 이어 저희는 디셰이킹 모델의 정량적 분석을 위해 8가지 전체 참조 메트릭을 사용했습니다.

이러한 메트릭에 대한 자세한 설명은 [11]에서 확인할 수 있습니다.

비교를 위해 저희는 다음과 같은 방법으로 제공되는 SOTA 블라인드 디블러링 알고리즘을 선택합니다: Xu et al. [21], Whyte [20], Sun et al. [18], MBMF [3] 및 MS-CNN [16].

a) Places Dataset [24]:

진행 모델의 정량적 비교를 수행하기 위해 앞서 설명한 것과 동일한 방식으로 합성 블러된 데이터 세트를 생성합니다.

Places 데이터 세트의 이미지를 사용하여 디블러된 이미지와 블러된 이미지 쌍을 생성했습니다.

그 결과는 표 3에 나와 있습니다.

표 3의 Ours(1)은 l1 loss만 있는 조밀한 생성 네트워크를 설명합니다.

b) GoPro Dataset [16]:

이 데이터 세트의 이미지는 GoPro를 사용하여 캡처되었으며 실생활에서 발생하는 블러를 면밀히 모방합니다.

전체 이미지 중 테스트 데이터 세트에 438개의 이미지를 사용하고 나머지 이미지는 트레이닝 데이터 세트를 생성하는 데 사용했습니다.

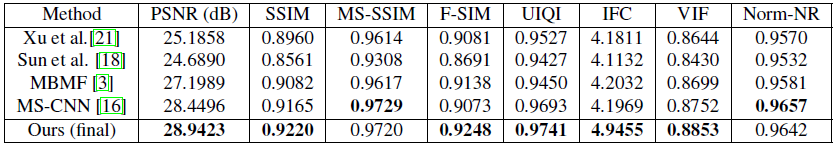

저희는 표 4의 다른 SOTA 방법과 정량적 비교 결과를 보여줍니다.

저희의 결과는 이미지 품질 측면에서 상당한 향상을 보여줍니다.

c) Lai et al. Dataset [11]:

Lai et al.은 불균일한 블러 커널을 컨볼루션하고 몇 가지 일반적인 저하를 부과하여 합성 데이터 세트를 생성했습니다.

블러 커널을 생성하기 위해 그들은 6D 카메라 궤적도 기록했습니다.

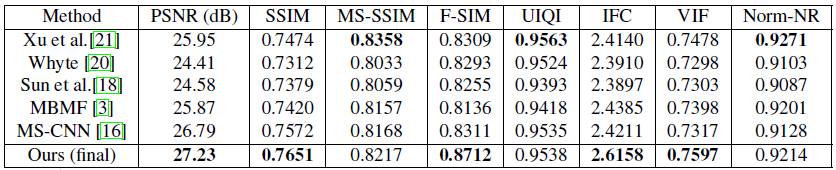

저희 방법과 다른 알고리즘의 비교 방법은 표 5에 나와 있습니다.

커널 추정 단계를 우회하는 MS-CNN 학습 모델[16]은 저희가 자체 모델을 학습하는 데 사용했던 것과 동일한 데이터 세트에서 재학습되었습니다.

반면, 저희는 비교 보고를 위해 [18]과 [3]의 사용 가능한 테스트 코드를 사용합니다.

d) K¨ohler et al. Dataset [10]:

이 벤치마크 데이터 세트는 4개의 잠재 이미지로 구성됩니다.

불균일한 블러 데이터 세트를 구성하기 위해 블러된 이미지를 캡처한 선형 카메라 응답 함수를 가정하여 시간 경과에 따라 12개의 6D 카메라 궤적을 기록했습니다.

캡처된 장면은 평면적이고 카메라와 고정된 거리였습니다.

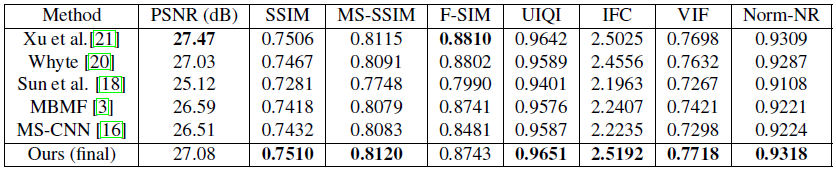

저희는 표 6에 이 데이터 세트에 대한 정량적 결과를 보고합니다.

표를 통해 저희 모델이 다른 방법을 훨씬 능가한다는 것을 추론할 수 있었습니다.

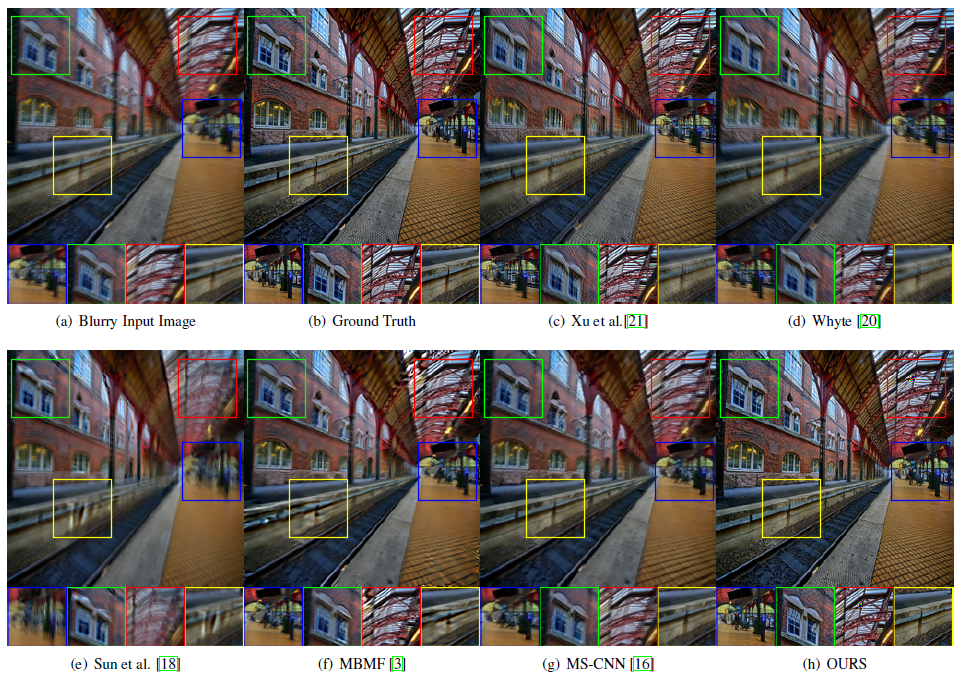

다른 방법과 저희 방법의 정성적 비교는 그림 3, 그림 4 및 그림 5에서 확인할 수 있습니다.

그림에서 알 수 있듯이 저희 방법으로 생성된 결과는 SOTA 방법에 비해 시각적으로 우수합니다.

5. Conclusion

저희는 흔들린 이미지의 블라인드 복원을 수행하는 새로운 엔드 투 엔드 조건부 GAN 기반 필터 모델을 설계했습니다.

저희의 결과는 저희의 모델과 프레임워크가 불균일한 디블러링에 대해 SOTA 성능을 능가한다는 것을 보여줍니다.

저희 모델의 빠른 실행 시간은 카메라와 사진 편집 도구에 쉽게 배포할 수 있습니다.

저희는 조밀하게 연결된 컨볼루션 네트워크가 분류에서와 마찬가지로 이미지 생성에 효과적일 수 있음을 보여줍니다.