2025. 8. 12. 09:39ㆍRobotics

Fine-Tuning Vision-Language-Action Models: Optimizing Speed and Success

Moo Jin Kim, Chelsea Finn, Percy Liang

Abstract

최근의 vision-language-action 모델 (VLA)은 사전 학습된 비전-언어 모델을 기반으로 하며, 다양한 로봇 데이터셋을 활용하여 강력한 작업 실행, 언어 추종 능력, 시맨틱 일반화를 입증합니다.

이러한 성공에도 불구하고 VLA는 새로운 로봇 설정에 어려움을 겪고 있으며, 좋은 성능을 달성하기 위해 파인튜닝이 필요하지만, 많은 가능한 전략을 고려할 때 이를 가장 효과적으로 파인튜닝하는 방법은 불분명합니다.

이 연구에서는 OpenVLA를 대표 base 모델로 사용하여 다양한 action 디코딩 방식, action 표현, 파인튜닝을 위한 학습 objective와 같은 주요 VLA 적응 설계 선택 사항을 연구합니다.

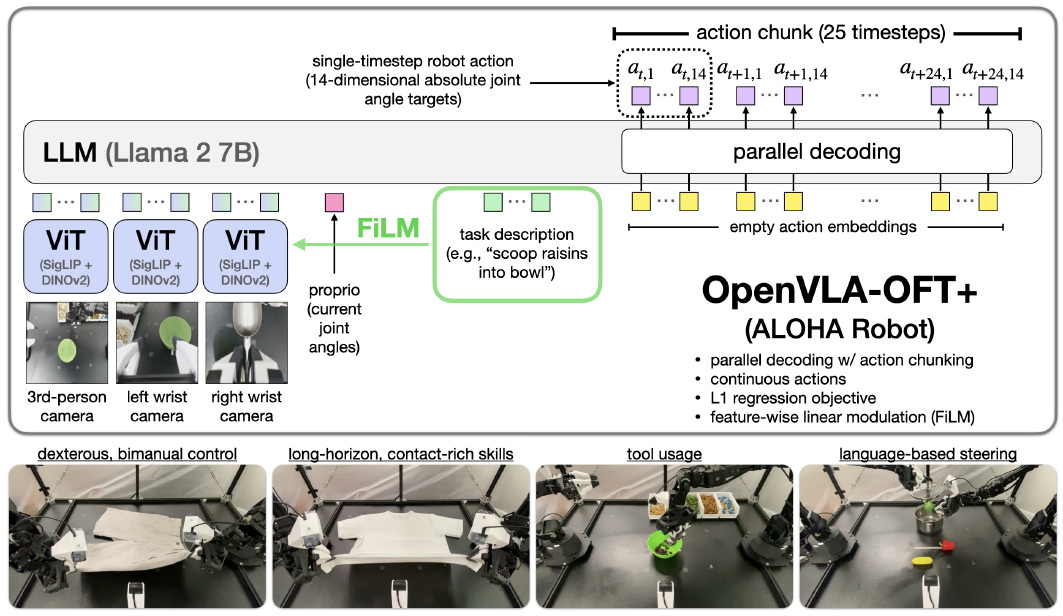

우리의 실증 분석은 병렬 디코딩, action 청킹, 연속 action 표현, 간단한 L1 회귀 기반 학습 objective를 통합하여 모델의 입출력 사양에서 추론 효율성, policy 성능 및 유연성을 모두 향상시키는 Optimized Fine-Tuning (OFT) 레시피를 제공합니다.

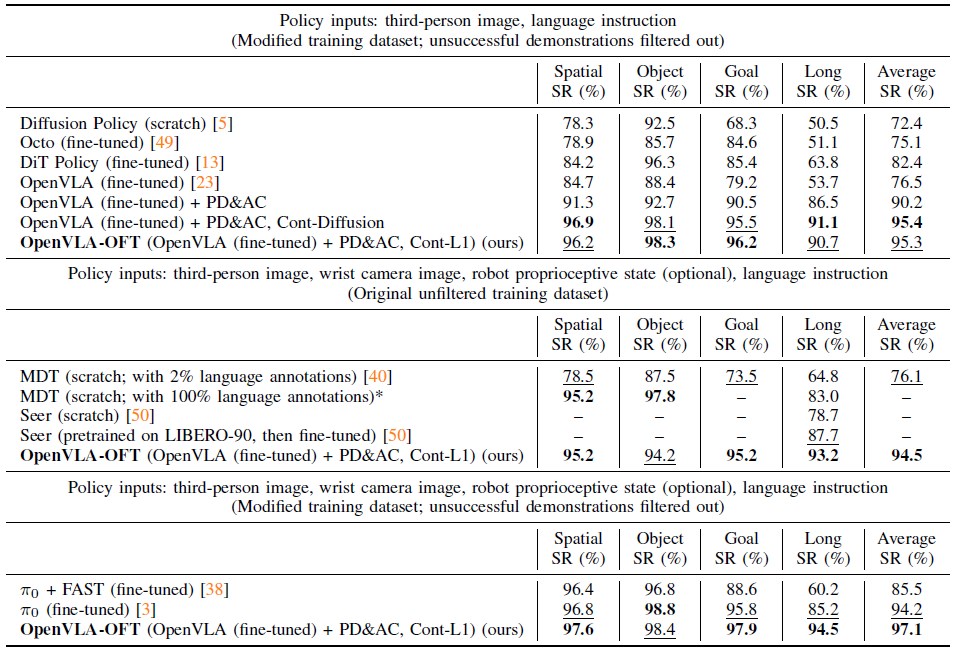

우리는 이 레시피의 인스턴스화인 OpenVLA-OFT를 제안합니다, 이는 LIBERO 시뮬레이션 벤치마크에서 새로운 SOTA 기술을 설정하여, 4개의 태스크 스위트에서 OpenVLA의 평균 성공률을 76.5%에서 97.1%로 크게 높이는 동시에 action 생성 처리량을 26배 증가시킵니다.

실제 평가에서 우리의 파인튜닝 레시피는 OpenVLA가 이중 수동 ALOHA 로봇에서 능숙하고 고주파 제어 작업을 성공적으로 수행할 수 있게 해주며, 기본 레시피를 사용하여 파인튜닝된 다른 VLA (π_0 및 RDT-1B)와 처음부터 학습된 강력한 모방 학습 policy (Diffusion Policy 및 ACT)을 평균 성공률에서 최대 15% (절대)까지 능가합니다.

Ⅰ. Introduction

최근 vision-language-action 모델(VLA)—저수준 로봇 제어를 위해 대규모 로봇 데이터셋에서 사전 학습된 비전-언어 모델을 파인튜닝하여 구축된 로봇 policy—은 다양한 로봇과 작업에서 강력한 작업 성능, 시맨틱 일반화 및 언어 추종 능력을 입증했습니다 [4, 34, 24, 23, 7, 15, 8, 53, 58, 3].

그들의 강점에도 불구하고, VLA를 새로운 로봇과 작업에 만족스럽게 배치하기 위해서는 파인튜닝이 매우 중요하지만, 넓은 설계 공간을 고려할 때 가장 효과적인 적응 방법이 무엇인지는 불분명합니다.

VLA를 새로운 로봇 설정 및 작업에 맞게 파인튜닝하고자 하는 로봇 공학 실무자는 사전 학습에 사용된 동일한 학습 레시피 (또는 매개변수 효율적인 변형)를 사용하지 않을 수 있지만, 이것이 최선의 policy를 제공할 수 있을지는 확실하지 않으며, 문헌에서 대체 파인튜닝 접근법에 대한 실증적 분석은 제한적입니다.

이전 연구에서는 VLA 적응 전략을 탐구하기 시작했으며, Kim et al. [23]은 LoRA를 통해 매개변수 효율적인 파인튜닝을 제안했습니다.

그러나 이들의 자기회귀 action 생성은 고주파 제어 (25-50Hz 이상)에 비해 너무 느리고 (3-5Hz), 자기회귀 VLA의 LoRA와 전체 파인튜닝 모두 이중 수동 조작 작업에서 종종 만족스럽지 못한 성능을 발휘합니다 [54, 27, 3].

최근 접근 방식은 더 나은 action 토큰화 방식 [2, 38]을 통해 효율성을 향상시키지만, action 청크 간의 상당한 지연 시간 (예: 최근 FAST 접근 방식 [38]의 경우 750ms)은 여전히 고주파 이중 수동 로봇에 실시간 배포를 제한합니다.

만족스러운 속도와 품질을 모두 달성하는 대체 VLA 적응 접근법을 탐구하는 것은 여전히 미개척 연구 분야로 남아 있습니다.

이 연구에서는 대표적인 자기회귀 VLA인 OpenVLA를 base 모델로 사용하여 새로운 로봇과 작업에 VLA를 적용하기 위한 주요 설계 결정을 연구합니다.

우리는 세 가지 주요 설계 선택 사항을 검토합니다: action 디코딩 방식 (자기회귀 vs. 병렬 생성), action 표현 방식(이산 vs. 연속), 학습 objective (다음 토큰 예측 vs. L1 회귀 vs 디퓨전).

우리의 연구는 서로에게 기반을 둔 몇 가지 주요 인사이트를 밝혀냅니다:

(1) action 청킹을 사용한 병렬 디코딩은 추론 효율성을 높일 뿐만 아니라 다운스트림 작업의 성공률을 향상시키면서 모델의 입출력 사양에 더 큰 유연성을 제공합니다;

(2) 연속적인 action 표현은 이산 표현에 비해 모델 품질을 더욱 향상시킵니다;

(3) L1 회귀 objective를 사용하여 VLA를 파인튜닝하면 디퓨전 기반 파인튜닝과 비슷한 성능을 발휘하면서도 더 빠른 학습 수렴 및 추론 속도를 제공합니다.

이러한 인사이트를 바탕으로 OpenVLA-OFT를 소개합니다: 병렬 디코딩 및 action 청킹, 연속 action 표현, L1 회귀 objective를 통합하여 알고리즘적 단순성을 유지하면서 추론 효율성, 작업 성능 및 모델 입출력 유연성을 향상시키는 Optimized Fine-Tuning (OFT) 레시피의 구현입니다.

우리는 표준화된 LIBERO 시뮬레이션 벤치마크와 실제 이중 수동 ALOHA 로봇에 대한 능숙한 작업 모두에 대해 실험을 수행합니다.

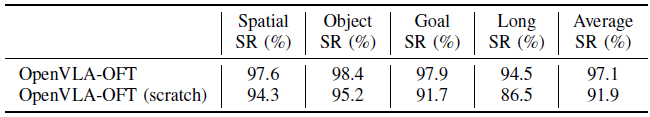

LIBERO에서 OpenVLA-OFT는 4개의 작업 스위트에서 평균 97.1%의 성공률을 달성하여 새로운 SOTA 기술을 확립했습니다, 이는 파인튜닝된 OpenVLA policy [23] (76.5%)와 π_0 policy [3] (94.2%)를 능가하는 동시에 8단계 action 청크로 action 생성 속도를 26배 향상시켰습니다.

실제 ALOHA 작업 [56]의 경우, 향상된 언어 기반을 위해 FiLM [37]으로 레시피를 보강하여 OFT+로 표시합니다.

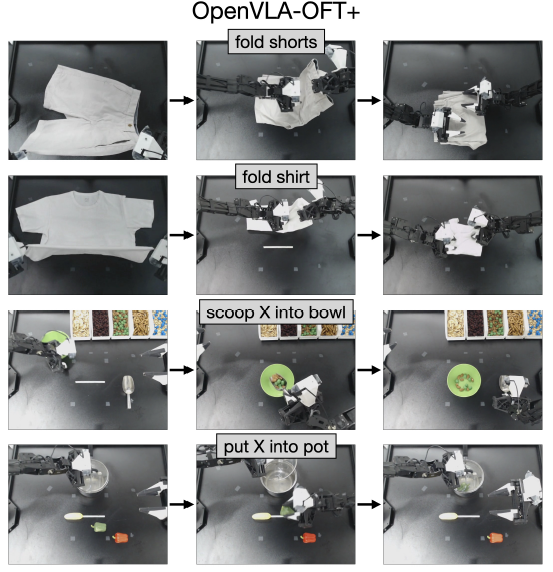

OpenVLA-OFT+는 사용자의 프롬프트를 기반으로 옷을 접거나 타겟 식품을 조작하는 등 손재주가 많은 이중 수작업 작업을 성공적으로 수행하여 파인튜닝된 VLA (π_0 및 RDT-1B)와 처음부터 학습된 저명한 모방 학습 policy (Diffusion Policy 및 ACT)을 평균 성공률에서 최대 15% (절대)까지 능가합니다.

25단계 action 청크를 사용하는 OpenVLA-OFT+는 기본 OpenVLA보다 43배 빠른 처리량을 달성하여 강력한 작업 성능과 언어 추종 능력으로 실시간 로봇 제어를 가능하게 한다는 것을 입증했습니다.

Ⅱ. Related Work

이전 연구들은 언어 및 비전 기반 모델을 활용하여 로봇의 역량을 향상시켜 왔으며, 이를 로봇 policy 학습을 가속화하는 사전 학습된 시각적 표현 [30, 33, 31, 20, 32], 로봇 작업의 객체 위치 파악 [9, 47], 고차원 계획 및 추론 [1, 17, 44, 16, 45, 18, 6]에 활용했습니다.

최근 연구자들은 저수준 로봇 제어 action을 직접 예측하기 위해 vision-language models (VLM)을 파인튜닝하여 "vision-language-action" 모델 (VLA) [4, 34, 24, 23, 7, 15, 8, 53, 54, 3, 2]을 개발했습니다, 이 모델들은 [59]에 이어 효과적인 언어를 사용하고 분포 외 테스트 조건과 보이지 않는 시맨틱 개념으로 일반화하는 것을 입증했습니다.

이 연구들은 주로 모델 개발에 중점을 두고 있으며, 우리는 이러한 모델을 파인튜닝하는 방법을 개발하고, 경험적 분석을 통해 얻은 통찰력을 바탕으로 개별 설계 결정을 정당화하는 데 중점을 둡니다.

실제 VLA 배포를 위한 파인튜닝의 중요성에도 불구하고, 효과적인 파인튜닝 레시피에 대한 실증적 분석은 여전히 제한적입니다.

Kim et al. [23]은 다양한 매개변수 업데이트 전략과 그들의 연구 결과를 통해 LoRA 파인튜닝이 낮은 제어 주파수 (< 10Hz)에서 작동하는 싱글 암 로봇에 효과적으로 적응할 수 있음을 보여주지만, 이들의 분석은 더 복잡한 제어 시나리오인 높은 제어 주파수 (25-50Hz 이상)를 가진 이중 수동 로봇에는 적용되지 않습니다.

우리는 25Hz 컨트롤러를 사용하는 실제 이중 수동 조작기에서 빠른 추론과 신뢰할 수 있는 작업 실행을 위해 VLA 적응 설계 결정을 탐구함으로써 이 격차를 해결합니다.

Belkhale와 Sadigh [2] 및 Pertsch et al. [38]의 최근 연구는 새로운 action 토큰화 방식을 통해 VLA 효율성을 향상시키며, 벡터 양자화 또는 이산 코사인 변환 기반 압축을 사용하여 단순 차원 당 비닝 (RT-2 [4] 및 OpenVLA [23]에서 사용된 것처럼)보다 적은 토큰으로 action 청크 (action 시퀀스)를 표현합니다.

이러한 접근 방식은 자기회귀 VLA에서 2배에서 13배의 속도 향상을 달성하지만, 반복 생성에 의해 본질적으로 제한되는 자기회귀 모델링을 넘어 설계 결정을 탐구합니다.

우리의 병렬 디코딩 접근 방식은 action 청킹과 결합될 때 훨씬 더 빠른 속도 향상을 달성합니다: 26배에서 43배의 처리량과 훨씬 낮은 지연 시간 (하나의 입력 이미지를 가진 싱글 암 작업의 경우 0.07ms, 세 개의 입력 이미지를 가진 이중 수동 작업의 경우 0.321ms)입니다.

또 다른 연구 [54, 27, 3]는 디퓨전 또는 플로우 매칭과 같은 생성적 접근 방식을 사용하여 고주파, 이중 수동 조작에 효과적인 VLA 파인튜닝을 보여줍니다.

이러한 디퓨전 기반 VLA는 여러 시간 단계의 action 청크를 동시에 생성하여 자기회귀 VLA보다 더 높은 action 처리량을 달성하지만, 추론 시 느린 학습과 여러 디노이징 또는 통합 단계를 통해 계산적 절충점을 제공합니다.

또한 이러한 디퓨전 VLA는 아키텍처, 학습 알고리즘, 비전-언어 융합 접근 방식, 입력-출력 사양 등에서 상당히 다양합니다—어떤 디자인 요소가 성능에 가장 큰 영향을 미치는지는 아직 명확하지 않습니다.

통제된 실험을 통해, 우리는 더 간단한 L1 회귀 objective로 파인튜닝된 policy가 작업 성능 면에서 더 복잡한 접근 방식과 일치하면서도 훨씬 더 높은 추론 효율성을 달성할 수 있음을 보여줍니다.

마지막으로, 이전 연구에서는 느린 VLA [36]와 더불어 더 빠른 저수준 제어 policy에 의존하는 것과 달리, 본 연구에서는 별도의 컨트롤러 없이 높은 효율성을 가능하게 하는 기술을 사용하여 기본 VLA를 종단 간으로 파인튜닝합니다.

또한, 강화 학습을 통해 전문가 policy를 지속적으로 업데이트하기 위해 온라인 상호작용 데이터를 수집하는 다른 작업들과 달리, 여기서는 고정된 전문가 과제 시연 데이터셋에서 오프라인으로 한 번만 학습하여 고성능 policy를 개발하는 더 간단한 모방 학습 패러다임에 중점을 둡니다 [19].

Ⅲ. Preliminaries

Original OpenVLA formulation.

우리는 OpenVLA [23]을 대표 기반 VLA로 사용합니다, 이는 Open X-Embodiment 데이터셋 [34]의 1백만 에피소드에서 Prismatic VLM [21]을 파인튜닝하여 만든 7B 매개변수 조작 policy입니다.

아키텍처 세부 사항은 부록 A를 참조하세요.

OpenVLA의 원래 학습 공식은 시간 단계당 7개의 이산 로봇 action 토큰의 자기회귀 예측을 사용합니다: 위치 제어용 3개, 방향 제어용 3개, 그리퍼 제어용 1개입니다.

언어 모델과 유사하게 교차 엔트로피 loss를 학습 objective로 하는 다음 토큰 예측을 사용합니다.

다음 몇 섹션에서는 병렬 디코딩, 연속 action 표현, L1 회귀 및 디퓨전 모델링과 같은 학습 objective를 포함한 대체 공식을 탐구합니다.

Action chunking.

이전 연구들은 action 청킹—즉, 중간 계획 없이 일련의 미래 action을 예측하고 실행하는 것—이 많은 조작 작업에서 policy 성공률을 향상시킨다는 것을 보여주었습니다 [56, 5, 28].

그러나 OpenVLA의 자기회귀 생성 방식은 NVIDIA A100 GPU에서 단 한 번의 단계 action도 생성하는 데 0.33초가 걸리기 때문에 action 청킹을 비현실적으로 만듭니다.

K개의 타임스텝과 action 차원 D의 청크 크기에 대해 OpenVLA는 K D 순차 디코더 순방향 패스가 필요하며, 청킹 없이 D개의 패스만 필요합니다.

지연 시간이 K배 증가함에 따라 원래 공식 하에서 고주파 로봇의 action 청킹은 비현실적입니다.

다음 섹션에서는 효율적인 action 청킹을 가능하게 하는 병렬 생성 방식을 제시합니다.

Ⅳ. Studying Key VLA Fine-Tuning Design Decisions

이 섹션에서는 먼저 VLA를 새로운 로봇 설정 및 작업에 적용하기 위한 주요 설계 결정을 개략적으로 설명하고, 그 구현에 대한 세부 사항을 제공합니다.

A. VLA Fine-Tuning Design Decisions

base 모델의 자기회귀 학습 레시피를 사용하여 VLA를 파인튜닝하는 기존 접근 방식은 두 가지 주요 한계에 직면해 있습니다: 느린 추론 속도 (3-5Hz)는 고주파 제어에 적합하지 않으며, 이중 조작기에서 신뢰할 수 없는 작업 실행 [54, 27, 3].

이러한 문제를 해결하기 위해 우리는 VLA 파인튜닝을 위한 세 가지 주요 설계 구성 요소를 조사합니다:

(a) Action generation strategy (그림 2, 왼쪽):

순차적인 토큰-바이-토큰 처리가 필요한 자기회귀 생성과 모든 action을 동시에 생성하고 효율적인 action 청킹을 가능하게 하는 병렬 디코딩을 비교합니다.

(b) Action representation (그림 2, 오른쪽):

소프트맥스 기반 토큰 예측을 통해 처리된 이산 action (정규화된 action의 256-bin 이산화)과 MLP action 헤드에서 직접 생성된 연속 action을 살펴봅니다.

이산 action의 경우, 언어 모델 디코더의 최종 히든 state는 로짓에 선형적으로 투영되며, 로짓은 소프트맥스 연산에 의해 처리되어 action 토큰에 대한 확률 분포를 형성합니다.

연속 action의 경우, 최종 히든 state는 대신 별도의 action 헤드 MLP에 의해 정규화된 연속 action에 직접 매핑됩니다.

(c) Learning objective (그림 2, 오른쪽):

이산 action에 대한 다음 토큰 예측, 연속 action에 대한 L1 회귀 [56], 연속 action에 대한 conditional denoising diffusion [5]로 파인튜닝된 policy를 비교합니다 (Chi et al. [5]와 유사함).

우리는 OpenVLA [23]을 base 모델로 사용하여 연구를 수행합니다, 이는 비교적 작은 학습 데이터셋 (사전 학습을 위한 500개의 데모와 100만 개의 데모) 때문에 LoRA 파인튜닝 [14]을 통해 이를 조정한 것입니다.

B. Implementing Alternative Design Components

base OpenVLA 모델은 원래 다음 토큰 예측을 통해 최적화된 이산 action 토큰의 자기회귀 생성을 사용합니다.

우리는 원래의 사전 학습을 그대로 유지하면서 파인튜닝을 위한 대체 설계 결정을 구현합니다.

아래에서는 주요 구현 측면을 설명하며, 자세한 내용은 부록 B에 설명되어 있습니다.

Parallel decoding and action chunking.

순차적인 토큰 예측이 필요한 자기회귀 생성과 달리 병렬 디코딩을 통해 모델은 입력 임베딩을 단일 순방향 패스로 예측된 출력 시퀀스에 매핑할 수 있습니다.

모델을 수정하여 빈 action 임베딩을 입력으로 받고 인과 어텐션 마스크를 양방향 어텐션으로 대체하여 디코더가 모든 action을 동시에 예측할 수 있도록 합니다.

이렇게 하면 D 순차 패스에서 단일 패스로 action 생성이 줄어듭니다, 여기서 D는 action 차원입니다.

병렬 디코딩은 자연스럽게 action 청킹으로 확장됩니다: 여러 미래 시간 단계에 대한 작업을 예측하기 위해 디코더의 입력에 빈 작업 임베딩을 추가로 삽입하기만 하면, 이 임베딩은 미래 작업의 일부에 매핑됩니다.

청크 크기 K의 경우, 모델은 한 번의 전진 패스에서 KD action을 예측하여 지연 효과를 최소화하면서 처리량을 K배 증가시킵니다.

병렬 디코딩은 이론적으로 자기회귀 접근법보다 표현력이 떨어질 수 있지만, 우리의 실험은 다양한 작업에서 성능 저하가 없음을 보여줍니다.

Continuous action representations.

OpenVLA는 원래 각 action 차원이 [-1, +1]로 정규화되고 256개의 bin으로 균일하게 이산화되는 이산 action 토큰을 사용합니다.

이 접근 방식은 기본 VLM에 아키텍처 수정이 필요하지 않기 때문에 편리하지만, 이산화 과정은 세밀한 작업 세부 사항을 희생시킬 수 있습니다.

우리는 눈에 띄는 모방 학습 접근법에서 도출된 두 가지 학습 obejctive를 사용하여 연속적인 action 표현을 연구합니다:

먼저, Zhao et al. [56]과 유사하게, 우리는 디코더의 출력 임베딩 레이어를 MLP action 헤드로 대체하여 최종 디코더 레이어 히든 state를 연속 action 값으로 직접 매핑함으로써 L1 회귀를 구현합니다.

이 모델은 예측된 action과 실제 action 간의 평균 L1 차이를 최소화하도록 학습되어 병렬 디코딩의 효율성 이점을 유지하면서 action 정밀도를 향상시킬 수 있습니다.

둘째, Chi et al. [5]에서 영감을 받아 모델이 순방향 디퓨전 중 action 샘플에 추가되는 노이즈를 예측하는 방법을 학습하는 조건부 디노이징 디퓨전 모델링을 구현합니다.

추론 과정에서 policy는 인버스 디퓨전을 통해 노이즈가 있는 action 샘플을 점진적으로 디노이즈하여 실제 action을 생성합니다.

이 접근 방식은 잠재적으로 더 표현력 있는 action 모델링을 제공할 수 있지만, 추론 중에 여러 번의 전진 패스 (우리 구현에서는 50단계 디퓨전)가 필요하여 병렬 디코딩에서도 배포 지연 시간에 영향을 미칩니다.

Additional model inputs and outputs.

원래 OpenVLA는 단일 카메라 뷰를 처리하지만, 일부 로봇 설정에는 여러 시점과 추가 로봇 상태 정보가 포함됩니다.

유연한 입력 처리 파이프라인을 구현합니다: 카메라 이미지의 경우 OpenVLA의 듀얼 비전 인코더를 사용하여 뷰당 256개의 패치 임베딩을 추출하고, 이를 공유 프로젝터 네트워크를 통해 언어 임베딩 공간에 투영합니다.

저차원 로봇 state 입력 (예: 관절 각도 및 그리퍼 상태)의 경우, 별도의 투영 네트워크를 사용하여 하나의 추가 입력 임베딩과 동일한 임베딩 공간에 매핑합니다.

모든 입력 임베딩—시각적 피쳐, 로봇 state, 언어 토큰—은 디코더로 전달되기 전에 시퀀스 차원을 따라 연결됩니다.

이 통합된 잠재 표현을 통해 모델은 action을 생성할 때 사용 가능한 모든 정보에 attend할 수 있습니다.

병렬 디코딩 및 action 청킹과 결합된 이 아키텍처는 그림 1과 같이 여러 시간 단계의 action을 생성하면서 풍부한 멀티모달 입력을 효율적으로 처리할 수 있습니다.

C. Augmenting OpenVLA-OFT with FiLM for Enhanced Language Grounding.

Challenges with Language following.

손목에 착용하는 카메라를 포함한 여러 관점에서 ALOHA 로봇 설정을 배포할 때, 시각적 입력의 허위 상관관계로 인해 policy가 언어 팔로우에 어려움을 겪을 수 있음을 관찰했습니다.

학습 중에 policy는 action을 예측할 때 언어 지침에 제대로 주의하지 않고 이러한 허위 상관관계를 파악하는 방법을 배울 수 있으며, 이로 인해 테스트 시 사용자의 명령에 대한 순응도가 떨어질 수 있습니다.

또한, 언어 입력은 작업의 특정 순간에만 중요할 수 있습니다—예를 들어, 섹션 Ⅵ에서 논의된 "scoop X into bowl" 과제에서 숟가락을 잡고 어떤 재료를 퍼낼지 결정한 후에.

따라서 특별한 기술 없이는 언어 입력에 적절히 집중하도록 모델을 학습시키는 것이 특히 어려울 수 있습니다.

FiLM.

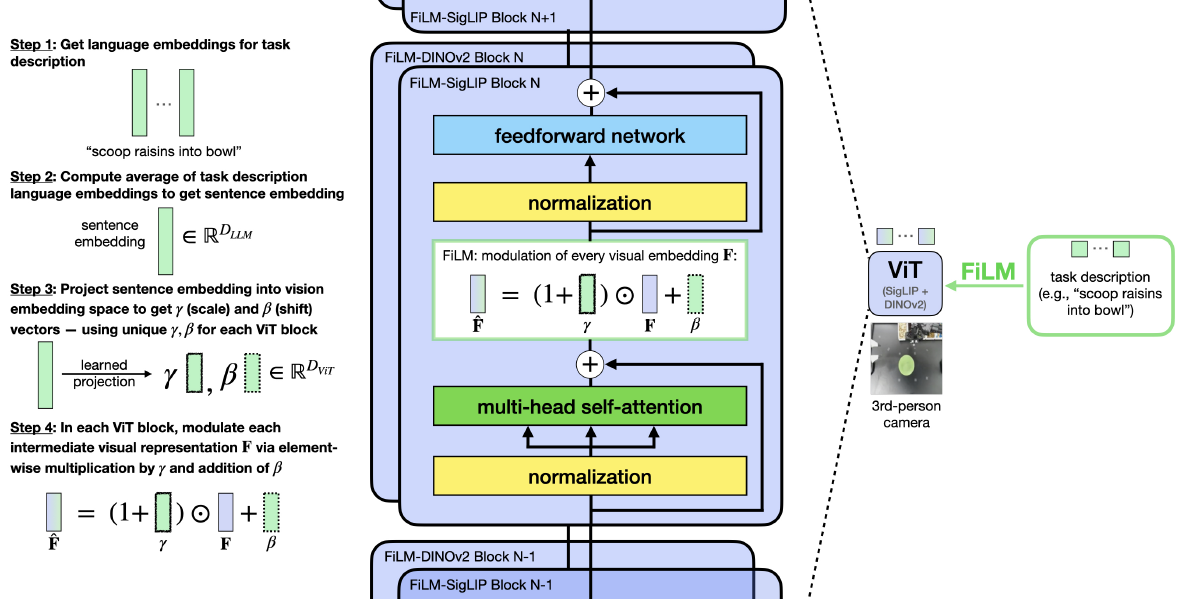

언어 팔로우를 향상시키기 위해, 우리는 모델이 언어 입력에 더 많은 주의를 기울이도록 시각적 표현에 언어 임베딩을 주입하는 feature-wise linear modulation (FiLM)[37]를 사용합니다.

작업 설명에서 언어 임베딩 x의 평균을 계산하고 이를 투영하여 스케일링 및 시프트 벡터 γ와 β를 얻습니다.

이 벡터들은 아핀 변환을 통해 시각적 피쳐 F를 변조합니다: FiLM(F|γ, β) = ˆF = (1 + γ) ⊙ F + β

중요한 구현 세부 사항은 비전 트랜스포머에서 변조를 위한 "feature"를 선택하는 것입니다.

개별 패치 임베딩을 변조해야 할 피쳐로 취급하는 것을 자연스럽게 고려할 수도 있지만, 이러한 접근 방식은 언어 팔로우가 저조하다는 것을 발견했습니다.

대신, 전체 피쳐 맵을 확장하고 이동시켜 공간적으로 무관하게 변조가 적용되는 컨볼루션 네트워크에서 FiLM이 작동하는 방식을 바탕으로, 우리는 모든 시각적 패치 임베딩에 걸쳐 해당 히든 유닛에 γ과 β의 각 요소를 적용하여 γ와 β가 모든 패치 임베딩에 영향을 미치도록 합니다.

구체적으로, 이는 γ 및 β D_ViT 차원 벡터를 만듭니다, 여기서 D_ViT는 히든 차원의 수 (즉, 비전 트랜스포머의 잠재 표현에 있는 각 패치 임베딩의 요소 수)를 의미합니다.

각 비전 트랜스포머 블록에서 셀프 어텐션 레이어 후와 피드포워드 레이어 전에 FiLM을 적용하며, 각 블록마다 별도의 프로젝터를 사용합니다 (그림 8 참조).

추가 구현 세부 사항은 부록 C에 제공됩니다.

우리는 섹션 6에서 논의된 ALOHA 실험에만 FiLM을 사용합니다, 여기서 여러 카메라 시점은 시각적 입력에서 더 큰 허위 상관관계를 초래합니다.

Ⅴ. Experiments: Evaluating VLA Fine-Tuning Design Decisions

이 섹션에서는 세 가지 주요 질문에 답하기 위한 통제된 실험을 통해 제안된 VLA 적응 설계 결정의 효과를 평가합니다:

1) 각 설계 결정이 하위 작업에서 파인튜닝된 policy의 성공률에 어떤 영향을 미치나요?

2) 각 설계 결정이 모델 추론 효율성 (action 생성 처리량 및 지연 시간)에 어떤 영향을 미치나요?

3) 대체 파인튜닝 공식이 모델 입출력 사양의 유연성에 어떤 영향을 미치나요?

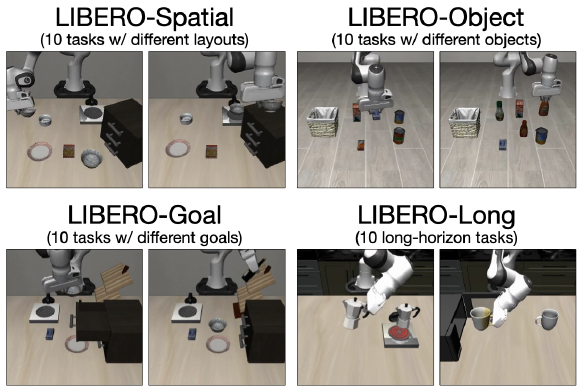

A. LIBERO Experimental Setup

우리는 카메라 이미지, 로봇 state, 작업 주석, 델타 엔드 이펙터 포즈 action을 포함한 시연을 통해 Franka Emika Panda 팔을 시뮬레이션에 적용한 LIBERO 시뮬레이션 벤치마크 [26]에서 평가합니다.

우리는 네 가지 작업 세트—LIBERO-Spatial, LIBERO-Object, LIBERO-Goal, LIBERO-Long—를 사용하여 각각 10개의 작업에 걸쳐 500개의 전문가 시연을 제공하여 다양한 공간 레이아웃, 객체, 목표 및 장기 작업에 대한 policy 일반화를 평가합니다.

Kim et al. [23]에 이어, 실패한 데모를 필터링하고 각 작업 세트에서 LoRA [14]를 통해 OpenVLA를 개별적으로 파인튜닝합니다.

우리는 8개의 A100/H100 GPU에 걸쳐 64-128의 배치 크기를 사용하여 비디퓨전 방법에 대해 50-150K 그래디언트 단계와 디퓨전 방법에 대해 100-250K 단계를 학습합니다 (더 느리게 수렴함).

50K 단계마다 체크포인트를 테스트하고 각 실행에 대해 최고의 성능을 보고합니다, 달리 명시되지 않는 한 policy는 1개의 3인칭 이미지와 언어 지침을 입력으로 받습니다.

action 청킹을 사용하는 방법의 경우, Diffusion Policy 베이스라인 [5]에 맞추기 위해 청크 크기를 K = 8로 설정하고, 계획을 세우기 전에 전체 청크를 실행하여 속도와 성능을 모두 향상시키는 것을 발견했습니다.

하이퍼파라미터에 대한 자세한 내용은 부록 D를 참조하세요.

이 연구의 주요 베이스라인은 원래의 파인튜닝 레시피를 사용하여 파인튜닝된 기본 OpenVLA 모델입니다.

그러나 더 넓은 비교를 위해 Diffusion Policy [5], Octo [49], DiT Policy [13], Seer [50], MDT [40], π_0 [3]과 같은 이전 SOTA 모방 학습 방법의 LIBERO 결과도 포함시켰습니다.

Seer는 추가적인 LIBERO-90 사전 학습 데이터를 사용합니다.

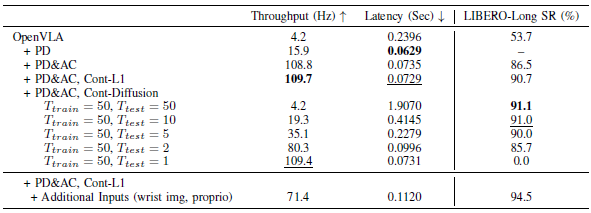

B. LIBERO Task Performance Comparisons

만족스러운 배포를 위해서는 로봇 policy가 신뢰할 수 있는 작업 실행을 입증해야 합니다.

먼저 다양한 VLA 파인튜닝 설계 결정이 LIBERO 벤치마크에서 성공률에 미치는 영향을 평가합니다.

우리의 효율성 분석 (나중에 논의)은 parallel decoding (PD)과 action chunking (AC)이 고주파 제어 (25-50Hz 이상)에 필요하다는 것을 보여줍니다, 특히 action 차원이 두 배인 양방향 로봇의 경우 더욱 그렇습니다.

따라서 우리는 두 가지 기법을 공동으로 사용하여 OpenVLA policy를 평가합니다, 이산 action을 사용하는 변형, L1 회귀를 사용하는 연속 action, 디퓨전을 사용하는 연속 action을 비교합니다.

표 I의 결과에 따르면 병렬 디코딩과 action 청킹은 처리량을 증가시킬 뿐만 아니라 성능도 크게 향상시켜 자기회귀 OpenVLA policy에 비해 평균 성공률을 14% (절대) 높였습니다.

이러한 개선은 특히 LIBERO-Long에서 두드러지며, 이는 action 청킹이 시간적 종속성을 포착하고 복리 오류를 줄이는 데 도움이 되며, 이는 궁극적으로 더 부드럽고 신뢰할 수 있는 작업 실행으로 이어진다는 것을 시사합니다.

또한, 연속적인 action 변형을 사용하면 action 예측의 더 높은 정밀도로 인해 이산 action 변형보다 성공률이 5% (절대) 더 향상된다는 것을 발견했습니다.

L1 회귀 및 디퓨전 변형은 유사한 성능을 달성하여, 고용량 OpenVLA 모델이 간단한 L1 회귀로도 멀티태스크 action 분포를 효과적으로 모델링할 수 있음을 나타냅니다.

C. LIBERO Inference Efficiency Comparisons

효율적인 추론은 고주파 제어 로봇에 VLA를 배치하는 데 매우 중요합니다.

이제 parallel decoding (PD), action chunking (AC) 및 연속 action 표현이 모델 추론 속도에 어떤 영향을 미치는지 평가합니다.

우리는 NVIDIA A100 GPU에서 각 모델 변형을 100번 쿼리하여 평균 지연 시간 (로봇 action 또는 action 청크 하나를 생성하는 데 걸리는 시간)과 처리량 (초당 생성되는 총 action 수)을 측정합니다.

각 쿼리는 224 x 224 px 이미지와 샘플 LIBERO 언어 지침 ("pick up the alphabet soup and place it in the basket")을 처리합니다.

표 II의 결과는 병렬 디코딩이 policy의 디코더 부분을 통과하는 7개의 순차적 순방향 패스를 단일 패스로 대체함으로써 지연 시간을 줄이고 처리량을 4배 증가시킨다는 것을 보여줍니다.

action 청킹 (K = 8)을 추가하면 디코더의 긴 어텐션 시퀀스로 인해 지연 시간이 17% 증가하지만, 병렬 디코딩과 결합하면 처리량이 획기적으로 향상되어 기본 OpenVLA보다 26배 더 빨라집니다.

L1 회귀를 사용하는 연속 action 변형은 base 모델에 비해 추가적인 MLP action 헤드가 최소한의 계산 비용을 추가하기 때문에 효율성 면에서 미미한 차이를 보입니다.

기본 디퓨전 변형은 50개의 디노이징 단계가 필요하며 (이는 학습 시간에 지정된 단계 수이기 때문에), 따라서 높은 지연 시간을 겪습니다.

그러나 병렬 디코딩 및 action 청킹으로 인해 여전히 베이스라인 OpenVLA와 동일한 유효 처리량을 달성합니다.

즉, action 청크 사이에 더 긴 일시 정지가 발생하더라도 50단계 디퓨전 변형은 여전히 원래의 자기회귀 변형과 동일한 속도로 로봇 에피소드를 완성합니다.

우리는 또한 추론 시간에 50단계 미만의 디노이징 단계 (DDIM 샘플러 [46]에 의해 활성화됨)를 사용하여 OpenVLA 디퓨전 변형을 테스트하고, 추론 시간에 5-10단계를 사용하는 SOTA 디퓨전 및 플로우 매칭 방법을 매칭합니다 [40, 27, 3].

이러한 구성은 표 II에 나타난 바와 같이 추론 효율성을 훨씬 높여줍니다.

그러나 모델 품질 저하로 인해 디노이징 단계가 줄어들수록 성공률이 감소합니다.

D. Model Input-Output Flexibility

섹션 IV-B에서 설명하고 이전 섹션의 효율성 평가를 통해 검증한 바와 같이, 병렬 디코딩은 OpenVLA가 최소한의 지연 시간 증가로 action 청크를 생성할 수 있게 하여 모델 출력의 유연성을 향상시킵니다.

병렬 디코딩 및 action 청킹을 통해 실현된 상당한 속도 향상은 추가 모델 입력을 처리할 수 있는 여유 공간을 제공합니다.

우리는 OpenVLA를 로봇 고유 수용 state와 로봇 손목 장착 카메라 이미지와 같은 추가 입력으로 파인튜닝함으로써 이를 입증합니다, 이는 언어 모델 디코더에 전달되는 시각적 패치 임베딩의 수를 256개에서 512개로 두 배로 늘립니다.

입력 시퀀스 길이가 크게 증가했음에도 불구하고, 파인튜닝된 OpenVLA policy는 표 II와 같이 높은 처리량 (71.4Hz)과 낮은 지연 시간 (0.112초)을 유지합니다.

이러한 polict를 LIBERO 벤치마크에 대한 추가 입력으로 평가한 결과, 모든 작업군에서 평균 성공률이 더욱 향상된 것으로 나타났습니다 (표 I).

특히, 저희의 향상된 파인튜닝 OpenVLA policy는 최고의 파인튜닝 π_0 policy [3, 38] — 더 큰 규모의 사전 학습과 더 정교한 학습 objective (플로우 매칭 [25])를 갖춘 base 모델의 이점을 제공합니다 —와 Multimodal Diffusion Transformer (MDT) [40] 및 Seer [50] policy를 능가합니다.

최신 VLA보다 적은 데이터로 사전 학습된 더 간단한 base 모델을 사용하더라도, 우리의 대안적인 VLA 적응 설계 결정이 파인튜닝된 OpenVLA policy가 LIBERO 벤치마크에서 새로운 SOTA 기술을 확립할 수 있도록 지원한다는 것을 발견했습니다.

E. Optimized Fine-Tuning Recipe

작업 성능, 추론 효율성 및 모델 입력-출력 유연성의 입증된 향상을 바탕으로, 우리는 세 가지 주요 구성 요소를 결합한 VLA 적응을 위한 Optimized Fine-Tuning (OFT) 레시피를 제안합니다:

1) action 청킹을 사용한 병렬 디코딩

2) 연속 action 표현

3) L1 회귀 objective

이러한 설계 선택은 알고리즘의 단순성을 유지하면서 고주파수에 배포할 수 있는 강력한 policy를 생성하기 위해 함께 작동합니다.

우리는 OFT 레시피를 사용하여 OpenVLA base 모델에서 파인튜닝된 policy를 OpenVLA-OFT로 나타냅니다.

섹션 6에서는 고주파 제어 로봇을 사용하여 실제 세계에서 손재주가 있는 이중 수동 조작 작업에 대한 OpenVLA-OFT의 기능을 평가합니다.

F. Additional Experiments

대체 파인튜닝 공식이 추가 모델 입력 및 출력과 함께 기본 VLA의 사전 학습과 파인튜닝 간의 분포 변화를 유도한다는 점을 고려할 때, 한 가지 합리적인 질문은 기본 VLA의 사전 학습된 표현이 도움이 되고 우리가 보고한 결과에 어떤 영향을 미치는지 여부입니다.

이 문제를 해결하기 위해 부록 G2에서 ablation 연구를 수행하여 OpenVLA 사전 학습 단계를 ablating하고 OFT 레시피로 기본 사전 학습된 VLM을 직접 파인튜닝합니다.

표 XV에서 볼 수 있듯이, 기본 OpenVLA 사전 학습된 표현은 로봇 policy 학습에 여전히 유익합니다, 이를 제거하면 LIBERO 평가 모음에서 평균 성공률 (절대)이 5.2% 감소하기 때문입니다.

(OpenVLA-OFT를 더 큰 데이터셋으로 확장하는 등 다른 추가 실험은 부록 G를 참조하십시오—LIBERO 시뮬레이션 설정과 BridgeData V2 데이터셋에서 5만 건 이상의 시연이 있는 실제 단일 팔 로봇 조작 설정 모두에서 [52])

Ⅵ. Experiments: Adapting OpenVLA to a Real-World ALOHA Robot

이전 섹션의 실험 결과는 시뮬레이션에서 OpenVLA-OFT의 효과를 입증하지만, 사전 학습에서 볼 수 있는 것과는 상당히 다른 로봇 플랫폼에서 실제 환경에 성공적으로 배포하는 것은 광범위한 적용 가능성을 보여주는 데 매우 중요합니다.

따라서 우리는 높은 제어 주파수에서 작동하는 실제 이중 수동 조작 플랫폼인 ALOHA 로봇 설정 [56]에서 최적화된 파인튜닝 레시피의 효능을 평가합니다.

우리는 OpenVLA의 사전 학습 (싱글암 로봇 데이터만 포함) 중에 이전에 경험한 적이 없는 새로운 손재주 있는 조작 작업을 평가합니다.

이전 연구들 [54, 27, 3]은 자기회귀 VLA를 사용한 vanilla LoRA 파인튜닝 [23]이 실시간 배포에 필요한 25-50Hz보다 훨씬 낮은 처리량 (싱글암 로봇의 경우 3-5Hz, 이중 수동 작업의 경우 더 낮음)을 보여주었습니다.

따라서 우리는 이 베이스라인을 실험에서 제외하고, 간단히 논의하는 더 효과적인 방법들을 비교합니다.

이 섹션에서는 IV-C 섹션에 설명된 바와 같이 향상된 언어 기반을 위해 featurewise linear modulation (FiLM)를 추가로 포함하는 VLA 파인튜닝 레시피 (OFT+)의 증강 버전을 사용합니다.

이 증강된 파인튜닝 레시피를 통해 인스턴스화된 OpenVLA policy를 OpenVLA-OFT+라고 부릅니다.

A. ALOHA Experimental Setup

ALOHA 플랫폼은 두 개의 ViperX 300 S 암, 세 개의 카메라 뷰포인트 (탑다운, 손목 장착 두 개), 로봇 state 입력 (14차원 관절 각도)으로 구성되어 있습니다.

25Hz에서 작동하며 (원래 50Hz에서 줄여 더 빠른 학습을 가능하게 하면서도 부드러운 로봇 제어를 유지합니다), action은 타겟 절대 관절 각도를 나타냅니다.

이 설정은 싱글 암 로봇 데이터, 3인칭 카메라의 단일 카메라 시점, 로봇 state 입력 없음, 저주파 제어 (3-10Hz), 상대적 엔드 이펙터 포즈 action을 포함하는 OpenVLA의 사전 학습과 크게 다릅니다.

분포 변화는 이 모델의 적응에 도전 과제를 제기합니다.

변형 가능한 객체 조작, 장기적인 기술, 도구 사용, 언어 기반 제어를 테스트하는 네 가지 대표적인 작업을 설계합니다:

1) "fold shorts": 테이블 위에 흰색 반바지를 두 번 연속으로 접습니다.

학습: 20개의 시연.

평가: 10번의 시도.

2) "fold shirt": 흰색 티셔츠를 여러 번 동기화된 이중 수동 접힘을 통해 접으면 접촉이 풍부하고 긴 수평 조작을 테스트할 수 있습니다.

학습: 30개의 시연.

평가: 10번의 시도.

3) “scoop X into bowl”: 금속 숟가락을 사용하여 왼팔로 그릇을 테이블 중앙으로 옮기고, 오른팔로 지정된 재료 (“raisins,” “almonds and green M&M" 또는 "pretzels")를 떠서 넣습니다.

학습: 45개의 시연 (재료당 15개).

평가: 12번의 시도 (재료당 4번).

4) "put X into pot": 왼팔로 냄비를 열고, 오른팔로 지정된 품목 (“green pepper,” “red pepper,” 또는 "yellow corn")을 넣고 닫습니다.

학습: 300개의 시연 (객체당 100개).

평가: 24건의 시도 (12 in-distribution, 12 out-of-distribution).

우리는 action 청크 크기 K = 25인 50-150K 그래디언트 단계 (총 배치 크기 32, 8개의 A100/H100-80GB GPU)에 대해 각 작업에서 독립적으로 OFT+를 사용하여 OpenVLA를 파인튜닝합니다.

추론 시점에 우리는 다음 청크에 대한 모델을 요청하기 전에 전체 action 청크를 실행합니다.

B. Methods in Comparison

ALOHA 작업은 제어 빈도, action 공간 및 입력 양식 측면에서 사전 학습 플랫폼과의 상당한 차이를 고려할 때 OpenVLA를 base 모델로 하는 데 있어 상당한 적응 과제를 제시합니다.

이러한 이유로, 우리는 OpenVLA-OFT+를 이중 수동 조작 데이터로 사전 학습된 최신 VLA—RDT-1B [27] 및 π_0 [3]—와 비교하며, 이러한 다운스트림 작업에서 더 나은 성능을 기대할 수 있습니다.

우리는 저자들이 추천한 레시피를 사용하여 이 모델들을 파인튜닝한 후 평가하며, 이러한 방법들은 중요한 비교 지점이 됩니다.

또한, 계산 효율적인 대안과의 비교를 위해 두 가지 인기 있는 모방 학습 베이스라인을 평가합니다:

ACT [56] 및 Diffusion Policy [5]은 각 작업에 대해 처음부터 학습되었습니다.

이러한 기본 방법에서 언어 팔로우를 활성화하기 위해 우리는 언어 조건 구현을 사용합니다.

ACT의 경우, EfficientNet-B0 [48]을 수정하여 FiLM [37, 43]을 통해 CLIP [39] 언어 임베딩을 처리합니다.

Diffusion Policy에서는 DistilBERT [42] 언어 임베딩에 대한 action 디노이징을 조건으로 하는 DROID 데이터셋 [22] 구현을 사용하며, 이는 이중 수동 제어와 여러 이미지 입력을 지원하도록 수정되었습니다.

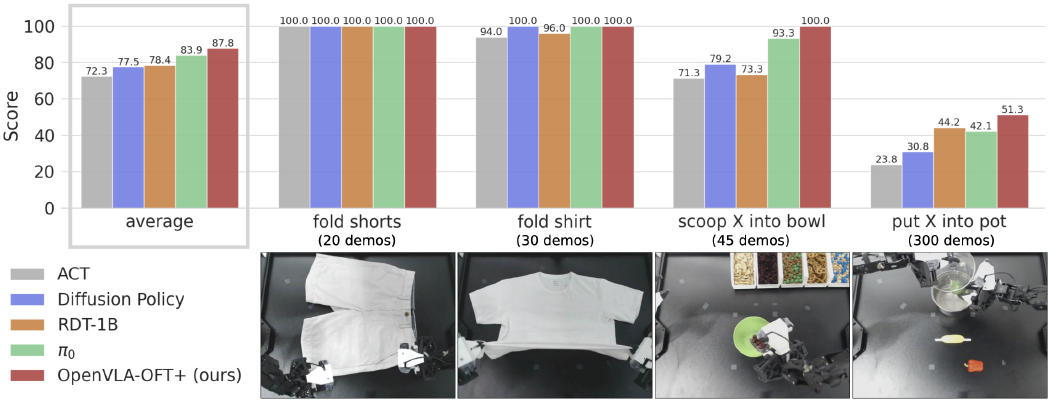

C. ALOHA Task Performance Results

우리는 네 가지 ALOHA 작업에 대해 모든 방법—ACT, Diffusion Policy, RDT-1B, π_0, OpenVLA-OFT+—을 평가합니다.

세밀한 평가를 제공하기 위해 부분 과제 완료 점수를 할당하는 미리 정해진 루브릭을 사용합니다 (자세한 내용은 부록 F 참조).

그림 4는 총 성과 점수를 보여주며, 그림 5는 언어 의존 과제에 대한 언어 추종 능력을 구체적으로 추적합니다.

Performance of non-VLA baselines.

처음부터 학습된 베이스라인 방법들은 다양한 수준의 성공을 보여줍니다.

ACT는 기본 작업을 완료할 수 있지만 정확도가 낮고 전체 성능이 가장 낮습니다.

Diffusion Policy는 옷 접기 및 스쿱 작업에서 RDT-1B의 신뢰성과 일치하거나 그 이상의 강력한 기능을 보여줍니다.

그러나 더 큰 학습 데이터셋을 가진 "put X into pot" 작업에서는 어려움을 겪고 있으며, 이는 VLA 기반 접근 방식에 비해 확장성이 제한적임을 시사합니다.

Performance of fine-tuned VLAs.

파인튜닝된 VLA policy는 일반적으로 작업 실행과 언어 팔로우 모두에서 처음부터 시작하는 베이스라인을 능가하며, 이는 이전 연구 결과와 일치합니다 [27, 3].

VLA 중에서 우리는 뚜렷한 특징을 관찰합니다:

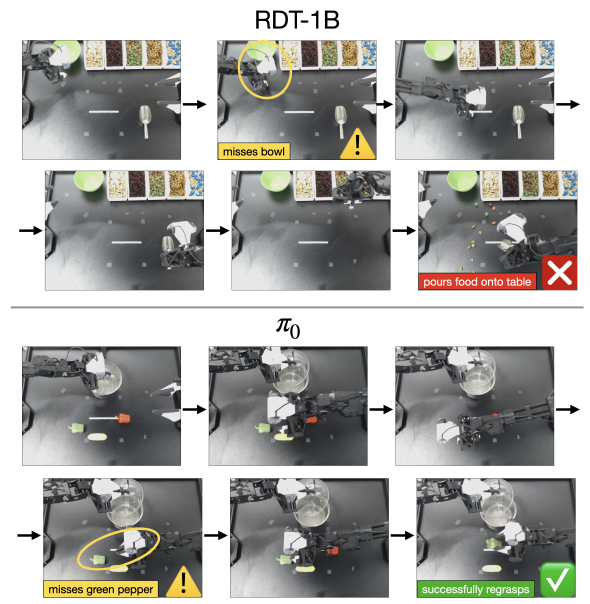

RDT-1B는 "Alternating Condition Injection" 방식 [27]을 통해 좋은 언어 추종을 달성하지만, 폐쇄 루프 피드백을 처리하는 데 한계가 있습니다.

그림 6에서 시각화된 바와 같이, "scoop X into bowl" 작업에서 실수를 수정하는 데 실패하는 경우가 많습니다—예를 들어, 실제 그릇을 놓친 후에도 재료를 계속해서 상상의 그릇에 붓는 것은 시각적 피드백보다 고유 수용 상태에 지나치게 의존한다는 것을 의미합니다.

반면, π_0는 더 부드러운 동작과 피드백에 대한 반응성이 향상되어 더 강력한 실행을 보여주며, 종종 초기 실패에서 성공적으로 회복됩니다 (그림 6 참조).

π_0는 RDT-1B보다 약간 뒤처지지만, 전반적인 작업 완료율이 더 높아 가장 강력한 베이스라인이 됩니다.

마지막으로 OpenVLA-OFT+는 작업 실행과 언어 팔로우 모두에서 최고 성능을 달성했습니다 (성공적인 작업 롤아웃의 예는 그림 7을 참조하세요).

이는 base OpenVLA 모델이 싱글 암 데이터만을 대상으로 사전 학습된 반면, RDT-1B와 π_0은 각각 6K 에피소드와 8K 시간의 이중 수동 데이터셋을 대상으로 사전 학습되었다는 점에서 특히 주목할 만합니다.

이는 다운스트림 성능을 위해 데이터 커버리지를 사전 학습하는 것보다 파인튜닝 기술이 더 중요할 수 있음을 시사합니다.

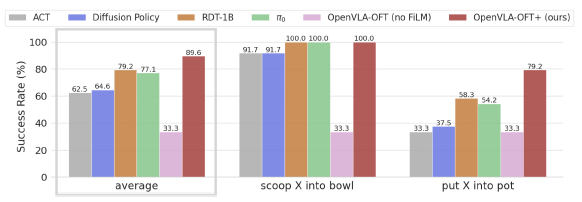

Ablation study of FiLM.

우리는 성공적인 실행을 위해 좋은 언어 기반이 필요한 마지막 두 가지 작업에 대해 policy의 언어 추종 능력을 평가함으로써 OpenVLA-OFT+ 접근 방식에서 FiLM의 중요성을 평가합니다.

그림 5에서 볼 수 있듯이, 두 작업 모두에서 언어 팔로우가 33%로 떨어집니다—정확한 지침을 랜덤으로 선택하는 equal.

이는 모델이 허위 시각적 피쳐에 과적합되는 것을 방지하고 언어 입력에 적절히 attend하는 데 FiLM이 필수적임을 보여줍니다.

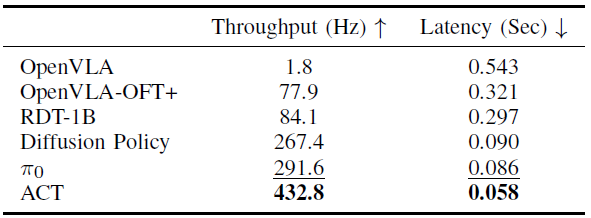

D. ALOHA Inference Efficiency Comparisons

우리는 각 방법에 대해 100개의 쿼리에서 action 생성 처리량과 지연 시간을 측정하여 추론 효율성을 평가합니다.

우리는 결과를 표 III에 보고합니다.

원래의 OpenVLA 포뮬러는 추가적인 손목 카메라 입력만으로도 1.8Hz 처리량과 0.543초 지연으로 효율성이 떨어집니다.

반면에 OpenVLA-OFT+는 77.9Hz 처리량을 달성하지만, 두 개의 추가 입력 이미지를 처리해야 하기 때문에 이전 LIBERO 실험의 policy에 비해 지연 시간이 더 높습니다.

다른 방법들은 아키텍처가 작기 때문에 OpenVLA-OFT+보다 더 높은 처리량을 보여줍니다: ACT (84M 매개변수), Diffusion Policy (157M), RDT-1B (12B), π_0 (33B) — OpenVLA는 75억 개의 매개변수를 가지고 있습니다.

ACT는 L1 회귀 기반 단일 패스 action 생성 (예: OpenVLA-OFT+)과 컴팩트 아키텍처를 결합하여 최고 속도를 달성합니다.

또한, π_0는 더 큰 크기에도 불구하고 최적화된 JAX 구현 덕분에 속도 면에서 RDT-1B와 Diffusion Policy를 모두 능가합니다 (다른 모든 방법은 PyTorch로 구현됨).

Ⅶ. Discission

VLA 파인튜닝 설계 결정에 대한 우리의 연구는 다양한 구성 요소가 추론 효율성, 작업 성능, 모델 입력-출력 유연성 및 언어 추종 능력에 어떻게 영향을 미치는지를 보여줍니다.

이러한 인사이트는 병렬 디코딩, action 청킹, 연속 action, L1 회귀 및 (선택적으로) FiLM 언어 조건화를 통해 새로운 로봇과 작업에 효과적으로 VLA 적응을 가능하게 하는 Optimized Fine-Tuning (OFT) 레시피로 이어집니다.

OFT의 성공은 OpenVLA에서 특히 주목할 만합니다: 사전 학습 중에 이중 수동 로봇이나 멀티뷰 이미지 입력에 노출되지 않았음에도 불구하고, OFT로 파인튜닝된 OpenVLA는 이러한 구성에 적응할 수 있으며, 사전 학습 중에 이중 수동 조작기와 다중 입력 이미지를 접한 최신 디퓨전 기반 VLA (π_0 및 RDT-1B)와 일치하거나 심지어 더 뛰어난 성능을 발휘할 수 있습니다.

이는 잘 설계된 파인튜닝 레시피가 최종 성능에 상당한 영향을 미칠 수 있으며, 기존 VLA를 새로운 로봇 시스템에 성공적으로 적응시킬 수 있음을 보여줍니다.

또한, 우리의 결과는 OpenVLA와 같은 고용량 모델을 사용한 간단한 L1 회귀 기반 접근 방식이 새로운 로봇과 작업에 적응하는 데 매우 효과적임을 보여줍니다.

이 접근 방식은 디퓨전 기반 방법에 비해 실질적인 이점을 제공합니다: 더 간단한 알고리즘은 강력한 성능을 유지하면서도 더 빠른 학습 수렴과 추론 속도를 제공하여 실제 로봇 응용 분야에 특히 적합합니다.

Ⅷ. Limitations

우리의 Optimized Fine-Tuning (OFT) 레시피는 VLA를 새로운 로봇과 작업에 적용할 수 있는 가능성을 보여주지만, 몇 가지 중요한 질문이 남아 있습니다.

Handling multimodal demonstrations.

우리의 실험은 작업별로 일관된 전략을 가진 집중 시연 데이터셋을 사용합니다.

L1 회귀는 policy가 시연된 action에서 중앙값 모드를 학습하도록 장려하여 학습 시연에서 노이즈를 완화하는 데 도움이 될 수 있지만, 동일한 입력에 대해 여러 유효한 action이 존재하는 진정한 멀티모달 action 분포를 정확하게 모델링하는 데 어려움을 겪을 수 있습니다, 이는 대체 action 시퀀스를 생성하는 능력이 작업 완료에 도움이 되는 경우 이상적이지 않을 수 있습니다.

반대로, 디퓨전 기반 접근 방식은 이러한 멀티 모달리티를 더 잘 포착할 수 있지만 학습 데이터에서 최적이 아닌 모드에 과적합될 위험이 있습니다 (이러한 뉘앙스에 대한 토론 및 비디오 예시는 웹사이트를 참조하세요).

멀티모달 시연을 통한 OFT의 효과를 이해하는 것은 향후 연구에서 여전히 중요한 방향입니다.

Pretraining versus fine-tuning.

우리 연구는 특히 다운스트림 작업을 위한 VLA 파인튜닝에 중점을 둡니다.

OFT의 이점이 사전 학습에 효과적으로 적용되는지, 아니면 디퓨전과 같은 더 표현력 있는 알고리즘이 대규모 학습에 필요한지는 추가 조사가 필요합니다.

Inconsistent language grounding.

우리의 ALOHA 실험 결과, LIBERO 시뮬레이션 벤치마크 실험에서 이러한 문제가 없음에도 불구하고 FiLM이 없는 OpenVLA는 언어 기반이 열악한 것으로 나타났습니다.

이러한 불일치의 원인 (사전 학습에서 이중 매뉴얼 데이터의 부족 또는 기타 요인으로 인한 것인지)은 여전히 불분명하며 추가 연구가 필요합니다.