2025. 7. 24. 11:13ㆍRobotics

Robot Utility Models: General Policies for Zero-Shot Deployment in New Environments

Haritheja Etukuru, Norihito Naka, Zijin Hu, Seungjae Lee, Julian Mehu, Aaron Edsinger, Chris Paxton, Soumith Chintala, Lerrel Pinto, Nur Muhammad “Mahi” Shafiullah

로봇 모델, 특히 대량의 데이터로 학습된 모델들은 최근에 다양한 실제 조작 및 내비게이션 기능을 보여주고 있습니다.

여러 독립적인 노력에 따르면, 환경에서 충분한 학습 데이터가 주어지면 로봇 policy가 그 환경에서 입증된 변화로 일반화될 수 있습니다.

그러나 로봇 모델을 모든 새로운 환경에 맞게 파인튜닝해야 한다는 점은 오픈 월드 문제에 대해 제로샷으로 배포할 수 있는 언어나 비전 모델과는 극명한 대조를 이룹니다.

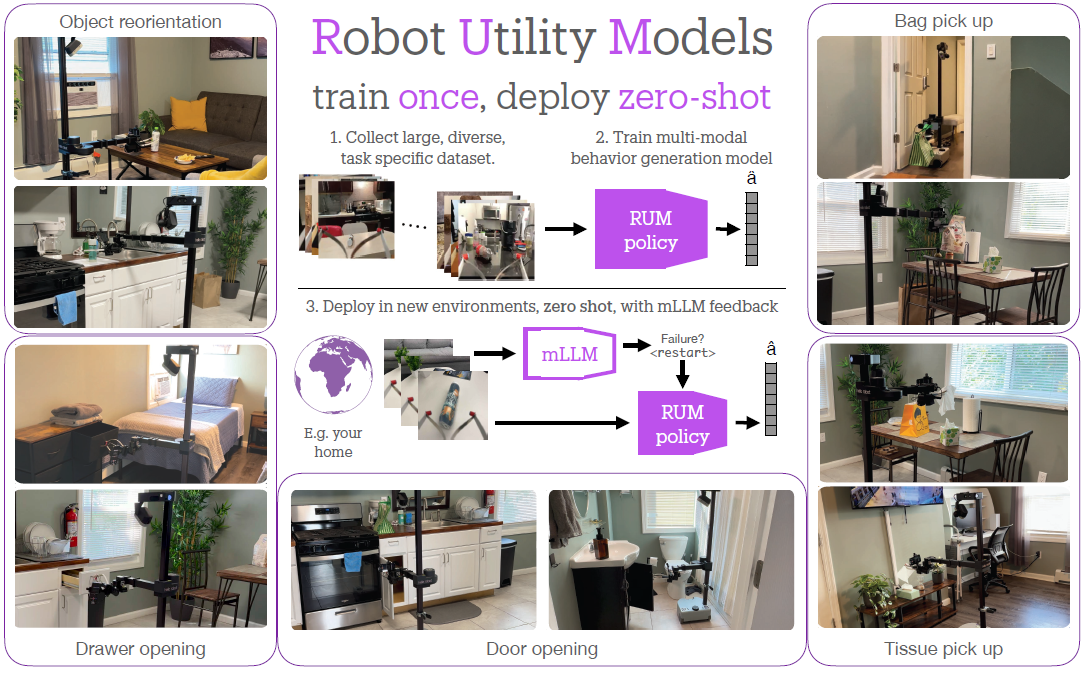

이 연구에서는 파인튜닝 없이 새로운 환경에 직접 일반화할 수 있는 제로샷 로봇 policy를 학습하고 배포하기 위한 프레임워크인 Robot Utility Models (RUM)을 소개합니다.

RUM을 효율적으로 생성하기 위해, 우리는 모바일 조작 작업을 위한 데이터를 신속하게 수집하고, 이러한 데이터를 멀티모달 모방 학습이 포함된 policy에 통합하며, 저렴한 상품 로봇인 Hello Robot Stretch에 외부 mLLM 검증기를 사용하여 재시도할 수 있는 policy를 기기 내에 배포하는 새로운 도구를 개발했습니다.

우리는 opening cabinet doors, opening drawers, picking up napkins, picking up paper bags, 및 reorienting fallen objects 다섯 가지 실용적인 모델을 학습시킵니다.

우리 시스템은 보이지 않는 새로운 환경에서 보이지 않는 물체와 상호작용할 때 평균적으로 90%의 성공률을 달성합니다.

또한 유틸리티 모델은 추가 데이터, 학습 또는 파인튜닝 없이도 다양한 로봇 및 카메라 설정에서 성공할 수 있습니다.

우리의 주요 교훈 중 하나는 학습 알고리즘과 policy 수업보다 학습 데이터의 중요성, 데이터 확장에 대한 가이던스, 다양하면서도 고품질의 시연의 필요성, 그리고 개별 환경에서 성능을 향상시키기 위한 로봇 성찰 및 재시도의 레시피입니다.

1. Introduction

최근 원격 조작 로봇 (Mandlekar et al., 2018; Arunachalam et al., 2023b; Cheng et al., 2024; Iyer et al., 2024; Khazatsky et al., 2024)이 수집한 데이터에 딥 네트워크를 맞춤으로써 학습 조작 기술이 빠르게 발전하고 있습니다 (Brohan et al., 2023; Zhao et al., 2023b; Fu et al., 2024a,b; Haldar et al., 2024; Kim et al., 2024; Lin et al., 2024).

이러한 기술을 새로운 환경에 배포하는 메커니즘은 2014년경 비전 커뮤니티 (Girshick et al., 2014)에서 처음 개발한 사전 학습 후 파인튜닝 전략을 모방합니다.

그곳에서 모델들은 먼저 ImageNet에서 사전 학습된 후, 탐지, 세그멘테이션, 포즈 추정과 같은 작업별 데이터에 대해 파인튜닝되었습니다 (Girshick et al., 2014; Gkioxari et al., 2014).

로봇 공학의 맥락에서 이 전략은 대규모 로봇 데이터셋 (Padalkar et al., 2023; Shafiullah et al., 2023; Walke et al., 2023; Khazatsky et al., 2024)에 대한 사전 학습을 통해 로봇 파운데이션 모델을 생성한 다음, 새로운 환경이나 작업에서 수집된 데이터를 파인튜닝하는 것을 포함합니다 (Shafiullah et al., 2023; Kim et al., 2024; Team et al., 2024).

로봇이 수행할 것으로 예상되는 바로 그 환경에서 인간이 데이터를 수집해야 하기 때문에 새로운 환경마다 파운데이션 모델을 파인튜닝해야 하는 것은 한계가 있습니다.

따라서 비전 및 언어 모델은 환경별 파인튜닝 데이터 없이 제로샷 배포로 전환되었지만, 이러한 기능은 대부분의 로봇 조작기를 피할 수 있습니다.

제로샷 조작 모델을 만들려고 시도한 적이 없다는 뜻은 아닙니다 – grasping 및 pick-and-place (Mahler et al., 2017; Sundermeyer et al., 2021; Fang et al., 2023b)의 여러 파운데이션 작업은 과제별 해결책을 통해 이 문제를 해결해 왔습니다.

그렇다면 제로샷으로 작동할 수 있는 임의의 작업에 대한 일반 policy를 만드는 이유는 무엇일까요?

첫 번째는 충분한 데이터에 대한 우려입니다 – 이러한 일반 모델을 학습하는 데 필요한 데이터의 양은 많을 수 있습니다.

로봇 데이터를 수집하는 것은 어렵기 때문에, 대규모 데이터셋을 만드는 것도 어렵고 종종 비용이 많이 듭니다, 왜냐하면 인간은 보통 로봇 시연을 수집해야 하기 때문입니다.

둘째, 오픈 월드에서 대규모 데이터셋을 수집할 때는 반드시 다양성이 크고 시연자 행동에 멀티 모드가 필요합니다.

이 다양한 데이터에 로봇 모델을 맞추는 것은 어려운 일입니다.

셋째, 이미지와 텍스트라는 네이티브 데이터 형태가 대부분 표준인 비전과 언어와 달리 로봇 공학은 표준 카메라와 하드웨어 설정은 물론 온보드 컴퓨팅에서 실시간으로 모델을 실행해야 하는 물리적 문제와도 거리가 멉니다.

학습과 배포 사이의 하드웨어 설정을 약간만 변경해도 실행할 수 있는 제로샷 모델을 만들려면 세부 사항에 세심한 주의가 필요합니다.

마지막으로, 새로운 환경에 제로 샷을 배치한 모델은 해당 환경에서 파인튜닝된 모델보다 자연스럽게 더 높은 고장률을 보입니다.

따라서 모델 제로샷을 배포하려면 오류 감지 및 복구 메커니즘을 갖추는 것이 중요합니다.

이 연구에서는 새로운 환경에서 추가 학습이나 파인튜닝 없이 제로샷으로 배포할 수 있는 유용한 작업을 완료하기 위해 초점 및 기능적 유틸리티 모델을 학습하는 새로운 프레임워크인 Robot Utility Models (RUM)을 소개합니다.

이는 시스템 우선 접근 방식을 취함으로써 이루어집니다.

데이터 품질을 저하시키지 않으면서 데이터셋을 확장하기 위해, 우리는 비테더링 데이터 수집에 대한 이전 연구를 바탕으로 새로운 도구를 개발했습니다 (Shafiullah et al., 2023; Chi et al., 2024).

우리는 이러한 다양한 데이터셋에서 SOTA 멀티모달 행동 학습 알고리즘 (Chi et al., 2023; Lee et al., 2024)을 사용하여 policy를 학습하고, 대규모 데모 데이터를 어떻게 흡수하고 확장할 수 있는지 보여줍니다.

마지막으로, 우리는 mLLM을 통한 자기 비판 (Guo et al., 2023)과 재시도를 통해 다양한 환경에 policy를 배포하여 저렴하고 범용적인 하드웨어에서 policy를 견고하게 실행할 수 있는 방법을 보여줍니다.

학습된 모델 중 일부는 큰 수정 없이 Hello Robot Stretch에서 이용할 수 있습니다.

디폴트 Stretch 배포 외에도 다른 로봇 암, 카메라, 조명 조건에서도 배포가 가능하여 접근 방식의 일반화 가능성을 보여줍니다.

RUM을 생성하고 배포하면서 몇 가지 흥미로운 교훈을 얻었습니다.

먼저, 우리는 데이터의 양과 질이 유틸리티 모델을 학습하는 데 매우 중요하며, 모델 아키텍처의 선택이 덜 중요하다는 것을 발견했습니다.

둘째, 수집된 데이터의 다양성은 모델이 새로운 환경으로 일반화하는 데 매우 중요하며, raw 데이터 양보다 더 중요하다는 것을 알 수 있습니다.

셋째, 독립적인 모델로 모델 성능에 대한 자기 비판을 수행하고 적절한 경우 재시도함으로써 단일 환경에서 모델을 더 유능하게 만들 수 있음을 발견했습니다.

RUM을 검증하기 위해 New York City (NY), Jersey City (NJ), Pittsburgh (PA)의 가정을 포함한 실제 환경에서 총 2,950개의 로봇 롤아웃을 실행했습니다.

이러한 실험을 통해 다음과 같은 사실이 밝혀졌습니다:

• 우리는 1,000개의 시연 순서대로 적당한 양의 데이터로 일반 로봇 유틸리티 모델을 생성할 수 있음을 보여줍니다 (섹션 2).

이러한 RUM은 25개의 새로운 환경에서 제로샷 배포에서 평균 90%의 성공률을 달성합니다 (섹션 3.1).

• RUM의 성공은 주로 두 가지 주요 기술에 의존합니다.

첫째, 멀티모달 policy의 사용 (섹션 2.3)은 74.4%의 제로샷 성공률을 제공합니다 (섹션 3.2).

둘째, mLLM 기반의 자기 비판 및 재시도 시스템 (섹션 2.4)은 성공률을 15.6% 향상시킵니다 (섹션 3.6).

• RUM의 전반적인 프레임워크는 간단하지만, 데이터 다양성 vs. 데이터 양 (섹션 3.4 및 3.5)과 같이 예상치 못한 출처에서 이익을 얻는 경우가 많습니다.

2. Robot Utility Models

로봇 유틸리티 모델을 만들기 위해 풀스택 접근 방식을 취합니다.

우리 시스템의 핵심은 모방 학습 프레임워크를 따릅니다.

그러나 학습된 policy를 제로샷으로 배포할 수 있을 정도로 모방 학습을 효과적으로 확장하기 위해 데이터 수집, 모델 학습, 추론 및 배포를 개선하기 위한 새로운 도구와 기법을 개발했습니다.

2.1. Data collection tool

우리 시스템의 주요 요구 사항 중 하나는 다양하면서도 정확한 시연 데이터를 저렴하게 확장할 수 있는 것입니다.

이를 위해 우리는 손에 들고 휴대할 수 있는 휴대용 데이터 수집 도구 (Song et al., 2020; Young et al., 2020; Pari et al., 2021; Shafiullah et al., 2023; Chi et al., 2024)의 진화 경로를 따라가며 정확한 시연을 빠르게 수집할 수 있습니다.

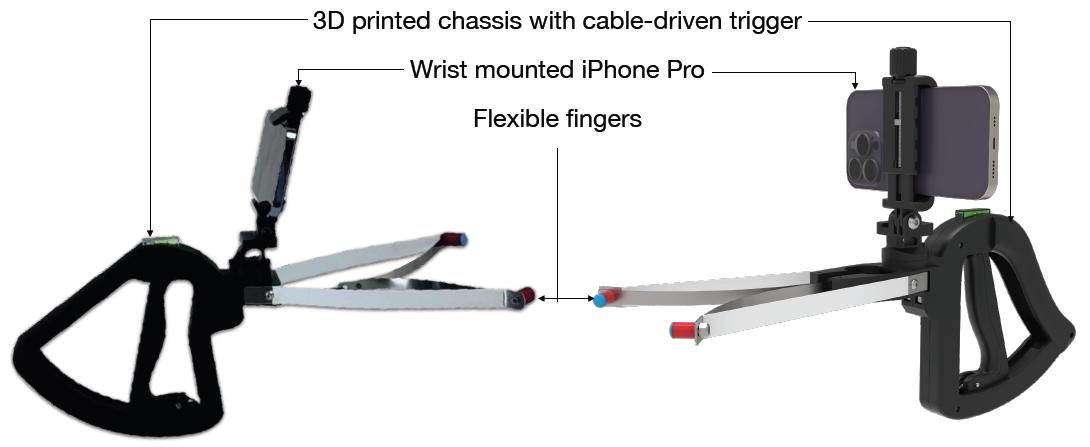

이전 연구 (Shafiullah et al., 2023)에 이어, 우리는 이 도구를 Stick-v2라고 부릅니다, 이는 iPhone Pro와 총 25달러의 자료 청구서로 구성된 휴대용 데이터 수집 도구입니다.

Stick-v1의 빠른 배포성에서 영감을 얻은 것과 UMI 그리퍼의 작고 휴대하기 쉬운 폼 팩터를 결합했습니다.

자세한 제작 지침과 자료 청구서에 대해서는 독자에게 보충 자료를 참조해 주시기 바랍니다 (Appendix A.5).

우리의 디자인 결정은 몇 가지 요인에 기반을 두고 있습니다: 휴대성, 편리함, 그리고 설정 속도.

우리는 이러한 요소들이 로봇 데이터셋과 학습 RUM을 신속하게 확장하는 데 중요하다는 것을 실험적으로 발견했습니다.

섹션 3.3의 실험에서 볼 수 있듯이, RUM의 데이터 수집에서 가장 중요한 측면 중 하나는 데이터 다양성, 즉 다양한 환경에서 데이터를 수집하는 것입니다.

따라서 새로운 환경에서 대량 인쇄, 휴대 및 배포가 용이한 휴대용 도구를 갖추는 것이 중요합니다.

둘째, 수집된 데이터가 다양한 환경에서 정확하게 사용되는 것이 중요합니다.

마지막으로, 데이터 수집 시스템 설정, 카메라 보정 또는 도구의 SLAM 시스템에 사용되는 "per-environment set-up time"을 최소화하는 것이 중요합니다.

위의 이유로, 우리는 널리 사용되고 사용되는 iPhone Pro (그림 2)에서 ARKit API를 중심으로 데이터 수집 도구인 Stick-v2를 설계했습니다.

기술적 기능을 고려할 때 Stick-v2의 유일한 디지털 구성 요소는 iPhone으로, 특히 배송 및 취급에 견고합니다.

iPhone, 따라서 Stick-v2는 최대 60Hz에서 RGB 비디오 및 depth가 데이터를 수집할 수 있으며, ARKit API로부터 최대 100Hz에서 고정밀 6D 포즈 및 위치 정보를 수집할 수 있습니다.

그리퍼 개구부 정보를 캡처하기 위해 이미지에서 그리퍼 개구부를 예측하는 RGB 기반 모델을 학습시켰습니다.

또한, 이 데이터는 보정 없이 iPhone에 의해 자동으로 동기화되고 타임스탬프가 부여됩니다.

이를 통해 설정 시간 없이 다양한 환경에서 데이터를 수집할 수 있습니다.

이는 시각적 SLAM 시스템을 기반으로 한 다른 데이터 수집 도구들과는 대조적입니다.

시각적 SLAM 시스템은 정밀도가 제한적이며, 평평한 벽, 천장, 모서리와 같은 "textureless" 장면 주변에서 견고하지 않습니다 (Young et al., 2020; Chi et al., 2024).

마지막으로, 카메라 보정이 필요 없기 때문에 우리 시스템은 어떤 환경에서도 즉시 배포할 수 있으며, 특히 환경이 통제되지 않는 현실 세계에서도 더욱 그렇습니다.

이를 통해 소매 가정용품 매장에서 데이터를 수집하여 데이터셋을 최소한의 중단으로 풍부하게 만들 수 있으며, 각 새로운 환경에 맞게 카메라 및 주행 거리 측정 시스템을 보정해야 하는 경우 방해를 받을 수 있습니다.

2.2. Collected datasets

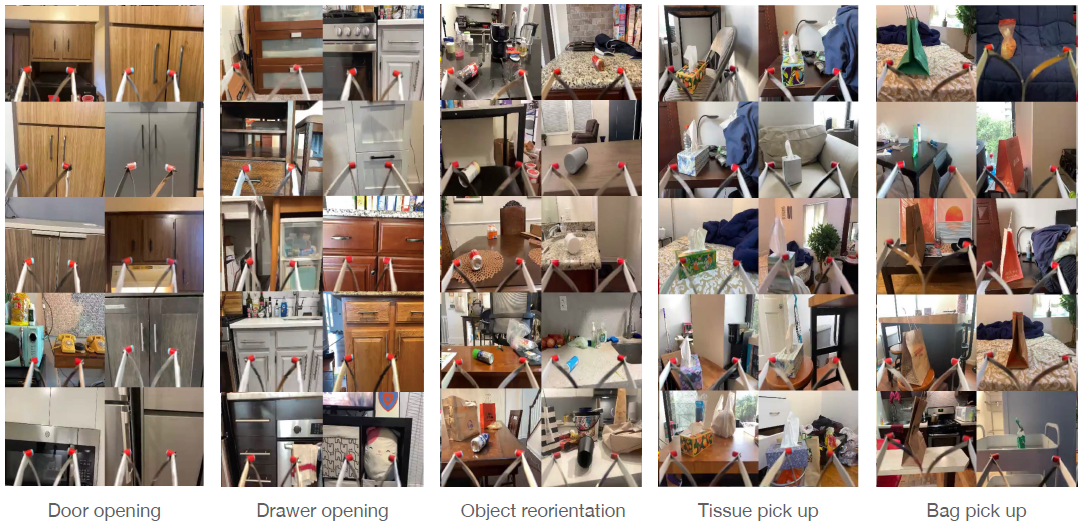

우리는 아래 정의된 대로 다섯 가지 작업 각각에 대한 데이터를 수집합니다:

• Door opening: 캐비닛이나 전자레인지와 같은 긴 손잡이로 문을 엽니다.

하드웨어 제한으로 인해 로봇은 둥근 손잡이로 문을 열 수 없으므로 데이터셋에서 이를 제외합니다.

• Drawer opening: 손잡이가 있는 서랍을 엽니다.

위와 유사한 이유로 손잡이가 있는 서랍은 데이터셋에서 제외합니다.

• Reorientation: 평평한 표면에 놓여 있는 원통형 물체 (예: 병)를 들어 같은 표면에 똑바로 놓습니다.

• Tissue pickup: 모든 티슈 페이퍼 박스에서 부드럽고 유연한 티슈 페이퍼를 집습니다.

• Bag pickup: 평평한 표면에서 크래프트 종이 가방이나 이와 유사한 다른 가방을 집습니다.

다섯 개의 RUM 각각에 대해 약 40개의 환경에서 약 1,000개의 데모를 수집하는 데 집중했으며, 각 환경당 평균 약 25개의 데모를 수집했습니다.

유일한 예외는 1,200개의 door opening과 525개의 시연이 있는 drawer opening입니다.

이러한 환경의 작은 모음은 그림 3에 나와 있습니다.

door opening 작업을 위해, 우리는 이 데이터셋을 뉴욕의 주택 데이터셋 (Shafiullah et al., 2023)과 Dobb-E 실험 중에 수집된 데모로 시드했습니다.

다른 작업의 경우, 우리의 데이터셋은 Stick-v2 도구를 사용하여 새로운 환경과 객체 세트에서 수집된 새로운 데모로 구성되어 있습니다.

경험이 부족한 데이터 수집가들이 이전 데이터셋에서 수집한 시연의 경우, 수동 품질 검사를 실시하고 실패한 시연과 같이 저품질 시연이 많은 환경은 제외합니다.

참고로, 우리의 실험을 편견 없이 유지하기 위해 우리는 테스트 환경과 객체를 유지하고 데이터를 수집하지 않습니다.

학습에 사용하는 다양한 작업 데이터에 대한 빠른 인사이트를 얻기 위해 인터랙티브 데이터 다이버시티 시각화 도구를 만들었습니다

2.3. Model training

우리의 데이터가 대규모 데모 수집가들에 의해 수집된다는 점을 고려할 때, 개념적으로 모델이 데이터셋에서 결과적인 멀티-모달리티를 처리하는 것이 중요합니다.

이 작업에서는 각 작업에 대한 데이터셋에서 대규모 policy 클래스를 학습합니다.

정책 클래스 중 가장 성과가 좋은 클래스는 VQ-BeT (Lee et al., 2024)와 Diffusion Policy (DP) (Chi et al., 2023)입니다.

또한 제한된 작업 세트에 대해 ACT (Zhao et al., 2023b) 및 MLP-BC policy를 학습합니다.

각 policy 클래스는 Shafiullah et al. (2023)의 HPR 인코더에 초기화된 ResNet34 기반 비전 인코더와 트랜스포머 기반 policy 트렁크와 같은 몇 가지 기능을 공유합니다.

우리는 또한 동일한 500 에폭 동안 각 모델을 학습시킵니다.

그 외에도 학습률, 이력 길이, 청크 크기에 가장 적합한 하이퍼파라미터를 찾기 위해 스윕하고, 각 모델에 대해 원본 논문에서 권장하는 하이퍼파라미터를 사용합니다.

최종 VQ-BeT 모델은 3.75Hz에서 서브샘플링된 데이터를 기반으로 학습되었으며, 가장 최근의 6가지 프레임을 사용하여 다음 action을 예측합니다.

우리의 모든 모델은 로봇 엔드 이펙터의 상대적인 6D 공간에서의 action과 그리퍼 개구부의 절대값 [0, 1] 범위에서 예측합니다.

우리는 섹션 3.2에서 다양한 학습 알고리즘 선택이 미치는 영향에 대해 논의합니다.

모든 모델을 학습하는 데 24시간에서 48시간이 걸렸고, 클러스터에 있는 2개의 Nvidia A100 GPU에서 더 많은 GPU를 사용하거나 H100과 같은 최신 GPU를 사용하여 비례적인 속도 향상을 이루었습니다.

2.4. Retrying with GPT-4o feedback

사전 학습된 모델은 새로운 환경에서 작업을 해결할 수 있지만, 최상의 성능을 달성하기 위해서는 모델에 대한 추가 런타임 지원이 필요합니다.

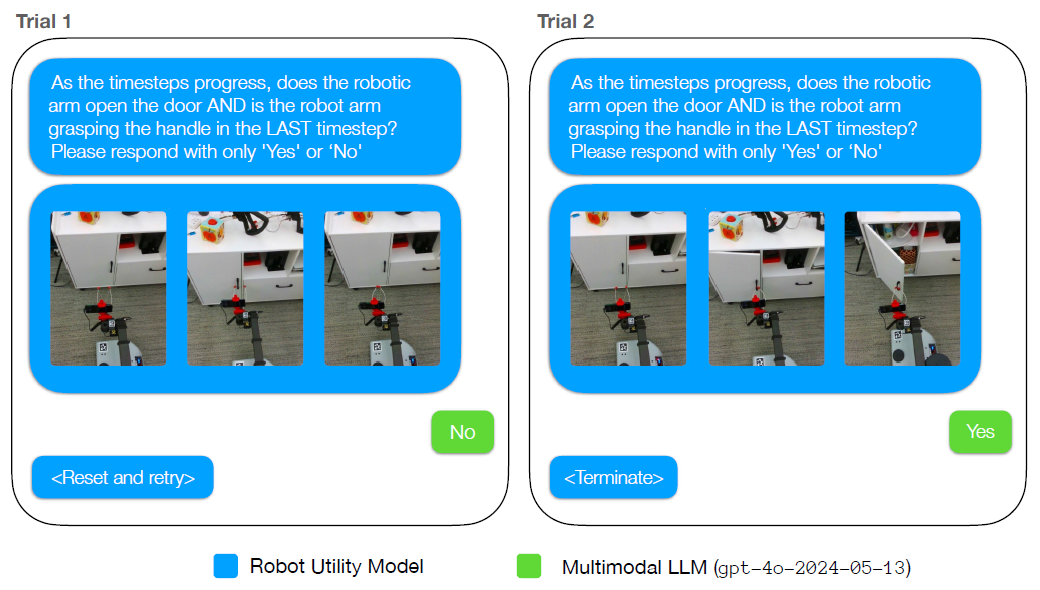

배포를 위해 멀티모달 LLM (gpt-4o-2024-05-13)을 성공 감지 및 재시도 메커니즘을 위한 policy의 성찰 모듈로 사용합니다.

각 작업에 대해 단일 검증 프롬프트를 정의하고, 로봇 관찰 요약이 주어지면 mLLM에 작업의 성공 여부를 검증하도록 요청합니다.

실행 요약에 관해서는 로봇 카메라에서 작업에 따라 머리 또는 손목 카메라의 다른 프레임마다 mLLM을 제공합니다.

mLLM이 고장을 감지하면 (그림 4), RUM은 자동으로 로봇을 홈 위치로 재설정하고 새로운 초기 로봇 상태로 작업을 다시 시도합니다.

2.5. Deployment Details

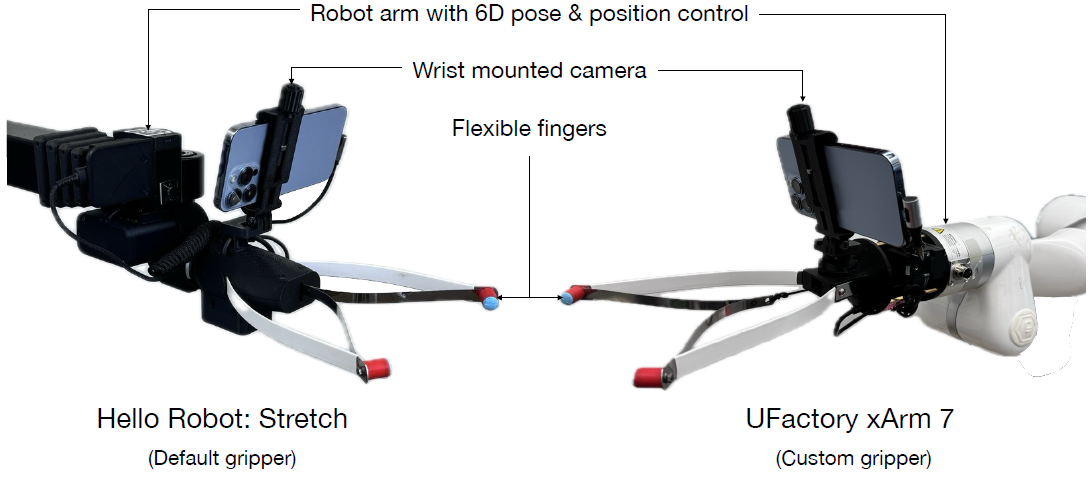

로봇 유틸리티 모델 배포를 위한 주요 하드웨어는 Hello Robot입니다: 손목에 iPhone을 착용한 Stretch 로봇이지만, 상대적으로 6D 포즈와 위치 제어가 가능한 모든 로봇 암에 모델을 배치하는 것을 지원합니다 (그림 5).

우리는 xArm이나 Franka Panda와 같은 표준 로봇 암에 장착할 수 있는 관련 로봇 엔드 이펙터를 설계하고 출시합니다.

마찬가지로, 저희는 주로 iPhone Pro를 배포 카메라로 사용하지만, Hello Stretch Edition 3 이후의 기본 손목 카메라인 Intel Realsense D405와 같은 다른 손목 카메라에도 배포를 표시합니다.

전반적으로 배포 하드웨어 시스템은 다음 세 가지에 크게 의존합니다: 유연한 두 손가락 그립퍼와 그립퍼 팁, 충분한 시야를 갖춘 손목 카메라, 손목에 장착할 수 있는 6자유도 팔을 갖춘 엔드 effector.

우리는 Hello Stretch 3와 우리가 만든 xArm 손목 마운트의 기본 통합 코드를 공개합니다, 이는 다른 팔들의 예시가 될 것입니다.

3. Capabilities of Robot Utility Models

RUM의 기능을 이해하기 위해 다양한 환경에서 각 모델을 평가합니다.

동시에, 우리는 유틸리티 모델 학습을 위한 레시피를 검토하고 일련의 ablation 실험을 실행하여 학습된 모델에 대한 일련의 질문에 답하려고 합니다.

우리가 답하려고 하는 주요 질문은 다음과 같습니다:

• 로봇 유틸리티 모델은 보이지 않는 물체에서 작동하는 동안 보이지 않는 환경에서 작업을 얼마나 잘 해결하나요?

• 로봇 유틸리티 모델의 다양한 구성 요소들, 예를 들어 학습 데이터, 학습 알고리즘, 그리고 자기 검증의 상대적 중요성은 무엇입니까?

– 유능한 RUM을 학습하려면 어떤 규모의 데이터가 필요합니까?

– RUM을 학습하는 데 가장 중요한 데이터 속성은 무엇입니까?

– mLLM 기반 자기비판은 RUM에 어떤 영향을 미치며, 그것이 성공하거나 실패하는 곳은 어디인가요?

• 새로운 로봇 embodiments에 RUM을 얼마나 잘 배포할 수 있을까요?

Evaluation details:

각 작업마다 25개의 새로운 환경 – 각 작업마다 5개씩 – 을 설정했으며, 학습 데이터셋에서 볼 수 없는 객체와 소품이 포함되어 있습니다.

이러한 평가 환경을 조성하기 위해 로봇을 이전에는 볼 수 없었던 주방으로 데려가 온라인으로 새 가구를 구입하고 (door and drawer opening), 학습 세트에 포함되지 않은 것으로 수동으로 확인된 새 물체 (reorientation, bag and tissue pick up)를 소싱합니다.

부록 A.2에서 각 환경과 객체의 샘플 사진을 보여줍니다.

우리는 부록 그림 15에 나타난 것처럼 Shafiullah et al. (2023)이 사용하는 작업 공간을 마주보는 동일한 시작 위치 그리드에서 시작하여, 각 환경에서 10번의 시도에 대해 각 시스템과 policy를 평가합니다.

재시도 기반 실험의 경우, RUM이 성공하는 데 평균 1.31번의 시도가 필요하지만 (섹션 3.6), 무한 재시도 루프에 갇히지 않도록 10번의 시도 타임아웃을 설정했습니다.

3.1. Zero-shot evaluation of RUMs on unseen environments

로봇 유틸리티 모델의 가장 중요한 능력 테스트는 이러한 모델이 새로운 객체에서 작동하는 새로운 환경에서 타겟 작업을 해결할 수 있는지 여부입니다.

우리는 학습 중에 보지 못한 25개의 평가 환경과 객체에 대해 RUM을 실행하여 이 기능을 테스트합니다.

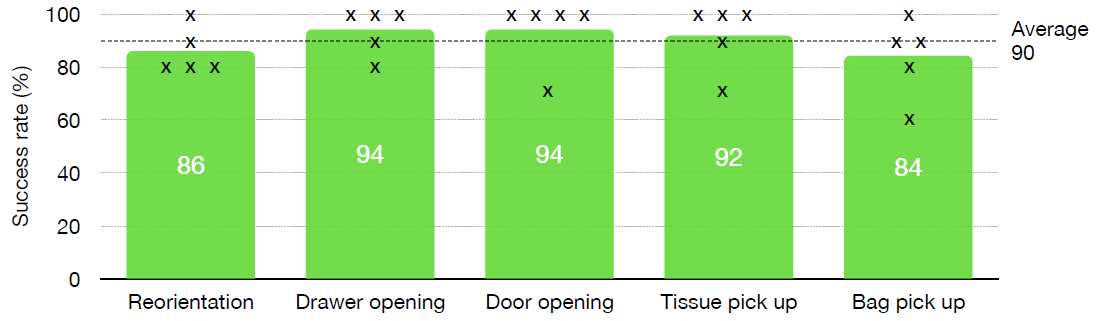

그림 6을 보면, 보이지 않는 새로운 환경에서 RUM은 전체적으로 90%의 성공률을 달성하며, 개별 작업에서 84%에서 94% 사이의 성과를 보인다는 것을 알 수 있습니다.

부록 섹션 A.7에서 관찰한 몇 가지 실패 사례에 대해 논의합니다.

또한, 표 1에 각 테스트 환경에서 RUM의 성능을 보여주며, 모든 평가 실험에서 RUM이 모든 환경에서 어느 정도 성공을 거두었음을 보여줍니다.

이 성공은 우리의 policy가 타겟 과제를 해결하는 일반적인 아이디어를 가지고 있음을 의미합니다; 그런 다음 이러한 policy는 사후 학습 방법 (섹션 3.6)을 통해 더욱 강화됩니다.

다음 모든 실험에서 우리는 이 두 가지 요소를 개별적으로 이해하려고 노력합니다: 기본 RUM policy의 raw 성과와 성찰 및 재시도가 RUM의 성과에 미치는 영향.

3.2. Effect of policy architecture and training method on RUMs

RUM이 실제로 새로운 환경에서 작업을 해결할 수 있다는 것을 확인한 후, 학습 레시피 내에서 다양한 구성 요소의 상대적 중요성을 조사합니다.

특히, 우리는 내향성 요소 없이 데이터셋에서 다양한 policy 아키텍처의 raw 성능을 비교합니다.

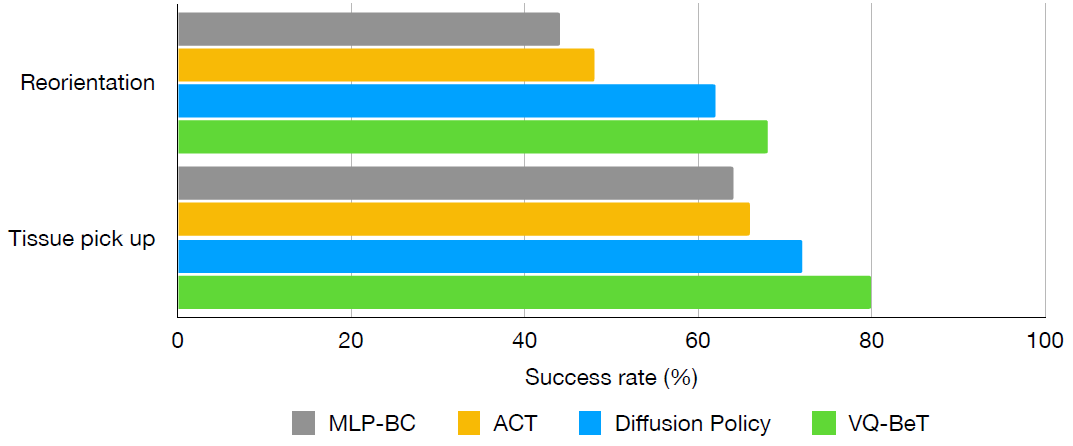

우리는 각 작업에 대해 VQ-BeT (Lee et al., 2024), Diffusion Policy (DP) (Chi et al., 2023), 그리고 두 가지 작업에 대한 베이스라인으로 ACT(Zhao et al., 2023b)와 MLP-BC를 포함한 일련의 policy 클래스를 학습시킵니다.

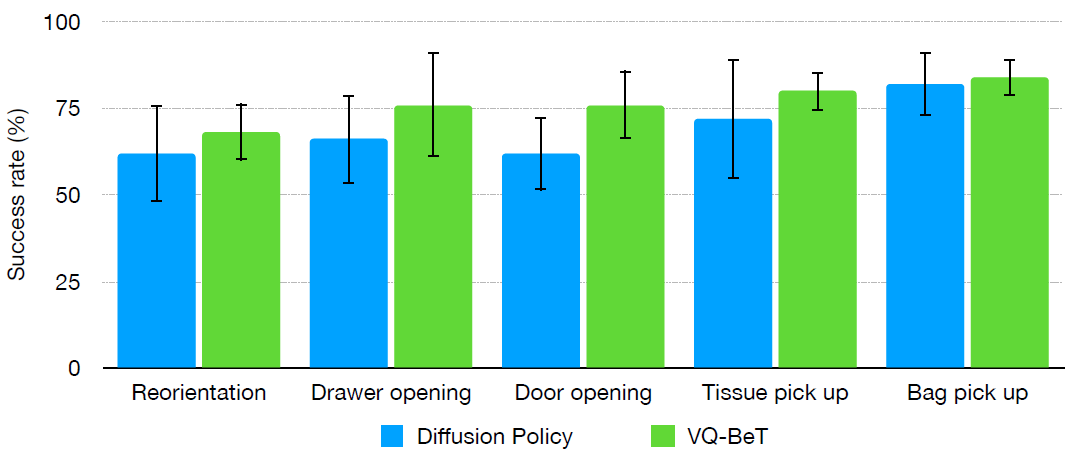

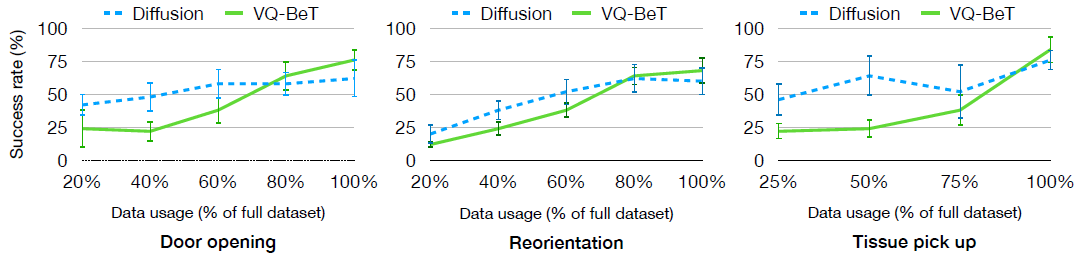

우리는 재시도 없이 다양한 policy 아키텍처의 기본 성공률을 비교한 결과를 그림 7과 8에 보여줍니다.

그림 7에서 볼 수 있듯이, VQ-BeT와 DP는 성능 면에서 상위 두 알고리즘으로, 대부분의 작업에서 비슷한 성능을 보이며 오류 막대가 겹칩니다.

게다가 그림 8을 보면 ACT와 MLP-BC가 정확히 동등하지는 않지만, 둘 다 크게 뒤처지지는 않는다는 것을 알 수 있습니다.

이 관찰은 충분한 품질의 학습 데이터를 사용할 경우 알고리즘 선택이 승패의 결정이 아닐 수 있으며, 다양하고 정확한 데이터를 수집하는 데 더 많은 에너지를 소비해야 함을 의미합니다.

테스트 환경에서도 비슷한 성능을 보이지만, 배포 중 로봇 CPU 자체의 성능이 향상되고 지연 시간이 짧아 최종 모델에는 VQ-BeT over DP를 사용합니다.

3.3. Effect of scaling datasets on RUMs

우리의 실험이 RUM을 생성하는 데 있어 학습 데이터의 중요성을 보여주므로, 성공적인 RUM이 의존하는 데이터셋의 특성을 조사합니다.

특히 신뢰할 수 있는 일반화가 나타나는 데이터셋의 규모와 데이터셋 크기에 따라 RUM의 성능이 어떻게 달라지는지 살펴봅니다.

우리는 작업별 데이터셋에서 랜덤 환경 하위 집합에 대한 policy를 학습하고, 평가 환경에서 이를 평가합니다.

그림 9에서는 데이터셋을 확장할 때 평가 환경에서 이러한 데이터 하위 집합에 대해 학습을 다시 시도하지 않고 VQ-BeT 및 Diffusion Policy의 성능을 보여줍니다.

Diffusion Policy는 더 작은 데이터셋에서는 더 나은 성능을 발휘하지만, VQ-BeT가 더 뛰어난 성능을 보이는 더 큰 데이터셋에서는 포화된다는 것을 알 수 있습니다.

이 관찰은 더 작은 데이터셋이 유능한 RUM을 학습하는 데 충분할 수 있지만, 더 큰 데이터셋이 최고의 성능을 달성하는 데 중요하다는 것을 의미합니다.

가장 큰 데이터셋에서도 데이터셋이 확장됨에 따라 VQ-BeT의 성능이 계속 향상되고 있으며, 이는 더 많은 데이터가 RUM을 더욱 향상시킬 수 있음을 시사합니다.

3.4. Importance of data diversity in training RUMs

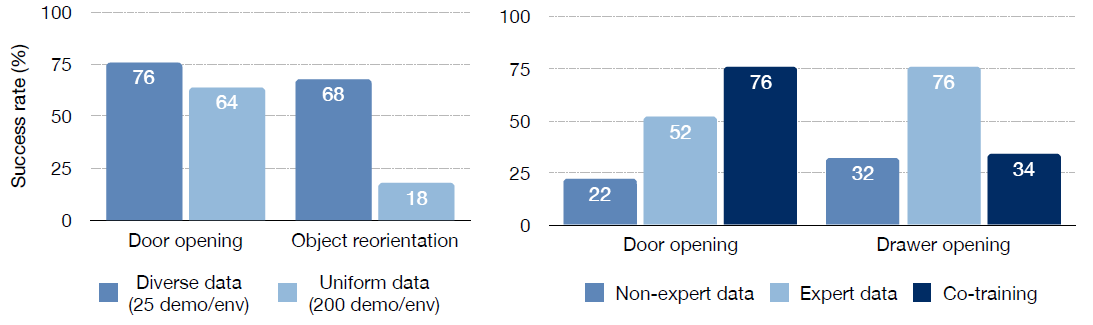

데이터셋의 규모 외에도, 우리는 학습 데이터의 다양성이 그림 10 (왼쪽)의 RUM 성능에 어떤 영향을 미치는지 조사합니다.

우리는 door opening 작업과 객체 reorientation 작업을 위해 동일한 크기의 두 개의 대체 데이터셋을 만듭니다.

첫 번째 데이터셋은 각 환경에서 약 25개의 시연이 있는 다양한 환경으로 구성되어 있습니다.

두 번째 데이터 세트는 각 환경에서 약 200개의 시연이 있는 5~6개의 서로 다른 환경으로 구성되어 있습니다.

장면의 다양성이 좁은 개방 작업에서 다양하고 균일한 환경에서 학습된 policy들이 모두 잘 수행되었음을 알 수 있습니다.

그러나 다양한 보이지 않는 환경과 객체가 있는 재배치 작업에서는 다양한 환경에서 학습된 RUM policy만이 좋은 성과를 거두었습니다 – 보다 균일한 환경에서 학습된 policy는 성능 저하를 50% 경험합니다.

이 결과는 효과적인 RUM을 학습시키기 위해서는 다양한 데이터 세트를 수집하는 것이 중요하다는 것을 의미합니다.

3.5. Impact of using expert demonstrations on training policies

데이터셋 크기와 다양성을 확장하는 것이 RUM을 학습하는 데 중요하지만, 중요한 질문은 학습 데이터셋의 품질입니다.

즉, 많은 demonstrator들이 많은 수의 데모를 수집하는 것은 쉬울 수 있지만, 데모의 품질은 다를 수 있습니다.

이 섹션에서는 RUM 학습에서 전문가 시연을 사용하는 것의 가치를 조사합니다.

그림 10 (오른쪽)에서 우리는 약 500개의 데모에서 학습된 RUM의 성능을 비교합니다, 여기서 데이터는 전문가 또는 비전문가 데모 수집기에서 샘플링됩니다.

여기서 "expertise"은 로봇에 Dobb-E policy를 배포한 경험으로 정의됩니다.

일반적으로 전문가 데이터가 비전문가 데이터보다 더 가치가 있으며, 모든 작업에서 전문가 데이터가 비전문가 데이터보다 우수하다는 것을 알 수 있습니다.

게다가, 전문가 데이터와 비전문가 데이터를 공동으로 학습하는 것이 policy의 성과를 향상시킬 수 있지만, 항상 그런 것은 아닙니다.

이 관찰은 작업에 따라 데이터 품질이 서로 다른 수준의 최적성을 가질 수 있으며, 극단적인 경우 공동 학습의 성과를 해칠 수도 있음을 의미합니다, 이는 일부 이전 연구의 일반적인 관행과 반대됩니다 (Zhao et al., 2023b; Khazatsky et al., 2024).

3.6. Effects of introspection and retrying with self-critique in RUMs

RUM에서는 실패를 식별하기 위한 자기 비판 방법으로 multimodal large language model (MLLM)을 사용하고 있습니다.

그러나 실제로 사전 학습된 mLLM은 로봇 배치에 있어 또 다른 장애물 안전 계층일 뿐, 그 자체로 성공을 보장하는 것은 아닙니다.

따라서 이 섹션에서는 이러한 성찰 방법이 어떻게 도움이 되고 어떻게 실패할 수 있는지 이해하려고 합니다.

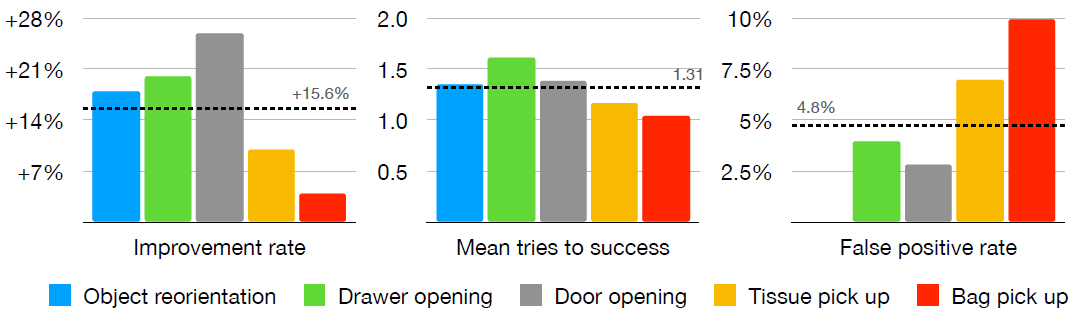

그림 11 (왼쪽)에서 재시도 메커니즘 없이 단순히 RUM policy를 사용하는 것보다 자기 비판을 사용하는 것이 개선된 것을 볼 수 있습니다.

5개의 작업 중 평균적으로 RUM policy를 단순히 사용하는 것보다 15.6% 개선된 것으로 나타났습니다.

재시도는 성공률을 높이는 데 매우 중요하지만, 오랫동안 재시도를 하지 않는 시스템은 훨씬 덜 유용합니다.

다행히도 그림 11 (가운데)에서 볼 수 있듯이 평균적으로 RUM이 성공하면 평균 1.31번의 시도 내에서 성공합니다.

마지막으로, 우리는 거짓 양성을 예측하는 mLLM의 주요 고장 모드를 분석합니다: 궤적이 실제로 실패했을 때 성공으로 분류하기.

평균적으로 우리 궤적의 4.8%가 이러한 동작을 보이며, 이는 그림 11 (오른쪽)에서 볼 수 있듯이 전체 오류의 절반을 차지합니다.

3.7. Transferring RUMs to different embodiments

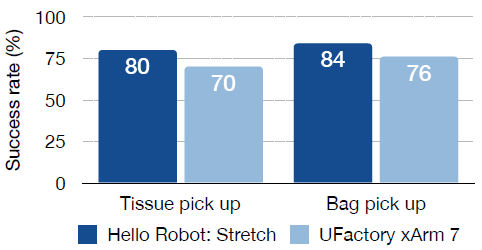

마지막으로, 우리는 RUM이 다양한 embodiments 방식과 카메라로 전송될 수 있는 능력을 조사합니다.

그림 5에 표시된 다른 로봇 설정에서 두 개의 RUM의 성능을 테스트합니다: 다른 실험을 진행하는 Hello Robot Stretch 설정과는 다른 UFactory xArm 7입니다.

RUM은 성능 loss를 최소화하면서 다양한 embodiments 방식과 카메라로 전송할 수 있다는 것을 알 수 있습니다: 그림 12와 같이 수정된 mLLM 피드백이 없는 두 경우 모두 성능이 약 10% 감소했습니다.

우리는 RUM과 mLLM 자기 비판을 결합하면 다른 embodiments에서도 유사한 성능 향상을 가져올 것으로 예상합니다; 실제로 외부 3인칭 카메라를 사용하면 오류가 더 많이 포착되고 수정될 것으로 예상됩니다.

이 실험은 RUM이 최소한의 노력으로 다양한 로봇과 카메라에 쉽게 배치될 수 있음을 의미하며, 이는 다양한 로봇 응용 분야에 다용도로 사용될 수 있는 도구임을 시사합니다.

4. Related works

Large Scale Data Collection:

데이터 수집 파이프라인은 데이터 기반 로봇 학습 프레임워크에서 가장 중요한 요소 중 하나입니다.

이전 연구들은 다양한 데이터 수집 기법을 사용하여 다양한 시뮬레이션 또는 실제 데이터에 걸쳐 다양한 오픈 소스 데이터셋을 결합했으며, 여기에는 전 세계 여러 기관의 다양한 로봇 embodiment도 포함됩니다 (Reed et al., 2022; Brohan et al., 2023; Padalkar et al., 2023; Khazatsky et al., 2024).

로봇 데모 수집에 대한 가장 일반적인 접근 방식은 로봇 또는 엔드 이펙터를 원격 컨트롤러 장치 또는 운동학적으로 동형인 장비와 페어링하는 것입니다.

사용되는 장치들은 다양한 복잡성과 형태를 가지고 있습니다: 그것들은 완전한 로봇 외골격 (Ishiguro et al., 2020; Fang et al., 2023c; Zhao et al., 2023a)뿐만 아니라 더 간단한 데이터 수집 도구 (Wu et al., 2023; Zhao et al., 2023b; Fu et al., 2024b), 그리고 로봇을 물리적으로 움직일 필요가 없는 방법들 (Song et al., 2020; Young et al., 2020; Pari et al., 2021; Shafiullah et al., 2023; Chi et al., 2024)도 포함합니다.

또한 비디오 게임 컨트롤러 (Sian et al., 2004; Liu et al., 2024a), Virtual Reality (VR) 장치 (Arunachalam et al., 2022; Cui et al., 2022; Arunachalam et al., 2023a; Cheng et al., 2024; Fu et al., 2024a; Iyer et al., 2024; Park and Agrawal, 2024; Yang et al., 2024), 휴대폰 (Mandlekar et al., 2018)등 다양한 제어 방법도 사용되었습니다.

가장 직관적인 방법은 실제 로봇을 물리적으로 움직이는 것이지만, 다양한 환경으로 확장하는 것은 어렵고 동시에 어렵습니다.

하드웨어 컨트롤러 접근 방식은 시연자가 로봇 동작을 컨트롤러 입력에 정신적으로 매핑해야 하기 때문에 비효율적일 수 있습니다.

반대로 로봇을 움직이지 않고 기기를 사용하는 것은 시연자의 움직임을 로봇에 직접 매핑할 수 있다는 점에서 효율적이지만, 힘 피드백을 적용하는 것은 어렵습니다.

이 두 가지 방향의 상대적 장점에 대한 관점을 제공하는 연구는 간단한 컨트롤러의 다재다능함과 물리적 엔드 이펙터를 움직이는 직관성을 결합한 (Shafiullah et al., 2023; Chi et al., 2024)입니다.

이 연구에서는 데이터 수집 파이프라인을 위해 제안된 장치 (Shafiullah et al., 2023; Chi et al., 2024)를 상속하고 개선하는 장치를 사용합니다.

Pretrained Robot Models:

사전 학습된 파운데이션 모델은 다양한 도메인에서 광범위한 일반화 성능을 입증했으며, 인터넷 규모의 사전 학습 데이터 (Devlin et al., 2018; Radford et al., 2021; Kirillov et al., 2023; Dubey et al., 2024)를 통해 학습할 수 있는 능력을 갖추고 있습니다.

그러나 이러한 비전 및 언어 사전 학습 모델에 비해 로봇 공학의 파운데이션 모델을 학습하는 것은 제한된 수의 데이터셋 (Kappler et al., 2015; Levine et al., 2016; Depierre et al., 2018; Zhu et al., 2023), 도메인 간의 상당한 불일치 (Dasari et al., 2019; Kalashnikov et al., 2021; Padalkar et al., 2023), 토큰화 측면에서 액션 데이터셋의 본질적으로 도전적인 특성 (Brohan et al., 2023; Lee et al., 2024; Zheng et al., 2024)으로 인해 상대적으로 어려운 분야로 간주되어 왔습니다.

이러한 문제를 해결하기 위해 최근 연구에서는 모듈식 및 계층적 시스템을 도입하고, 사전 학습된 언어 및 시각 모델 (Nair et al., 2022b; Shafiullah et al., 2022; Karamcheti et al., 2023; Li et al., 2023; Gupta et al., 2024; Liu et al., 2024b)을 통합하며, 효율적인 데이터 수집 방식으로 대규모 데이터를 수집하는 기술을 점점 더 많이 채택하고 있습니다 (Ebert et al., 2022; Brohan et al., 2023; Fang et al., 2023a; Walke et al., 2023; Khazatsky et al., 2024).

그 결과, 사전 학습된 파운데이션 로봇 모델이 향상된 일반화 성능을 발휘할 수 있게 되었으며, 이를 통해 로봇 에이전트가 여러 로봇 구현 및 작동 환경에서 작동할 수 있음을 보여주었습니다 (Reed et al., 2022; Doshi et al., 2024; Kim et al., 2024; Team et al., 2024).

앞서 언급한 접근 방식과는 달리, 인터넷 규모의 데이터를 학습하고 작업별 데이터를 파인튜닝하는 방법을 따르는 접근 방식과는 달리, 우리의 접근 방식은 로봇이 작동할 것으로 예상되는 환경에서 모델이 데이터셋에 접근할 수 있을 것으로 기대하지 않습니다.

오히려, 이 프로젝트는 각 새로운 로봇 embodiment 및 환경에 맞게 모델을 파인튜닝할 필요 없이 일반화 가능한 성능을 보여줍니다.

Large Models Feedback and Improvement:

복잡한 시맨틱과 관계를 이해하는 능력 덕분에 자연어와 Large language models (LLM)은 최근 모방 학습 (Fried et al., 2018; Jang et al., 2021; Shridhar et al., 2022; Kim et al., 2024)과 강화 학습 (Goyal et al., 2021; Du et al., 2023)을 기반으로 한 로봇 에이전트에 적용되고 있습니다.

언어 모델이 제공하는 광범위한 기능 중에서 의사 결정의 맥락에서 일반적으로 사용되는 기능에는 불확실한 정보를 해결하기 위한 피드백 제공 (Huang et al., 2022b; Guo et al., 2023; Liu et al., 2023; Park et al., 2023; Ren et al., 2023; Gao et al., 2024; Mullen Jr and Manocha, 2024), 가치 함수와 결합하여 환경에서 가능한 것에 대한 어포던스 제안 (Ahn et al., 2022), 결과에 대한 상상력 (Zhang et al., 2024) 또는 복잡한 작업을 중간 수준의 계획으로 계획하고 분해하는 것 (Sharma et al., 2021; Huang et al., 2022a; Zeng et al., 2022; Song et al., 2023)이 포함됩니다.

언어 모델은 리워드 신호를 개선하거나 (Goyal et al., 2021; Nair et al., 2022a; Ma et al., 2023), 장기적인 추론을 활용하거나 (Blukis et al., 2022; Zhou et al., 2023; Dalal et al., 2024), 환경을 설계함 (Ma et al., 2024)으로써 자율 에이전트 시스템의 전반적인 성능을 향상시키는 데에도 사용될 수 있습니다.

이 프로젝트에서는 mLLM을 사용하여 위의 연구와 유사한 방식으로 개방형 환경에서 리셋 신호 형태로 피드백을 제공합니다.

5. Limitations and Conclusion

이 작업에서는 새로운 환경에서 특정 작업을 제로샷으로 수행할 수 있는 로봇 유틸리티 모델을 만들지만, 향후 버전이 개선할 수 있는 몇 가지 한계가 있습니다.

우리가 보는 주요 한계는 하드웨어입니다: 예를 들어, Stick-v2와 같은 두 손가락 그립퍼는 둥근 문 손잡이로 문을 열 수 없습니다.

마찬가지로, 유연한 손끝은 policy에 더 관대할 수 있지만, 무거운 물건을 조작하기 어렵게 만듭니다.

이러한 문제를 해결하기 위해 더 나은 그립퍼 및 손가락 끝 디자인에 대한 더 많은 연구를 권장합니다.

둘째, 내비게이션을 별도의 구성 요소로 가정하고, 이 작업에서는 로봇이 작업 목표를 향하는 작업 공간에 있다고 가정합니다.

모듈형 내비게이션 작업 (Liu et al., 2024b)과 결합하면 이 문제를 해결할 수 있습니다.

마지막으로, mLLM 성찰과 재시도를 위해, 우리는 모델 (a)에 의해 발생한 오류가 작업 공간을 어느 정도 분산시키고, (b) 로봇을 초기 상태로 쉽게 재설정할 수 있게 한다고 가정합니다.

데이터셋에서 장애 복구 동작을 포함한 학습 데이터를 늘리면 로봇이 이러한 장애 사례로부터 보다 자연스럽게 복구할 수 있습니다.

'Robotics' 카테고리의 다른 글

| SmolVLA: A vision-language-action model for affordable and efficient robotics (0) | 2026.01.08 |

|---|---|

| Fine-Tuning Vision-Language-Action Models: Optimizing Speed and Success (1) | 2025.08.12 |

| Octo: An Open-Source Generalist Robot Policy (0) | 2025.07.03 |

| OpenVLA: An Open-Source Vision-Language-Action Model (0) | 2025.06.30 |

| Navigation World Models (0) | 2025.06.25 |