2021. 2. 23. 15:22ㆍComputer Vision

OverFeat: Integrated Recognition, Localization and Detection using Convolutional Networks

Pierre Sermanet David Eigen

Xiang Zhang Michael Mathieu Rob Fergus Yann LeCun

Courant Institute of Mathematical Sciences, New York University

719 Broadway, 12th Floor, New York, NY 10003

Abstract

분류, 지역화 및 탐지를 위해 Convolutional Networks를 사용하기 위한 통합 프레임 워크를 제시합니다.

ConvNet 내에서 다중 스케일 및 슬라이딩 윈도우 접근 방식을 효율적으로 구현하는 방법을 보여줍니다.

또한 객체 경계를 예측하는 학습을 통해 현지화에 대한 새로운 딥러닝 접근 방식을 소개합니다.

그런 다음 감지 신뢰도를 높이기 위해 경계 상자가 억제되지 않고 누적됩니다.

단일 공유 네트워크를 사용하여 여러 작업을 동시에 학습할 수 있음을 보여줍니다.

이 통합 프레임 워크는 ImageNet Large Scale Visual Recognition Challenge 2013 (ILSVRC2013)의 현지화 작업에서 우승했으며 탐지 및 분류 작업에 대해 매우 경쟁력 있는 결과를 얻었습니다.

경쟁 후 작업에서 우리는 탐지 작업을 위한 새로운 상태를 확립합니다.

마지막으로 우리는 OverFeat라는 최고의 모델에서 기능 추출기를 출시합니다.

1. Introduction

이미지에서 지배적인 개체의 범주를 인식하는 것은 개체가 손으로 쓴 문자, 집 번호, 질감 없는 장난감, 교통 표지판, Caltech-101 데이터 세트의 개체, 또는 1000 카테고리 ImageNet 데이터 세트의 개체이든 상관없이 ConvNets (Convolutional Networks)가 수년 동안 적용되어 온 작업입니다.

Caltech-101과 같은 소규모 데이터 세트에서 ConvNets의 정확도는 괜찮지만 기록적인 것은 아닙니다.

그러나 더 큰 데이터 세트의 출현으로 ConvNets는 1000 카테고리 ImageNet과 같은 데이터 세트에 대한 최첨단 기술을 크게 발전시킬 수 있었습니다.

이러한 많은 작업에서 ConvNets의 주요 이점은 원시 픽셀에서 최종 범주에 이르기까지 전체 시스템이 엔드 투 엔드 학습되어 적절한 기능 추출기를 수동으로 설계해야 하는 요구 사항을 완화한다는 것입니다.

가장 큰 단점은 레이블이 지정된 훈련 샘플에 대한 탐욕스러운 욕구입니다.

이 논문의 요점은 이미지에서 객체를 동시에 분류, 찾기 및 감지하도록 컨볼루션 네트워크를 훈련하면 분류 정확도와 모든 작업의 탐지 및 위치 정확도를 높일 수 있음을 보여주는 것입니다.

이 논문은 단일 ConvNet을 사용하여 객체 감지, 인식 및 위치 파악에 대한 새로운 통합 접근 방식을 제안합니다.

또한 예측된 경계 상자를 누적하여 지역화 및 감지를 위한 새로운 방법을 소개합니다.

많은 현지화 예측을 결합하여 백그라운드 샘플에 대한 교육 없이 탐지를 수행할 수 있으며 시간이 많이 걸리고 복잡한 부트스트랩 교육 과정을 피할 수 있음을 제안합니다.

백그라운드에서 훈련하지 않으면 네트워크가 더 높은 정확도를 위해 양성 클래스에만 집중할 수 있습니다.

실험은 ImageNet ILSVRC 2012 및 2013 데이터 세트에서 수행되고 ILSVRC 2013 현지화 및 감지 작업에 대한 최신 결과를 설정합니다.

ImageNet 분류 데이터 세트의 이미지는 이미지의 대부분을 채우는 대략 중앙에 있는 개체를 포함하도록 주로 선택되지만, 관심 개체는 때때로 이미지 내에서 크기와 위치가 크게 다릅니다.

이 문제를 해결하는 첫 번째 아이디어는 이미지의 여러 위치에 슬라이딩 윈도우 방식으로 여러 스케일에 걸쳐 ConvNet을 적용하는 것입니다.

그러나 이 경우에도 많은 보기 창에는 개체의 완벽하게 식별 가능한 부분 (예 : 개의 머리)이 포함될 수 있지만 전체 개체 또는 개체의 중심은 포함되지 않을 수 있습니다.

이로 인해 적절한 분류가 이루어지지만 현지화 및 감지가 불량합니다.

따라서 두 번째 아이디어는 각 윈도우에 대한 범주에 대한 분포를 생성할 뿐만 아니라 윈도우와 관련된 개체를 포함하는 경계 상자의 위치와 크기에 대한 예측을 생성하도록 시스템을 훈련시키는 것입니다.

세 번째 아이디어는 각 위치와 크기에서 각 범주에 대한 증거를 축적하는 것입니다.

많은 저자들이 다중 스케일에 걸쳐 슬라이딩 윈도우를 사용하여 감지 및 위치 파악을 위해 ConvNet을 사용할 것을 제안했습니다. 1990년대 초반부터 다중 문자열, 얼굴, 손으로 거슬러 올라갑니다.

최근에 ConvNets는 자연 이미지, 얼굴 감지 및 보행자 감지에서 텍스트 감지에 대한 최첨단 성능을 제공하는 것으로 나타났습니다.

여러 저자는 또한 viewing 윈도우에 대한 상대적인 위치 또는 객체의 포즈와 같이 위치할 객체의 인스턴스화 매개 변수를 직접 예측하도록 ConvNets를 훈련시킬 것을 제안했습니다.

예를 들어 Osadchy 등[23]은 동시 얼굴 감지 및 포즈 추정을 위한 ConvNet을 설명합니다.

얼굴은 9차원 출력 공간에서 3D 매니 폴드로 표현됩니다.

매니 폴드의 위치는 포즈 (피치, 요 및 롤)를 나타냅니다.

훈련 이미지가 얼굴인 경우 네트워크는 알려진 포즈의 위치에서 매니 폴드의 한 지점을 생성하도록 훈련됩니다.

이미지가 얼굴이 아니면 출력이 매니 폴드에서 밀려납니다.

테스트 시간에 매니 폴드까지의 거리는 이미지에 얼굴이 있는지 여부를 나타내며 매니 폴드에서 가장 가까운 지점의 위치는 포즈를 나타냅니다.

Taylor 등[27, 28]은 ConvNet을 사용하여 신체 부위 (손, 머리 등)의 위치를 추정하여 인체 포즈를 도출합니다.

메트릭 학습 기준을 사용하여 신체 포즈 매니 폴드에 포인트를 생성하도록 네트워크를 훈련시킵니다.

Hinton 등은 또한 인식 프로세스의 일부로 피처의 명시적 인스턴스화 매개 변수를 계산하도록 네트워크를 훈련하도록 제안했습니다[12].

다른 저자들은 ConvNet 기반 세분화를 통해 객체 지역화를 수행할 것을 제안했습니다.

가장 간단한 접근 방식은 ConvNet이 viewing 윈도우의 중앙 픽셀 (또는 체적 이미지의 경우 복셀)을 영역 사이의 경계로 분류하도록 훈련시키는 것입니다[13].

그러나 영역을 분류해야 하는 경우 의미론적 분할을 수행하는 것이 좋습니다.

주요 아이디어는 ConvNet이 해당 윈도우를 결정의 컨텍스트로 사용하여 viewing 윈도우의 중심 픽셀을 자신이 속한 개체의 범주로 분류하도록 훈련시키는 것입니다.

응용 분야는 생물학적 이미지 분석, 이동 로봇용 장애물 태깅, 사진 태깅에 이르기까지 다양합니다.

이 접근 방식의 장점은 경계 윤곽이 직사각형일 필요가 없고 영역이 잘 둘러싸인 객체일 필요가 없다는 것입니다.

단점은 학습을 위해 조밀한 픽셀 수준 레이블이 필요하다는 것입니다.

이 세분화 전처리 또는 객체 제안 단계는 최근 검색을 위한 위치, 규모 및 종횡비의 검색 공간을 줄이기 위해 전통적인 컴퓨터 비전에서 인기를 얻었습니다[19, 2, 6, 29].

따라서 고가의 분류 방법을 검색 공간의 최적 위치에 적용할 수 있으므로 인식 정확도가 높아집니다.

또한 [29, 1]은 이러한 방법이 가능성이 없는 물체 영역을 대폭 감소시켜 잠재적인 오탐지를 줄임으로써 정확도를 개선한다고 제안합니다.

그러나 우리의 조밀한 슬라이딩 윈도우 방법은 ILSVRC13 탐지 데이터 세트에서 객체 제안 방법을 능가할 수 있습니다.

Krizhevsky 등[15]은 최근 대규모 ConvNet을 사용하여 인상적인 분류 성능을 입증했습니다.

저자는 또한 ImageNet 2012 대회에 참가하여 분류 및 현지화 문제를 모두 이겼습니다.

그들은 인상적인 현지화 성능을 보여 주었지만 그들의 접근 방식을 설명하는 출판된 작품은 없습니다.

따라서 우리의 논문은 ConvNet이 ImageNet 데이터의 지역화 및 감지에 어떻게 사용될 수 있는지 명확한 설명을 제공하는 최초의 문서입니다.

이 논문에서 우리는 ImageNet 2013 대회에서의 사용과 일치하는 방식으로 지역화 및 감지라는 용어를 사용합니다. 즉, 유일한 차이점은 사용된 평가 기준이며 둘 다 이미지의 각 개체에 대한 경계 상자를 예측하는 것과 관련이 있다는 것입니다.

2. Vision Tasks

이 논문에서는 (i) 분류, (ii) 지역화 및 (iii) 감지의 세 가지 컴퓨터 비전 작업을 난이도의 순서로 탐색합니다.

각 작업은 다음 작업의 하위 작업입니다.

모든 작업은 단일 프레임 워크와 공유 기능 학습 기반을 사용하여 처리되지만 다음 섹션에서 별도로 설명합니다.

논문 전반에 걸쳐 2013 ImageNet 대규모 시각 인식 챌린지 (ILSVRC2013)에 대한 결과를 보고합니다.

이 챌린지의 분류 작업에서 각 이미지에는 이미지의 주요 개체에 해당하는 단일 레이블이 할당됩니다.

다섯 번의 추측으로 정답을 찾을 수 있습니다 (이미지에 레이블이 지정되지 않은 여러 개체가 포함될 수도 있기 때문입니다).

현지화 작업은 이미지 당 5개의 추측이 허용된다는 점에서 비슷하지만, 예측된 개체에 대한 경계 상자가 각 추측과 함께 반환되어야 합니다.

올바른 것으로 간주되려면 예측된 상자가 최소한 50%까지 근거와 일치해야하며 (교차에 대한 결합의 PASCAL 기준 사용) 올바른 클래스로 레이블을 지정해야합니다 (즉, 각 예측은 함께 연관된 레이블 및 경계 상자입니다).

감지 작업은 각 이미지에 여러 개체 (0 포함)가 있을 수 있고 mean Average Precision(mAP) 측정 값에 의해 오탐지가 처벌된다는 점에서 지역화와 다릅니다.

현지화 작업은 분류와 감지 사이의 편리한 중간 단계이며 감지와 관련된 문제 (예 : 백그라운드 클래스 학습)와 관계없이 현지화 방법을 평가할 수 있습니다.

그림 1에서는 현지화 / 검출 예측과 해당 정답이 있는 이미지의 예를 보여줍니다.

분류 및 현지화는 동일한 데이터 세트를 공유하는 반면 감지에는 개체가 더 작을 수 있는 추가 데이터가 있습니다.

감지 데이터에는 특정 물체가 없는 이미지 세트도 포함됩니다.

이것은 부트스트래핑에 사용할 수 있지만 이 작업에서는 사용하지 않았습니다.

3. Classification

우리의 분류 아키텍처는 Krizhevsky et al [15]의 최고의 ILSVRC12 아키텍처와 유사합니다.

그러나 우리는 네트워크 설계와 추론 단계를 개선합니다.

시간 제약으로 인해 Krizhevsky 모델의 일부 학습 기능은 탐색되지 않았으므로 결과가 더욱 향상될 수 있을 것으로 기대합니다.

이는 향후 작업 섹션 6에서 논의됩니다.

3.1. Model Design and Training

ImageNet 2012 학습 세트 (120만 개 이미지 및 C=1000 클래스)에서 네트워크를 교육합니다[5].

우리 모델은 훈련 중에 Krizhevsky 등[15]이 제안한 동일한 고정 입력 크기 접근법을 사용하지만 다음 섹션에서 설명하는 것처럼 분류를 위해 다중 스케일로 전환합니다.

각 이미지는 가장 작은 치수가 256 픽셀이 되도록 다운 샘플링됩니다.

그런 다음 221x221 픽셀 크기의 무작위 크롭 5개 (및 수평 플립)를 추출하여 128크기의 미니 배치로 네트워크에 표시합니다.

네트워크의 가중치는 (μ, σ) = (0, 1×10−2)로 무작위로 초기화됩니다.

그런 다음 모멘텀 항 0.6과 1×10−5의 ℓ2 가중치 감쇠를 동반하는 확률적 경사 하강법에 의해 업데이트됩니다.

학습률은 처음에는 5×10−2이고 (30, 50, 60, 70, 80) epoch 후에 0.5배씩 연속적으로 감소합니다.

0.5의 비율을 가진 DropOut[11]은 분류기의 완전 연결 계층 (6번째 및 7번째)에 사용됩니다.

표 1과 3에서 아키텍처 크기를 자세히 설명합니다.

학습 중에 공간 출력을 생성하는 추론 단계와는 반대로 이 아키텍처를 비공간 (크기 1x1의 출력 맵)으로 취급합니다.

레이어 1-5는 정류 ("relu") 비선형성 및 최대 풀링을 사용하는 Krizhevsky 등[15]과 유사하지만 다음과 같은 차이점이 있습니다: (i) 대비 정규화가 사용되지 않습니다; (ii) 풀링 영역은 겹치지 않으며 (iii) 우리 모델은 더 작은 stride (4 대신 2) 덕분에 더 큰 첫 번째 및 두 번째 레이어 피처 맵을 가집니다.

stride가 클수록 속도에 도움이 되지만 정확도가 떨어집니다.

그림 2에서는 처음 두 개의 컨벌루션 레이어의 필터 계수를 보여줍니다.

첫 번째 레이어 필터는 방향이 지정된 가장자리, 패턴 및 얼룩을 캡처합니다.

두 번째 레이어에서 필터는 다양한 형태를 가지며 일부는 확산되고 다른 일부는 강한 선 구조 또는 방향이 있는 가장자리를 갖습니다.

3.2. Feature Extractor

이 논문과 함께 컴퓨터 비전 연구에 강력한 기능을 제공하기 위해 "OverFeat"라는 기능 추출기를 출시합니다.

빠르고 정확한 두 가지 모델이 제공됩니다.

각 아키텍처는 표 1과 3에 설명되어 있습니다.

또한 매개 변수 및 연결 측면에서 표 4의 크기를 비교합니다.

정확한 모델은 빠른 모델보다 정확하지만 (표 2의 16.39%에 비해 14.18% 분류 오류) 거의 두배에 가까운 연결이 필요합니다.

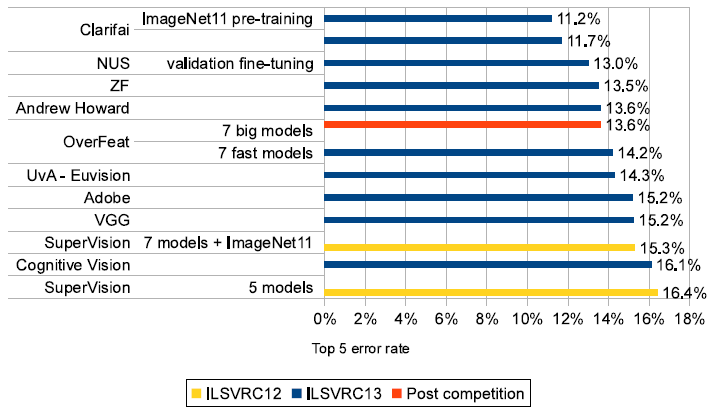

7개의 정확한 모델로 구성된 위원회를 사용하면 그림 4와 같이 분류 오류가 13.6%에 도달합니다.

3.3. Multi-Scale Classification

[15]에서는 다중-view 투표를 사용하여 성능을 향상시킵니다: 고정된 10개의 view 세트 (4개의 모서리와 중앙, 수평으로 뒤집기)가 평균화됩니다.

그러나 이 접근 방식은 이미지의 많은 영역을 무시할 수 있으며 view가 겹칠 때 계산적으로 중복됩니다.

또한 ConvNet이 최적의 신뢰도로 응답하는 규모가 아닐 수도 있는 단일 척도로만 적용됩니다.

대신 각 위치와 여러 규모에서 네트워크를 조밀하게 실행하여 전체 이미지를 탐색합니다.

슬라이딩 윈도우 접근 방식은 특정 유형의 모델에 대해 계산적으로 금지될 수 있지만 ConvNet의 경우 본질적으로 효율적입니다 (섹션 3.5 참조).

이 접근 방식은 투표에 대해 훨씬 더 많은 view를 생성하여 효율성을 유지하면서 견고성을 높입니다.

임의 크기의 이미지에서 ConvNet을 컨볼빙한 결과는 각 스케일에서 C차원 벡터의 공간 맵입니다.

그러나 위에서 설명한 네트워크의 총 서브 샘플링 비율은 2x3x2x3 또는 36입니다.

따라서 조밀하게 적용하면 이 아키텍처는 각 축을 따라 입력 차원에서 36 픽셀마다 분류 벡터만 생성할 수 있습니다.

이렇게 coarse 출력 분포는 네트워크 윈도우가 이미지의 개체와 잘 정렬되지 않기 때문에 10-view 방식에 비해 성능을 저하시킵니다.

네트워크 윈도우와 개체가 더 잘 정렬될수록 네트워크 응답의 신뢰도가 가장 높습니다.

이 문제를 피하기 위해 우리는 Giusti 등 [9]에 의해 도입된 것과 유사한 접근 방식을 취하고 모든 오프셋에서 마지막 서브 샘플링 작업을 적용합니다.

이렇게하면 이 레이어에서 해상도 손실이 제거되어 x36 대신 x12의 총 서브 샘플링 비율이 생성됩니다.

이제 해상도 증가가 수행되는 방법을 자세히 설명합니다.

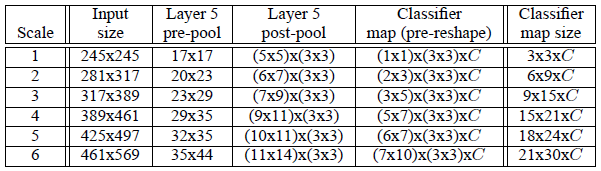

다양한 해상도의 풀링되지 않은 레이어 5 맵을 생성하는 6개의 입력 스케일을 사용합니다 (자세한 내용은 표 5 참조).

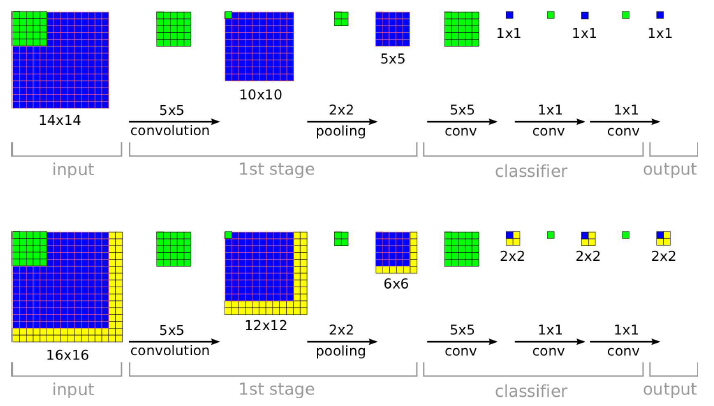

그런 다음 그림 3에 설명된 다음 절차를 사용하여 풀링되고 분류기에 제공됩니다:

(a) 단일 이미지의 경우 주어진 축척에서 풀링되지 않은 레이어 5 피처 맵으로 시작합니다.

(b) 풀링되지 않은 각 맵은 {0, 1, 2}의 (△x, △y) 픽셀 오프셋에 대해 3x3회 반복되는 3x3 최대 풀링 작업 (겹치지 않는 영역)을 거칩니다.

(c) 이렇게 하면 서로 다른 (△x, △y) 조합에 대해 (3x3)번 복제된 풀링된 피처 맵 세트가 생성됩니다.

(d) 분류기 (레이어 6,7,8)는 5x5의 고정 입력 크기를 가지며 풀링된 맵 내의 각 위치에 대한 C차원 출력 벡터를 생성합니다. 분류기는 풀링된 맵에 슬라이딩 윈도우 방식으로 적용되어 C차원 출력 맵을 생성합니다 (주어진 (△x, △y) 조합에 대해).

(e) 서로 다른 (△x, △y) 조합에 대한 출력 맵이 단일 3D 출력 맵 (두 공간 차원 x C클래스)으로 재구성됩니다.

이러한 작업은 서브 샘플링 없이 풀링 레이어를 통해 분류기의 viewing 윈도우를 1픽셀 씩 이동하고 다음 레이어에서 스킵 커널을 사용하는 것으로 볼 수 있습니다 (인접한 값이 인접하지 않은 경우).

또는 동등하게, 가능한 모든 오프셋에서 최종 풀링 레이어와 완전히 연결된 스택을 적용하고 출력을 인터리빙하여 결과를 조합합니다.

위의 절차는 각 이미지의 수평으로 뒤집힌 버전에 대해 반복됩니다.

그런 다음 (i) 각 등급, 각 스케일 및 플립에서 공간 최대 값을 취하여 최종 분류를 생성합니다. (ii) 다른 스케일 및 플립에서 생성된 C-차원 벡터를 평균화하고 (iii) 평균 클래스 벡터에서 top-1 또는 top-5 요소 (평가 기준에 따라 다름)를 가져옵니다.

직관적인 수준에서 네트워크의 두 부분, 즉 특징 추출 레이어(1-5) 및 분류자 레이어(6-출력) — 반대 방식으로 사용됩니다.

특징 추출 부분에서 필터는 한 번의 패스로 전체 이미지에 걸쳐 컨볼루션됩니다.

계산 관점에서 볼 때 고정 크기 특징 추출기를 이미지 위로 이동한 다음 다른 위치의 결과를 집계하는 것보다 훨씬 효율적입니다.

그러나 이러한 원칙은 네트워크의 분류자 부분에 대해 반대입니다.

여기서 우리는 다양한 위치와 스케일에 걸쳐 레이어 5 피처 맵에서 고정 크기 표현을 찾고자 합니다.

따라서 분류기는 고정된 크기의 5x5 입력을 가지며 레이어 5 맵에 철저히 적용됩니다.

철저한 풀링 방식 (단일 픽셀 시프트 (△x, △y) 포함)을 통해 분류자와 피처 맵에서 객체 표현 사이의 미세 정렬을 얻을 수 있습니다.

3.4. Results

표 2에서 우리는 다양한 접근 방식을 실험하고 참조를 위해 Krizhevsky et al [15]의 단일 네트워크 모델과 비교합니다.

위에서 설명한 접근 방식은 6개의 척도를 사용하여 13.6%의 상위 5개 오류율을 달성합니다.

예상할 수 있듯이 더 적은 척도를 사용하면 성능이 저하됩니다: 단일 척도 모델은 상위 5개 오류가 16.97%로 더 나쁩니다.

그림 3에 예시된 미세 보폭 기법은 단일 스케일 영역에서 비교적 작은 개선을 가져오지만 여기에 표시된 다중 스케일 이득에도 중요합니다.

우리 모델 (OverFeat)은 7개의 ConvNet (각각 다른 초기화로 훈련 됨)에 투표하여 14.2%의 정확도를 얻었으며 18개 팀 중 5위를 차지한 2013년 대회의 테스트 세트 결과를 그림 4에 보고합니다.

ILSVRC13 데이터만 사용한 최상의 정확도는 11.7% 였습니다.

ImageNet Fall11 데이터 세트의 추가 데이터를 사용한 사전 학습은 이 수치를 11.2%로 향상시켰습니다.

대회 후 작업에서 더 큰 모델 (더 많은 기능과 더 많은 레이어)을 사용하여 OverFeat 결과를 13.6% 오류로 개선합니다.

시간 제약으로 인해 이러한 더 큰 모델은 완전히 훈련되지 않았으며 시간이 지나면 더 많은 개선 사항이 나타날 것으로 예상됩니다.

3.5. ConvNets and Sliding Window Efficiency

한 번에 하나씩 입력의 각 창에 대해 전체 파이프 라인을 계산하는 많은 슬라이딩 윈도우 접근 방식과 달리, ConvNet은 중첩 영역에 공통적인 계산을 자연스럽게 공유하기 때문에 슬라이딩 방식으로 적용될 때 본질적으로 효율적입니다.

테스트 시간에 더 큰 이미지에 네트워크를 적용할 때 전체 이미지의 범위에 각 컨볼루션을 적용하기만하면 됩니다.

이렇게하면 각 레이어의 출력이 새로운 이미지 크기를 포함하도록 확장되어 결국 입력의 각 "창"(시야)에 대해 하나의 공간 위치가 있는 출력 클래스 예측 맵이 생성됩니다.

이것은 그림 5에 나와 있습니다.

컨볼루션은 상향식으로 적용되므로 인접한 창에 공통된 계산은 한 번만 수행하면 됩니다.

아키텍처의 마지막 계층은 완전히 연결된 선형 계층입니다.

테스트 시간에 이러한 레이어는 1x1 공간 범위의 커널을 사용하는 컨볼루션 연산으로 효과적으로 대체됩니다.

그러면 전체 ConvNet은 단순히 일련의 컨볼루션, 최대 풀링 및 임계값 작업입니다.

4. Localization

분류 훈련된 네트워크에서 시작하여 분류기 계층을 회귀 네트워크로 대체하고 각 공간 위치 및 규모에서 객체 경계 상자를 예측하도록 훈련합니다.

그런 다음 회귀 예측을 각 위치의 분류 결과와 함께 결합합니다.

4.1. Generating Predictions

객체 경계 상자 예측을 생성하기 위해 모든 위치와 규모에서 분류기와 회귀 네트워크를 동시에 실행합니다.

이들은 동일한 특징 추출 계층을 공유하므로 분류 네트워크를 계산한 후 최종 회귀 계층만 다시 계산하면 됩니다.

각 위치에서 클래스 c에 대한 최종 소프트 맥스 레이어의 출력은 해당 시야에 클래스 c의 객체가 존재한다는 신뢰 점수를 제공합니다 (반드시 완전히 포함되지는 않음).

따라서 각 경계 상자에 신뢰도를 할당할 수 있습니다.

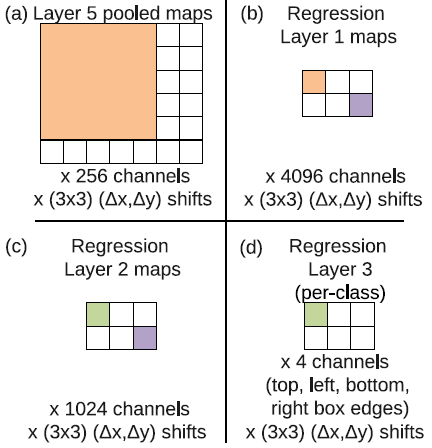

4.2. Regressor Training

회귀 네트워크는 레이어 5에서 풀링된 피처 맵을 입력으로 사용합니다.

각각 크기가 4096 및 1024채널인 완전히 연결된 2개의 숨겨진 레이어가 있습니다.

최종 출력 레이어에는 경계 상자 가장자리의 좌표를 지정하는 4개의 단위가 있습니다.

분류와 마찬가지로 △x, △y 이동으로 인해 전체적으로 (3x3) 사본이 있습니다.

아키텍처는 그림 8에 나와 있습니다.

분류 네트워크에서 특성 추출 계층 (1-5)을 수정하고 각 예제에 대해 예측된 경계 상자와 실제 경계 상자간의 ℓ2 손실을 사용하여 회귀 네트워크를 훈련합니다.

최종 회귀 계층은 클래스 별로 다르며 각 클래스에 대해 하나씩 1000개의 서로 다른 버전이 있습니다.

섹션 3에 설명된 것과 동일한 척도 세트를 사용하여 이 네트워크를 훈련시킵니다.

컨볼루션 내에서 회귀자 변환 오프셋의 참조 프레임으로 이동한 ground-truth 경계 상자와 각 공간 위치에서 회귀자 네트의 예측을 비교합니다 (그림 8 참조).

그러나 우리는 입력 시야와 50% 미만으로 겹치는 경계 상자에서 회귀자를 훈련하지 않습니다: 객체는 대부분 이러한 위치 밖에 있기 때문에 객체를 포함하는 회귀 윈도우에서 더 잘 처리됩니다.

다중 스케일 방식으로 회귀자를 훈련하는 것은 전체 스케일 예측 조합에 중요합니다.

단일 척도에서의 학습은 해당 척도에서 잘 수행되고 다른 척도에서는 여전히 합리적으로 수행됩니다.

그러나 다중 스케일을 훈련하면 스케일 간에 예측이 올바르게 일치하고 병합된 예측의 신뢰도가 기하급수적으로 증가합니다.

결과적으로 이는 일반적으로 탐지의 경우와 같이 여러 척도가 아닌 몇 가지 척도로만 잘 수행할 수 있게합니다.

보행자 감지에서 한 척도에서 다른 척도로의 일반적인 비율 [25]은 약 1.05에서 1.1이지만 여기서는 시스템을 더 빠르게 실행할 수 있도록 약 1.4(차원이 네트워크의 보폭에 정확히 맞도록 크기가 조정되기 때문에이 숫자는 각 스케일마다 다릅니다)의 큰 비율을 사용합니다.

4.3. Combining Predictions

다음 알고리즘을 사용하여 회귀자 경계 상자에 적용된 욕심 많은 병합 전략을 통해 개별 예측 (그림 7 참조)을 결합합니다.

(a) 각 척도 s ∈ 1 ... 6에 대해 상위 k에 있는 클래스 집합을 Cs에 할당합니다. 해당 척도에 대한 공간 위치에서 최대 탐지 클래스 출력을 취하여 찾은 것입니다.

(b) 척도 s의 모든 공간 위치에서 Cs의 각 클래스에 대해 회귀 네트워크에서 예측한 경계 상자 세트를 B에 할당합니다.

(c) 할당 B ← ∪s Bs

(d) 완료될 때까지 병합을 반복합니다.

(e) (b^∗1, b^∗2) = argmin b1≠b2∈B match_score (b1, b2)

(f) match_score (b^∗1, b^∗2)> t이면 중지합니다.

(g) 그렇지 않으면 B ← B \ {b^∗1, b^∗2} ∪ [box_merge (b^∗1, b^∗2)

위의 경우 두 경계 상자의 중심과 상자의 교차 영역 사이의 거리의 합을 사용하여 match_score를 계산합니다.

box_merge는 경계 상자 좌표의 평균을 계산합니다.

최종 예측은 최대 클래스 점수가 있는 병합된 경계 상자를 가져옴으로써 제공됩니다.

이는 각 경계 상자가 예측된 입력 윈도우와 관련된 탐지 클래스 출력을 누적 추가하여 계산됩니다.

하나의 고 신뢰성 경계 상자로 병합된 경계 상자의 예는 그림 6을 참조하십시오.

이 예에서 일부 거북이 및 고래 경계 상자는 중간 다중 스케일 단계에 나타나지만 최종 감지 이미지에서는 사라집니다.

이러한 경계 상자는 분류 신뢰도가 낮을 뿐만 아니라 (각각 최대 0.11 및 0.12), 그들의 수집은 상당한 신뢰 향상을 얻기 위해 곰 경계 상자 만큼 일관적이지 않습니다.

곰 상자는 강한 신뢰도 (척도 당 평균 약 0.5)와 높은 일치 점수를 가지고 있습니다.

따라서 병합 후 많은 곰 경계 상자가 하나의 매우 높은 신뢰도 상자로 통합되는 반면 잘못된 긍정은 경계 상자 일관성 및 신뢰 부족으로 인해 감지 임계값 아래로 사라집니다.

이 분석은 우리의 접근 방식이 경계 상자 일관성을 보상함으로써 기존의 비 최대 억제보다 순수 분류 모델에서 발생하는 오탐에 대해 자연스럽게 더 강력함을 시사합니다.

4.4. Experiments

경쟁에 지정된 현지화 기준을 사용하여 ImageNet 2012 검증 세트에 네트워크를 적용합니다.

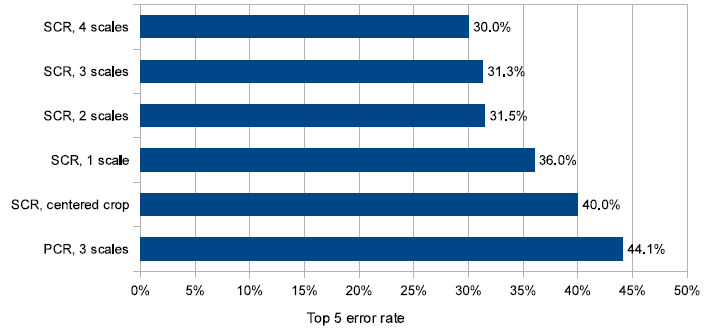

이에 대한 결과는 그림 9에 나와 있습니다.

그림 10은 2012년과 2013년 현지화 대회의 결과를 보여줍니다 (학습 및 테스트 데이터는 이 두 해 모두 동일함).

우리의 방법은 29.9% 오류로 2013년 대회에서 우승했습니다.

우리의 멀티 스케일 및 멀티 view 접근 방식은 그림 9에서 볼 수 있듯이 우수한 성능을 얻는 데 중요했습니다: 단일 중심 작물만 사용하면 회귀 네트워크가 40%의 오류율을 달성합니다.

모든 공간 위치의 회귀 예측을 두 가지 척도로 결합하여 31.5%라는 훨씬 더 나은 오류율을 달성했습니다.

세 번째 및 네 번째 척도를 추가하면 성능이 30.0% 오류로 더욱 향상됩니다.

각 클래스에 대해 회귀 네트워크의 각 클래스에 대해 다른 최상위 계층을 사용하는 경우 (그림 9의 PCR (Per-Class Regressor))는 놀랍게도 모든 클래스 (44.1% vs. 31.3%)에서 공유되는 단일 네트워크만 사용했을 때 성능을 능가하지 못했습니다.

이는 훈련 세트에 경계 상자로 주석이 달린 클래스 당 예제가 상대적으로 적고 네트워크에 최상위 계층 매개 변수가 1000배 더 많아서 훈련이 불충분하기 때문일 수 있습니다.

이 접근 방식은 유사한 클래스간에만 매개 변수를 공유함으로써 개선될 수 있습니다 (예 : 모든 클래스의 개에 대해 하나의 네트워크, 차량에 대해 다른 네트워크 훈련 등).

5. Detection

탐지 훈련은 분류 훈련과 유사하지만 공간적 방식입니다.

이미지의 여러 위치를 동시에 학습할 수 있습니다.

모델이 컨볼루션이므로 모든 가중치가 모든 위치에서 공유됩니다.

지역화 작업과의 주요 차이점은 개체가 없을 때 백그라운드 클래스를 예측해야 한다는 것입니다.

전통적으로 부정적인 예는 처음에는 훈련을 위해 무작위로 취해집니다.

그런 다음 가장 문제가 되는 부정적 오류가 부트스트래핑 패스의 학습 세트에 추가됩니다.

독립적인 부트스트랩 패스는 훈련을 복잡하게 만들고 부정적인 예제 수집과 훈련 시간 사이의 잠재적인 불일치를 위험에 빠뜨립니다.

또한 훈련이 작은 세트에 과도하게 맞지 않도록 부트스트랩 패스의 크기를 조정해야합니다.

이러한 모든 문제를 피하기 위해 무작위 이미지 또는 가장 불쾌한 이미지와 같이 이미지 당 몇 가지 흥미로운 부정적인 예제를 선택하여 즉석에서 부정적인 훈련을 수행합니다.

이 접근 방식은 계산 비용이 더 많이 들지만 절차를 훨씬 더 간단하게 만듭니다.

그리고 특징 추출은 처음에 분류 작업으로 훈련되었기 때문에 탐지 미세 조정은 어쨌든 길지 않습니다.

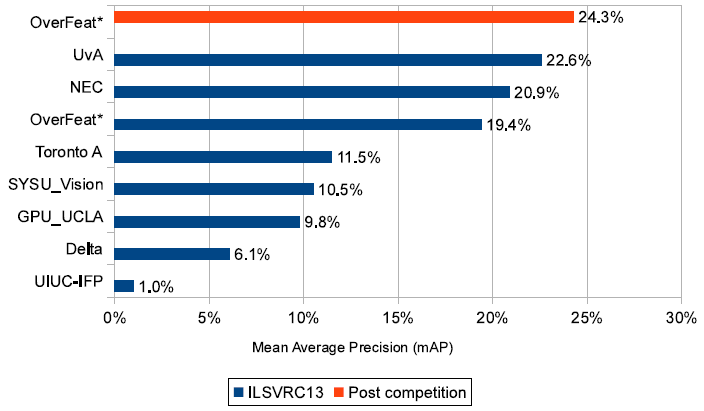

그림 11에서는 탐지 시스템이 mean Average Precision (mAP) 19.4%로 3위를 차지한 ILSVRC 2013 대회 결과를 보고합니다.

우리는 나중에 24.3% mAP로 새로운 탐지 상태를 확립했습니다.

상위 3개 방법과 다른 팀 간에 큰 차이가 있습니다 (4번째 방법은 11.5% mAP를 산출합니다).

또한 우리의 접근 방식은 초기 세분화 단계를 사용하여 후보 창을 약 200,000에서 2,000으로 줄이는 상위 2개 시스템과 상당히 다릅니다.

이 기술은 추론 속도를 높이고 잠재적인 오탐지 수를 크게 줄입니다.

[29, 1]은 예상치 못한 물체 위치를 버리고 오탐을 줄이는 선택적 검색과는 반대로 조밀한 슬라이딩 윈도우를 사용할 때 탐지 정확도가 떨어집니다.

우리의 방법과 결합하면 여기에서 볼 수 있듯이 기존의 고밀도 방법과 세분화 기반 방법간에 유사한 개선 사항을 관찰할 수 있습니다.

또한 NEC 및 UvA가 수행한 것처럼 탐지 검증 세트를 미세 조정하지 않았습니다.

검증 및 테스트 세트 분포는 학습 세트와 상당히 다르므로 이것만으로도 결과가 약 1포인트 향상됩니다.

그림 11의 두 OverFeat 결과 간의 개선은 더 긴 훈련 시간과 컨텍스트 사용 때문입니다. 즉, 각 스케일은 입력으로 더 낮은 해상도 스케일도 사용합니다.

6. Discussion

분류, 위치 파악 및 감지에 사용할 수 있는 다중 스케일, 슬라이딩 윈도우 접근 방식을 제시했습니다.

ILSVRC 2013 datasets에 적용했으며 현재 분류 4위, 현지화 1위, 탐지 1위를 기록하고 있습니다.

이 논문의 두 번째 중요한 공헌은 ConvNet을 탐지 및 현지화 작업에 효과적으로 사용할 수 있는 방법을 설명하는 것입니다.

이러한 문제는 [15]에서 다루지 않았으므로 ImageNet 2012의 맥락에서 이것이 어떻게 수행될 수 있는지를 최초로 설명했습니다.

우리가 제안하는 계획은 분류를 위해 설계된 네트워크에 대한 상당한 수정을 포함하지만 ConvNet이 이러한 더 어려운 작업을 수행할 수 있음을 분명히 보여줍니다.

우리의 현지화 접근 방식은 2013 ILSVRC 대회에서 우승했으며 모든 2012 및 2013 접근 방식을 훨씬 능가했습니다.

탐지 모델은 대회 기간 동안 최고의 성과를 거두었으며 대회 후 결과에서 1위를 차지했습니다.

픽셀에서 직접 학습한 공통 특징 추출 기반을 공유하면서 다양한 작업을 수행할 수 있는 통합 파이프 라인을 제안했습니다.

우리의 접근 방식은 여전히 여러 가지 방법으로 개선될 수 있습니다.

(i) 현지화를 위해 현재 전체 네트워크를 통해 지원되지 않습니다; 이렇게 하면 성능이 향상될 수 있습니다.

(ii) 우리는 성능이 측정되는 교차 결합 (IOU) 기준을 직접 최적화하기 보다는 ℓ2 손실을 사용하고 있습니다.

겹치는 부분이 있는 경우 IOU를 여전히 구별할 수 있으므로 손실을 이것으로 바꿀 수 있어야 합니다.

(iii) 경계 상자의 대체 매개 변수화는 출력을 상호 연관시키는 데 도움이 될 수 있으며, 이는 네트워크 훈련에 도움이 될 것입니다.

'Computer Vision' 카테고리의 다른 글

| Mask R-CNN (번역) (0) | 2021.03.02 |

|---|---|

| SPPnet: Spatial Pyramid Pooling in Deep Convolutional Networks for Visual Recognition (번역) (0) | 2021.02.26 |

| Faster R-CNN: Towards Real-Time Object Detection with Region Proposal Networks (번역) (0) | 2021.02.25 |

| Fast R-CNN (번역) (1) | 2021.02.24 |

| R-CNN, Rich feature hierarchies for accurate object detection and semantic segmentation (번역) (1) | 2021.02.22 |