2022. 3. 22. 17:07ㆍ3D Object Detection

DeepFusion: Lidar-Camera Deep Fusion for Multi-Modal 3D Object Detection

Yingwei Li, Adams Wei Yu, Tianjian Meng, Ben Caine, Jiquan Ngiam, Daiyi Peng, Junyang Shen, Bo Wu, Yifeng Lu2, Denny Zhou, Quoc V. Le, Alan Yuille, Mingxing Tan

Abstract

라이다와 카메라는 자율주행 시 3D 감지를 위한 보완 정보를 제공하는 중요 센서입니다.

일반적인 멀티모달 방식[34, 36]은 원시 라이다 포인트 클라우드를 카메라 피쳐로로 장식하여 기존 3D 검출 모델에 직접 제공하지만, 본 연구에서는 원시 포인트 대신 깊이 있는 라이다 피쳐와 카메라 피쳐를 융합하면 성능이 향상될 수 있음을 보여줍니다.

그러나 이러한 피쳐가 종종 강화되고 통합되기 때문에 퓨전 시 중요한 과제는 두 가지 모달리티에서 변환된 피쳐를 효과적으로 정렬하는 방법입니다.

본 논문에서는 두 가지 새로운 기법을 제안한다: InverseAug는 회전과 같은 기하학적 관련 증대를 반전시켜 라이다 포인트와 이미지 픽셀 간의 정확한 기하학적 정렬을 가능하게 합니다, 그리고 LearnableAlign은 교차 주의를 활용하여 퓨전 중에 이미지와 라이다 피쳐 간의 상관 관계를 동적으로 캡처합니다.

InverseAug 및 LearnableAlign을 기반으로 DeepFusion이라는 일반 멀티모달 3D 검출 모델 패밀리를 개발하여 기존 방법보다 정확도가 향상되었습니다.

예를 들어 DeepFusion을 사용하면 보행자 검출에 대한 PointPillars, CenterPoint 및 3D-MAN 기준선이 각각 6.7, 8.9 및 6.2 LEVEL 2 APH에 대해 향상됩니다.

특히, 당사의 모델은 Waymo Open Dataset에서 최첨단 성능을 달성하고 입력 손상 및 분산되지 않은 데이터에 대한 강력한 모델 견고성을 보여줍니다.

1. Introduction

라이더와 카메라는 자율주행을 위한 두 가지 보완 센서다.

3D 물체 탐지를 위해 라이더는 저해상도 모양 및 깊이 정보를 제공하는 반면 카메라는 고해상도 모양 및 텍스처 정보를 제공합니다.

두 센서의 조합이 최상의 3D 물체 감지기를 제공할 것으로 예상되지만, 대부분의 최첨단 3D 물체 감지기는 입력으로 라이더만 사용하는 것으로 밝혀졌다(Waymo Challenge Leaderboard, 2021년 10월 14일 액세스).

이는 이 두 센서의 신호를 효과적으로 융합하는 방법이 여전히 어렵다는 것을 나타냅니다.

이 문서에서는, 이 문제에 대한 범용적이고 효과적인 솔루션을 제공하기 위해 노력하고 있습니다.

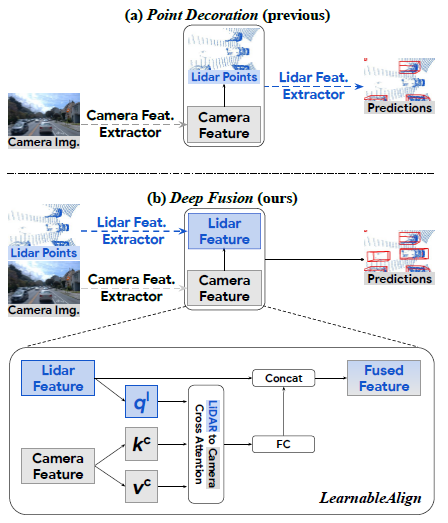

라이다와 카메라를 융합하기 위한 문헌의 기존 접근 방식은 크게 두 가지 접근 방식을 따른다(그림 1): 라이다 포인트 클라우드의 점을 해당 카메라 피쳐와 장식하는 등 초기에 피쳐를 융합하거나 피쳐 추출 후 피쳐가 결합되는 중간 수준의 융합을 사용한다. [13, 17].

두 가지 접근 방식 모두에서 가장 큰 어려움 중 하나는 라이다와 카메라 피쳐 간의 대응 관계를 파악하는 것입니다.

이 문제에 대처하기 위해 다음 두 가지 방법을 제안합니다: InverseAug 및 LearnableAlign을 통해 미드레벨의 효과적인 융합을 실현합니다.

InverseAug는 기하학 관련 데이터 증가(예: RandomRotation [46])를 반전시킨 다음 원래 카메라와 라이다 매개변수를 사용하여 두 가지 양식을 연결합니다.

LearnableAlign은 교차 주의를 활용하여 라이다 피쳐와 해당 카메라 피쳐 간의 상관 관계를 동적으로 학습합니다.

이 두 가지 제안된 기술은 단순하고 일반적이며 효율적입니다.

Point-Pillars [16] 및 CenterPoint [44]와 같은 인기 있는 3D 포인트 클라우드 감지 프레임워크에서 InverseAug 및 LearnableAlign은 한계 계산 비용으로 카메라 이미지를 라이다 포인트 클라우드와 효과적으로 정렬할 수 있도록 지원합니다(즉, 하나의 교차 주의 레이어만).

정렬된 멀티모달 기능을 융합할 때 카메라 신호가 훨씬 더 높은 해상도로 모델의 인식 및 현지화 능력을 크게 향상시킵니다.

이러한 장점은 장거리 물체 탐지에 특히 유용합니다.

우리는 DeepFusions라는 이름의 멀티모달 3D 검출 모델군을 개발했습니다, 이 모델들은 (1) 엔드 투 엔드로 학습될 수 있고 (2) 기존의 많은 복셀 기반 3D 검출 방법과 호환되는 일반적인 구성 요소들이라는 장점을 제공합니다.

DeepFusion은 PointPillars [16] 및 CenterPoint [44]와 같은 대부분의 복셀 기반 3D 검출 방법에 쉽게 적용할 수 있는 플러그인 역할을 합니다.

광범위한 실험을 통해 (1) 효과적인 딥 피처 얼라인먼트가 멀티모달 3D 객체 검출의 핵심이며 (2) 제안된 InverseAug 및 LearnableAlign을 통해 얼라인먼트의 품질을 향상시킴으로써 DeepFusion은 검출 정확도를 크게 향상시킵니다, 그리고 (3) DeepFusion은 단일 모달 기준과 비교하여 입력 손상 및 분산되지 않은 데이터에 대해 더욱 견고합니다.

Waymo Open Dataset에서 DeepFusion은 PointPillars[16], CenterPoints[44] 및 3D-MAN[43]과 같은 몇 가지 일반적인 3D 탐지 모델을 각각 6.7, 8.9 및 6.2 LEVEL 2 APH 향상시킵니다.

DeepFusion이 검증 세트에서 이전의 최고의 멀티모달 방식인 PointAugmenting [36]보다 7.4 보행자 LEVEL 2 APH를 향상시킨 Waymo Open Dataset의 최신 결과를 달성했습니다.

이 결과는 우리의 방법이 라이다와 카메라 양식을 효과적으로 결합할 수 있다는 것을 보여주며, 장거리 물체의 인식과 위치 파악을 통해 가장 큰 개선이 이루어졌다.

우리의 기여는 세 가지로 요약할 수 있다.

• 우리가 아는 한, 우리는 3D 멀티 모달리티 검출기에 대한 딥 피처 얼라인먼트의 영향을 체계적으로 연구한 최초의 기업이다.

• 깊은 피처 레벨의 정렬을 실현하여 정확하고 견고한 3D 물체 검출기를 실현하기 위해 InverseAug와 LearnableAlign을 제안한다.

• 제안 모델인 DeepFusions는 Waymo Open Dataset에서 최첨단 성능을 제공합니다.

2. Related Work

3D Object Detection on Point Clouds.

라이다 포인트 클라우드는 종종 순서가 매겨지지 않은 집합으로 표시되며, 많은 3D 객체 탐지 방법은 이러한 순서가 매겨지지 않은 원시 포인트를 직접 처리하는 경향이 있습니다.

PointNet [25]와 PointNet++ [26]은 포인트 클라우드에 직접 신경망을 적용한 초기 작품입니다.

그 후 [22, 24, 31, 42]는 PointNet과 같은 [25]레이어로 피쳐를 학습합니다.

라이다 포인트 클라우드는 조밀 범위 영상으로도 표현될 수 있으며, 각 픽셀에는 추가 depth 정보가 포함됩니다.

[1, 18]은(는) 범위 영상에서 직접 작동하여 3D 바운딩 박스를 예측합니다.

또 다른 3D 검출 방법은 라이다 포인트를 복셀 또는 필러로 변환하여 일반적으로 사용되는 복셀 기반 및 필러 기반 두 가지 3D 검출 방법으로 이어집니다.

VoxelNet [46]은 각 하위 공간을 복셀이라고 하는 3D 그리드로 포인트 클라우드를 이산화하는 복셀 기반 접근 방식을 제안한다.

그런 다음 고밀도 3D 컨볼루션 네트워크를 이 그리드에 적용하여 탐지 기능을 학습할 수 있습니다.

SECOND [40]는 VoxelNet을 기반으로 구축되며 효율성을 높이기 위해 희박한 3D 컨볼루션 사용을 제안합니다.

3D 복셀은 처리 비용이 많이 들기 때문에 PointPillars[16] 및 PIXOR[41]는 3D 복셀을 bird-eye-view 2D 필러로 단순화하며, 여기서 z축이 동일한 모든 복셀은 하나의 필러로 접힙니다.

그런 다음 이러한 2D 필러를 기존의 2D 컨볼루션 감지 네트워크로 처리하여 bird-eye-view 바운딩 박스를 제작할 수 있습니다.

2D 필러는 일반적으로 쉽고 빠르게 처리되기 때문에 최근 많은 3D 검출 방법[34, 38, 43, 44]이 PointPillars를 기반으로 구축되었습니다.

또한 이 논문에서는 라이다 포인트 클라우드를 다루기 위한 기본 접근법으로 PointPillar를 선택합니다.

Lidar-camera Fusion.

단안 탐지 접근법은 라이다 포인트 클라우드에 의존하는 대신 2D 영상에서 3D 박스를 직접 예측합니다[3,15,27].

이러한 접근법의 핵심 과제는 2D 영상에 depth 정보가 없다는 것이다, 따라서 대부분의 단안 검출기는 각 2D 영상 픽셀에 대한 depth를 암묵적으로 또는 명시적으로 예측해야 하며, 이는 종종 매우 어려운 또 다른 작업이다.

최근에는 3D 감지를 개선하기 위해 라이다와 카메라 데이터를 결합하는 추세입니다.

일부 접근 방식[24, 39]에서는 먼저 2D 영상에서 객체를 감지한 다음 이 정보를 사용하여 포인트 클라우드를 추가로 처리합니다.

전작 [4, 14]도 2단계 프레임워크를 사용하여 객체 중심 모달리티 퓨전을 수행한다.

이러한 방법과는 달리, 우리의 접근 방식은 대부분의 기존 복셀 기반 3D 감지 방법에 더 쉽게 플러그인할 수 있다.

Point Decoration Fusion.

PointPainting [34]는 사전 학습된 시맨틱 세그멘테이션 네트워크로 추출된 카메라 이미지의 시맨틱 스코어로 각 라이다 포인트를 증가시킬 것을 제안한다.

PointAugmenting [36]은 시맨틱 스코어의 한계를 지적하고 카메라 이미지 위에 2D 객체 검출 네트워크로부터 추출된 딥 피쳐로 라이다 포인트를 증강할 것을 제안한다.

그림 1 (a)에서 보듯이, 이러한 방법은 카메라 이미지에서 피쳐를 추출하기 위해 사전 학습을 받은 모듈(예: 2D 검출 또는 분할 모델)에 의존하며, 카메라 이미지에서 피쳐를 추출한 다음 라이다 특징 복셀라이저에 공급하여 bird-eye-view pseudo 이미지를 구성합니다.

Mid-level Fusion.

Deep Continuous Fusion [17], EPNet [13] 및 4D-Net [23]은 2D 및 3D 백본 간에 정보를 공유하여 두 모달리티를 결합하려고 합니다.

그러나 이러한 작업에서 누락된 중요한 부분은 카메라와 라이다 피쳐 간의 효과적인 정렬 메커니즘이며, 이는 효과적인 엔드 투 엔드 멀티 모달 3D 물체 감지기를 구축하는 데 핵심으로 우리의 실험에서 확인되었다.

효과적인 얼라인먼트의 중요성을 알면서도 다음과 같은 이유로 얼라인먼트를 실시하는 것은 어렵다고 지적합니다.

첫째, 기존 벤치마크(예: Waymo Open Dataset)에서 최고의 성능을 달성하기 위해 퓨전 단계 이전의 라이다 포인트와 카메라 이미지에 다양한 데이터 증강 전략을 적용합니다.

예를 들어, z축을 따라 3D 세계를 회전시키는 RandomRotation [46]은 일반적으로 라이다 포인트에는 적용되지만 카메라 이미지에는 적용되지 않으므로 이후 피쳐 정렬이 어렵습니다.

둘째, 여러 개의 라이다 포인트가 동일한 3D 큐브(즉, 장면에서 복셀)로 집계되기 때문에, 한 복셀은 다수의 카메라 피쳐에 해당하며, 이러한 카메라 피쳐는 3D 검출에 동등하게 중요하지 않습니다.

3. DeepFusion

섹션 3.1에서는 먼저 심층 기능 퓨전 파이프라인을 소개합니다.

그런 다음 섹션 3.2에서 심층 기능 융합을 위한 정렬의 중요성을 정량적으로 설명하기 위해 일련의 예비 실험을 실시한다.

마지막으로 섹션 3.3의 정렬 품질을 개선하기 위해 InverseAug와 LearnableAlign이라는 두 가지 기술을 제안합니다.

3.1. Deep Feature Fusion Pipeline

그림 1 (a)에서 볼 수 있듯이, PointPainting [34] 및 PointAugmenting [36]과 같은 이전 방법에서는 일반적으로 카메라 피쳐 추출기로서 특별히 잘 훈련된 검출 또는 분할 모델을 사용합니다.

예를 들어 PointPainting은 Deeplabv3+를 사용하여 픽셀당 분할 라벨을 카메라 피쳐로 생성합니다[34].

다음으로 추출된 카메라 피쳐로 원시 라이다 포인트를 장식한다.

마지막으로 카메라 피쳐에 의해 장식된 라이다 포인트를 3D 포인트 클라우드 물체 검출 프레임워크에 공급한다.

위의 파이프라인은 다음과 같은 이유로 개선될 수 있습니다.

우선 카메라 피쳐는 포인트 클라우드 데이터 처리를 위해 특별히 설계된 여러 모듈에 공급됩니다.

예를 들어 PointPillars[16]를 3D 검출 프레임워크로 채택한 경우 카메라 피쳐를 원시 포인트 클라우드와 함께 복셀화하여 bird's-eye-view pseudo 이미지를 생성해야 합니다.

그러나 복셀화 모듈은 카메라 정보를 처리하도록 설계되지 않았습니다.

둘째, 카메라 피쳐 추출기는 다른 독립적인 작업(즉, 2D 감지 또는 분할)에서 학습되며, 이는 (1) 도메인 갭, (2) 주석 작업, (3) 추가 계산 비용, 그리고 더 중요한 것은 (4) 추출된 피쳐가 엔드 투 엔드의 방식으로 학습되는 것이 아니라 경험적으로 선택되기 때문에 차선의 추출된 피쳐로 이어질 수 있다.

위의 두 가지 문제에 대처하기 위해 우리는 심층 피쳐 융합 파이프라인을 제안한다.

첫 번째 문제를 해결하기 위해 카메라 신호가 포인트 클라우드용으로 설계된 모듈을 통과하지 않도록 입력 수준에서 원시 라이다 포인트를 장식하는 대신 심층 카메라와 라이다 피쳐를 통합합니다.

두 번째 문제에서는 컨볼루션 레이어를 사용하여 카메라 피쳐를 추출하고 이러한 컨볼루션 레이어를 네트워크의 다른 컴포넌트와 함께 엔드 투 엔드로 학습합니다.

요약하면, 우리가 제안하는 심층 피쳐 퓨전 파이프라인을 그림 1(b)에 나타냅니다: 라이다 포인트 클라우드를 기존 라이다 피쳐 추출기(예: PointPillars[16]의 필러 피쳐망)로 공급하여 라이다 피쳐(예: PointPillars[16]의 pseudo 이미지)를 얻는다; 카메라 영상을 2D 영상 피쳐 추출기(예: ResNet [10])에 공급하여 카메라 피쳐를 얻습니다; 그런 다음 카메라 피쳐가 라이다 피쳐에 결합됩니다; 마지막으로, 퓨전 피쳐는 검출 결과를 얻기 위해 선택된 라이다 검출 프레임워크의 나머지 성분(예: Point-pillars [16]로부터의 Backbone 및 Detection Head)에 의해 처리된다.

이전 설계와 달리 이 방법에는 두 가지 이점이 있습니다: (1) 풍부한 컨텍스트 정보를 가진 고해상도 카메라 피쳐를 잘못 복셀화한 후 투시 뷰에서 조감도 뷰로 변환할 필요가 없습니다; (2) 도메인 갭 및 주석 문제가 완화되고 엔드 투 엔드 훈련으로 더 나은 카메라 피쳐를 얻을 수 있습니다.

단, 입력 레벨의 장식에 비해 카메라의 피쳐를 라이다 신호에 맞추는 것은 상세 피쳐 레벨에서는 간단하지 않다는 단점도 있습니다.

예를 들어, 두 가지 모달리티에 대한 이질적인 데이터 증대에 의해 야기된 부정확한 정렬은 융합 단계에 잠재적인 문제를 일으킬 수 있다.

섹션 3.2에서는 오정렬이 검출 모델에 실제로 해를 끼칠 수 있는지 확인하고 섹션 3.3의 솔루션을 제공한다.

3.2. Impact of Alignment Quality

심층 피쳐 융합에 대한 정렬의 영향을 정량적으로 평가하기 위해 다른 모든 데이터 증강은 비활성화하지만 학습 중에는 심층 융합 파이프라인의 라이다 포인트 클라우드에 RandomRotation [46]의 크기만 비틀어 놓습니다.

실험 설정에 대한 자세한 내용은 보충 자료를 참조하십시오.

라이다 포인트 클라우드만 증강하고 카메라 이미지는 변경하지 않으므로 지오메트리 관련 데이터 확대가 강하면 정렬 상태가 나빠집니다.

표 1과 같이 다중 모드 융합의 이점은 회전 각도가 커짐에 따라 감소한다.

예를 들어, 증대를 적용하지 않은 경우(최대 회전 = 0˚), 개선은 가장 유의한(+2.6 AP), 최대 회전 수가 45˚일 경우 +0.4 AP 게인만 관찰됩니다.

이러한 관찰을 바탕으로 정렬이 정확하지 않으면 카메라 입력의 이점이 거의 없는 심층 피쳐 융합에 매우 중요하다는 결론을 내렸습니다.

3.3. Boosting Alignment Quality

심층 피쳐 정렬의 중요성에 따라 두 가지 모달리티에서 심층 피쳐를 효과적으로 정렬하기 위해 InverseAug와 LearnableAlign이라는 두 가지 기술을 제안합니다.

InverseAug.

기존 벤치마크에서 최고의 성능을 달성하려면 대부분의 방법이 강력한 데이터 증강을 필요로 합니다, 학습은 대개 과적합 시나리오에 빠지기 때문입니다.

데이터 증강의 중요성은 표 1에서 확인할 수 있습니다, 표 1에서는 단일 모델의 경우 정확도가 최대 5.0까지 향상될 수 있습니다.

게다가, Cheng et al. [5] 에서는 3D 객체 검출 모델을 학습하기 위한 데이터 증강의 중요성을 제안합니다.

그러나 데이터 증강의 필요성은 DeepFusion 파이프라인에서 사소한 문제가 아닙니다.

특히, 두 가지 모달리티의 데이터는 일반적으로 서로 다른 증강 전략(예: 2D 영상의 무작위 플립과 결합된 3D 포인트 클라우드의 z축을 따라 회전)으로 증강되므로 정렬이 어렵습니다.

기하학 관련 데이터 증강으로 인한 정렬 문제를 해결하기 위해 InverseAug를 제안한다.

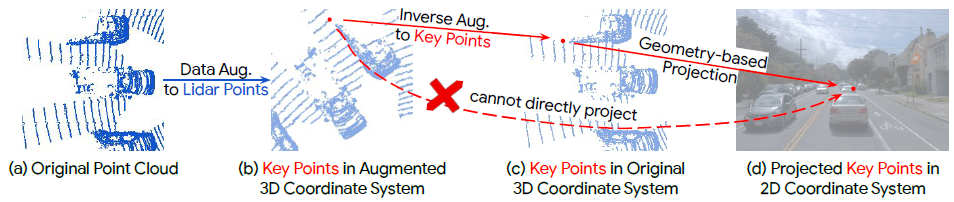

그림 2와 같이 포인트 클라우드에 데이터 증대를 적용한 후, 증강된 공간에서 3D 키포인트(라이다 포인트, 복셀 센터 등 임의의 3D 좌표일 수 있음)가 주어지면 원래 라이다와 카메라 파라미터만으로는 2D 공간에서 해당 카메라 피쳐를 찾을 수 없습니다.

현지화를 실현 가능하게 하기 위해 InverseAug는 형상 관련 데이터 증강을 적용할 때 먼저 증강 매개변수(예: RandomRotate [46]의 회전 정도)를 저장합니다.

융합 단계에서는 이러한 모든 데이터 증대를 반전시켜 3D 키 포인트의 원래 좌표(그림 2(c))를 얻은 다음 카메라 공간에서 해당 2D 좌표를 찾습니다.

우리의 방법은 단순성을 위해 그림 2의 라이다 포인트만 채택하지만 다른 유형의 핵심 포인트(예: 복셀 센터)를 정렬할 수 있기 때문에 일반적이며 두 가지 양식이 모두 증강되는 상황도 처리할 수 있다.

이와는 대조적으로 PointAugmenting [36]과 같은 기존 퓨전 방식에서는 데이터를 증가하기 전에만 처리할 수 있습니다.

마지막으로 그림 3(b)에서 InverseAug에 의한 얼라인먼트 품질 개선 예를 제시합니다.

Learnable Align.

PointPainting [34] 및 PointAugmenting [36]과 같은 입력 수준 장식 방법의 경우 3D 라이다 포인트가 지정되면 일대일 매핑이 있으므로 해당 카메라 픽셀만 정확히 배치할 수 있습니다.

이와는 대조적으로 DeepFusion 파이프라인에서 심층 피쳐를 융합할 경우 각 라이다 피쳐는 포인트의 서브셋을 포함하는 복셀을 나타내므로 대응하는 카메라 픽셀은 폴리곤에 있습니다.

따라서 정렬은 일 복셀 대 다 픽셀의 문제가 됩니다.

순진한 접근법은 주어진 복셀에 대응하는 모든 픽셀에 대해 평균을 내는 것입니다.

그러나 직관적으로, 그리고 우리가 시각화한 결과에 의해 뒷받침되듯이, 이 픽셀들은 라이다 심층 피쳐로부터의 정보가 모든 카메라 픽셀과 균일하게 일치하기 때문에 똑같이 중요하지 않습니다.

예를 들어, 일부 픽셀은 검출 대상 물체와 같은 검출을 위한 중요한 정보를 포함할 수 있으며, 다른 픽셀은 도로, 식물, 폐색기 등의 배경으로 구성되어 있어 정보가 부족할 수 있습니다.

라이다 피쳐의 정보를 가장 관련성이 높은 카메라 피쳐와 더 잘 맞추기 위해 그림 1과 같이 교차 주의 메커니즘을 활용하여 두 양식 간의 상관 관계를 동적으로 캡처하는 LearnableAlign을 소개합니다.

특히 입력에는 복셀 셀과 그에 대응하는 모든 N 카메라 피쳐가 포함됩니다.

LearnableAlign은 완전히 연결된 3개의 레이어를 사용하여 각각 복셀을 쿼리 q^l로 변환하고 카메라 피쳐를 키 k^c 및 값 v^c로 변환합니다.

각 쿼리(즉, 복셀 셀)에 대해, 우리는 복셀과 모든 해당 N 카메라 피쳐 사이에 1 x N 상관 관계를 포함하는 주의 선호도 매트릭스를 얻기 위해 쿼리와 키 사이에서 내부 곱을 수행한다.

다음으로 softmax 연산자에 의해 정규화된 어텐션 어피니티 매트릭스를 사용하여 카메라 정보를 포함한 값 v^c를 가중치 및 집계한다.

집약된 카메라 정보는 완전히 연결된 레이어에 의해 처리되며, 최종적으로 원래의 라이다 피쳐와 연결됩니다.

마지막으로 모델 학습을 위해 PointPillars 또는 CenterPoint와 같은 표준 3D 검출 프레임워크에 출력이 입력됩니다.

4. Experiments

5. Conclusion

이 논문은 다중 모달 3D 물체 탐지를 위해 라이다와 카메라 데이터를 효과적으로 융합하는 방법을 연구합니다.

본 연구에서는 후기의 심층 기능 융합이 잘 정렬될 때 더 효과적일 수 있지만, 다른 모달리티의 두 심층 기능을 정렬하는 것은 어렵다.

이 과제를 해결하기 위해 멀티모달 피쳐 간의 효과적인 정렬을 위해 InverseAug와 LearnableAlign이라는 두 가지 기술을 제안합니다.

이러한 기술을 기반으로 DeepFusions라는 이름의 단순하고 일반적이지만 효과적인 다중 모달 3D 검출기 제품군을 개발하여 Waymo Open Dataset에서 최첨단 성능을 달성합니다.

'3D Object Detection' 카테고리의 다른 글

| Center-based 3D Object Detection and Tracking (0) | 2022.04.06 |

|---|---|

| PointPillars: Fast Encoders for Object Detection from Point Clouds (0) | 2022.03.31 |