2024. 10. 11. 17:38ㆍ3D Vision/NeRF with Real-World

NeRF On-the-go: Exploiting Uncertainty for Distractor-free NeRFs in the Wild

Weining Ren, Zihan Zhu, Boyang Sun, Jiaqi Chen, Marc Pollefeys, Songyou Peng

Abstract

Neural Radiance Fields (NeRFs)는 정적 장면의 멀티뷰 이미지에서 사진사실적인 뷰를 합성하는 데 놀라운 성공을 보여주었지만 움직이는 물체, 그림자 및 조명 변화와 같은 distractors가 있는 동적인 실제 환경에서는 어려움을 겪고 있습니다.

기존 방법은 제어된 환경과 낮은 폐색 비율을 관리하지만 특히 높은 폐색 시나리오에서는 렌더링 품질에 미치지 못합니다.

이 논문에서는 자연스럽게 캡처된 이미지 시퀀스에서만 복잡하고 실제 장면에서 새로운 뷰를 robust 합성할 수 있는 간단하면서도 효과적인 접근 방식인 NeRF On-the-go를 소개합니다.

불확실성을 파고들어, 우리의 방법은 캡처가 우세한 경우에도 distractors를 효율적으로 제거할 뿐만 아니라 현저하게 빠른 수렴 속도를 달성합니다.

다양한 장면에 대한 포괄적인 실험을 통해 우리의 방법은 SOTA 기술에 비해 상당한 개선을 보여줍니다.

이러한 발전은 다양하고 동적인 실제 애플리케이션에서 NeRF를 위한 새로운 길을 열어줍니다.

1. Introduction

Novel View Synthesis (NVS)은 이전에 관찰되지 않은 관점에서 장면을 렌더링하는 문제를 다룹니다.

Neural radiance fields (NeRFs) [30]은 이 작업의 획기적인 패러다임으로 부상했습니다.

이는 NeRF가 얇은 구조와 반투명 물체가 있는 복잡한 시나리오에서도 지오메트릭 일관되고 사실적인 렌더링을 생성할 수 있기 때문입니다.

NeRF 모델을 학습하려면 주어진 카메라 포즈가 포함된 RGB 이미지 세트가 필요하며 초점 거리, 노출 및 화이트 밸런스와 같은 카메라 설정을 수동으로 조정해야 합니다.

더 중요한 것은 vanilla NeRF는 움직이는 물체, 그림자 또는 기타 동적 요소와 같은 distractors 없이 캡처 프로세스 동안 장면이 완전히 정적인 상태로 유지되어야 한다는 가정 하에서 작동합니다 [39].

그럼에도 불구하고 실제 세계는 본질적으로 동적이므로 이러한 distractor-free 요구 사항은 종종 비현실적입니다.

또한 캡처된 데이터에서 distractor를 제거하는 것은 쉬운 일이 아닙니다.

이 프로세스에는 각 이미지에 대한 픽셀당 주석이 포함되며, 이는 특히 대규모 장면의 장시간 캡처에 매우 노동 집약적인 절차입니다.

이는 동적 실제 환경에서 NeRF를 실제로 적용하는 데 있어 핵심적인 한계를 강조합니다.

최근 여러 연구 [26, 38, 46, 52]가 이러한 문제를 해결하려고 시도했습니다.

[38]과 [46]은 특정 이동 객체에 대해 사전 학습된 시맨틱 세그멘테이션 모델을 사용하지만 모델은 정의되지 않은 객체 클래스를 세그멘트하지 못합니다.

NeRF-W [26]는 볼륨 렌더링을 통해 랜덤으로 초기화된 임베딩에서 픽셀 단위의 불확실성을 최적화합니다.

이러한 설계는 이미지의 prior 정보를 무시하고 불확실성을 래디언스 필드 재구성과 얽히게 하기 때문에 차선책입니다.

결과적으로, 그들은 distractor를 설명하기 위해 transient 임베딩을 도입해야 합니다.

새로운 자유도를 추가하면 시스템 튜닝이 복잡해져 [39]에서 논의된 바와 같이 Pareto-optimal 시나리오로 이어집니다.

D^2NeRF [52]와 같은 동적 NeRF 방법은 비디오 입력을 위해 정적 및 동적 장면을 분해할 수 있지만 희소한 이미지 입력으로는 성능이 떨어집니다.

보다 최근에는 RobustNeRF [39]가 distractors를 이상치로 모델링하고 제어되고 간단한 시나리오에서 인상적인 결과를 보여줍니다.

그럼에도 불구하고 복잡한 야생 장면에서는 성능이 크게 떨어집니다.

흥미롭게도 RobustNeRF는 distractors가 없는 시나리오에서도 성능이 떨어집니다.

이는 설득력 있는 연구 질문으로 이어집니다:

distractors의 비율에 관계없이 무심코 캡처한 이미지에서 야생 장면을 위한 NeRF를 구축할 수 있습니까?

이 목표를 위해 효과적인 distractor 제거를 위해 설계된 다용도 플러그 앤 플레이 모듈인 NeRF On-the-go를 소개하여 무심코 캡처한 이미지에서 신속한 NeRF 학습을 가능하게 합니다.

저희의 방법은 세 가지 주요 측면에 기반을 두고 있습니다.

첫째, 저희는 피쳐 추출의 견고성과 공간-시간 일관성을 위해 DINOv2 피쳐 [33]를 활용하며, 이를 통해 작은 multi layer perceptron (MLP)이 샘플당 픽셀 불확실성을 예측합니다.

둘째, 저희의 방법은 structural similarity loss를 활용하여 불확실성 최적화를 개선하여 전경 distractors와 정적 배경 간의 구별을 향상시킵니다.

셋째, 저희는 특히 높은 폐색 장면에서 distractor 제거를 크게 향상시키는 분리된 학습 전략을 사용하여 추정된 불확실성을 NeRF의 이미지 재구성 objective에 통합합니다.

저희의 방법은 작은 물체가 있는 제한된 실내 장면에서 복잡하고 대규모의 거리 풍경 장면에 이르기까지 광범위한 시나리오에서 견고성을 입증하고 다양한 레벨의 distractors를 효과적으로 처리할 수 있습니다.

특히, 저희는 On-the-go 모듈이 RobustNeRF에 비해 NeRF 학습을 최대 1배까지 가속화할 수 있다는 것을 발견했습니다.

이러한 효율성은 최신 NeRF 프레임워크와의 직접적인 통합과 결합되어 NeRF On-the-go를 동적 실제 환경에서 NeRF 학습을 향상시키기 위한 액세스 가능하고 강력한 도구로 만듭니다.

2. Related Work

Uncertainty in Scene Reconstruction.

불확실성은 단안 depth 예측 [15, 36], 시맨틱 세그멘테이션 [17, 31], simultaneous localization ans mapping (SLAM) [6, 28, 40, 59]과 같은 광범위한 작업의 견고성과 신뢰성을 향상시키는 것으로 입증되었습니다.

일반적으로 불확실성은 두 가지 범주로 나눌 수 있습니다: epistemic 및 aleatoric [20].

장면 재구성의 특정 맥락에서, epistemic 불확실성은 일반적으로 제한된 시점과 같은 데이터 제한으로 인해 발생합니다.

예를 들어, [44]는 앙상블 학습을 활용하여 NeRF에 대한 next-best-view (NBV) 계획에서 관찰되지 않은 영역을 탐색하기 위한 epistemic 불확실성을 정량화합니다.

Goli et al. [11]은 NeRF에서 플로터를 제거하기 위한 체적 불확실성 필드를 설정합니다.

반면, aleatoric 불확실성은 장면의 측정 노이즈, 모양 변화 및 distractors와 같은 데이터의 고유한 랜덤성에서 비롯됩니다.

액티브 러닝을 위한 가이딩 원칙으로 aleatoric 불확실성을 활용하고 더 나은 NeRF 학습을 위한 NBV 계획이 있습니다 [19, 34, 37].

유사하게, DebSDF [54]는 불확실성 맵을 통해 실내 장면 재구성을 개선하여 단안 prior의 노이즈를 완화합니다.

우리와 밀접하게 관련된 NeRF-W [27]는 transient 및 외관 임베딩을 도입하여 비정형 인터넷 사진 모음에서 transient 객체를 제거하고 가변 조명을 해결하기 위해 개척했습니다.

Ha-NeRF [5]와 같은 후속 작업은 제약이 없는 관광 이미지에서 NeRF를 환각하는 반면, Neural Scene Chronology [25]는 시간 스탬프가 있는 인터넷 사진에서 시간적으로 변화하는 연대기를 재구성합니다.

aleatoric 불확실성에 대한 이전 공식을 기반으로, 저희는 예측된 불확실성의 품질을 향상시키는 불확실성 예측에 DINOv2 피쳐를 통합하여 혁신합니다.

최근 연구에서 Kim et al. [21]도 유사한 DINO 기반 불확실성 예측 접근 방식을 제시하지만 NeRF-W [27]를 포즈가 없는 조건에 직접 적응시킵니다.

이와 대조적으로, 저희는 무심코 캡처된 이미지 시퀀스에서 distractors 요소를 효과적으로 처리하기 위해 NeRF 학습을 개선하는 데 중점을 둡니다.

SLAM and SfM in Dynamic Scenes.

동적 장면 처리는 SLAM 및 SfM 문헌에서 수년 동안 연구되어 왔습니다.

고전적인 방법은 강력한 커널 함수 [8, 32] 또는 RANSAC [41, 42]을 가진 동적 객체와 관련된 픽셀을 제외합니다.

그러나 이러한 수작업 피쳐는 폐색 비율이 낮은 시나리오에서 효과적이지만 실제 장면에서는 어려움을 겪습니다.

이를 해결하기 위해 최근의 발전은 추가 정보를 통합했습니다.

여기에는 사전 정의된 클래스에 대한 외부 세그멘테이션 또는 감지 모듈 [60, 62-64], 광학 또는 장면 flow 활용 [2, 9, 45, 47, 61, 66], 클러스터링 및 에피폴라 라인 거리 [3, 16, 63]을 사용하는 지오메트리-기반 접근 방식이 포함됩니다.

NeRF in Dynamic Scenes.

최근의 NeRF 방법은 비디오 시퀀스 [7, 10, 23, 24, 35, 49, 52, 53]에서 정적 및 동적 구성 요소를 모두 재구성하여 임의의 타임스탬프에서 새로운 뷰 합성을 가능하게 하는 데 중점을 둡니다.

주로 비디오 입력을 위해 설계되었지만 이러한 방법은 사진 수집 시퀀스 [39]에서 성능이 떨어지는 경우가 많습니다.

또한 정적 구성 요소와 동적 구성 요소를 분리하는 데는 시간이 많이 걸릴 수 있으며 광범위한 하이퍼파라미터 튜닝이 필요합니다.

이 영역에서 주목할 만한 예는 EmerNeRF [58]이며, DINOv2 [33] 피쳐도 사용합니다.

그러나 이들은 향상된 장면 분해에 사용하는 반면, 우리는 distractors를 위한 강력한 prior 지식으로 사용합니다.

우리가 아는 한 동적 장면의 정적 장면 재구성도 타겟으로 하는 유일한 방법인 RobustNeRF는 이상치 검증을 위해 반복적으로 가중치를 재조정하는 최소 제곱을 사용합니다.

이와 비교하여 우리의 방법은 다양한 수준의 폐색을 가진 더 복잡한 장면을 처리할 수 있습니다.

3. Method

저희는 불확실성 예측을 위해 픽셀당 DINO 피쳐를 활용하는 방법을 보여주는 것으로 시작합니다 (섹션 3.1).

그 후, 저희는 NeRF에서 distractors를 제거하기 위해 불확실성을 학습하기 위한 새로운 접근 방식을 보여줍니다 (섹션 3.2).

저희는 불확실성 예측과 NeRF를 위한 분리된 최적화 체계를 추가로 소개합니다 (섹션 3.3).

마지막으로, 저희는 샘플링 방법이 distractors-free NeRF 학습에서 중요한 이유를 설명합니다 (섹션 3.4).

파이프라인에 대한 개요는 그림 2에 나와 있습니다.

3.1. Uncertainty Prediction with DINOv2 Features

저희의 주요 objective는 여러 이미지에 걸쳐 나타나는 반복적인 distractors를 효과적으로 식별하고 제거하는 것입니다.

이를 달성하기 위해 뷰 간에 공간-시간 일관성을 유지할 수 있는 것으로 나타난 DINOv2 [33] 피쳐를 활용합니다.

먼저 각 입력 RGB 이미지에 대한 DINOv2 피쳐를 추출합니다.

다음으로 이러한 피쳐는 각 픽셀에 대한 불확실성 값을 예측하기 위한 작은 MLP의 입력 역할을 합니다.

불확실성 예측의 일관성을 더욱 강화하기 위해 정규화 항을 포함합니다.

Image Feature Extraction.

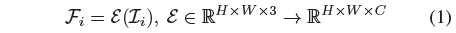

H × W 해상도의 RGB 이미지의 경우 사전 학습된 DINOv2 피쳐 추출기 E를 통해 픽셀당 피쳐를 도출합니다:

, 여기서 i는 모든 학습 이미지에 걸쳐 있고, C는 피쳐 차원을 나타냅니다.

이 모듈은 또한 가장 가까운 이웃 샘플링에 의해 피쳐 맵을 원래 해상도로 업샘플링합니다.

Uncertainty Prediction.

2D DINOv2 피처 맵을 얻은 후 각 샘플링된 ray r의 불확실성을 결정합니다.

먼저 해당 피처 f = F_i(r)를 쿼리한 다음 얕은 MLP에 입력하여 이 ray β(r) = G(f)에 대한 불확실성을 추정하고 여기서 G는 불확실성 MLP입니다.

다음 섹션에서는 특히 장면에서 distractors의 영향을 처리하고 완화하는 데 중요한 역할을 하는 가중치 함수로서 이 예측된 불확실성 β(r)가 최적화 프로세스에 어떻게 통합되는지 보여줄 것입니다.

Uncertainty Regularization.

불확실성 예측에 시공간적 일관성을 적용하기 위해 미니배치 내 피쳐 벡터의 코사인 유사성에 기반한 정규화 항을 도입합니다.

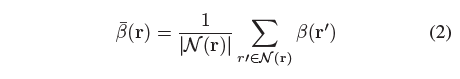

구체적으로, 각 샘플링된 ray에 대해 관련 피쳐 벡터가 r의 피쳐 f와 높은 유사성을 나타내는 동일한 배치의 ray r로 구성된 이웃 집합 N(r)을 정의합니다.

이 이웃 집합은 지정된 코사인 유사성 임계값 η를 충족하는 ray를 선택하여 형성됩니다: N(r) = {r′| cos(f , f′) > η}, 여기서 f'는 r'의 관련 피쳐입니다.

ray r에 대한 정제된 불확실성은 N(r)의 평균으로 계산됩니다:

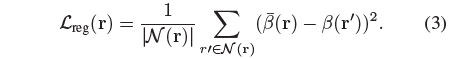

일관성을 강화하기 위해 N(r) 내의 불확실성 분산에 불이익을 주는 정규화 항을 도입합니다:

이 정규화는 이미지 간 ray에서 유사한 피쳐 전반에 걸쳐 불확실성 예측의 갑작스러운 변화를 완화하여 불확실성 추정 프로세스의 전반적인 견고성과 일관성을 향상시키는 것을 목표로 합니다.

3.2. Uncertainty for Distractor Removal in NeRF

저희는 동적 요소 (distractors)와 상관관계가 있는 픽셀은 높은 불확실성을 가져야 하는 반면 정적 영역은 낮은 불확실성을 가져야 한다고 가정합니다.

이 전제를 통해 예측된 불확실성을 NeRF 학습 objective에 효과적으로 통합할 수 있으며, 새로운 뷰 합성을 위해 distractors를 점진적으로 필터링하는 것을 목표로 합니다.

우리는 NeRF의 loss 함수에 불확실성을 통합하는 고전적인 방법의 잠재적인 문제를 분석할 것입니다.

마지막으로, 우리는 robust distractor 제거를 위해 불확실성을 통합하는 간단하면서도 효과적인 수정을 소개합니다.

Uncertainty Convergence Analysis.

불확실성 예측은 NeRF 기반의 새로운 뷰 합성을 포함한 다양한 분야에서 널리 사용되어 왔습니다.

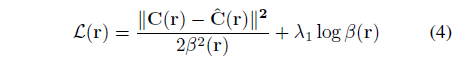

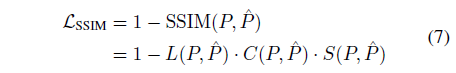

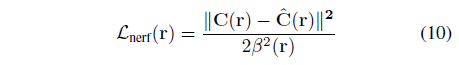

예를 들어, 중요한 작업인 NeRF in the Wild [27]에서 이들의 loss는

로 표시됩니다.

여기서 C(r) 및 ˆC(r)는 입력 및 렌더링된 RGB 값을 나타냅니다.

불확실성 β(r)는 가중치 함수로 처리됩니다.

정규화 항은 첫 번째 항의 균형을 맞추고 β(r) = ∞ 인 사소한 솔루션을 방지하는 데 중요합니다.

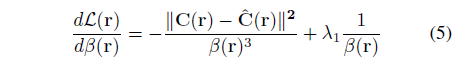

여기서는 loss 함수와 관련하여 불확실성이 어떻게 변화하는지 이해하기 위한 간단한 분석을 제시하고, 먼저 β(r)와 관련하여 편미분을 취합니다:

이 도함수를 0으로 설정하면 최적의 불확실성에 대한 폐쇄형 해를 도출합니다:

이것은 불확실성 예측과 렌더링된 색상과 입력된 색상 사이의 오차 사이의 중요한 관계를 보여줍니다.

구체적으로 최적의 불확실성은 이 오차항에 정비례합니다.

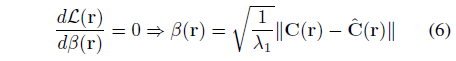

그러나 식 (4)와 같이 ℓ2 loss를 사용할 때, 특히 distractors와 배경의 색상이 가까울 때 (그림 3 (d)와 같이) 문제가 발생합니다.

이러한 경우, 해당 영역에서 예측된 불확실성도 식 (6)에 따라 낮을 것입니다.

이는 불확실성 기반 distractors 제거의 효과를 방해하고 렌더링된 이미지에서 클라우드 아티팩트로 이어집니다.

ℓ2 RGB loss에 내재된 한계를 인식하여 예측된 불확실성이 distractors와 정적 배경을 보다 효과적으로 구별할 수 있도록 더 나은 불확실성 학습을 위한 새로운 loss를 제안합니다.

SSIM-Based Loss for Enhanced Uncertainty Learning.

structural similarity index (SSIM)는 세 가지 측정으로 구성됩니다: 휘도, 대비 및 구조 유사성.

이러한 구성 요소는 장면 요소를 구별하는 데 중요한 로컬 구조적 및 수축적 차이를 포착합니다.

이는 그림 3에서 확인되며, 여기서 SSIM은 이 세 가지 구성 요소를 함께 통합하여 distractors를 감지하는 데 효과적입니다.

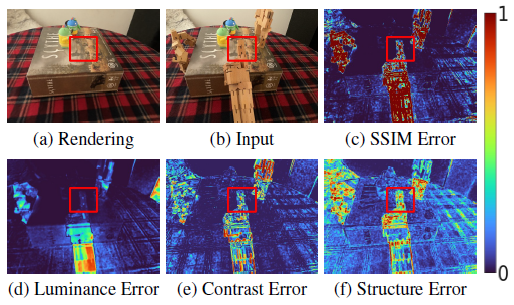

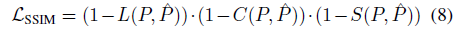

SSIM loss는

로 공식화할 수 있으며, 여기서 P와 ˆP는 각각 입력 및 렌더링 이미지 C(r) 및 ˆC(r)에서 샘플링된 패치입니다.

L, C, S는 P와 ˆP 사이의 휘도, 대비 및 구조적 유사성을 나타냅니다.

저희는 식 (7)을

로 추가로 수정합니다.

식 (7)에 비해 식 (8)의 재구성은 동적 요소와 정적 요소 간의 차이에 더 중점을 둡니다.

결과적으로 불확실성의 차이를 개선하여 불확실성을 보다 효과적으로 최적화할 수 있습니다.

식 (7)과 식 (8) 간의 수학적 증명과 비교는 부록에 포함되어 있습니다.

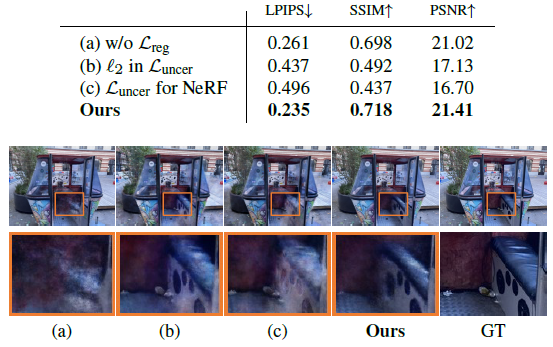

이 업데이트된 SSIM 공식을 기반으로 불확실성 학습에 맞춘 새로운 loss를 소개합니다:

이 loss는 더 나은 불확실성 학습을 위해 조정된 식 (4)를 단순하게 수정한 것입니다.

L_uncer는 불확실성 추정 MLP G를 학습하는 데 특별히 적용됩니다.

이는 불확실성 예측으로부터 NeRF 모델의 학습을 분리할 수 있기 때문에 매우 중요합니다.

이러한 분리는 학습된 불확실성이 다양한 유형의 distractors에 강건함을 보장합니다.

L_uncer에 대한 ablation은 표 4를 참조하십시오.

최근 연구인 S3IM [55]에서도 NeRF 학습을 위해 SSIM을 사용하지만 loss는 정적 장면에 맞게 조정된 반면, 저희 연구는 불확실성 학습을 개선하기 위해 설계되었습니다.

또한 S3IM은 비로컬적 구조적 유사성을 식별하기 위해 확률적 샘플링을 사용하는 반면, distractors를 위해 로컬 구조에 초점을 맞추기 위해 확장 샘플링을 사용합니다.

3.3. Optimization

위에서 언급한 바와 같이 불확실성 예측 모듈과 NeRF 모델을 별도로 최적화하는 것이 중요합니다.

불확실성 예측 MLP의 최적화를 위해 식 (9)의 L_uncer와 식 (3)의 L_reg를 사용합니다.

병렬로 NeRF 모델을 다음

으로 학습합니다.

이 loss는 본질적으로 정규화 항이 없는 식 (4)가 사용되는데, 이는 L_uncer가 이미 불확실성에 대한 사소한 솔루션 (β(r) = ∞)을 방지하기 때문입니다.

병렬 학습 프로세스는 그림 2에 표시된 바와 같이 L_uncer에서 NeRF 표현으로, L_nerf에서 불확실성 MLP G로 그래디언트 흐름을 분리함으로써 용이하게 됩니다.

또한 RobustNeRF [39]를 따르고 NeRF 학습을 위해 Mip-NeRF 360 [1]의 interval loss와 distortion loss를 포함하며, 여기서는 단순화를 위해 생략합니다.

우리의 전반적인 objective는

로 표시된 모든 loss를 함께 통합하며, 여기서 각 항은 해당 λ에 의해 가중치가 부여됩니다.

3.4. Dilated Patch Sampling

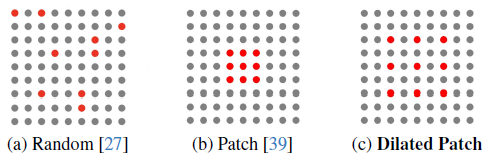

이 섹션에서는 NeRF 학습의 효과, 특히 방해 분산자가 없는 결과를 달성하는 데 있어 핵심 요소인 ray 샘플링 전략에 대해 살펴봅니다.

RobustNeRF는 랜덤 샘플링(그림 4(a))에 대한 패치 기반 ray 샘플링(그림 4(b))의 효과를 입증했습니다.

그러나 이 접근 방식은 주로 샘플링된 패치의 크기가 작기 때문에 한계가 있습니다(예: 16×16).

특히 GPU 메모리의 제약으로 인해 배치 크기가 작을 때, 이 작은 컨텍스트는 네트워크의 학습 용량을 제한하여 최적화 안정성과 수렴 속도에 영향을 미칠 수 있습니다.

이 문제를 해결하기 위해 그림 4(c)에 표시된 dilated patch sampling [18, 29, 43, 50, 56, 57]을 사용합니다.

이 전략에는 확장 패치에서 ray를 샘플링하는 것이 포함됩니다.

패치 크기를 확장하면 각 학습 반복에서 사용할 수 있는 컨텍스트 정보의 양을 크게 늘릴 수 있습니다.

표 3의 경험적 결과는 확장된 패치 샘플링이 학습 프로세스를 가속화할 뿐만 아니라 distractor 제거에서 우수한 성능을 제공한다는 것을 보여줍니다.

4. Experiments

RobustNeRF Dataset.

테이블 위의 장난감 설정이 있는 시퀀스는 4개입니다.

그러나 Crab 장면은 공개되지 않아 포함할 수 없습니다.

한편, 이 시퀀스의 각 이미지에는 우리의 설정과 다른 별개의 distractors 세트가 포함되어 있기 때문에 우리는 Baby Yoda 장면에 대한 비교를 보충에 넣었습니다.

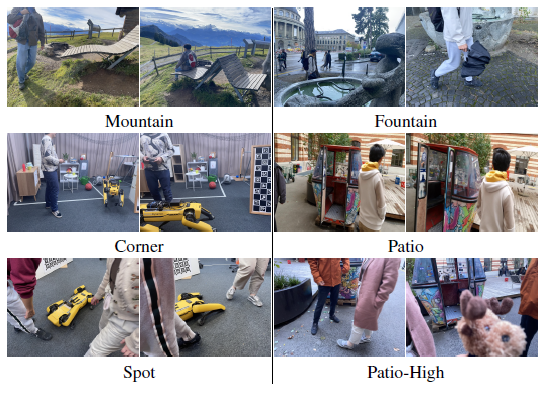

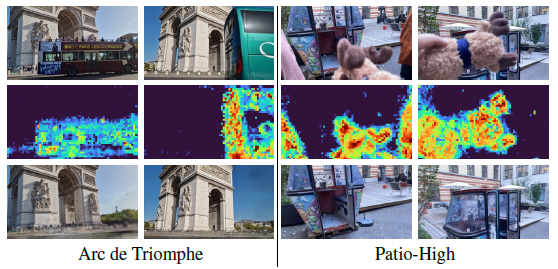

On-the-go Dataset.

실제 실내 및 실외 환경에서 접근 방식을 엄격하게 평가하기 위해 다양한 distractors 비율(5%에서 30% 이상)로 10개의 실외 및 2개의 실내 장면을 포함하여 12개의 무심코 캡처한 시퀀스가 포함된 데이터 세트를 캡처했습니다.

정량적 평가를 위해 그림 5와 같이 서로 다른 폐색률을 나타내는 6개의 시퀀스를 선택합니다.

이 데이터 세트에 대한 자세한 내용과 결과는 보충 자료에서 확인할 수 있습니다.

Baselines.

우리는 우리의 방법을 Mip-NeRF 360 [1], D^2NeRF [52], NeRF-W [27], Ha-NeRF [5], RobustNeRF [39], Mip-NeRF 360 + SAM과 비교하고, SAM [22]으로 이미지에서 동적 객체를 제외하고 정적 부분에 대한 NeRF를 학습합니다.

자세한 내용은 보충 사항을 참조하십시오.

Metrics.

우리는 새로운 뷰 합성 평가를 위해 널리 사용되는 PSNR, SSIM [51] 및 LPIPS [65]를 채택합니다.

4.1. Evaluation

On-the-go Dataset.

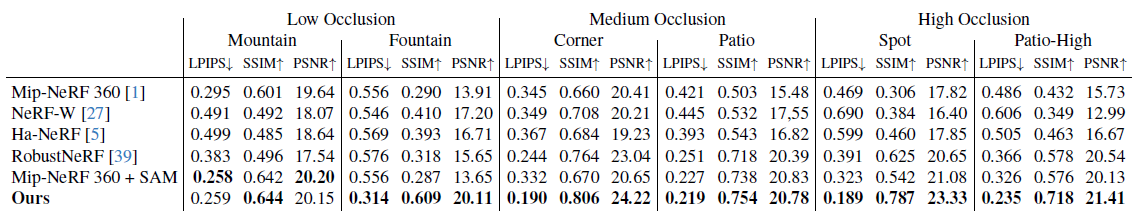

저희는 그림 5 및 표 1과 같이 On-the-go 데이터 세트에 대한 평가를 확장합니다.

저희의 방법에 비해 RobustNeRF는 저폐색 시나리오에서 중간 폐색 시나리오에서 fine 세부 정보를 유지하지 못하는 경우가 많으며, 폐색이 심한 설정에서는 distractors를 제거하는 데 어려움을 겪습니다.

또한, 폐색이 심한 장면에 대해 이상치 비율의 하이퍼파라미터를 조정한 후에도 RobustNeRF는 여전히 성능이 떨어지는 것으로 나타났습니다.

보충 사항을 참조하십시오.

RobustNeRF와 달리 NeRF-W 및 Ha-NeRF는 낮은 및 중간 폐색 수준에서 distractors를 제거하는 데 능숙하지만 이러한 효율성은 이미지 품질 저하의 대가를 치르게 됩니다.

이러한 절충점은 [34, 39]에서 논의된 바와 같이 과도 임베딩 접근 방식의 결과입니다.

또한 NeRF-W 및 Ha-NeRF는 더 높은 폐색 비율에서 특히 어려움을 겪습니다.

이러한 경우 이미지별 과도 임베딩이 distractors를 적절하게 모델링할 수 없어 성능이 눈에 띄게 저하됩니다.

SAM 방법과 결합된 Mip-NeRF 360은 distractors를 세그먼트하기 쉬운 산과 같은 간단한 장면에서 잘 작동합니다.

그러나 더 복잡한 장면에서는 그 효과가 감소합니다.

이와 달리 다양한 폐색 비율로 장면 전반에 걸쳐 다재다능함을 보이며 일관되게 고품질 렌더링을 생성할 수 있습니다.

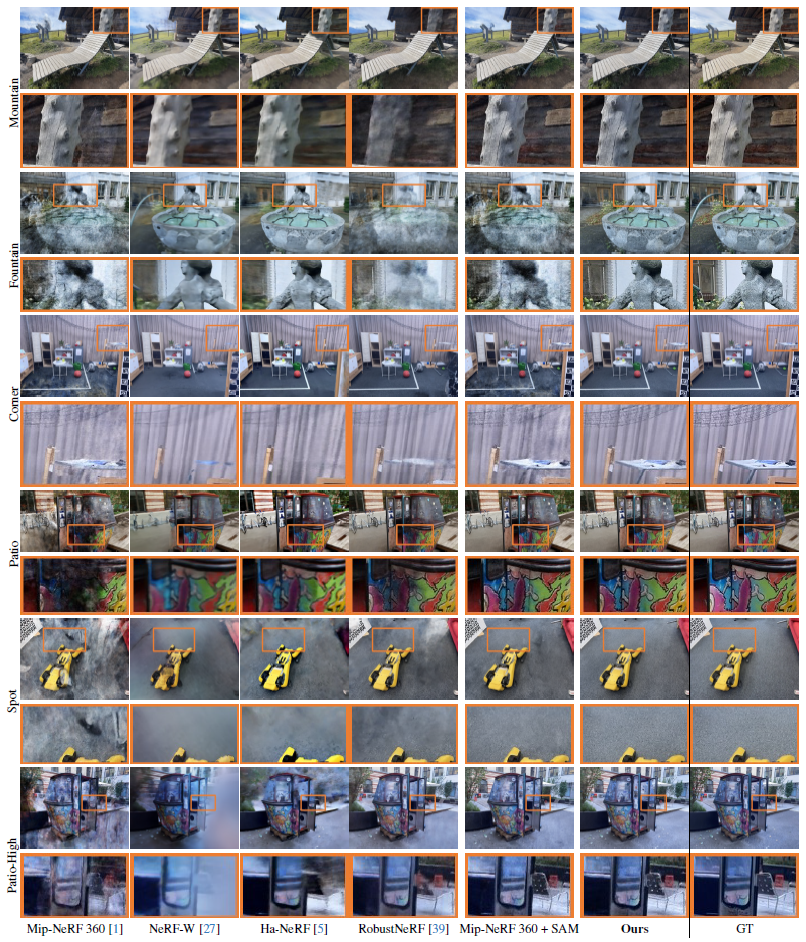

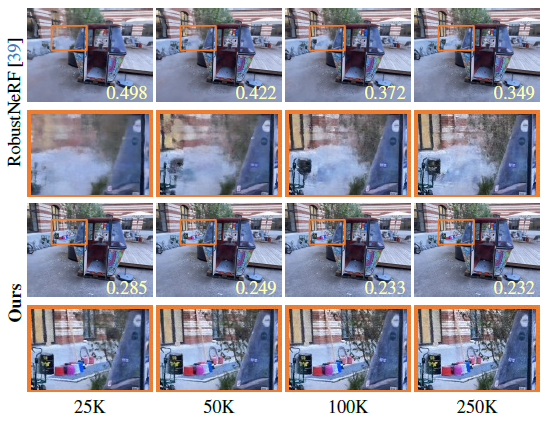

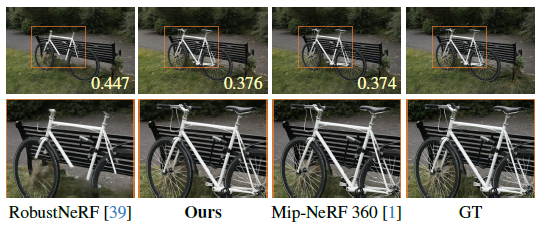

Comparison on RobustNeRF Dataset [39].

표 2에서 볼 수 있듯이 우리의 방법은 모든 베이스라인에서 양적, 질적으로 우수한 성능을 보여줍니다.

RobustNeRF의 하드 임계값 접근 방식은 Android 장면의 신발과 카펫과 같이 관찰이 제한된 복잡한 구조를 간과하는 경향이 있습니다.

또한 Statue 장면에서 뷰에 따라 강조 표시된 테이블의 나무 텍스쳐와 같이 뷰에 따라 효과가 있는 평면 표면과 관련된 시나리오에서는 성능이 떨어지는 것으로 관찰되었습니다.

Mip-NeRF 360 + SAM은 SAM을 사용하여 각 이미지의 모든 distractor 요소를 수동으로 선택하는 지루한 프로세스가 필요하지만 여전히 얇은 구조, 그림자 및 반사를 캡처하는 데 어려움을 겪습니다.

4.2. Ablation Study

모든 ablation는 On-the-go 데이터 세트에서 까다로운 고도로 폐쇄된 "Patio-High" 장면에서 수행됩니다.

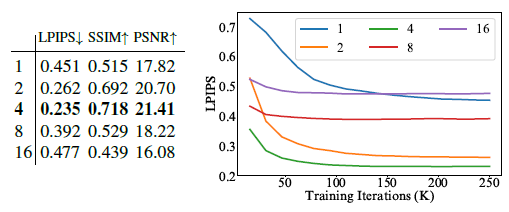

Patch Dilation.

여기서는 표 3과 같이 확장 패치 샘플링에 대한 다양한 확장률을 테스트합니다.

1에서 4 사이의 범위에서 확장률이 높으면 훨씬 더 빠른 수렴과 더 나은 렌더링 품질을 얻을 수 있습니다.

이는 패치 내에서 컨텍스트 정보를 증가시키면 성능이 효과적으로 향상될 수 있다는 섹션 3.4의 가설을 검증합니다.

그러나 확장률이 4 이상이면 불확실성 최적화가 붕괴되기 시작합니다.

확장률이 높으면 패치에서 의미 정보가 손실되기 때문일 수 있습니다.

이는 샘플링이 이제 랜덤 샘플링과 유사해짐에 따라 발생하여 불확실성 학습에 부정적인 영향을 미칩니다.

다른 시퀀스에 걸친 패치 크기 및 확장률에 대한 자세한 내용과 분석은 부록에서 확인할 수 있습니다.

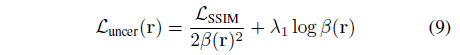

Loss Functions.

표 4에서 저희는 다양한 학습 loss를 완화합니다.

(b)에서 SSIM은 ℓ2 loss에 비해 정적 요소로 distractors를 더 능숙하게 구별합니다.

(c)에서 저희는 불확실성 MLP와 NeRF를 함께 학습합니다.

그 결과 성능이 크게 저하되어 분리된 학습 접근 방식의 효과가 있음을 알 수 있습니다.

또한 (a)에서 L_reg를 생략하면 특정 뷰의 렌더링 품질에 부정적인 영향을 미친다는 것을 발견했습니다.

다양한 시퀀스에 대한 추가 연구는 부록에 나와 있습니다.

4.3. Analysis

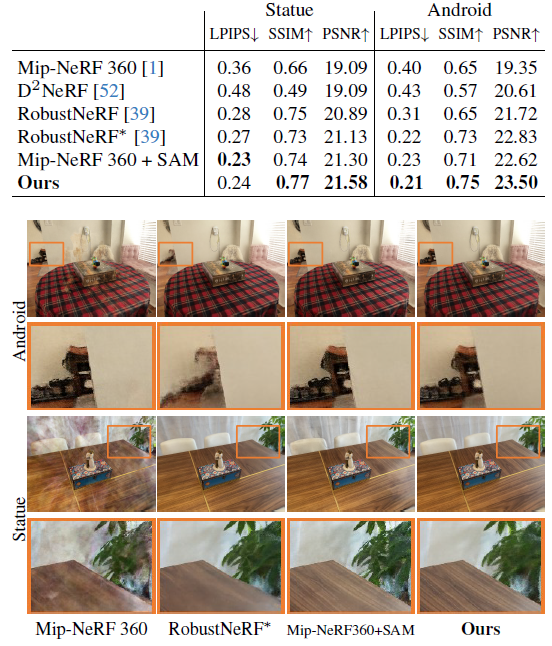

Fast Convergence.

그림 7은 학습 과정에서 RobustNeRF와 우리의 것을 비교한 것입니다.

불확실성 예측 파이프라인과 확장된 패치 샘플링 덕분에 우리는 현저하게 더 빠른 수렴을 보여줍니다.

학습 초기 단계에서 이미 fine 세부 사항을 포착할 수 있으며, 25K에서는 우리의 것을, 250K에서는 RobustNeRF를 볼 수 있습니다.

Applicability to Static Scenes.

동적 장면에서 NeRF를 구축하는 데 효과를 보인 후 정적 장면에 직접 적응할 수 있는지 여부를 살펴봅니다.

저희는 Mip-NeRF 360 [1] 데이터 세트의 정적 장면을 사용하여 평가합니다.

그림 8에 표시된 것과 같이, 저희는 실제로 Mip-NeRF 360 [1]만큼 뛰어난 성능을 달성했습니다.

반면, RobustNeRF는 주요 설계 중 하나가 장면의 적어도 일부를 누락하는 것을 포함하기 때문에 자전거의 특정 부분을 캡처하지 못합니다.

Large Obstructions.

그림 9에서 우리는 또한 우리의 방법이 예측된 불확실성으로 큰 장애물을 충실하게 모델링하고 효과적으로 제거할 수 있음을 보여줍니다.

5. Conclusions

저희는 다양한 수준의 distractors를 포함하는 동적 실제 장면에서 효과적이고 효율적인 distractor 제거를 가능하게 하는 다용도 방법인 NeRF On-the-go를 소개합니다.

저희의 방법은 실제 야생 응용 분야에서 NeRF의 잠재력을 최대한 실현하기 위한 단계를 나타냅니다.

Limitation.

우리의 방법은 다양한 실제 장면에서 견고성을 보여주지만 창문이나 금속과 같이 반사가 심한 표면과 같이 뷰 의존적 효과가 강한 영역에 대한 정확한 불확실성을 예측하는 데 어려움을 겪습니다.

최적화 프로세스에 추가 prior 지식을 통합하는 것이 잠재적으로 도움이 될 수 있습니다.