2024. 9. 28. 13:16ㆍ3D Vision/NeRF with Real-World

NeRF-MS: Neural Radiance Fields with Multi-Sequence

Peihao Li, Shaohui Wang, Chen Yang, Bingbing Liu, Weichao Qiu, Haoqian Wang

Abstract

Neural radiance fields (NeRF)는 단일 시퀀스 데이터로만 학습할 때 새로운 뷰 합성에서 인상적인 성능을 달성합니다.

그러나 더 나은 재구성 성능을 위해서는 서로 다른 시간에 서로 다른 카메라로 캡처한 멀티 시퀀스를 활용하는 것이 필수적입니다.

멀티 시퀀스 데이터에는 두 가지 주요 과제가 필요합니다: 조명 조건이 다르고 보행자와 같은 비 정적 물체로 인한 외관 변화.

이러한 문제를 해결하기 위해 멀티 시퀀스 데이터로 NeRF를 학습하는 새로운 접근 방식인 NeRF-MS를 제안합니다.

특히, 우리는 이미지별 외관 코드 분포를 정규화하기 위해 triplet loss를 활용하여 더 나은 고주파 텍스처와 정반사와 같은 일관된 외관을 제공합니다.

그런 다음 비 정적 물체를 명시적으로 모델링하여 플로터를 줄입니다.

광범위한 결과는 NeRF-MS가 실외 및 합성 장면에서 SOTA 뷰 합성 방법을 능가할 뿐만 아니라 3D 일관된 렌더링과 강력한 외관 제어를 달성한다는 것을 보여줍니다.

1. Introduction

Neural radiance field [20]는 사진 컬렉션이 주어졌을 때 새로운 뷰 합성에 큰 성공을 거두었습니다.

사진이 단일 시퀀스에서 가져온 경우 가장 잘 작동하므로 동일한 카메라에 동시에 캡처됩니다.

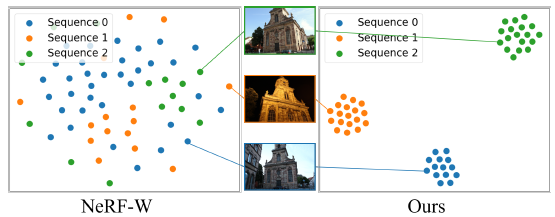

멀티 시퀀스는 그림 1과 같이 서로 다른 시간에 서로 다른 카메라에 의해 캡처된 사진 모음입니다.

멀티 시퀀스를 사용하는 것은 장면을 더 잘 3D로 재구성하는 데 중요합니다.

서로 다른 카메라에서 캡처한 이미지와 서로 다른 시간에 캡처한 이미지를 결합하면 그 틈새를 메우고 잘 재구성되지 않은 영역의 품질을 개선할 수 있습니다.

또한 서로 다른 계절이나 시간에 캡처한 동영상을 사용하여 시간에 따른 장면의 변형이나 변화를 보여줄 수 있습니다.

또한 서로 다른 방문자와 같은 이벤트의 카메라에 의해 캡처된 동영상은 장면의 다른 관점이나 각도를 제공할 수 있습니다.

다중 시퀀스 데이터는 기존 방법에 대한 문제를 제기합니다.

첫 번째는 외관 변형입니다.

시퀀스는 센서, 조명 및 날씨와 같은 다양한 조건에서 캡처됩니다.

이미지당 외관 코드 [19, 5, 33]를 할당하면 극단적인 외관 변경을 처리할 수 있습니다.

그러나 이는 모델에 너무 큰 유연성을 부여하므로 학습된 외관 코드가 이미지 콘텐츠와 카메라 포즈에 과적합되어 3D 일관성 없는 렌더링과 새로운 뷰에서 복잡한 텍스처의 loss를 초래합니다, 그림 3 참조.

또한 서로 다른 외관 코드 간의 보간 중 고스트가 발생합니다.

두 번째는 시퀀스 transient입니다.

이전 방법은 장면을 정적 부분과 transient 부분으로 분할합니다 [30].

멀티 시퀀스 데이터의 경우, 객체는 전체 시퀀스(주차 차량, 서 있는 보행자)에서 정적일 수 있지만 다른 시퀀스에는 없습니다.

이러한 종류의 객체는 transient로 성공적으로 분류할 수 없으므로 그림 5와 같이 장면에서 플로터가 발생합니다.

우리는 멀티 시퀀스를 사용하여 뉴럴 래디언스 필드를 구축하는 새로운 방법인 NeRF-MS를 제안합니다.

첫째, 높은 유연성으로 인한 과적합 외관 코드를 해결하기 위해 시퀀스 내 이미지 간의 유사성과 시퀀스 간의 다양성을 가정하는 triplet loss를 도입합니다.

외관 잠재 코드의 분포를 제약하는 triplet loss를 통해 우리의 방법은 재구성 프로세스의 모호성을 줄이고 텍스처 및 반사 충실도를 향상시킬 수 있습니다.

더 나은 잠재 공간을 구축하기 때문에 서로 다른 시퀀스에서 더 자연스러운 외관 보간을 수행할 수 있습니다.

둘째, 정적 장면에서 transient 물체를 더 잘 분리하기 위한 transient 분해 모듈을 제안합니다.

시퀀스와 이미지 transient를 별도로 명시적으로 모델링함으로써 시퀀스 transient에 과적합되는 것을 방지하고 기하학적 재구성 품질을 개선합니다.

실제 실외 데이터 세트 [29]와 합성 데이터 세트 [20]에 대한 우리의 실험은 우리의 접근 방식이 3D 일관된 외관을 재구성하고 고스팅 아티팩트를 줄임으로써 멀티 시퀀스 장면에서 SOTA 성능을 달성한다는 것을 보여줍니다.

또한 합성 데이터 세트에 대한 제어 가능한 실험을 통해 우리의 방법이 다양한 멀티 시퀀스 설정에 대해 강력하고 베이스라인을 일관되게 능가한다는 것을 보여줍니다.

결론적으로, 우리의 기여는 다음과 같이 요약할 수 있습니다:

• 뉴럴 래디언스 필드가 야생에서 캡처한 멀티 시퀀스 이미지로 새로운 뷰 합성을 수행할 수 있는 새로운 프레임워크.

• 외관 변형의 모호성을 줄이기 위해 외관 코드를 정규화하는 triplet loss로, 고정밀 렌더링과 제어 가능한 외관을 구현할 수 있습니다.

• 새로운 뷰 합성에서 플로터를 줄이기 위해 transient 물체와 정적 장면을 분리하는 시퀀스 transient 분해 모듈.

2. Related Work

2.1. Novel View Synthesis

Novel view synthesis (NVS)은 입력 이미지에서 타겟 뷰를 생성하는 컴퓨터 비전 및 그래픽 분야에서 널리 사용되는 연구 분야입니다.

초기 접근 방식은 입력 이미지 세트에서 타겟 뷰를 생성하는 image-based rendering (IBR)을 사용합니다.

나중에 일부 방법은 포즈 입력과 합성된 뷰를 통해 light fields [15] 또는 proxy geometry [6, 9, 28, 27]를 구성하고 왜곡된 입력을 리샘플링하거나 블렌딩했습니다.

그러나 이러한 방법에는 밀도가 높은 입력 이미지가 필요했으며 3D 재구성 및 희소 입력 데이터의 품질에 의해 제한되었습니다.

최근 딥러닝의 발전으로 주어진 3D 위치와 방향에 해당하는 레디언스 값을 계산하기 위해 신경망을 사용하는 것이 용이해지면서 고품질의 새로운 뷰 합성으로 이어졌습니다.

특히, 좌표 Multi-Layer Perceptrons (MLP)을 사용하는 Neural Radiance Fields (NeRF) [20] 기술은 장면을 모델링하고 볼륨 렌더링을 사용하여 렌더링하여 뛰어난 품질의 뷰 합성 결과를 산출합니다.

NeRF는 인상적인 뷰 합성 결과를 달성했으며 렌더링 및 최적화 가속화 [7, 8, 25, 38, 21, 4], 색상 변형 처리 [19, 33], 카메라 포즈 최적화 [16, 37, 35, 1], 입력 이미지가 거의 없는 성능 개선 [12, 14, 22] 등 추가 개선을 위해 많은 관련 연구에 영감을 주었습니다.

2.2. Calibrated Volume Rendering

NeRF는 렌더링 loss에 대한 그래디언트 하강을 사용하여 모든 입력 이미지를 일치시키도록 신경 체적 장면 표현을 직접 최적화합니다.

따라서 불완전한 입력 데이터는 합성된 새로운 뷰에 부정적인 영향을 미칠 수 있습니다.

이 문제를 해결하기 위해 다양한 카메라 조건 [19, 5, 30, 26], 폐색된 물체 [5, 17], 주의 분산 장치 [30]와 같이 볼륨 렌더링에서 완화된 가정으로 성능을 개선하기 위한 여러 가지 방법이 제안되었습니다.

NeRF in the Wild (NeRF-W) [19]는 재구성을 위해 야생 환경에서 웹 이미지를 사용하고 다양한 카메라 조건과 폐색된 물체를 처리하기 위해 외관 및 transient 임베딩에 의한 처리 메커니즘을 도입합니다.

Block-NeRF [33]는 외관 임베딩, 학습된 포즈 개선, 제어 가능한 NeRF 노출을 추가하여 다양한 환경 조건에서 수개월에 걸쳐 캡처된 데이터에 강력하게 적용합니다.

Ha-NeRF [5]는 관광 이미지에서 시간에 따라 변하는 외관과 복잡한 폐색을 처리하기 위해 외관 환각 모듈과 폐색 방지 모듈을 도입합니다.

RobustNeRF [30]는 NeRF 학습에 사용되는 최적화 문제에서 이상점으로 주의 분산 요소를 모델링하여 장면에서 효과적으로 제거하고 아티팩트를 줄입니다.

일부 방법은 다양한 노출을 가진 이미지를 처리하고 low dynamic range (LDR) 이미지에서 high dynamic range (HDR) 렌더링을 달성하는 것을 목표로 합니다.

RawNeRF [20]는 선형 raw 이미지에서 직접 학습하도록 NeRF를 수정하여 장면의 전체 동적 범위를 보존하고 거의 어두운 곳에서 캡처된 극도로 노이지한 입력 이미지에서 HDR 뷰 합성 작업을 가능하게 합니다.

HDR-NeRF [11] 및 HDR-Plenoxels [13]은 미분가능한 톤 매퍼를 사용하여 다양한 노출을 가진 낮은 동적 범위 이미지 세트에서 높은 동적 범위 뉴럴 래디언스 필드를 복구하여 HDR과 LDR 모두에 대해 고품질 렌더링을 달성합니다.

일부 작업은 디포커스 또는 모션 블러로 인한 이미지 저하를 해결하는 것을 목표로 합니다.

Deblur-NeRF [18]는 변형 가능한 희소 커널 모듈을 사용하여 디포커스 또는 모션 블러로 인한 블러 입력에서 샤프한 NeRF를 복구하는 합성별 분석 접근 방식을 제안합니다.

BAD-NeRF [35]는 NeRF의 매개 변수를 공동으로 학습하고 노출 시간 동안 카메라 움직임 궤적을 복구하여 심각한 모션 블러 이미지와 부정확한 카메라 포즈에 강건하게 작용합니다.

본 논문에서는 학습 데이터의 photometric 일관성에 대한 요구 사항을 완화하는 다중 시퀀스로 NeRF를 최적화하는 문제를 다룹니다.

3. Preliminaries

3.1. NeRF

3.2. NeRF in the Wild

4. Method

우리의 방법은 서로 다른 시간에 또는 서로 다른 센서로 캡처된 다중 시퀀스 {S_k}를 포함하는 이미지 컬렉션 {I_i}으로 뉴럴 래디언스 필드를 재구성하는 것을 목표로 합니다.

구체적으로, 우리는 섹션 4.1에서 triplet loss가 있는 시퀀스-일관된 외관 잠재 코드를 최적화하여 뉴럴 래디언스 필드를 구축합니다.

비고정 객체를 더 잘 분리하기 위해 섹션 4.2에서 시퀀스 transient 코드와 이미지 transient 코드를 사용하여 다양한 범주의 비고정 객체를 모델링하여 렌더링된 결과의 아티팩트를 줄였습니다.

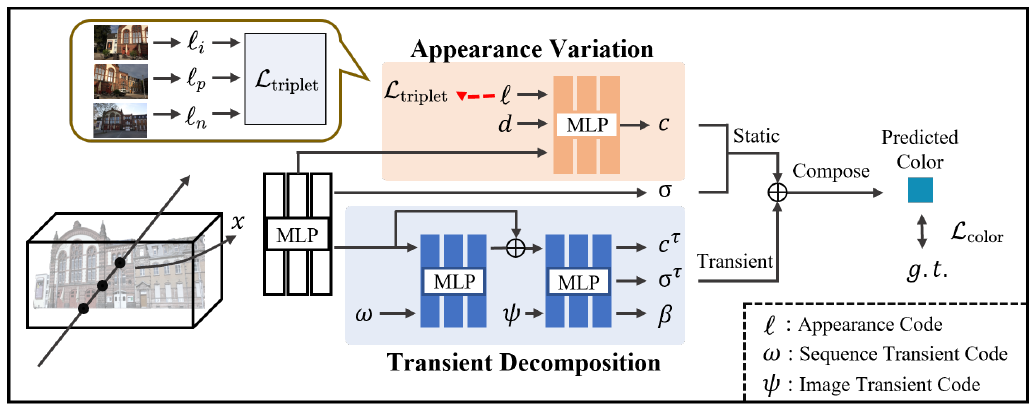

그림 2는 제안된 방법의 워크플로와 구조에 대한 개요를 제시합니다.

4.1. Triplet Loss for Appearance Regularization

다중 시퀀스로 3D 장면을 재구성하려면 다양한 모양을 정적 지오메트리에서 분리하는 것이 중요합니다.

Generative Latent Optimization [2]를 사용하여 [19]를 따라 각 이미지 I_i 대한 외관 잠재 코드 ℓ_i ∈ R^(n_1)을 맞춥니다.

따라서 외관 임베딩을 MLP의 입력으로 사용하여 식 2를 다음과 같이 확장합니다:

자유도가 높기 때문에 각 이미지에 대해 하나의 외관 코드를 최적화하면 학습 데이터 세트에 모양 다양성이 부족할 때 과적합이 발생하여 테스트 뷰에서 일반화 성능이 저하됩니다.

또한 이미지별 외관은 시퀀스 내에서 이미지 간의 유사성을 모델링할 수 없으므로 3D 일관된 새로운 뷰 합성을 방지합니다.

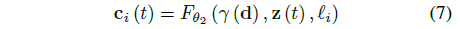

이 문제를 해결하기 위해 우리는 시퀀스 외관 분리를 보존하기 위해 메트릭 학습 [32, 10, 31, 3]에서 주로 사용되는 triplet loss를 제안합니다:

, 여기서 m은 내부 시퀀스 거리와 시퀀스 간 거리 사이의 일정한 마진을 조정하는 하이퍼 파라미터입니다.

외관 코드 ℓ_p 및 ℓ_n은 양성 샘플과 음성 샘플을 나타내며, 이는 (ℓ_i, ℓ_p, ℓ_n)이 이미지(I_i, I_p, I_n)에 해당하는 반면, I_i, I_p ∈ S_k 및 I_n / ∈ S_k.

시퀀스별 외관 코드를 사소하게 최적화하는 것과 비교했을 때, triplet loss 함수는 화이트 밸런스, 노출 및 렌즈 플레어로 인해 일반적으로 발생하는 동일한 시퀀스 내 이미지 간의 미묘한 외관 변화에 대해 견고합니다.

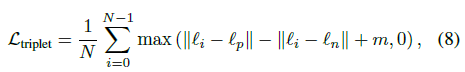

표 2는 이러한 방법이 작동하지 않음을 보여줍니다.

이미지별 외관 코드를 최적화하면 멀티뷰 일관성 제약이 약화되고 과적합이 발생합니다.

우리의 방법은 외관 코드의 정규화를 통해 이러한 단점을 극복합니다.

따라서 그림 3에 나와 있는 것처럼 멀티뷰 정보를 통합하여 고주파 텍스처와 반사와 같은 뷰 종속 효과를 재구성할 수 있습니다.

우리의 방법은 그림 4와 같이 합리적인 외관의 잠재 공간을 구성할 수 있으며, 이는 시퀀스 간의 그림 모양이 유사하다는 이전의 결과와 일치합니다.

잠재 공간을 더 간결하게 정규화하려면 섹션 5.3과 같이 강력한 새로운 뷰 합성과 부드러운 외관 보간을 만들기 위해 필수적입니다.

4.2. Transient Decomposition

다중 시퀀스 작업에서 장면은 "static components", "sequence transients" 및 "image transients"의 세 부분으로 구성됩니다.

시퀀스 transient는 주차된 차량과 같은 시퀀스 내에서 정적으로 유지되므로, 현재 작업 [19, 33, 5]은 그림 5와 같이 시퀀스 transient를 정적 장면과 분리할 수 없으며, 이는 새로운 뷰에서 아티팩트와 고스트로 이어집니다.

우리는 시퀀스 transient를 명시적으로 모델링하여 정적 지오메트리와 transient를 더 잘 분리하기 위해 transient 분해 모듈을 도입합니다.

우리는 학습된 두 종류의 transient 잠재 코드를 활용하여 비정적 객체를 모델링합니다: 각 시퀀스에 대한 시퀀스 transient 코드 ω_k ∈ R^(n_2) 및 이미지별 transient 코드 ψ_i ∈ R^(n_3).

매개 변수 {θ_3, θ_4}을 사용하여 두 MLP의 transient 필드를 다음과 같이 인코딩합니다:

, z(t)는 식 1의 출력이고, ω_k는 시퀀스 S_k에 해당하며, ψ_i는 이미지 I_i ∈ S_k에 해당합니다.

시퀀스 transient와 이미지 transient를 분리함으로써, 우리의 방법은 NeRF가 프레임 의존적인 외관 대신 transient 코드로 고정되지 않은 물체를 맞추도록 장려합니다.

ray r을 따라 transient 분해 모듈의 출력은 정적 래디언스 c_i 및 밀도 σ_i로 구성되어 픽셀 색상 ˆC_i(r) 및 불확실성 ˆβ_i(r)를 얻습니다.

[19]에 이어 색상 loss는 다음과 같이 제안됩니다:

, 여기서 λ_u는 transient 양에 대한 페널티를 조정하기 위한 loss 가중치입니다.

테스트 단계에서는 transient 분해 모듈을 생략하고 새로운 뷰 합성을 위해 c_i와 σ_i만 렌더링합니다.

4.3. Optimization

NeRF-MS를 얻기 위해 위에서 언급한 제약 조건을 통합하고 네트워크 매개 변수 {θ_1, θ_2, θ_3, θ_4}와 학습된 잠재 코드 {ℓ_i}, {ψ_i}, {ω_k}의 공동 학습을 수행하여 전체 loss 함수를 최소화합니다:

, 색 loss와 triplet loss와 loss 가중치 λ의 선형 조합.

5. Experiment

5.1. Datasets

NeRF-OSR.

NeRF-OSR 데이터 세트 [29]는 110개의 서로 다른 녹화 세션에서 3240개의 시점에서 캡처한 8개의 실외 장면을 포함하는 실외 장면 relighting을 위한 벤치마크 데이터 세트입니다.

우리는 각각 4개의 장면에 대해 서로 다른 조명 조건에서 3개의 시퀀스를 선택합니다.

구체적으로, 우리는 8번째 프레임마다의 첫 번째 프레임을 테스트 세트로 선택합니다.

또한 테스트 중에 시맨틱 세그멘테이션을 활용하여 transient 폐색을 제거하고 정적 구성 요소를 재구성할 때 알고리즘의 성능을 평가하는 데 집중합니다.

Synthetic Dataset.

제어 가능한 실험을 위해 NeRF Synthetic 데이터 세트 [20]를 기반으로 합성 데이터 세트를 구성합니다.

먼저 100개의 학습 뷰를 여러 시퀀스 {S_k}^M_(k=1)로 랜덤으로 분할합니다.

그런 다음 NeRF-W [19]와 유사하게 첫 번째 이미지의 외관 코드가 테스트 뷰를 렌더링하는 데 사용되는 첫 번째 시퀀스를 제외하고 각 시퀀스에 대해 랜덤 색상 섭동을 적용합니다.

시퀀스당 이미지 수를 조정하는 동시에 전체 학습 이미지 수를 100개로 고정함으로써 섹션 5.5의 다양한 멀티 시퀀스 설정에 대한 방법의 견고성을 보여줍니다.

보다 제어 가능한 실험과 자세한 내용은 부록을 참조하시기 바랍니다.

5.2. Implementation Details

NeRF 및 NeRF-W의 구현은 [24]를 기반으로 하며, Ha-NeRF의 구현은 [5]를 따릅니다.

정적 래디언스 필드는 256개의 채널을 가진 8개의 레이어와 128개의 채널 레이어로 구성되어 σ와 c를 생성합니다.

transient 분해 모듈에 2개의 레이어가 있는 두 개의 MLP에 이어 ReLU가 생성되며, 완전 연결된 하나의 레이어에 의해 색상, 밀도 및 불확실성이 생성됩니다.

48개의 차원을 가진 이미지당 외관 벡터는 마진 m = 2의 triplet loss로 인해 제약을 받고 triplet loss λ의 가중치는 0.01로 설정됩니다.

시퀀스 transient 코드와 이미지 transient 코드의 차원은 모두 16입니다.

우리는 1024의 배치 크기로 20k 단계 동안 8개의 Nvidia 2080Ti GPU에서 전체 모델을 학습하고 학습 및 평가 중에 모든 이미지를 2배 다운샘플링합니다.

구현 및 코드는 MindSport [34]와 PyTorch [23]를 사용합니다.

5.3. Comparisons with the State-of-the-art Models

Baselines.

NeRF-MS 및 기타 SOTA NeRF-like 베이스라인을 다음과 같이 평가합니다: a) 볼륨 렌더링을 제시하지만 엄격한 조명 조건이 필요한 vanilla NeRF; b) 비정형 이미지 세트를 사용하여 레디언스 필드를 학습할 수 있는 NeRF-W [19]; c) 컨볼루션 신경망을 사용하여 외관 코드를 추출하고 2D transient 마스크를 예측하는 폐색 네트워크를 사용하는 Ha-NeRF [5].

Evaluation.

우리는 Peak Signal-to-noise Ratio (PSNR), Structural Similarity Index Measure (SSIM [36]), Learned Perceptual Image Patch Similarity (LPIPS [39]) 등 다양한 평가 지표를 사용하여 새로운 뷰 합성의 시각적 품질을 측정합니다.

[5]의 설정을 따르고 각 테스트 이미지의 왼쪽 절반에 있는 외관 코드를 최적화하여 방법과 NeRF-W 및 오른쪽 절반에 있는 메트릭을 보고하고 Ha-NeRF는 전체 테스트 이미지를 입력으로 받아 외관 피쳐를 가져옵니다.

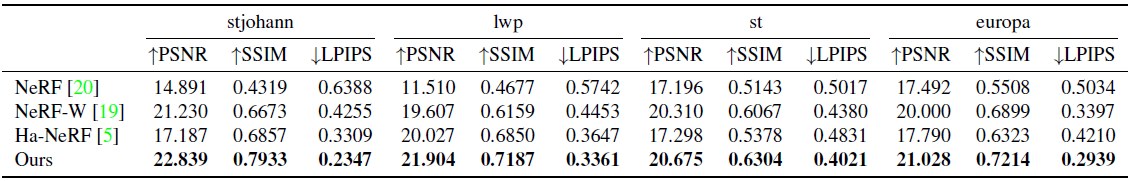

정량적 결과는 표 1에 나와 있습니다.

멀티 시퀀스 학습 이미지를 사용하여 우리의 방법은 NeRF-OSR 데이터 세트에서 PSNR, SSIM 및 LPIPS의 베이스라인을 능가합니다.

이미지별 외관 코드를 정규화함으로써 멀티 뷰 일관성 제약 조건을 강화하여 강력한 렌더링을 수행하고 3D 일관된 외관, 특히 그림 3과 같은 일부 뷰 종속 효과를 재구성할 수 있도록 합니다.

더 나은 지오메트리 재구성을 위해 시퀀스 transient의 모델링 기능을 향상시켜 정적 객체와 transient 객체의 철저한 분리를 실현하는 transient 분해 모듈을 제안합니다.

실제 데이터 세트에 대한 정량적 결과는 우리의 방법이 멀티 시퀀스 작업에서 SOTA 성능을 달성했음을 발표합니다.

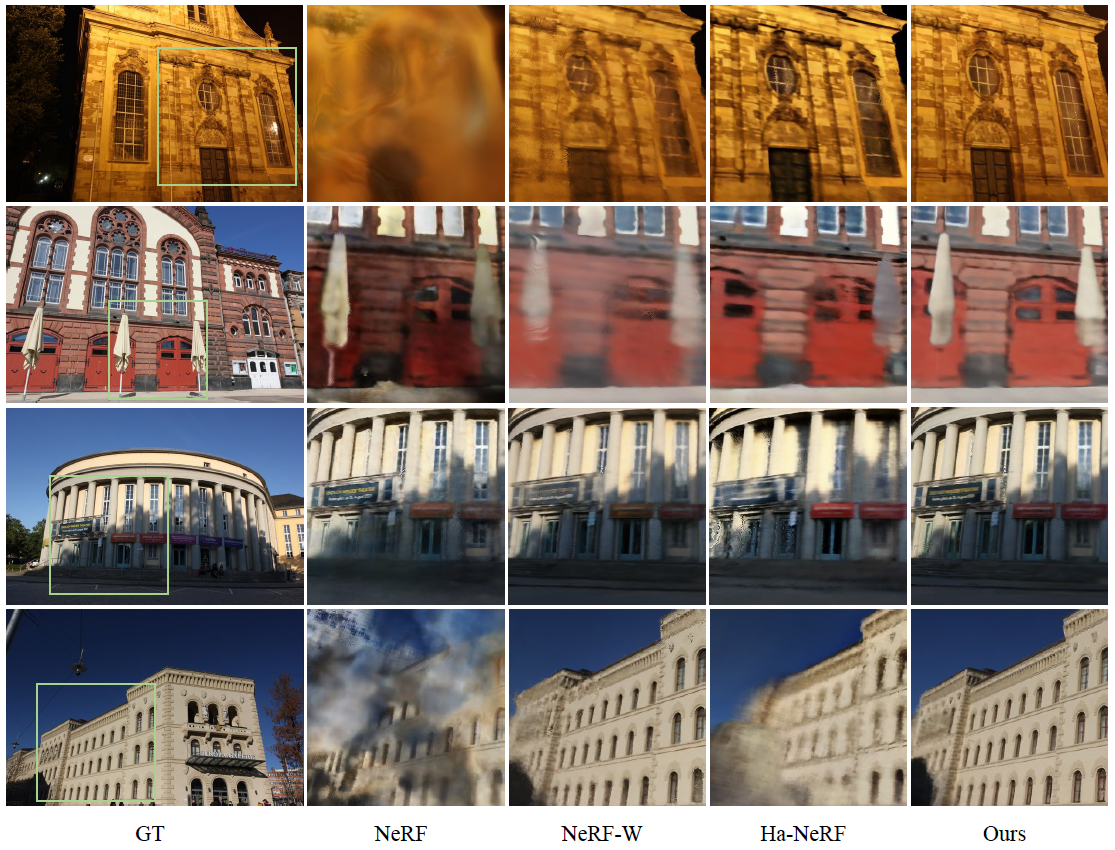

정성적 결과는 그림 6에 나와 있습니다.

우리의 방법은 멀티 시퀀스를 학습 데이터로 사용하는 테스트 뷰에서 베이스라인과 비교하여 렌더링 성능을 크게 향상시킵니다.

NeRF는 photometric 일관성에 대한 강력한 가정을 가지고 있기 때문에 심각한 고스팅 및 아티팩트로 인해 어려움을 겪고 있습니다.

NeRF-W는 정규화 및 가정 없이 각 이미지에 대한 이미지별 외관 및 transient 코드를 최적화하고 외관 변형의 다양성 부족과 학습 뷰의 제한된 수로 인해 멀티 시퀀스 작업에서 과적합으로 어려움을 겪습니다.

과적합 외관 임베딩은 고주파 텍스처 및 지오메트리 디테일을 재구성하는 능력이 약합니다 (예: 1, 2, 4, 그림 6).

Ha-NeRF는 CNN을 사용하여 학습 이미지에서 외관 피쳐를 가져옵니다.

마찬가지로 CNN은 이미지 콘텐츠에 과적합되기 쉬우며, 그 결과 전역 색상 편향과 블러 렌더링이 발생합니다 (예: 1, 3, 4, 그림 6).

또한 Ha-NeRF는 MLP를 활용하여 transient 필드 대신 transient 객체에 대한 2D 마스크를 예측합니다.

3D 일관성 없는 마스크는 지오메트리를 과도하게 분리하여 재구성에서 미세한 디테일을 손실하게 만듭니다 (예: 그림 6의 2 및 그림 7의 지붕).

Controllable Appearance.

우리의 방법은 서로 다른 시퀀스 간의 보간을 통해 제어 가능한 외관을 달성합니다.

그림 7에서 우리는 가장 왼쪽 이미지와 가장 오른쪽 이미지에서 보간된 외관 코드로 렌더링된 일부 이미지를 제시합니다.

우리의 방법은 더 나은 잠재 공간을 구축하여 부드러운 외관 스타일 전송을 수행하는 반면, NeRF-W와 Ha-NeRF는 보이지 않는 영역(오른쪽 하늘)에서 아티팩트를 고스팅하는 데 어려움을 겪습니다.

정규화되지 않은 이미지별 외관 코드는 학습 뷰에 과적합되기 쉬우며 새로운 관점에서 강력하게 렌더링하고 보간할 수 없다는 것을 보여줍니다.

5.4. Ablation Studies

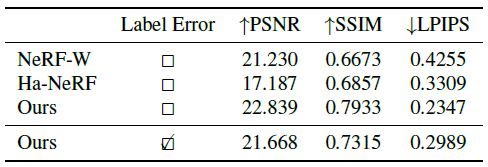

표 2의 결과는 각 구성 요소가 멀티 시퀀스 융합 작업에 도움이 된다는 것을 보여줍니다.

이는 정규화가 외관 코드 분포와 시퀀스 transient를 명시적으로 모델링하는 데 미치는 효과를 보여줍니다.

Without Triplet Loss.

이 실험에서 triplet loss를 제거합니다.

triplet loss가 없으면 외관 코드가 이미지 콘텐츠와 카메라 포즈에 과도하게 적합하여 테스트 뷰에서 전역적인 색상 이동과 고주파 텍스처 loss를 초래하는 경향이 있습니다.

또한 임베딩 분포의 정규화 없이는 그림 3과 같이 뉴럴 레이디언스 필드가 3D 일관된 렌더링을 수행하고 뷰 종속 효과를 재구성할 수 없습니다.

With Sequence Appearance Code.

이 실험에서는 이미지별 출현 코드를 시퀀스별 출현 코드로 대체합니다.

이 실험의 결과는 "w/o Triplet Loss"보다 더 나쁘며, 이는 시퀀스 출현 코드가 멀티 시퀀스 작업에 해를 끼친다는 것을 나타냅니다.

가장 큰 이유는 이러한 사소한 방법으로는 동일한 시퀀스에서 프레임 간의 차이를 모델링할 수 없기 때문입니다.

Without Transient Decomposition Module.

실험에서 우리는 시퀀스 transient 코드를 제거하고 NeRF-W와 같은 이미지 transient 코드만 최적화한다.

시퀀스 transient를 명시적으로 모델링하지 않고 현재 방법은 그림 5와 같이 정적 장면에서 시퀀스 transient를 분리하는 데 어려움을 겪고 있으며, 이로 인해 아티팩트와 플로터가 발생합니다.

5.5. Robustness Analysis

Robustness against Error Sequence Label.

시퀀스 라벨은 타임스탬프와 같이 자유롭게 구할 수 있습니다.

그러나 일부 극단적인 경우에는 조명을 켜면 장면 외관이 극적으로 변경되는 등 부정확한 라벨이 존재하기도 합니다.

"stjohann" 장면에서 시퀀스 0과 시퀀스 1을 동일한 시퀀스로 라벨링함으로써 시퀀스 라벨 오류에 대한 방법의 견고성을 평가합니다.

표 3과 같이 시퀀스 라벨 오류가 있는 경우, 우리의 방법은 여전히 베이스라인을 넘어서는 성능을 보여주며, 이는 라벨 오류에 대한 우리 방법의 견고성과 시퀀스 내의 급격한 변화를 증명합니다.

주된 이유는 triplet loss로 인해 동일한 시퀀스의 이미지 간에 분산이 가능하기 때문입니다.

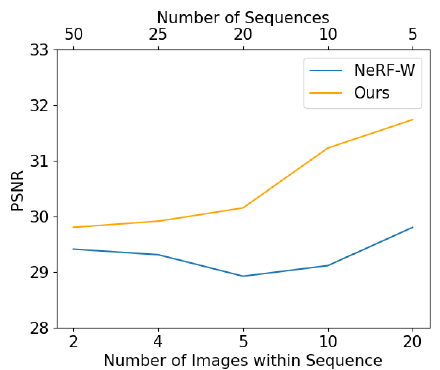

Robustness against Various Multi-sequence Settings.

우리는 다양한 멀티 시퀀스 설정에 대한 우리 방법의 견고성에 대해 논의합니다.

우리는 합성 데이터 세트에서 시퀀스당 시퀀스 수와 이미지 수가 다른 방법과 베이스라인을 평가하는 동시에 전체 학습 뷰 수를 100으로 고정합니다.

그림 8은 우리의 방법이 NeRF-W와 같은 설정 (시퀀스당 이미지 2개가 있는 50개의 시퀀스)에서도 NeRF-W를 지속적으로 능가한다는 것을 보여줍니다.

따라서 우리 방법에 적합한 시퀀스는 긴 비디오 또는 수백 프레임 컬렉션뿐만 아니라 여러 이미지로 구성된 이미지 세트입니다.

6. Conclusion

우리는 다중 시퀀스 이미지로 뉴럴 래디언스 필드를 학습하는 새로운 프레임워크인 NeRF-MS를 제시합니다.

NeRF-MS는 외관 코드에 과적합을 피하기 위해 triplet loss를 활용하고 더 나은 비정적 물체 분리를 위해 시퀀스 transient 코드를 제안합니다.

우리의 방법은 3D 일관된 반사를 재구성하고 제어 가능한 외관을 달성할 수 있습니다.

시퀀스 transient 코드는 비정적 구성 요소를 효과적으로 분리하는 반면, 기존 방법은 이러한 현상을 처리할 수 없습니다.

실험에 따르면 NeRF-MS는 다중 시퀀스로 SOTA 새로운 뷰 합성 효과를 달성합니다.

우리는 우리의 방법이 NeRF의 잠재적 응용 분야를 확장하는 데 있어 상당한 발전을 이룬다고 믿습니다.

'3D Vision > NeRF with Real-World' 카테고리의 다른 글

| RobustNeRF: Ignoring Distractors with Robust Losses (0) | 2024.10.03 |

|---|---|

| Cross-Ray Neural Radiance Fields for Novel-view Synthesis from Unconstrained Image Collections (0) | 2024.10.02 |

| NeRF for Outdoor Scene Relighting (0) | 2024.09.25 |

| Hallucinated Neural Radiance Fields in the Wild (0) | 2024.09.16 |

| NeRF in the Wild: Neural Radiance Fields for Unconstrained Photo Collections (0) | 2022.04.13 |