2024. 11. 7. 13:33ㆍDeep Learning

Depth Pro: Sharp Monocular Metric Depth in Less Than a Second

Aleksei Bochkovskii, Ama¨el Delaunoy, Hugo Germain, Marcel Santos, Yichao Zhou, Stephan R. Richter, Vladlen Koltun

Abstract

제로샷 메트릭 단안 뎁스 추정을 위한 파운데이션 모델을 제시합니다.

저희 모델인 Depth Pro는 탁월한 샤프함과 고주파수 디테일로 고해상도 뎁스 맵을 합성합니다.

예측은 카메라 intrinsic과 같은 메타데이터의 가용성에 의존하지 않고 절대 규모의 메트릭입니다.

또한 모델은 표준 GPU에서 0.3초 만에 2.25 메가픽셀 뎁스 맵을 생성하여 빠릅니다.

이러한 특성은 밀도가 높은 예측을 위한 효율적인 멀티스케일 비전 트랜스포머, 실제 및 합성 데이터 세트를 결합하여 미세 경계 추적, 추정된 뎁스 맵의 경계 정확도를 위한 전용 평가 지표, 단일 이미지에서 SOTA 초점 거리 추정과 함께 높은 메트릭 정확도를 달성하는 학습 프로토콜 등 다양한 기술적 기여를 통해 가능합니다.

광범위한 실험을 통해 특정 설계 선택 사항을 분석하고 Depth Pro가 여러 차원에서 이전 작업보다 성능이 뛰어나다는 것을 입증했습니다.

1 Introduction

제로샷 단안 뎁스 추정은 고급 이미지 편집, 뷰 합성 및 조건부 이미지 생성과 같은 점점 더 다양한 애플리케이션의 기반이 되고 있습니다.

MiDaS (Ranftl et al., 2022)와 많은 후속 작업 (Ranftl et al., 2021; Ke et al., 2024; Yang et al., 2024a; Piccinelli et al., 2024; Hu et al., 2024)에서 영감을 받은 애플리케이션은 모든 이미지에 대해 밀도가 높은 픽셀 단위 뎁스 맵을 도출하는 기능을 점점 더 활용하고 있습니다.

우리의 작업은 특히 단안 뎁스 추정의 발전으로 변화한 흥미로운 애플리케이션인 단일 이미지의 새로운 뷰 합성에 의해 동기 부여됩니다 (Hedman et al., 2017; Shih et al., 2020; Jampani et al., 2021; Khan et al., 2023).

뷰 합성과 같은 애플리케이션은 단안 뎁스 추정을 위한 여러 가지 요구 사항을 의미합니다.

첫째, 뎁스 추정기는 특정 도메인에 국한되지 않고 모든 이미지에서 제로 샷으로 작동해야 합니다 (Ranftl et al., 2022; Yang et al., 2024a).

또한 이 방법은 물체 모양, 장면 레이아웃 및 절대 척도를 정확하게 재현하기 위해 이 제로샷 체제에서 메트릭 뎁스 맵을 이상적으로 생성해야 합니다 (Guizilini et al., 2023; Hu et al., 2024).

'in the wild' 가장 광범위한 적용 가능성을 위해 이 방법은 이미지에 카메라 intrinsics (예: 초점 거리)가 제공되지 않더라도 절대 척도의 메트릭 뎁스 맵을 생성해야 합니다 (Piccinelli et al., 2024).

이를 통해 본질적으로 임의의 단일 이미지에 대해 "Synthesize a view of this scene from 63 mm away"과 같은 뷰 합성 시나리오를 사용할 수 있습니다 (Dodgson, 2004).

둘째, 가장 매력적인 결과를 얻으려면 단안 뎁스 추정기가 고해상도로 작동하고 머리카락, 털 및 기타 미세한 구조와 같은 이미지 세부 사항을 밀접하게 준수하는 세분화된 뎁스 맵을 생성해야 합니다 (Miangoleh et al., 2021; Ke et al., 2024; Li et al., 2024a).

복잡한 세부 사항을 정확하게 추적하는 샤프한 뎁스 맵을 생성할 때 얻을 수 있는 한 가지 이점은 뷰 합성과 같은 애플리케이션에서 이미지 품질을 저하시킬 수 있는 'flying pixels'을 제거한다는 것입니다 (Jampani et al., 2021).

셋째, 많은 대화형 애플리케이션 시나리오의 경우 뎁스 추정기가 낮은 지연 시간으로 작동하여 고해상도 이미지를 1초 이내에 처리하여 온디맨드 뷰 합성 "queries"를 지원해야 합니다.

낮은 지연 시간은 제로 샷 단안 깊이 추정을 신경망을 통한 단일 순방향 패스로 줄이는 방법의 일반적인 특성이지만 (Ranftl et al., 2021; Yang et al., 2024a; Piccinelli et al., 2024), 테스트 시간에 더 계산이 많이 필요한 기계를 사용하는 방법이 항상 공유하는 것은 아닙니다 (Ke et al., 2024; Li et al., 2024a).

이 연구에서 우리는 이러한 모든 요구 사항을 충족하는 제로샷 메트릭 단안 뎁스 추정을 위한 파운데이션 모델을 제시합니다.

우리의 모델인 Depth Pro는 카메라 intrinsic과 같은 메타데이터 없이도 'in the wild' 임의의 이미지에서 절대 척도의 메트릭 뎁스 맵을 생성합니다.

고해상도로 작동하여 V100 GPU에서 0.3초 만에 2.25-메가픽셀 뎁스 맵 (선택 사항 추가 업샘플링 전에 1536 × 1536의 기본 출력 해상도)을 생성합니다.

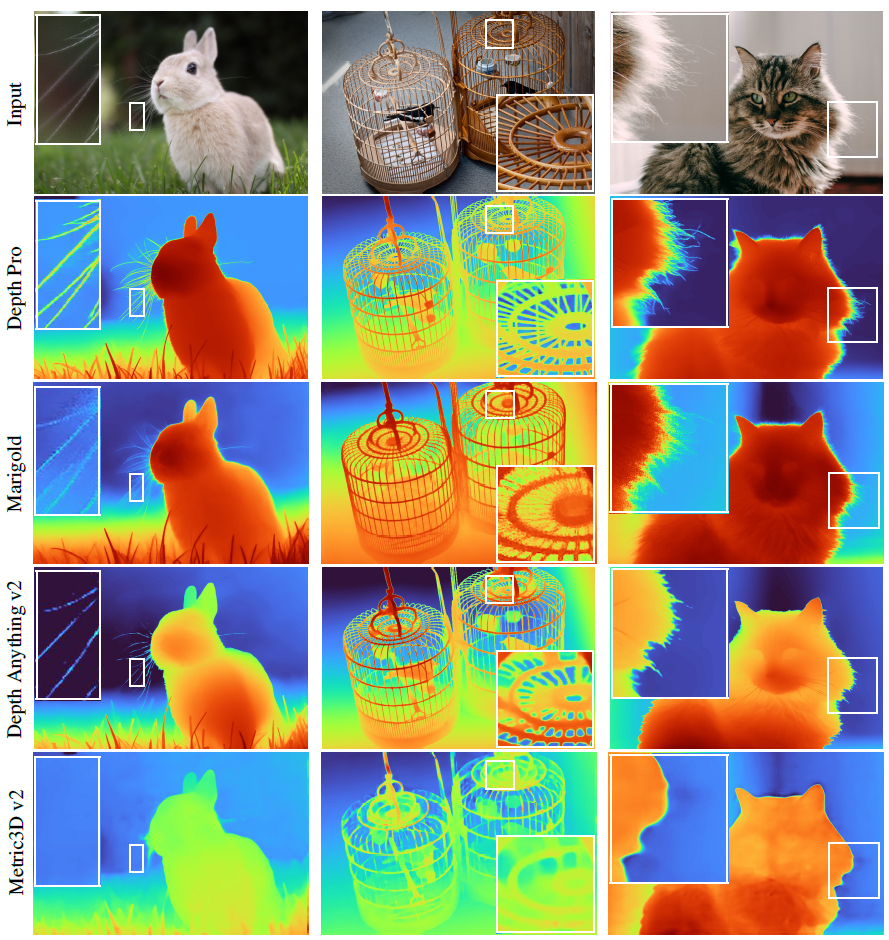

그림 1은 몇 가지 대표적인 결과를 보여줍니다.

Depth Pro는 머리카락, 털, 식생과 같은 미세한 구조를 포함하여 물체 경계를 선명하게 묘사하는 모든 이전 작업을 극적으로 능가합니다.

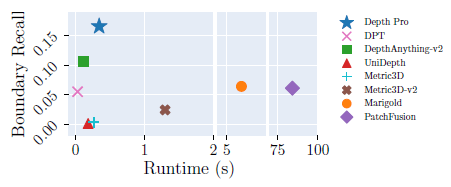

그림 2에 표시된 것처럼 Depth Pro는 경계 회상에서 모든 이전 작업을 곱셈 요소만큼 능가하는 탁월한 경계 추적 기능을 제공합니다 (자세한 내용은 섹션 4 참조).

경계 정확도에서 이전 최신 기술 (Ke et al., 2024; Li et al., 2024a)과 비교했을 때 Depth Pro는 1~2배 더 빠르며 훨씬 더 정확한 경계를 생성하며 절대 척도의 메트릭 뎁스 맵을 제공합니다.

Depth Pro는 여러 기술적 기여에 의해 활성화됩니다.

첫째, 전역 이미지 컨텍스트를 캡처하는 동시에 고해상도의 미세한 구조를 준수하기 위한 효율적인 멀티 스케일 ViT 기반 아키텍처를 설계합니다.

둘째, 단안 뎁스 맵을 평가할 때 경계 추적의 정확도를 정량화하기 위해 매우 정확한 매팅 데이터 세트를 활용할 수 있는 새로운 메트릭 세트를 도출합니다.

셋째, 정확한 픽셀 단위 ground truth를 제공하지만 현실감이 제한된 합성 데이터 세트와 함께 경계 주변에서 coarse하고 부정확한 supervision을 제공하는 실제 데이터 세트를 학습하면서 샤프한 뎁스 추정을 촉진하는 loss 함수 세트와 학습 커리큘럼을 고안합니다.

넷째, 이전 SOTA 기술을 크게 능가하는 단일 이미지에서 제로샷 초점 거리 추정에 기여합니다.

2 Related work

단안 뎁스 추정에 대한 초기 연구는 단일 카메라로 기록된 개별 데이터 세트에 대한 학습에 중점을 두었습니다 (Saxena et al., 2009; Eigen et al., 2014; Eigen & Fergus, 2015).

이 설정은 메트릭 뎁스 예측을 직접적으로 가능하게 했지만 단일 데이터 세트와 좁은 도메인으로 제한되었습니다.

Zero-shot depth estimation.

MegaDepth (Li & Snavely, 2018)는 다양한 데이터 세트에 대한 학습을 통해 특정 도메인을 넘어 단안 뎁스 예측을 일반화할 수 있음을 입증했습니다.

MiDaS (Ranftl et al., 2022)는 scale-and-shift-invariant loss가 있는 다양한 데이터 세트의 대규모 혼합에 대한 학습을 통해 이 아이디어를 발전시켰습니다.

후속 작업에서는 이 레시피를 트랜스포머 기반 아키텍처 (Ranftl et al., 2021; Birkl et al., 2023)에 적용하고 self-supervision (Spencer et al., 2023; Yang et al., 2024a)을 통해 실현 가능한 데이터 세트를 더욱 확장했습니다.

일련의 작업은 self-supervision을 사용하여 레이블이 지정되지 않은 이미지 및 비디오 데이터에서 학습합니다 (Petrovai & Nedevschi, 2022; Yang et al., 2024a).

최근의 여러 접근 방식 (Ke et al., 2024; Gui et al., 2024)은 디퓨전 모델을 활용하여 상대 뎁스 맵을 합성합니다.

이러한 방법 중 일부는 우수한 일반화를 보여주었지만, 예측은 규모와 변화가 모호하여 정확한 모양, 크기 또는 거리가 필요한 다운스트림 애플리케이션을 배제합니다.

Zero-shot metric depth.

한 연구 라인은 뎁스 값의 전역 분포 (Fu et al., 2018; Bhat et al., 2021; 2022; Li et al., 2024b)와 장면 유형에 대한 추가 조건화 (Bhat et al., 2023)를 통해 메트릭 뎁스 예측을 개선하려고 했습니다.

다른 접근 방식은 카메라 intrinsics를 직접 고려합니다.

Cam-Convs (F´acil et al., 2019)는 카메라 intrinsics에 대한 컨볼루션을 조건화했습니다.

LeReS (Yin et al., 2021)는 왜곡되지 않은 포인트 클라우드를 위한 별도의 네트워크를 학습하여 스케일과 시프트를 복구하고, Metric3D (Yin et al., 2023)는 이미지 또는 뎁스 맵을 표준 공간으로 확장하여 초점 거리를 주어진 추정된 뎁스를 재매핑하며, ZeroDepth (Guizilini et al., 2023)는 변형 프레임워크에서 카메라별 임베딩을 학습합니다.

DMD (Saxena et al., 2023)는 field-of-view에서 디퓨전 모델을 조건화합니다.

Metric3D v2 (Hu et al., 2024)는 표면 normals를 보조 출력으로 활용하여 표면 뎁스를 개선합니다.

이러한 모든 방법에는 카메라 intrinsics를 알고 정확하게 파악해야 합니다.

보다 최근의 연구에서는 별도의 네트워크를 통해 (Spencer et al., 2024) 또는 구형 공간 (Piccinelli et al., 2024)에서 뎁스 예측을 조건화하기 위한 카메라 임베딩을 예측하여 알려지지 않은 카메라 intrinsics에 대해 추론하려고 시도합니다.

이러한 최근의 접근 방식과 마찬가지로, 우리의 방법은 초점 거리를 입력으로 제공할 필요가 없습니다.

우리는 뎁스 예측 네트워크의 중간 피쳐에서 field-of-view를 직접 추정하고, 이것이 도메인 간 초점 거리 추정 작업에서 이전 기술을 크게 능가한다는 것을 보여줄 것을 제안합니다.

Sharp occluding contours.

SharpNet (Ramamonjisoa & Lepetit, 2019)은 노멀 및 폐색 윤곽 제약을 통합하지만 학습 중에 추가 윤곽 및 노멀 supervision이 필요합니다.

BoostingDepth (Miangoleh et al., 2021)는 저해상도 네트워크에서 이미지 패치에 독립적으로 적용하여 자세한 예측을 얻습니다.

패치에는 전역 컨텍스트가 없기 때문에 BoostingDepth는 정교한 다단계 파이프라인을 통해 이를 융합합니다.

PatchFusion (Li et al., 2024a)은 종단 간 학습을 가능하게 하는 이미지 적응형 패치 샘플링과 맞춤형 모듈을 통해 이 개념을 개선합니다.

최근의 작업 라인은 디퓨전 priors를 활용하여 폐색 경계의 샤프함을 향상시킵니다 (Gui et al., 2024; Ke et al., 2024).

이러한 접근 방식은 주로 상대적 (메트릭보다는) 뎁스를 예측하는 데 중점을 둡니다.

우리는 작업별 모듈이나 디퓨전 priors 없이 더 간단한 아키텍처를 제안하고 메트릭 뎁스 맵을 생성하고 런타임을 두 배 이상 줄이면서 더 샤프하고 정확한 결과를 얻을 수 있음을 보여줍니다.

가이드 뎁스 초해상도는 입력 이미지를 사용하여 저해상도 뎁스 예측을 업샘플링합니다 (Metzger et al., 2023; Zhong et al., 2023).

SMDNet (Tosi et al., 2021)은 이중 모드 혼합 밀도를 예측하여 폐색 윤곽을 개선합니다.

그리고 Ramamonjisoa et al. 2020은 사전 학습된 네트워크의 뎁스 경계를 개선하는 학습 모듈을 소개합니다.

이러한 작업은 우리의 작업과 직교하며 고해상도 예측을 추가로 업샘플링하는 데 적용될 수 있습니다.

예측 뎁스 맵에서 경계 추적을 평가하기 위해 Koch et al. (2018)은 폐색 윤곽 및 해당 메트릭에 대한 수동 주석이 포함된 iBims 데이터 세트를 소개합니다.

수동 주석과 매우 정확한 뎁스 ground truth의 필요성으로 인해 벤치마크는 작은 실내 장면 세트로 제한됩니다.

우리는 ground truth 뎁스를 얻을 수 없는 복잡하고 역동적인 환경 또는 매우 미세한 세부 사항을 가진 장면에 대한 평가를 가능하게 함으로써 상호 보완적인 관점을 제공하는 세그멘테이션 및 매팅 데이터 세트 기반 메트릭을 제공합니다.

Multi-scale vision transformers.

Vision transformers (ViT)는 인식 작업을 위한 주요 범용 아키텍처로 부상했지만 저해상도로 작동합니다 (Dosovitskiy et al., 2021).

계산 복잡성으로 인해 아키텍처를 더 높은 해상도로 나이브하게 확장하는 것은 불가능합니다.

여러 연구에서 어텐션 레이어를 ViT 확장의 주요 장애물로 식별하고 대안을 제안했습니다 (Zhu et al., 2021; Liu et al., 2021; Li et al., 2022c; Chu et al., 2021; Liu et al., 2022a; 2023; Cai et al., 2023; Jaegle et al., 2022).

또 다른 작업 라인은 피쳐 계층 구조를 생성하기 위해 ViT 아키텍처를 수정했습니다 (Fan et al., 2021; Xie et al., 2021; Yuan et al., 2021; Ranftl et al., 2021; Chen et al., 2021; Lee et al., 2022).

계산 비용이 많이 드는 재학습이 필요한 ViT 아키텍처를 수정하는 대신, 멀티 스케일에서 일반 ViT 백본을 적용하고 예측을 단일 고해상도 출력으로 융합하는 네트워크 아키텍처를 제안합니다.

이 아키텍처는 새로운 변형을 (Oquab et al., 2024; Peng et al., 2022b; Sun et al., 2023)에서 쉽게 교체할 수 있기 때문에 ViT 사전 학습의 지속적인 개선의 이점을 누릴 수 있습니다.

사전 학습된 비전 트랜스포머는 시맨틱 세그멘테이션 및 객체 감지를 위해 채택되었습니다.

ViT-Adapter (Chen et al., 2023)와 ViT-CoMer (Xia et al., 2024)는 사전 학습된 ViT에 컨볼루션 네트워크를 추가하여 밀도를 예측하는 반면, ViT-Det (Li et al., 2022b)은 사전 학습된 ViT 위에 피쳐 피라미드를 구축합니다.

이와는 달리, 우리는 멀티 스케일에서 적용된 ViT의 피쳐를 융합하여 로컬 디테일과 함께 전역 컨텍스트를 학습합니다.

3 Method

3.1 Network

우리 아키텍처의 핵심 아이디어는 멀티 스케일로 추출된 패치에 일반 ViT 인코더 (Dosovitskiy et al., 2021)를 적용하고 패치 예측을 종단 간 학습 가능한 모델에서 단일 고해상도 밀도 예측에 융합하는 것입니다.

그림 3은 아키텍처를 보여줍니다.

뎁스를 예측하기 위해 패치 인코더와 이미지 인코더라는 두 개의 ViT 인코더를 사용합니다.

패치 인코더는 멀티 스케일에서 추출된 패치에 적용됩니다.

직관적으로 이를 통해 가중치가 스케일 간에 공유됨에 따라 스케일 불변 표현을 학습할 수 있습니다.

이미지 인코더는 패치 예측을 전역 컨텍스트에 고정합니다.

선택한 인코더 백본의 기본 입력 해상도에 다운샘플링된 전체 입력 이미지에 적용됩니다 (우리의 경우 384×384).

전체 네트워크는 1536×1536의 고정 해상도로 작동하며, 이는 ViT의 384×384 배수로 선택되었습니다.

이를 통해 모든 이미지에 대해 충분히 큰 수용 필드와 일정한 런타임을 보장하는 동시에 메모리 부족 오류를 방지할 수 있습니다 (대형 이미지의 가변 해상도 접근 방식에 대해 반복적으로 관찰했습니다).

이러한 설계 선택을 확인한 결과, 섹션 4와 표 5에 보고된 결과는 Depth Pro가 가변 해상도 접근 방식보다 일관되게 빠르면서도 더 정확하고 더 샤프한 경계를 생성한다는 것을 보여줍니다.

맞춤형 인코더보다 일반 ViT 인코더에서 아키텍처를 조립할 때 얻을 수 있는 주요 이점은 활용할 수 있는 사전 학습된 ViT 기반 백본이 풍부하다는 것입니다 (Oquab et al., 2024; Peng et al., 2022b; Sun et al., 2023).

우리는 사전 학습된 몇 가지 백본을 평가하고 우리 아키텍처를 부록의 다른 고해상도 아키텍처와 비교합니다(표 8 및 섹션 B.2).

1536×1536으로 다운샘플링한 후 입력 이미지는 384×384 패치로 분할됩니다.

두 개의 가장 작은 스케일의 경우, seams를 피하기 위해 패치가 겹치도록 했습니다.

각 스케일에서 패치는 패치 인코더에 공급되며, 패치는 입력 패치당 해상도 24×24의 피쳐 텐서를 생성합니다 (그림 3의 피쳐 3 - 6).

가장 큰 스케일에서 중간 피쳐 (그림 3의 피쳐 1 및 2)을 추가로 추출하여 세분화된 세부 정보를 캡처합니다.

우리는 피쳐 패치를 맵으로 병합하고, 이는 DPT 디코더 (Ranftl et al., 2021)와 유사합니다.

스케일 간에 표현을 공유하는 것 외에도 인코더 네트워크의 패치 기반 애플리케이션은 패치를 독립적으로 처리할 수 있으므로 사소한 병렬화를 허용합니다.

계산 효율성의 또 다른 원인은 ViT를 더 높은 해상도로 확장하는 것에 비해 패치 기반 처리의 계산 복잡성이 낮기 때문입니다.

그 이유는 입력 픽셀 수에 따라 계산 복잡성이 2차적으로 확장되어 이미지 차원이 4차적으로 확장되는 멀티헤드 셀프 어텐션 (Vaswani et al., 2017)입니다.

3.2 Sharp monocular depth estimation

Training objectives.

각 입력 이미지 I에 대해 네트워크 f는 표준 인버스 뎁스 이미지 C = f(I)를 예측합니다.

밀도가 높은 메트릭 뎁스 맵 D_m을 얻기 위해 초점 거리 f_px와 너비 w로 표시되는 수평 field of view로 확장합니다 (Yin et al., 2023): D_m = f_px / wC .

표준 인버스 뎁스를 기반으로 하는 몇 가지 objectives를 가지고 학습하는데, 이는 더 먼 영역이나 전체 장면보다 카메라에 가까운 영역을 우선시하므로 새로운 뷰 합성과 같은 애플리케이션에서 시각적 품질을 지원하기 때문입니다.

ˆC를 ground truth 표준 인버스 뎁스라고 가정합니다.

모든 메트릭 데이터 세트에 대해 픽셀 i당 mean absolute error (L_MAE, 식 1)를 계산하고 실제 세계(합성이 아닌) 데이터 세트의 이미지당 상위 20%의 오차가 있는 픽셀을 폐기합니다: (1)

모든 비메트릭 데이터 세트(즉, 신뢰할 수 있는 카메라 intrinsics가 없거나 규모가 일관되지 않은 데이터 세트)에 대해 loss를 적용하기 전에 중앙값의 평균 절대 편차 (Ranftl et al., 2022)를 통해 예측과 ground truth를 정규화합니다.

우리는 멀티 스케일에서 (표준) 인버스 뎁스 맵의 1차 및 2차 도함수에 대한 오류를 추가로 계산합니다.

∇_∗가 Scharr (S) (Scharr et al., 1997) 또는 Laplace (L)와 같은 공간 도함수 연산자 ∗를 가리키고, p 오차 norm을 가리킨다고 가정합니다.

우리는 M 스케일에 대한 멀티 스케일 파생 loss를 (2)로 정의하며, 여기서 스케일 j는 인버스 뎁스 맵을 스케일당 2배씩 블

요약으로 평균 절대 기울기 오차 LMAGE = LS,1,6, 평균 절대 라플라스 오차 LMALE = LL,1,6, 평균 제곱 기울기 오차 LMSGE = LS,2,6을 정의합니다. 러링 및 다운샘플링하여 계산됩니다.

요약으로 Mean Absolute Gradient Error L_MAGE = L_(S,1,6), 평균 절대 라플라스 오차 LMALE = LL,1,6, Mean

Absolute Laplace Error L_MSGE = L_(S,2,6)을 정의합니다.

Training curriculum.

우리는 다음 관찰에 기반한 학습 커리큘럼을 제안합니다.

첫째, 실제와 합성 데이터 세트의 대규모 혼합에 대한 학습은 제로 샷 정확도로 측정할 때 일반화를 개선합니다 (Ranftl et al., 2022; 2021; Yang et al., 2024a; Hu et al., 2024).

둘째, 합성 데이터 세트는 픽셀 정확도의 ground truth를 제공하는 반면, 실제 데이터 세트에는 종종 누락된 영역, 일치하지 않는 뎁스 또는 객체 경계에 대한 잘못된 측정이 포함됩니다.

셋째, 학습 과정에서 예측이 더욱 샤프해집니다.

이러한 관찰을 기반으로 2단계 학습 커리큘럼을 설계합니다.

첫 번째 단계에서는 네트워크가 여러 도메인에 걸쳐 일반화할 수 있는 강력한 피쳐를 학습하는 것을 목표로 합니다.

이를 위해 레이블이 지정된 모든 학습 세트를 혼합하여 학습합니다.

특히 메트릭 데이터 세트의 L_MAE와 비메트릭 데이터 세트의 정규화 버전을 최소화합니다.

L_MAE는 잠재적으로 손상될 수 있는 실제 ground truth를 처리하는 견고성으로 인해 선택되었습니다.

네트워크를 샤프한 경계로 유도하기 위해 예측의 그래디언트도 supervise하는 것을 목표로 합니다.

그러나 나이브하게 수행하면 최적화를 방해하고 수렴 속도를 늦출 수 있습니다.

합성 데이터 세트에만 적용되는 그래디언트에 대한 스케일-및-시프트-불변 loss가 가장 잘 작동한다는 것을 발견했습니다.

통제된 실험은 부록에 보고되어 있습니다.

두 번째 단계의 학습은 경계를 강화하고 예측된 뎁스 맵에서 세부 사항을 공개하도록 설계되었습니다.

부정확한 ground truth의 영향을 최소화하기 위해 이 단계에서는 고품질 픽셀 정확 ground truth를 제공하는 합성 데이터 세트에 대해서만 학습합니다.

(이는 합성 데이터에 대한 첫 번째 학습을 한 다음 실제 데이터에 대한 파인튜닝이라는 일반적인 관행을 뒤집는 것입니다(Gaidon et al., 2016; G´omez et al., 2023; Sun et al., 2021).)

특히, 우리는 다시 L_MAE를 최소화하고 1차 및 2차 파생에 대한 loss를 선택하여 보완합니다: L_MAGE, L_MALE 및 L_MSGE. 부록의 각 단계에서 적용되는 loss 함수에 대한 자세한 사양을 제공합니다.

Evaluation metrics for sharp boundaries.

새로운 뷰 합성과 같은 애플리케이션은 객체 경계를 준수하기 위해 뎁스 맵이 필요합니다.

이는 얇은 구조물의 경우 특히 어렵습니다.

경계가 잘못 정렬되거나 블러해지면 객체가 왜곡되거나 부분으로 분할될 수 있습니다.

단안 뎁스 예측을 위한 일반적인 벤치마크는 경계 샤프함을 거의 고려하지 않습니다.

이는 부분적으로 정확한 픽셀 정확한 ground truth 뎁스를 가진 다양하고 사실적인 데이터 세트가 부족하기 때문일 수 있습니다.

이러한 단점을 해결하기 위해 뎁스 경계 평가를 위한 새로운 메트릭 세트를 제안합니다.

우리의 주요 관찰은 매트, 현저성 또는 분할에 대한 기존의 고품질 주석을 뎁스 경계에 대한 ground truth로 활용할 수 있다는 것입니다.

이러한 작업에 대한 주석을 객체와 환경 간의 전경/배경 관계를 정의하는 이진 맵으로 취급합니다.

(이러한 관계는 모든 경우에 적용되지 않을 수 있습니다. 그러나 수동 검사를 통해 이러한 문제가 있는 사례를 쉽게 버릴 수 있습니다. 주석을 달기보다는 분할 마스크를 걸러내는 것이 훨씬 쉽습니다.)

관계가 유지되는지 확인하기 위해 이진 맵의 가장자리 주변 픽셀만 고려합니다.

우리는 먼저 뎁스 맵에 대한 메트릭을 정의하고 나중에 이진 세그멘테이션 마스크에 대한 공식을 도출합니다.

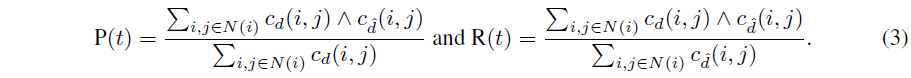

ranking loss (Chen et al., 2016)에 동기를 부여하여 이웃 픽셀의 쌍별 뎁스 비율을 사용하여 전경/배경 관계를 정의합니다.

i, j를 이웃하는 두 픽셀의 위치라고 가정합니다.

그런 다음 뎁스 맵 d에서 파생된 폐색 윤곽 c_d를 c_d(i, j) = [d(j) / d(i) > (1 + t/100)]로 정의하며, 여기서 [·]는 Iverson bracket입니다.

직관적으로 이는 픽셀 i와 j 사이에 해당 뎁스가 t% 이상 다른 경우 폐색 윤곽이 존재함을 나타냅니다.

그런 다음 모든 이웃 픽셀 쌍에 대해 precision (P)와 recall (R)을

으로 계산할 수 있습니다.

P와 R은 모두 스케일-불변입니다.

실험에서 우리는 F1 score를 보고합니다.

여러 상대 뎁스 비율을 설명하기 위해 t_min = 5에서 t_max = 25까지 선형 범위의 임계값으로 F1 값의 가중 평균을 추가로 수행하며, 높은 임계값에 대한 가중치가 더 강합니다.

다른 에지 기반 메트릭 (iBims (Koch et al., 2018)의 에지 정확도 및 완료와 같이)과 비교했을 때, 우리의 메트릭은 수동 에지 주석이 필요하지 않고 단순히 픽셀 단위의 ground truth만 필요하며, 이는 합성 데이터 세트에서 쉽게 얻을 수 있습니다.

마찬가지로 실제 세그멘테이션, 현저성 및 매팅 데이터 세트에서 도출할 수 있는 이진 레이블 맵에서 폐색 윤곽을 식별할 수도 있습니다.

이미지 위에 이진 마스크 b가 주어지면 픽셀 i, j 사이에 폐색 윤곽 c_b의 존재를 c_b(i, j) = b(i) ∧ ¬ b(j)로 정의합니다.

이 정의를 통해 우리는 식 3의 뎁스 맵에서 폐색 윤곽을 이진 맵에서 얻은 윤곽으로 대체하여 recall R(t)을 계산합니다.

이진 맵은 일반적으로 전체 객체를 라벨링하기 때문에 객체 실루엣과 일치하지 않는 ground truth 폐색 윤곽을 얻을 수 없습니다.

따라서 경계 주석은 불완전하지만 이 절차에 의해 모든 폐색 윤곽이 식별되지는 않습니다.

따라서 우리는 recall만 계산할 수 있지만 이진 맵에 대한 정밀도는 계산할 수 없습니다.

블러 가장자리에 불이익을 주기 위해 c_ˆd(i, j) 연결된 구성 요소의 유효한 범위 내에서 c_ˆd의 최대가 아닌 값을 억제합니다.

추가 실험 및 정성적 결과는 부록을 참조합니다.

3.3 Focal length estimation

부정확하거나 누락된 EXIF 메타데이터가 있을 수 있는 이미지를 처리하기 위해 초점 거리 추정 헤드로 네트워크를 보완합니다.

작은 컨볼루션 헤드는 뎁스 추정 네트워크에서 frozen 피쳐를 수집하고 별도의 ViT 이미지 인코더에서 작업별 피쳐를 수집하여 수평 각도 field-of-view를 예측합니다.

우리는 학습 loss로 L2를 사용합니다.

우리는 뎁스 추정 학습 후 초점 거리 헤드와 ViT 인코더를 학습합니다.

초점 거리 학습을 분리하면 뎁스 네트워크와의 공동 학습에 비해 몇 가지 이점이 있습니다.

뎁스 및 초점 거리 학습 objective의 균형을 맞출 필요가 없습니다.

또한 뎁스 추정 네트워크 학습에 사용되는 일부 좁은 도메인 단일 카메라 데이터 세트를 제외한 다양한 데이터 세트에서 초점 거리 헤드를 학습하고 초점 거리 supervision은 제공하지만 뎁스 supervision은 제공하지 않는 대규모 이미지 데이터 세트를 추가할 수 있습니다.

자세한 내용은 부록에 나와 있습니다.

4 Experiments

이 섹션에서는 주요 결과를 요약합니다.

데이터 세트, 하이퍼파라미터, 실험 프로토콜 및 그림 2에 요약된 런타임 비교에 대한 세부 정보를 포함한 추가 세부 정보와 실험이 부록에 보고되어 있습니다.

또한 부록에서는 네트워크 아키텍처, 학습 objectives 및 학습 커리큘럼에 대한 통제된 연구를 포함한 통제된 실험도 보고합니다.

여기에서는 Depth Pro와 SOTA 메트릭 단안 뎁스 추정 시스템의 여러 주요 비교를 요약합니다.

이러한 비교를 수행하는 데 있어 한 가지 과제는 많은 최신 시스템이 맞춤형 데이터 세트 조합에 대해 학습된다는 것입니다.

일부 시스템은 공개적으로 사용할 수 없는 독점 데이터 세트를 사용하고 일부 시스템은 제한적 라이선스에서만 사용할 수 있는 데이터 세트를 사용합니다.

일부 최신 시스템은 레이블이 지정되지 않은 데이터 세트를 학습하거나 추가 대규모 데이터 세트에 대해 학습된 사전 학습된 모델 (예: 디퓨전 모델)을 통합하기도 합니다.

이는 학습 데이터 (예: 우리와 동일한 데이터 세트를 사용하는 시스템과만 비교)를 제어하는 비교 가능성을 배제합니다.

이 연구 영역의 현재 단계에서 다른 선도적인 교차 도메인 단안 뎁스 추정 모델과 비교할 수 있는 유일한 방법은 전체 system-to-system입니다.

완전히 학습된 모델 (각각 대규모, 부분적으로 중복되고 부분적으로 구별되는 데이터 세트로 학습됨)은 비교된 시스템 중 어느 것도 학습되지 않은 데이터 세트에서 서로 제로샷으로 비교됩니다.

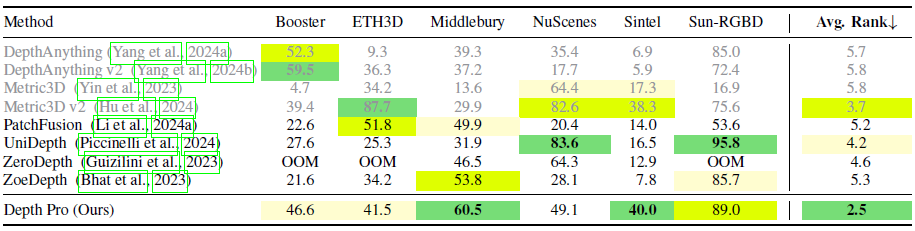

Zero-shot metric depth.

우리는 제로샷 메트릭 뎁스를 예측하는 방법의 능력을 평가하고 표 1의 최신 기술과 비교합니다.

우리의 베이스라인에는 Depth Anything (Yang et al., 2024a), Metric3D (Yin et al., 2023), PatchFusion (Li et al., 2024a), UniDepth (Piccinelli et al., 2024), ZeroDepth (Guizilini et al., 2023) 및 ZoeDepth (Bhat et al., 2023)가 포함됩니다.

또한 가장 최근의 Depth Anything v2 (Yang et al., 2024b) 및 Metric3D v2 (Hu et al., 2024)에 대한 결과도 보고합니다.

메트릭 뎁스 정확도의 전반적인 요약 척도로, 표 1은 이 목적에 일반적으로 사용되는 δ1 메트릭 (Ladicky et al., 2014)을 사용합니다 (Yin et al., 2023; Yang et al., 2024a; Piccinelli et al., 2024).

이는 예측된 뎁스와 ground truth 뎁스가 서로 25% 이내인 인라이어 픽셀의 백분율로 정의됩니다.

우리는 이 메트릭의 견고성을 위해 이 메트릭을 선택했으며, 문헌에서 가장 엄격한 임계값(25%)을 발견했습니다.

추가 메트릭에 대한 해당 표는 AbsRel (Ladicky et al., 2014), Log10, δ2, δ3 점수 및 포인트 클라우드 메트릭 (Spencer et al., 2022)을 포함한 부록의 섹션 A.2에서 확인할 수 있습니다.

표 1은 또한 데이터 세트 간 성능을 요약하는 일반적인 방법인 데이터 세트 간 각 방법의 평균 순위를 보고합니다(Ranftl et al., 2022).

부스터, 미들버리, 선에 대한 결과를 보고합니다-

Booster (Ramirez et al., 2024), Middlebury (Scharstein et al., 2014), Sun-RGBD (Song et al., 2015), ETH3D (Sch¨ops et al., 2017), nuScenes (Caesar et al., 2020) 및 Sintel (Butler et al., 2012)은 평가된 시스템을 학습하는 데 사용된 적이 없기 때문에 저희가 아는 한, 평가된 시스템을 학습하는 데 사용된 적이 없습니다.

최선의 노력에도 불구하고 높은 이미지 해상도로 인해 메모리가 지속적으로 부족하여 Booster, Middlebury 또는 Sun-RGBD에서 ZeroDepth를 실행할 수 없었습니다.

평가 설정에 대한 자세한 내용은 부록의 C.에서 확인할 수 있습니다.

표 1의 결과는 일부 주요 메트릭 뎁스 추정 모델에서 상당한 도메인 편향을 관찰한 Picinelli et al. (2024)의 결과를 확인시켜줍니다.

특히, Depth Anything v1 및 v2는 상대적 뎁스 추정에 초점을 맞추고 있으며, 메트릭 뎁스의 경우 실내 또는 실외 장면에 맞게 파인튜닝된 다양한 도메인에 대해 서로 다른 모델을 제공합니다.

Metric3D v1 및 v2는 도메인 불변 모델을 제공하지만, 테스트 시점에 크롭 크기를 신중하게 선택하는 데 따라 성능이 크게 달라지므로 실험에서 도메인당 수행되므로 제로샷 전제를 위반합니다.

이미지의 종횡비를 기반으로 크롭 크기를 자동으로 설정하려고 시도했지만, 이로 인해 Metric3D의 성능이 크게 저하되었고, 이러한 이유로 권장되는 도메인별 크롭 크기와 함께 권장되는 제로샷이 아닌 프로토콜을 사용합니다.

도메인별 모델과 크롭 크기는 우리(및 기타 베이스라인)가 운영하는 엄격한 제로샷 전제를 위반하므로, 표 1에서 Depth Anything 및 Metric3D 결과를 회색으로 표시합니다.

우리는 Depth Pro가 데이터 세트당 상위 접근 방식 중 일관되게 점수를 매기고 모든 데이터 세트에서 최고의 평균 순위를 얻음으로써 가장 강력한 일반화를 보여준다는 것을 발견했습니다.

Zero-shot boundaries.

표 2는 Depth Pro와 여러 베이스라인에 대한 경계 정확도 평가를 요약한 것입니다.

이 평가는 제로샷 설정에서 수행되며, 모델은 학습 중에 볼 수 없었던 데이터 세트에 대해서만 평가됩니다.

경계 메트릭은 규모 불변이기 때문에 여기에는 절대 메트릭이 아닌 상대적인 뎁스만 예측하는 방법도 포함됩니다.

절대 베이스라인에는 Metric3D (Yin et al., 2023), Metric3D v2 (‘giant’ model) (Hu et al., 2024), PatchFusion (Li et al., 2024a), UniDepth (Piccinelli et al., 2024), 및 ZoeDepth (Bhat et al., 2023)가 포함됩니다.

또한 메트릭보다 더 샤프한 경계를 생성하기 때문에 Depth Anything v1 & v2 (Yang et al., 2024a;b)의 상대적 변형에 대한 결과도 보고합니다.

마지막으로, 충실도가 높은 예측으로 인해 인기를 얻은 최근의 디퓨전 기반 상대적 뎁스 모델인 Marigold (Ke et al., 2024)를 포함합니다.

섹션 3.2에 소개된 경계 메트릭을 사용하고, ground truth 뎁스가 있는 데이터 세트의 평균 경계 F1 score와 매팅 또는 세그멘테이션 주석이 있는 데이터 세트의 경계 recall (R)을 보고합니다.

이미지 매팅 데이터 세트의 경우, 픽셀은 알파 매트의 값이 0.1 이상일 때 일치하는 것으로 표시됩니다.

데이터 세트에는 합성 데이터인 Sintel (Butler et al., 2012)과 Spring (Mehl et al., 2023)이 포함됩니다.

또한 해상도가 낮음에도 불구하고 뎁스 경계를 평가하는 데 주로 사용되는 iBims 데이터 세트 (Koch et al., 2018)도 포함되어 있습니다.

iBims별 메트릭의 전체 슬레이트는 부록을 참조합니다.

자연 이미지에서 발생하는 고주파 구조(예: 머리카락 또는 털)를 평가하기 위해 이미지 매팅 모델 (Li et al., 2023)을 평가하는 데 사용된 고해상도 이미지 매팅 데이터 세트인 AM-2k (Li et al., 2022a) 및 P3M-10k (Li et al., 2021)를 사용합니다.

또한 DIS-5k (Qin et al., 2022) 이미지 세그멘테이션 데이터 세트에 대한 추가 결과를 보고합니다.

이는 다양한 이미지에 걸쳐 매우 정확한 바이너리 마스크를 제공하는 객체 세그멘테이션 데이터 세트입니다.

세그멘트된 객체가 전경 객체에 의해 가려지는 샘플을 수동으로 제거합니다.

그림 2는 런타임의 함수로서 AM-2k 데이터 세트의 경계 recall 메트릭을 시각적으로 요약합니다.

우리는 Depth Pro가 모든 데이터 세트에서 모든 베이스라인보다 상당한 차이로 더 정확한 경계를 생성한다는 것을 발견했습니다.

그림 1에서 볼 수 있듯이, 표 2의 이미지와 섹션 A의 추가 결과에서 볼 수 있듯이 최근의 Metric3D v2 및 Depth Anything v2 모델의 경쟁 지표 정확도는 샤프한 경계를 의미하지 않습니다.

Depth Pro는 머리카락과 털과 같은 얇은 구조에 대해 지속적으로 더 높은 recall을 가지며 더 샤프한 경계를 생성합니다.

이는 수십억 개의 실제 단어 이미지에 대해 사전 학습된 것을 활용하는 디퓨전 기반 Marigold와 가변 해상도로 작동하는 PatchFusion과 비교했을 때도 마찬가지입니다.

Depth Pro의 런타임은 Marigold 및 PatchFusion보다 훨씬 빠릅니다 (그림 2 및 표 5 참조).

그림 4는 단일 이미지에서 새로운 뷰 합성을 위한 샤프한 경계 예측의 이점을 보여줍니다.

Focal length estimation.

이전 연구 (Piccinelli et al., 2024; Kocabas et al., 2021; Baradad & Torralba, 2020)에서는 야생 이미지에 대한 초점 거리 추정기에 대한 포괄적인 체계적인 평가를 제공하지 않습니다.

이를 해결하기 위해 제로샷 테스트 데이터 세트를 큐레이팅했습니다.

이를 위해 EXIF 데이터가 손상되지 않은 다양한 데이터 세트를 선택하여 초점 거리 추정 정확도를 신뢰할 수 있는 평가를 가능하게 했습니다.

FiveK (Bychkovsky et al., 2011), DDDP (Abuolaim & Brown, 2020), 및 RAISE (Dang-Nguyen et al., 2015)는 SLR 카메라로 촬영한 전문가 수준의 사진을 제공합니다.

SPAQ (Fang et al., 2020)는 휴대폰에서 캐주얼한 사진을 제공합니다.

PPR10K (Liang et al., 2021)는 고품질 초상화 이미지를 제공합니다.

마지막으로 ZOOM (Zhang et al., 2019)에는 다양한 광학 줌 레벨에서 캡처된 장면 세트가 포함되어 있습니다.

표 3은 Depth Pro를 SOTA 초점 거리 추정기와 비교하고 상대 추정 오차가 각각 25%와 50% 미만인 이미지의 비율을 보여줍니다.

Depth Pro는 모든 데이터 세트에서 가장 정확합니다.

예를 들어, 사람의 초상화 데이터 세트인 PPR10K에서 우리의 방법은 초점 거리 오차가 25% 미만인 이미지가 64.6%로 가장 높은 반면, 두 번째로 좋은 방법인 SPEC는 이 지표에서 34.6%만 달성합니다.

우리는 이러한 우수한 성능을 뎁스 네트워크에서 초점 거리 추정기의 학습을 분리하여 이 두 작업에 대해 서로 다른 학습 세트를 사용할 수 있도록 하는 네트워크 설계 및 학습 프로토콜 덕분이라고 생각합니다.

추가 통제된 실험은 부록에 보고되어 있습니다.

5 Conclusion & Limitations

Depth Pro는 초당 실행 시간에 높은 빈도의 세부 정보를 가진 고해상도 메트릭 뎁스 맵을 생성합니다.

우리 모델은 카메라 intrinsics와 같은 메타데이터 없이 SOTA 제로샷 메트릭 뎁스 추정 정확도를 달성하고, 'in the wild' 단일 이미지에서 새로운 뷰 합성과 같은 애플리케이션을 촉진하는 전례 없는 세부 정보로 폐색 경계를 추적합니다.

Depth Pro는 여러 차원에서 이전 작업보다 성능이 뛰어나지만 제한이 없는 것은 아닙니다.

예를 들어, 이 모델은 단일 픽셀 뎁스의 정의가 잘못 제시되고 모호한 반투명 표면 및 체적 산란을 처리하는 데 제한이 있습니다.

'Deep Learning' 카테고리의 다른 글

| YOLOv11: An Overview of the Key Architectural Enhancements (0) | 2024.11.27 |

|---|---|

| Fast Segment Anything (0) | 2024.11.07 |

| Segment Anything in High Quality (1) | 2024.10.28 |

| Recognize Anything: A Strong Image Tagging Model (0) | 2024.10.18 |

| Grounded SAM: Assembling Open-World Models for Diverse Visual Tasks (1) | 2024.10.17 |