2024. 10. 17. 11:31ㆍDeep Learning

Grounded SAM: Assembling Open-World Models for Diverse Visual Tasks

International Digital Economy Academy (IDEA) & Community

Abstract

Grounding DINO [38]를 오픈셋 객체 검출기로 사용하여 segment anything model (SAM) [25]과 결합하는 Grounded SAM을 소개합니다.

이러한 통합을 통해 임의의 텍스트 입력을 기반으로 모든 영역을 감지하고 세그멘트할 수 있으며 다양한 비전 모델을 연결할 수 있는 문이 열립니다.

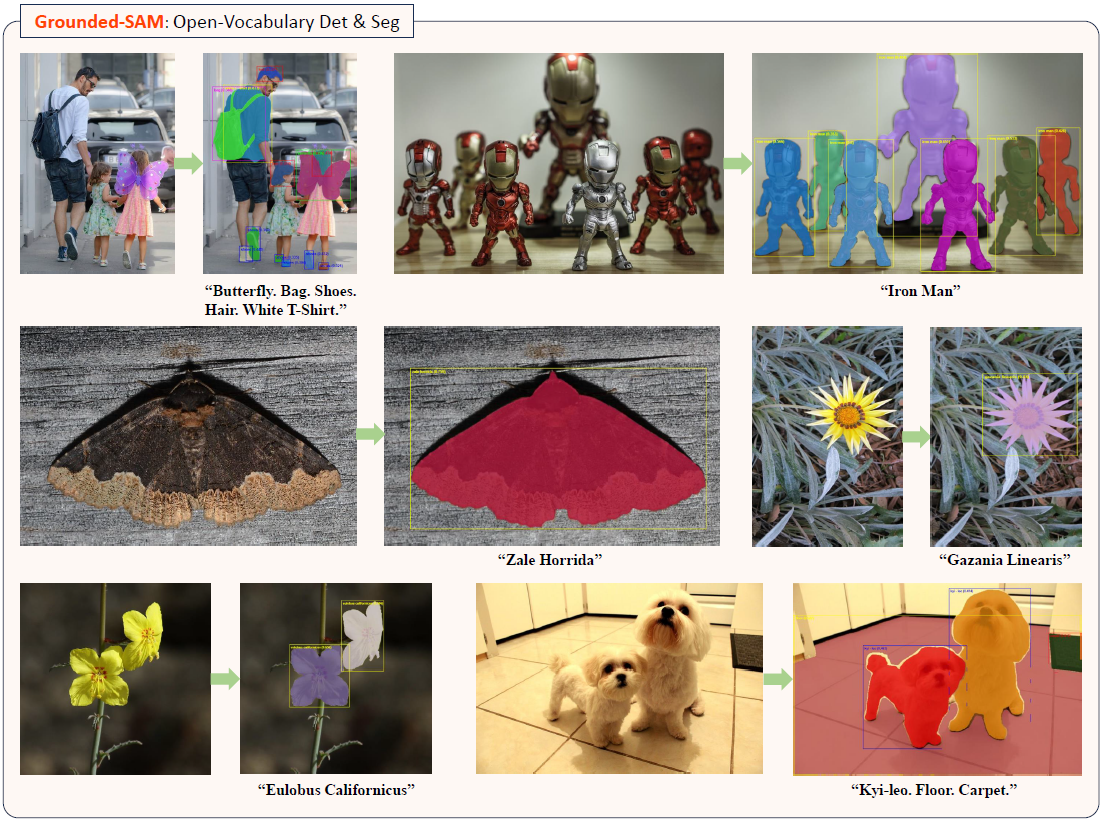

그림 1에 표시된 것처럼, 다용도 Grounded SAM 파이프라인을 사용하면 광범위한 비전 작업을 달성할 수 있습니다.

예를 들어, 입력 이미지에만 기반한 자동 주석 파이프라인은 BLIP [31] 및 Recognize Anything [83]과 같은 모델을 통합하여 구현할 수 있습니다.

또한 Stable-Diffusion [52]을 통합하면 제어 가능한 이미지 편집이 가능하며, OSX [33]를 통합하면 프롬프터블 3D 인체 동작 분석이 가능합니다.

또한 Grounded SAM은 open-vocabulary 벤치마크에서 우수한 성능을 보여주며, Grounding DINO-Base 및 SAM-Huge 모델의 조합과 함께 SegInW (Segmentation in the Wild) 제로샷 벤치마크에서 48.7 평균 AP를 달성했습니다.

1. Introduction

오픈 월드 시나리오에서 시각적 인식과 이해 작업은 자율 주행, 로봇 내비게이션, 지능형 보안 감시와 같은 애플리케이션의 발전에 매우 중요합니다.

이러한 애플리케이션에는 오픈 월드 환경을 해석하고 상호 작용할 수 있는 강력하고 다재다능한 시각 인식 모델이 필요합니다.

현재 오픈 월드 시각 인식의 과제를 해결하기 위한 세 가지 주요 방법론이 있습니다.

첫째, Unified Model 접근 방식에는 다양한 시각 작업을 지원하기 위해 여러 데이터 세트에서 UNINEXT [66] 및 OFA [59]와 같은 모델을 학습하는 것이 포함됩니다.

이 방법에는 LLaVA [34], InstructBLIP [12], Qwen-VL [3] 및 기타 MLLMs [60, 40, 80]과 같은 작업을 통합하기 위해 서로 다른 시각적 question-answering 데이터 세트에서 대형 언어 모델을 학습하는 것도 포함됩니다.

그러나 이러한 접근 방식의 상당한 한계는 데이터, 특히 오픈셋 세그멘테이션과 같은 복잡한 작업에서 제한된 범위라는 점입니다.

둘째, LLM as Controller 방법은 시각 expert와 언어 모델을 연결하려고 시도합니다.

예로는 HuggingGPT [55], Visual ChatGPT [62], LLaVA-Plus [35]가 있습니다.

이러한 접근 방식은 대형 언어 모델의 언어 이해 능력을 활용하여 다양한 시각 작업을 지시합니다.

그러나 이 방법은 대형 언어 모델의 기능과 한계에 크게 의존합니다.

셋째, Ensemble Foundation Models 접근 방식은 특정 컨텍스트에 맞게 설계된 expert 모델을 협력적으로 통합하여 복잡한 시나리오에서 오픈 월드 작업을 달성하려고 합니다.

이 접근 방식은 다양한 특수 모델의 강점을 결합하여 유연성을 제공합니다.

이러한 방법론을 통해 오픈 월드 작업을 해결하는 데 진전이 있었지만, 오픈 세트 세그멘테이션과 같은 복잡하고 근본적인 오픈 월드 작업을 지원할 수 있는 강력한 파이프라인은 아직 시장에서 부족합니다.

Grounded SAM은 앙상블 기반 모델 접근 방식의 관점에서 혁신적인 접근 방식을 취하여 Grounding DINO [38]와 같은 오픈 세트 검출기 모델과 SAM [25]과 같은 프롬프터블 세그멘테이션 모델의 통합을 개척합니다.

오픈 세트 세그멘테이션 문제를 두 가지 주요 구성 요소로 나누어 효과적으로 해결합니다: 오픈 세트 감지 및 프롬프터블 세그멘테이션.

이 접근 방식을 기반으로 하는 Grounded SAM은 다양한 expert 모델을 효율적으로 융합하여 더 복잡한 오픈 월드 작업을 처리할 수 있는 강력하고 포괄적인 플랫폼을 제공합니다.

Grounded SAM을 기반으로 구축하고 강력한 오픈셋 세그멘테이션 기능을 활용하면 추가 오픈월드 모델을 쉽게 통합할 수 있습니다.

예를 들어, RAM-Grounded-SAM 모델은 Recognize Anything (RAM) [83]과 결합하면 텍스트 입력 없이도 이미지 내의 사물이나 사물을 자동으로 식별하고 세그멘트할 수 있으므로 자동 이미지 주석 작업을 용이하게 수행할 수 있습니다.

BLIP [31]와의 통합을 통해서도 유사한 자동 이미지 주석 기능을 달성할 수 있습니다.

또한 Grounded SAM은 Grounded-SAM-SD 모델에서 예시한 것처럼 Stable Diffusion의 인페인팅 기능과 결합하면 매우 정밀한 이미지 편집 작업을 실행할 수 있습니다.

섹션 3에서 추가 오픈월드 모델의 통합을 통해 Grounded SAM과 그 증강 기능에 대해 더 자세히 설명합니다.

2. Related Work

2.1. Task-specific Vision Models

컴퓨터 비전 분야에서는 이미지 인식 [47, 31, 18, 83, 17], 일반 객체 감지 [49, 87, 43, 27, 77, 36, 19, 38, 51, 50, 20, 30], 일반 이미지 세그멘테이션 [9, 8, 26, 29, 78, 79, 25, 79, 16, 28], 참조 객체 감지 및 세그멘테이션 [41, 37, 86], 객체 추적 [67, 84], 이미지 생성 [75, 54, 48, 45, 23, 14, 52, 22, 82, 44], 이미지 편집 [42, 1, 2, 53, 21], 인간 중심 인식 및 이해 [72, 71, 73, 70, 69, 4, 33, 74], 인간 중심 동작 생성 [39, 6, 32, 61, 5] 등 다양한 작업에서 상당한 발전이 이루어졌습니다.

그러나 이러한 발전에도 불구하고 현재 모델은 대부분 작업별로 이루어지며 일반적으로 더 광범위한 작업을 처리하는 데 부족합니다.

2.2. Unified Models

여러 작업을 처리하기 위해 통합 모델이 개발되었습니다.

언어 분야에서는 자동 회귀 및 생성 접근 방식을 통해 언어 작업을 처리하는 범용 통합 모델의 예로 GPT-3 [13], LaMDA [57], PaLM [11]과 같은 Large language models (LLMs)을 들 수 있습니다.

통합되고 구조화된 토큰 표현에 의존하는 언어 작업과 달리 비전 작업은 픽셀, 공간(예: 상자, 키 포인트), 시간적 등 다양한 데이터 형식을 포함합니다.

최근 연구에서는 이러한 다양한 모달리티를 수용하기 위해 두 가지 관점에서 통합 비전 모델을 개발하려고 시도하고 있습니다.

첫째, 일부 모델은 다양한 비전 모달리티를 단일로 통합하는 것을 목표로 합니다.

예를 들어, Pix2Seq [7]과 OFA [59]는 상자 좌표와 같은 공간 양식을 언어로 통합하려고 시도합니다.

둘째, 일부 모델은 서로 다른 모달리티 출력과 호환되는 통합 모델을 찾습니다.

UNINEXT [66]은 다양한 인스턴스 레벨의 작업 출력을 지원하는 예입니다.

이러한 통합 비전 모델은 일반 지능의 발전을 앞당기고 있지만, 기존 모델은 제한된 수의 작업만 처리할 수 있으며 종종 작업별 모델의 성능에 미치지 못합니다.

2.3. Model Assembly with a Controller System

우리의 작업과 직교하는 Visual ChatGPT [62]와 HuggingGPT [55]는 서로 다른 작업을 해결하기 위해 서로 다른 AI 모델을 제어하기 위해 LLM을 활용할 것을 제안합니다.

이러한 모델과 비교하여 파운데이션 모델 조립 방법은 컨트롤러로 LLM을 사용하지 않으므로 전체 파이프라인이 더 효율적이고 유연해집니다.

우리는 복잡한 작업을 분리할 수 있고 학습이 없는 모델 조립 방식으로 단계별 시각적 추론을 달성할 수 있음을 보여줍니다.

3. Grounded SAM Playground

이 장에서는 Grounded SAM을 기반으로 다양한 영역의 expert 모델을 통합하여 보다 포괄적인 시각적 작업을 달성하는 방법을 시연합니다.

3.1. Preliminary

여기에서는 Grounded SAM 및 기타 도메인 expert 모델의 기본 구성 요소에 대해 설명합니다.

Segment Anything Model (SAM) [25]은 포인트, 상자 또는 텍스트와 같은 적절한 프롬프트로 모든 이미지의 모든 객체를 "cut out"할 수 있는 오픈 월드 세그멘테이션 모델입니다.

이 모델은 1,100만 개 이상의 이미지와 11억 개의 마스크에 대해 학습되었습니다.

강력한 제로 샷 성능에도 불구하고 이 모델은 임의의 텍스트 입력을 기반으로 마스크된 객체를 식별할 수 없으며 일반적으로 실행하려면 포인트 또는 상자 프롬프트가 필요합니다.

Grounding DINO [38]는 임의의 자유 형식 텍스트 프롬프트와 관련하여 모든 객체를 감지할 수 있는 오픈셋 객체 감지기입니다.

이 모델은 감지 데이터, 시각적 grounding 데이터 및 이미지-텍스트 쌍을 포함하여 천만 개 이상의 이미지에 대해 학습되었습니다.

강력한 제로 샷 감지 성능을 제공합니다.

그러나 이 모델은 텍스트가 입력으로 필요하며 해당 문구가 있는 상자만 감지할 수 있습니다.

OSX [33]는 단안 이미지에서 3D 인체 포즈, 손동작, 표정을 공동으로 추정하는 것을 목표로 하는 표현적 전신 메시 복구를 위한 SOTA 모델입니다.

먼저 사람 상자를 감지하고, 사람 상자를 잘라내고 크기를 조정한 다음 1인용 메시 복구를 수행해야 합니다.

BLIP [31]은 비전 언어 이해 및 생성 작업을 통합하는 비전 언어 모델입니다.

우리는 실험에서 BLIP의 이미지 캡션 모델을 사용합니다.

캡션 모델은 주어진 이미지에 대한 설명을 생성할 수 있습니다.

그러나 이 모델은 객체 감지 또는 세그멘테이션과 같은 객체-레벨의 작업을 수행할 수 없습니다.

Recognize Anything Model (RAM) [83]은 입력 이미지에 대해 정확도가 높은 일반적인 범주를 인식할 수 있는 강력한 이미지 태깅 모델입니다.

그러나 RAM은 태그만 생성할 수 있지만 인식된 범주에 대한 정확한 상자와 마스크는 생성할 수 없습니다.

Stable Diffusion [52]은 학습된 학습 데이터 분포에서 이미지를 샘플링하는 이미지 생성 모델입니다.

가장 널리 사용되는 응용 프로그램은 텍스트 프롬프트가 있는 이미지를 생성하는 것입니다.

우리는 실험에서 인페인팅 변형을 사용합니다.

이 모델은 멋진 생성 결과에도 불구하고 인식이나 이해 작업을 수행할 수 없습니다.

ChatGPT & GPT-4 [15, 46]는 대화형 AI 에이전트를 구축하는 데 사용되는 GPT (Generative Pre-trained Transformer) 아키텍처를 사용하여 개발된 대규모 언어 모델입니다.

방대한 양의 텍스트 데이터에 대해 학습되며 사용자 입력에 대해 사람과 유사한 응답을 생성할 수 있습니다.

이 모델은 대화의 맥락을 이해하고 종종 사람과 구별할 수 없는 적절한 응답을 생성할 수 있습니다.

3.2. Grounded SAM: Open-Vocabulary Detection and Segmentation

사용자가 제공한 텍스트에 언급된 영역에 해당하는 이미지에서 마스크를 결정하여 오픈 세트 세그멘테이션과 같은 세분화된 이미지 이해 작업을 가능하게 하는 것은 매우 어렵습니다.

이는 주로 야생 작업에서 세그멘테이션을 위한 고품질 데이터의 제한된 가용성 때문이며, 이는 데이터 희소성을 특징으로 하는 조건에서 모델이 정확한 오픈 세트 세그멘테이션을 달성하는 데 어려움이 있습니다.

반면, 오픈셋 감지 작업은 주로 다음 두 가지 이유로 인해 더 다루기 쉽습니다.

첫째, 감지 데이터의 주석 비용이 세그멘테이션 작업에 비해 상대적으로 낮기 때문에 더 고품질의 주석이 달린 데이터를 수집할 수 있습니다.

둘째, 오픈셋 감지는 정확한 픽셀 레벨의 객체 마스크 없이 주어진 텍스트를 기반으로 주어진 이미지를 기반으로 해당 객체 좌표를 식별하기만 하면 됩니다.

마찬가지로 상자에 조건을 두고 상자의 위치에 대한 prior 지식을 활용하여 해당 객체 마스크를 예측하는 것이 텍스트를 기반으로 지역 마스크를 직접 예측하는 것보다 더 효율적입니다.

이러한 접근 방식은 OpenSeeD [79]와 같은 이전 작업에서 검증되었으며, 데이터 희소성의 상당한 문제는 SAM [25]에서 개발된 SAM-1B 데이터 세트를 활용하여 크게 해결할 수 있습니다.

따라서 Grounded Pre-training [81, 38] 및 SAM [25]과 같은 이전의 성공적인 작업에서 영감을 받아 강력한 오픈 세트 파운데이션 모델을 결합하여 야생 작업에서 복잡한 세그멘테이션을 해결하는 것을 목표로 합니다.

입력 이미지와 텍스트 프롬프트가 주어지면 먼저 Grounding DINO를 사용하여 텍스트 정보를 조건으로 활용하여 이미지 내의 객체 또는 영역에 대한 정확한 상자를 생성합니다.

그런 다음 Grounding DINO를 통해 얻은 주석이 달린 상자는 SAM이 정확한 마스크 주석을 생성하는 상자 프롬프트 역할을 합니다.

이 두 가지 강력한 expert 모델의 기능을 활용하면 오픈 세트 감지 및 세그멘테이션 작업을 더 쉽게 수행할 수 있습니다.

그림 2에 나와 있듯이 Grounded SAM은 기존 및 롱테일 시나리오 모두에서 사용자 입력을 기반으로 텍스트를 정확하게 감지하고 세그멘트할 수 있습니다.

3.3. RAM-Grounded-SAM: Automatic Dense Image Annotation

자동 이미지 주석 시스템은 데이터 수동 주석의 효율성을 향상시키거나, 사람의 주석 비용을 줄이거나, 자율 주행에서 실시간 장면 주석과 이해를 제공하여 운전 안전을 향상시키는 등 다양한 실용적인 응용 분야를 가지고 있습니다.

Grounded SAM의 프레임워크에서는 Grounding DINO의 기능을 활용합니다.

사용자는 임의의 카테고리 또는 캡션을 입력할 수 있는 유연성을 갖게 되며, 이는 이미지 내의 개체와 자동으로 매칭됩니다.

이러한 기반을 바탕으로 이미지-캡션 모델 (BLIP [31] 및 Tag2Text [18]와 같은) 또는 이미지 태깅 모델(RAM [83과 같은])을 사용하여 출력 결과 (캡션 또는 태그)를 Grounded SAM의 입력으로 사용하고 각 인스턴스에 대한 정확한 상자 및 마스크를 생성할 수 있습니다.

이를 통해 전체 이미지에 자동으로 라벨링하여 자동 라벨링 시스템을 달성할 수 있습니다.

그림 3에 나와 있듯이 RAM-Grounded-SAM은 다양한 시나리오에서 카테고리 예측을 자동으로 수행하고 입력 이미지에 대한 밀도 높은 주석을 제공하는 기능을 보여줍니다.

이를 통해 주석 비용을 크게 절감하고 이미지 주석의 유연성을 크게 향상시킬 수 있습니다.

3.4. Grounded-SAM-SD: Highly Accurate and Controllable Image Editing

이미지 생성 모델의 강력한 text-to-image 기능을 Grounded SAM과 통합함으로써 강력한 데이터 합성 팩토리를 생성하여 파트-레벨, 인스턴스-레벨 및 시맨틱-레벨에서 세분화된 작업을 지원하는 포괄적인 프레임워크를 구축할 수 있습니다.

그림 4와 같이, 사용자는 이 파이프라인 내에서 바운딩 박스를 클릭하거나 그리기와 같은 대화형 방법을 통해 정확한 마스크를 얻을 수 있습니다.

또한 사용자는 텍스트 프롬프트와 결합된 grounding 기능을 활용하여 해당 관심 영역을 자동으로 찾을 수 있습니다.

이러한 파운데이션을 바탕으로 이미지 생성 모델의 추가 기능을 통해 이미지 표현 수정, 객체 교체, 해당 영역 제거 등 매우 정밀하고 제어된 이미지 조작을 달성할 수 있습니다.

데이터 부족이 발생하는 다운스트림 시나리오에서는 시스템이 모델 학습을 위한 데이터 요구 사항을 해결하면서 새로운 데이터를 생성할 수 있습니다.

3.5. Grounded-SAM-OSX: Promptable Human Motion Analysis

이전의 표현적 전신 메시 복구는 먼저 모든 (인스턴스에 구애받지 않는) 인체 상자를 감지한 다음 1인 메시 복구를 수행합니다.

많은 실제 애플리케이션에서 우리는 감지하고 분석할 타겟 사람을 지정해야 합니다.

그러나 기존 인체 감지기는 서로 다른 인스턴스를 구분할 수 없기 때문에(예: "a person with pink clothes"을 분석하도록 지정) 세분화된 인체 움직임 분석이 어렵습니다.

그림 5와 같이, 우리는 Grounded SAM 및 OSX [33] 모델을 통합하여 새로운 프롬프터블 (인스턴스별) 전신 인체 감지 및 메시 복구를 달성하여 프롬프터블 인체 움직임 분석 시스템을 구현할 수 있습니다.

구체적으로, 이미지와 특정 사람을 지칭하는 프롬프트가 주어지면 먼저 Grounded SAM을 사용하여 정확한 특정 인체 상자를 생성합니다.

그런 다음 OSX를 사용하여 인스턴스별 인체 메시를 추정하여 프로세스를 완료합니다.

3.6. More Extensions for Grounded SAM

앞서 언급한 기본 애플리케이션 외에도 Grounded SAM은 더 많은 모델을 통합하여 활용 범위를 더욱 확장할 수 있습니다.

예를 들어, 데이터 라벨링 프로세스에서 Grounded SAM은 FastSAM [85], MobileSAM [76], Light-HQ-SAM [24], EfficientSAM [63]과 같은 더 빠른 추론 SAM 모델과 협업할 수 있습니다.

이러한 협업은 전체 추론 시간을 크게 단축하고 라벨링 워크플로우를 가속화할 수 있습니다.

Grounded SAM은 또한 고품질 마스크를 생성할 수 있는 HQ-SAM [24] 모델을 활용하여 주석의 품질을 향상시킬 수 있습니다.

이미지 편집 영역에서 Grounded SAM은 Stable-Diffusion-XL [52]과 같이 새로 제안된 생성 모델과도 시너지 효과를 발휘하여 고품질 이미지 편집을 달성할 수 있습니다.

또한 LaMa [56] 및 PaintByExample [68]과 같은 모델과 통합하여 정확한 이미지 삭제 및 맞춤형 이미지 편집을 달성할 수 있습니다.

Grounded SAM은 특정 텍스트 프롬프트를 기반으로 객체 추적을 수행하기 위해 DEVA [10]와 같은 추적 모델과도 통합할 수 있습니다.

4. Effectiveness of Grounded SAM

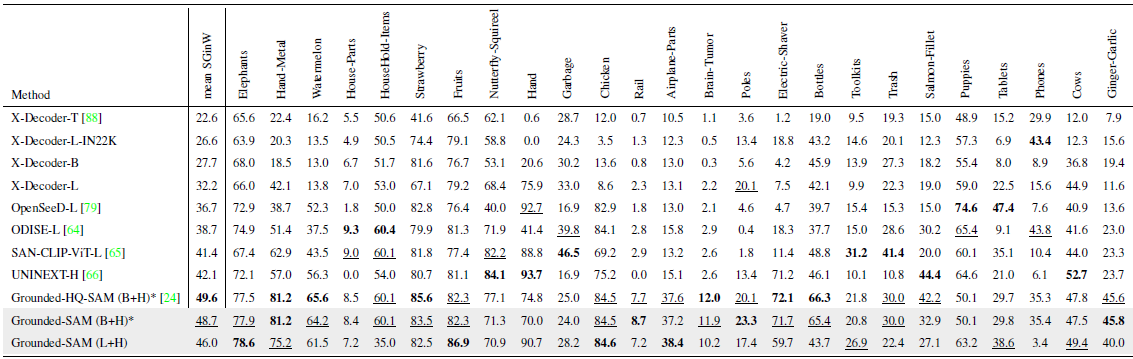

Grounded SAM의 효과를 검증하기 위해 25개의 제로샷 야생 데이터 세트로 구성된 Segmentation in the Wild (SGinW) 제로샷 벤치마크에서 성능을 평가합니다.

표 1에서 볼 수 있듯이, Grounding DINO Base와 Large 모델과 SAM-Huge를 결합하면 이전에 통합된 오픈셋 세그멘테이션 모델인 UNINEXT [66] 및 OpenSeeD [79]와 비교했을 때 SGinW의 제로샷 설정에서 상당한 성능 개선이 이루어집니다.

SAM보다 고품질의 마스크를 생성할 수 있는 HQ-SAM [24]을 통합함으로써 Grounded-HQ-SAM은 SGinW에서 더욱 향상된 성능을 달성합니다.

5. Conclusion and Prospects

다양한 expert 모델의 조립을 활용하여 다양한 비전 작업을 수행하는 제안된 Grounded SAM과 그 확장의 강점은 다음과 같이 요약할 수 있습니다.

첫째, 다양한 expert 모델을 조립하여 모델의 능력 경계를 원활하게 확장할 수 있습니다.

이전에는 n개의 모델로 n개의 작업을 수행할 수 있었습니다.

이제 가능한 모든 모델 조합을 고려하여 n개의 expert 모델로 최대 2^n - 1개의 작업을 수행할 수 있습니다.

복잡한 작업을 현재 사용 가능한 expert 모델로 해결되는 여러 하위 작업으로 분리할 수 있습니다.

둘째, 모델 조립 파이프라인은 작업을 여러 하위 작업으로 분해하여 더 설명할 수 있습니다.

최종 결과의 추론 과정을 얻기 위해 각 단계의 결과를 관찰할 수 있습니다.

마지막으로, 다양한 expert 모델을 결합함으로써 새로운 연구 및 응용 분야를 조사하여 잠재적으로 혁신적인 결과와 기술 발전으로 이어질 수 있습니다.

Prospect:

우리 방법론의 중요한 전망은 주석 데이터와 모델 학습 간의 폐쇄 루프를 설정하는 것입니다.

expert 모델의 조합을 통해 상당한 주석 비용을 절약할 수 있습니다.

또한 다양한 단계에 사람의 주석을 포함하면 부정확한 모델 예측을 필터링하거나 파인튜닝할 수 있으므로 모델 주석의 품질이 향상됩니다.

그런 다음 주석이 달린 데이터는 모델을 추가로 학습하고 개선하는 데 지속적으로 활용됩니다.

이 방법의 또 다른 잠재적 응용 분야는 Large Language Models (LLM)과 결합하는 것입니다.

조립된 모델은 다양한 입력 및 출력 모달리티, 특히 언어를 가진 거의 모든 computer vision (CV) 작업을 수행할 수 있으므로 LLM이 언어 프롬프트를 통해 API를 호출하여 CV 작업을 효과적으로 실행하는 것이 간단해집니다.

마지막으로, 특히 생성 모델과 결합할 때 이 모델을 사용하여 모든 모달리티 쌍을 연결하는 새로운 데이터 세트를 생성할 수 있습니다.

'Deep Learning' 카테고리의 다른 글

| Segment Anything in High Quality (1) | 2024.10.28 |

|---|---|

| Recognize Anything: A Strong Image Tagging Model (0) | 2024.10.18 |

| Grounding DINO: Marrying DINO with Grounded Pre-Training for Open-Set Object Detection (1) | 2024.10.16 |

| Faster Segment Anything: Towards Lightweight SAM for Mobile Applications (1) | 2024.10.15 |

| Deep Generative Filter for Motion Deblurring (0) | 2024.01.02 |