2025. 3. 17. 14:06ㆍRobotics

RT-2: Vision-Language-Action Models Transfer Web Knowledge to Robotic Control

Google DeepMind

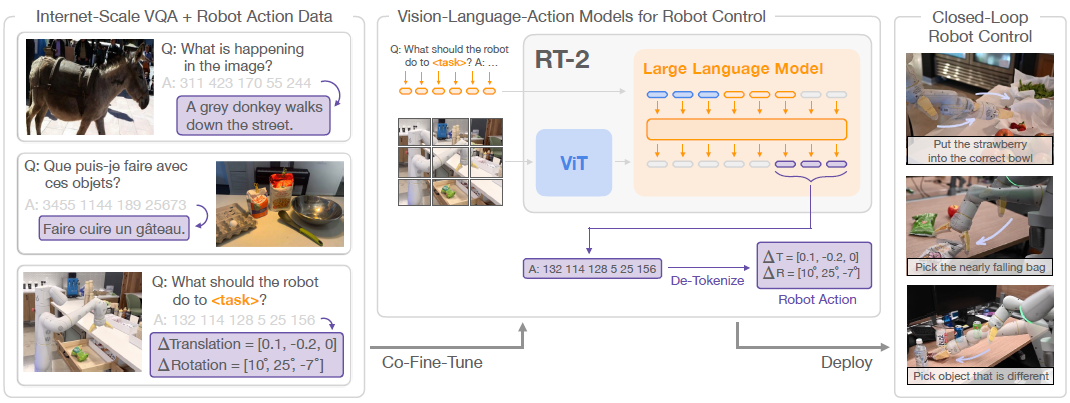

우리는 인터넷 규모의 데이터로 학습된 비전-언어 모델을 종단 간 로봇 제어에 직접 통합하여 일반화를 촉진하고 새로운 시맨틱 추론을 가능하게 하는 방법을 연구합니다.

우리의 목표는 단일 종단 간 학습 모델이 로봇 관찰을 액션으로 매핑하는 방법을 학습하고 웹에서 언어 및 비전-언어 데이터에 대한 대규모 사전 학습의 이점을 누릴 수 있도록 하는 것입니다.

이를 위해 우리는 로봇 궤적 데이터와 시각적 질문 응답과 같은 인터넷 규모의 비전 언어 작업 모두에서 SOTA 비전-언어 모델을 공동 파인튜닝할 것을 제안합니다.

다른 접근 방식과 달리, 우리는 이 목표를 달성하기 위한 간단하고 일반적인 레시피를 제안합니다: 자연어 응답과 로봇 액션을 동일한 형식으로 맞추기 위해, 우리는 액션을 텍스트 토큰으로 표현하고 이를 자연어 토큰과 같은 방식으로 모델의 학습 세트에 직접 통합합니다.

우리는 이러한 모델의 범주를 vision-language-action 모델 (VLA)이라고 부르며, 이러한 모델의 예를 RT-2라고 부릅니다.

광범위한 평가 (6k건의 평가 시험)를 통해 우리의 접근 방식이 성능이 뛰어난 로봇 policy로 이어지고 RT-2가 인터넷 규모의 학습을 통해 다양한 응급 기능을 얻을 수 있음을 보여줍니다.

여기에는 새로운 객체에 대한 크게 향상된 일반화, 로봇 학습 데이터에 없는 명령어를 해석하는 능력 (예: 특정 숫자나 아이콘에 객체를 배치하는 능력), 사용자 명령어 (예: 가장 작거나 큰 객체 또는 다른 객체에 가장 가까운 객체를 집는 능력)에 대한 응답으로 기본적인 추론을 수행하는 능력이 포함됩니다.

또한, chain of thought 추론을 통합하면 RT-2가 다단계 시맨틱 추론을 수행할 수 있음을 보여줍니다, 예를 들어, 즉흥적인 망치 (바위)로 사용하기 위해 어떤 물체를 집어들어야 할지, 피곤한 사람에게 가장 적합한 음료 (에너지 음료)를 찾는 것 등이 그것입니다.

1. Introduction

광범위한 웹 규모의 데이터셋에서 사전 학습된 고용량 모델은 다양한 다운스트림 작업에 효과적이고 강력한 플랫폼을 제공합니다: 대규모 언어 모델은 유창한 텍스트 생성 (Anil et al., 2023; Brohan et al., 2022; OpenAI, 2023)뿐만 아니라 창의적인 문제 해결 (Cobbe et al., 2021; Lewkowycz et al., 2022; Polu et al., 2022)과 창의적인 산문 생성 (Brown et al., 2020; OpenAI, 2023) 및 코드 생성 (Chen et al., 2021)도 가능하며, 비전 언어 모델은 개방형 어휘 시각 인식 (Kirillov et al., 2023; Mindererer et al., 2022; Radford et al., 2021)을 가능하게 하며 이미지에서 객체-에이전트 상호작용에 대한 복잡한 추론도 가능합니다 (Alayrac et al., 2022; Chen et al., 2023a,b; Driess et al., 2023; Hao et al., 2022; Huang et al., 2023; Wang et al., 2022).

이러한 시맨틱 추론, 문제 해결, 시각적 해석 능력은 실제 환경에서 다양한 작업을 수행해야 하는 일반론적 로봇에게 매우 유용할 것입니다.

그러나 로봇이 이러한 기능을 어떻게 습득해야 하는지는 불분명합니다.

브루트 포스 방식은 수백만 건의 로봇 상호작용 시험을 수집해야 할 수도 있지만, 가장 유능한 언어 및 비전 언어 모델은 수십억 개의 토큰과 웹 이미지를 기반으로 학습됩니다 (Alayrac et al., 2022; Chen et al., 2023a,b; Huang et al., 2023) – 가까운 미래에 로봇 데이터와 일치할 가능성이 낮은 양입니다.

한편, 이러한 모델을 로봇 작업에 직접 적용하는 것도 어렵습니다: 이러한 모델은 시맨틱, 레이블 및 텍스트 프롬프트에 대해 추론하는 반면, 로봇은 Cartesian end-effector 명령과 같은 저수준 작업을 필요로 합니다.

최근 여러 연구들이 언어 모델 (LLM)과 vision-language models (VLM)을 로봇 공학에 통합하려는 시도를 하고 있지만(Anne et al., 2022; Driess et al., 2023; Vemprala et al., 2023), 이러한 방법들은 일반적으로 로봇 계획의 "higher level" 측면만을 다루며, 기본적으로 명령을 해석하고 이를 개별 기본 요소 (예: 객체 선택 및 배치)로 구문 분석하는 상태 기계의 역할을 수행합니다, 그런 다음, 학습 중 인터넷 규모 모델의 풍부한 시맨틱 지식으로부터 혜택을 받지 못하는 별도의 저수준 제어기에 의해 실행됩니다.

따라서 이 논문에서는 다음과 같이 묻습니다: 대규모 사전 학습된 비전 언어 모델을 저수준 로봇 제어에 직접 통합하여 일반화를 촉진하고 새로운 시맨틱 추론을 가능하게 할 수 있습니까?

이를 위해 간단하고 놀랍도록 효과적인 접근 방식을 탐구합니다: 우리는 개방형 어휘 시각적 질문 응답과 시각적 대화를 위해 설계된 비전-언어 모델을 직접 학습하여 저수준 로봇 액션을 출력하고, 다른 인터넷 규모의 비전-언어 작업을 해결합니다.

이러한 모델은 일반적으로 자연어 토큰을 생성하도록 학습되지만, 액션을 텍스트 토큰으로 토큰화하고 해당 액션을 생성하여 카메라 관찰과 결합된 로봇 명령에 "respond"하는 "multimodal sentences" (Driess et al., 2023)을 생성함으로써 로봇 궤적에서 이를 학습시킬 수 있습니다.

이와 같이, 비전-언어 모델은 로봇 policy를 따르는 지시 역할을 하도록 직접 학습될 수 있습니다.

이 간단한 접근 방식은 VLM을 로봇 policy에 통합하거나 (Shridhar et al., 2022a) 새로운 비전-언어-액션 아키텍처를 처음부터 설계하는 이전의 대안들과 대조적입니다 (Reed et al., 2022a): 대신에, 이미 상환된 상당한 컴퓨팅 투자를 받은 기존 비전-언어 모델들은 텍스트-인코딩된 액션을 출력하기 위해 새로운 매개변수 없이 학습됩니다.

우리는 이 범주의 모델을 vision-language-action (VLA) 모델이라고 부릅니다.

우리는 유사한 데이터셋을 사용하여 RT-1 (Brohan et al., 2022)을 위해 제안된 프로토콜을 기반으로 VLA 모델을 인스턴스화하지만, 대규모 비전-언어 백본을 사용하도록 모델을 확장합니다.

따라서 우리는 우리의 모델을 RT-2 (Robotics Transformer 2)라고 부릅니다.

그림 1에 개요를 제공합니다.

우리는 이러한 비전-언어 모델에서 파생된 로봇 policy가 로봇 데이터에서 학습한 물리적 모션과 웹 데이터에서 학습한 이미지 및 텍스트를 단일 모델로 해석하는 능력을 결합하여 다양한 놀라운 능력을 발휘한다는 것을 관찰했습니다.

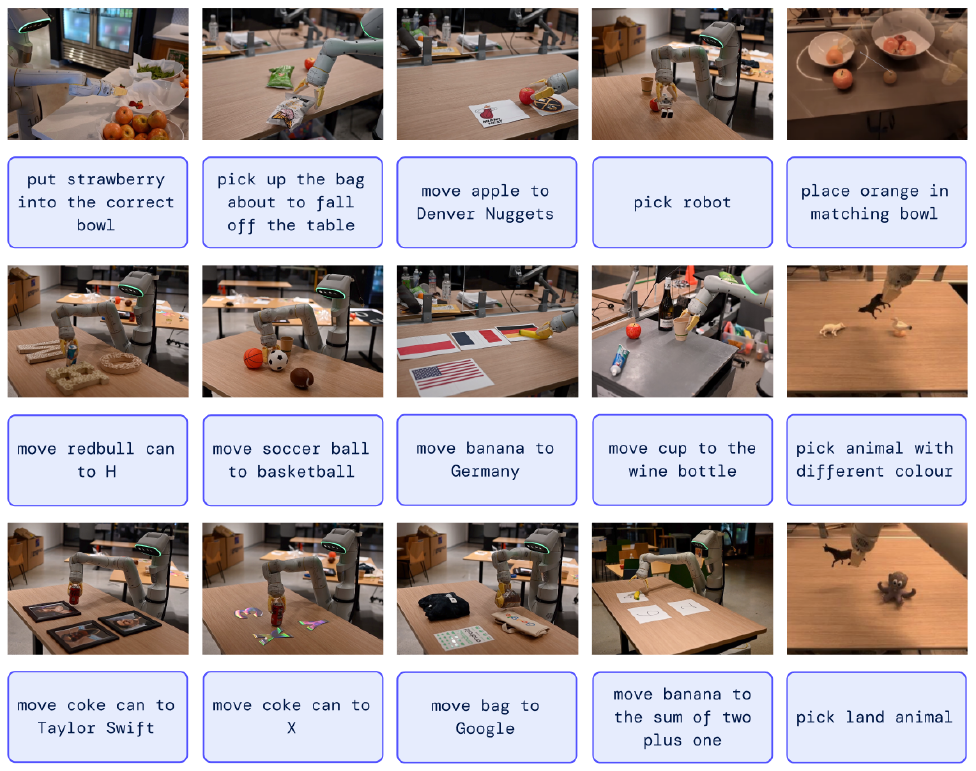

새로운 객체와 시맨틱적으로 다양한 명령어에 대한 일반화를 극적으로 개선하는 데 기대되는 이점 외에도, 우리는 여러 가지 새로운 기능을 관찰합니다.

모델의 물리적 기술은 여전히 로봇 데이터에서 볼 수 있는 기술의 분포에 국한되어 있지만, 모델은 웹에서 얻은 지식을 사용하여 이미지와 언어 명령을 해석함으로써 이러한 기술을 새로운 방식으로 배포할 수 있는 능력을 습득합니다.

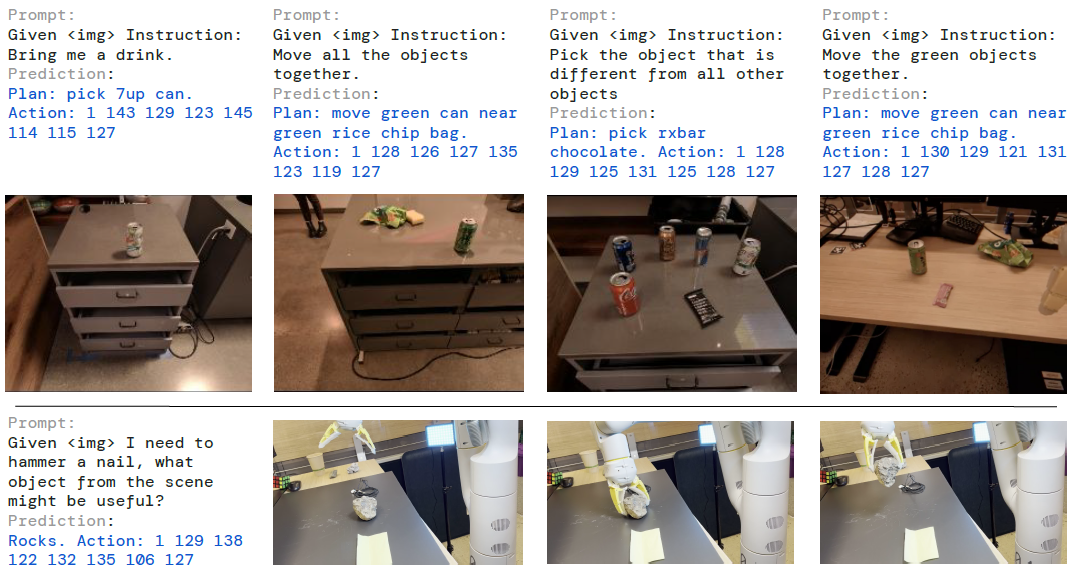

몇 가지 예시 하이라이트는 그림 2에 나와 있습니다.

이 모델은 로봇 데이터에서 배운 기술을 재사용하여 특정 숫자나 아이콘과 같이 시맨틱적으로 표시된 위치 근처에 물체를 배치할 수 있습니다.

이 모델은 로봇 시연에서는 이러한 관계가 제공되지 않음에도 불구하고 객체 간의 관계를 해석하여 어떤 객체를 선택하고 어디에 배치할지 결정할 수도 있습니다.

또한, chain of thought를 프롬프팅하여 명령을 강화하면, 모델은 즉흥적인 망치 (바위)로 사용하기 위해 어떤 물건을 집어들어야 할지, 피곤한 사람에게 가장 적합한 음료 (에너지 음료)를 찾는 등 더욱 복잡한 시맨틱 추론을 할 수 있습니다.

저희의 주요 기여는 RT-2입니다, 이는 웹 규모의 데이터를 기반으로 학습된 대규모 비전-언어 모델을 파인튜닝하여 일반화 가능하고 시맨틱적으로 인식되는 로봇 policy로 직접적으로 작동하도록 유도된 모델들입니다.

우리의 실험은 이전 연구 (Brohan et al., 2022)에서 인터넷 데이터와 명령어 주석이 달린 로봇 궤적을 기반으로 최대 55B 매개변수를 학습한 모델을 조사합니다.

6k 건의 로봇 평가를 통해, 우리는 RT-2가 객체, 장면, 명령어에 대한 일반화를 크게 개선할 수 있으며, 웹 규모의 비전 언어 사전 학습에서 물려받은 다양한 새로운 기능을 보여준다는 것을 보여줍니다.

2. Related Work

Vision-language models.

Vision-Language Models (VLM)에는 여러 가지 범주가 있으며 (Gan et al., 2022), 아마도 두 가지가 가장 관련이 있을 것입니다: (1) 표현 학습 모델, 예를 들어 두 모달리티에 대한 공통 임베딩을 학습하는 CLIP (Radford et al., 2021)과 (2) 시각과 언어를 입력으로 받아 자유로운 형태의 텍스트를 제공하는 방법을 배우는 {vision, text} → {text} 형태의 시각 언어 모델.

두 범주 모두 객체 분류 (Radford et al., 2021), 탐지 (Gu et al., 2021), 세그멘테이션 (Giasi et al., 2021)과 같은 다양한 하위 응용 프로그램에 대한 사전 학습을 제공하는 데 사용되었습니다.

이 연구에서는 후자의 범주 (Alayrac et al., 2022; Chen et al., 2023a,b; Dryess et al., 2023; Hao et al., 2022; Li et al., 2023, 2019; Lu et al., 2019)에 초점을 맞춥니다.

이 모델들은 일반적으로 이미지 캡셔닝, vision-question answering (VQA), 그리고 여러 데이터셋에서 동시에 수행되는 일반 언어 작업과 같은 다양한 작업에 대해 학습됩니다.

이전 연구들은 VLM을 로보틱스를 포함한 다양한 문제와 설정에 대해 연구하지만, 우리의 초점은 VLM의 기능이 로봇 액션을 예측할 수 있는 능력을 부여함으로써 로봇 폐루프 제어로 어떻게 확장될 수 있는지에 맞춰져 있으며, 이를 통해 VLM에 이미 존재하는 지식을 활용하여 새로운 수준의 일반화를 가능하게 합니다.

Generalization in robot learning.

다양한 시나리오에서 광범위하게 성공할 수 있는 로봇 컨트롤러를 개발하는 것은 로보틱스 연구의 오랜 목표입니다 (Kaelbling, 2020; Smith and Coles, 1973).

로봇 조작에서 일반화를 가능하게 하는 유망한 접근 방식은 크고 다양한 데이터셋에서 학습하는 것입니다 (Dasari et al., 2019; Levine et al., 2018; Pinto and Gupta, 2016).

이를 통해 이전 방법들은 로봇이 새로운 객체 인스턴스 (Finn and Levine, 2017; Levine et al., 2018; Mahler et al., 2017; Pinto and Gupta, 2016; Young et al., 2021), 객체와 기술의 새로운 조합을 포함하는 작업 (Dasari and Gupta, 2021; Finn et al., 2017; James et al., 2018; Jang et al., 2021; Yu et al., 2018), 새로운 목표나 언어 지침 (Jang et al., 2021; Jiang et al., 2022; Liu et al., 2022; Mees et al., 2022; Nair et al., 2022a; Pong et al., 2019), 새로운 시맨틱 객체 범주를 가진 작업 (Shridhar et al., 2021; Stone et al., 2023), 그리고 보이지 않는 환경 (Cui et al., 2022; Du et al., 2023a; Hansen et al., 2020)으로 일반화할 수 있는 방법을 입증했습니다.

대부분의 이전 연구와 달리, 우리는 이러한 모든 축을 따라 보이지 않는 조건으로 일반화할 수 있는 단일 모델을 개발하고 연구하는 것을 목표로 합니다.

우리 접근 방식의 핵심 요소는 로봇이 보는 데이터보다 훨씬 더 넓은 데이터에 노출된 사전 학습된 모델을 활용하는 것입니다.

Pre-training for robotic manipulation.

사전 학습은 로봇 학습 분야에서 오랜 역사를 가지고 있습니다.

대부분의 연구는 supervised ImageNet 분류 (Shah and Kumar, 2021), 데이터 증강 (Kostrikov et al., 2020; Laskin et al., 2020a, b; Pari et al., 2021) 또는 로봇 제어에 맞춘 objective (Karamcheti et al., 2023; Ma et al., 2022b; Majumdar et al., 2023b; Nair et al., 2022b; Xiao et al., 2022b)를 통해 로봇의 카메라 관측 인코더를 초기화하는 데 사용할 수 있는 사전 학습된 시각적 표현에 중점을 둡니다.

다른 연구들은 종종 사전 학습된 언어 모델을 명령 인코더로 포함시켰습니다 (Brohan et al., 2022; Hill et al., 2020; Jang et al., 2021; Jiang et al., 2022; Lynch and Sermanet, 2020; Nair et al., 2022a; Shridhar et al., 2022b) 또는 고수준 계획을 위한 것입니다 (Ahn et al., 2022; Dryess et al., 2023; Huang et al., 2022; Mu et al., 2023; Singh et al., 2023; Wu et al., 2023).

사전 학습된 비전 모델이나 사전 학습된 언어 모델을 사용하는 대신, 우리는 특히 세상에 대한 풍부하고 근거 있는 지식을 제공하는 사전 학습된 vision-language models (VLM)의 사용을 고려합니다.

이전 연구들은 로봇 공학을 위한 VLM의 사용을 연구해 왔습니다 (Driess et al., 2023; Du et al., 2023b; Gadre et al., 2022; Karamcheti et al., 2023; Shah et al., 2023; Shridhar et al., 2021; Stone et al., 2023), 이 연구의 영감의 일부가 되었습니다.

이러한 이전 접근 방식은 시각적 상태 표현 (Karamcheti et al., 2023), 객체 식별 (Gadre et al., 2022; Stone et al., 2023), 고수준 계획 (Driess et al., 2023) 또는 supervision 또는 성공 감지 제공 (Du et al., 2023b; Ma et al., 2023; Sumers et al., 2023; Xiao et al., 2022a; Zhang et al., 2023)을 위해 VLM을 사용합니다.

CLIPort (Shridhar et al., 2021)와 MOO (Stone et al., 2023)는 사전 학습된 VLM을 종단 간 시각 운동 조작 policy에 통합하지만, 둘 다 적용 가능성을 제한하는 중요한 구조를 policy에 통합합니다.

특히, 우리의 작업은 제한된 2D 액션 공간에 의존하지 않으며 보정된 카메라가 필요하지 않습니다.

게다가, 중요한 차이점은 이러한 작업들과 달리 언어를 생성하는 VLM을 활용하고, 우리의 공식화된 출력 공간을 통해 모델 가중치를 액션 전용 모델 레이어 구성 요소 없이 언어와 액션 작업 전반에 걸쳐 완전히 공유할 수 있다는 점입니다.

3. Vision-Language-Action Models

이 섹션에서는 VLM을 학습시켜 폐루프 로봇 제어를 직접 수행할 수 있도록 모델 패밀리와 설계 선택 사항을 제시합니다.

먼저, 우리는 모델의 일반적인 아키텍처와 비전-언어 작업에 일반적으로 사용되는 모델에서 어떻게 도출될 수 있는지 설명합니다.

그런 다음 웹 규모의 데이터로 사전 학습된 대형 VLM을 파인튜닝하여 로봇 액션을 직접 출력하고 VLA 모델이 되는 레시피와 과제를 소개합니다.

마지막으로, 이러한 모델을 로봇 작업에 실용적으로 활용하여 실시간 제어가 가능하도록 모델 크기와 추론 속도의 문제를 해결하는 방법을 설명합니다.

3.1. Pre-Trained Vision-Language Models

본 연구에서 구축한 비전-언어 모델 (Chen et al., 2023a; Driess et al., 2023)은 하나 이상의 이미지를 입력으로 받아 일련의 토큰을 생성하며, 이는 일반적으로 자연어 텍스트를 나타냅니다.

이러한 모델은 이미지의 구성을 추론하는 것부터 개별 객체와 다른 객체와의 관계에 대한 질문에 대한 답변에 이르기까지 다양한 시각적 해석 및 추론 작업을 수행할 수 있습니다 (Alayrac et al., 2022; Chen et al., 2023a; Driess et al., 2023; Huang et al., 2023).

이러한 다양한 작업을 수행하는 데 필요한 지식을 표현하려면 대규모 모델과 웹 규모의 데이터셋이 필요합니다.

이 연구에서는 이전에 제안된 두 가지 VLM을 VLA 모델로 적용합니다: PaLI-X (Chen et al., 2023a) 및 PaLM-E (Driess et al., 2023).

우리는 이 모델들의 비전-언어-액션 버전을 RT-2-PaLI-X와 RT-2-PaLM-E라고 부를 것입니다.

우리는 수십억에서 수백억 개의 매개변수에 이르는 이러한 모델의 인스턴스화를 활용합니다.

부록 D에서 이 두 모델의 아키텍처에 대한 자세한 설명을 제공합니다.

3.2. Robot-Action Fine-tuning

비전-언어 모델이 로봇을 제어할 수 있도록 하려면 로봇이 액션을 출력하도록 학습시켜야 합니다.

우리는 이 문제에 직접적인 접근 방식을 취하며, 모델의 출력에서 언어 토큰과 동일한 방식으로 처리되는 액션을 토큰으로 표현합니다.

우리는 RT-1 모델 Brohan et al. (2022)이 제안한 이산화를 기반으로 작업 인코딩을 수행합니다.

액션 공간은 로봇 엔드 이펙터의 6-DoF 위치 및 회전 변위뿐만 아니라 로봇 그리퍼의 확장 수준과 에피소드 종료를 위한 특수 이산 명령으로 구성되며, 이는 성공적인 완료를 알리는 정책에 의해 트리거되어야 합니다.

연속 차원 (이산 종료 명령을 제외한 모든 차원)은 256개의 빈으로 균일하게 이산화됩니다.

따라서 로봇 액션은 이산 빈의 서수를 8개의 정수로 사용하여 표현할 수 있습니다.

이러한 이산화된 액션을 사용하여 비전-언어를 비전-언어-행동 모델로 파인튜닝하려면 모델의 기존 토큰화 토큰을 이산 액션 빈과 연결해야 합니다.

이를 위해서는 액션 토큰으로 사용하기 위해 256개의 토큰을 예약해야 합니다.

어떤 토큰을 선택할지는 각 VLM에서 사용하는 특정 토큰화에 따라 달라지며, 이는 이 섹션의 뒷부분에서 설명합니다.

VLM 파인튜닝의 타겟을 정의하기 위해 각 차원의 액션 토큰을 공간 문자로 간단히 연결하여 액션 벡터를 단일 문자열로 변환합니다:

“terminate Δpos_𝑥 Δpos_𝑦 Δpos_𝑧 Δrot_𝑥 Δrot_𝑦 Δrot_𝑧 gripper_extension”.

이러한 타겟의 가능한 인스턴스화는 다음과 같을 수 있습니다: “1 128 91 241 5 101 127”.

실험에서 파인튜닝하는 두 가지 VLM인 PaLI-X (Chen et al., 2023a)와 PaLM-E (Driess et al., 2023)는 서로 다른 토큰화를 사용합니다.

PaLI-X의 경우, 최대 1000개의 정수는 각각 고유한 토큰을 가지고 있으므로, 우리는 단순히 해당 정수를 나타내는 토큰에 액션 빈을 연결합니다.

숫자를 편리하게 표현하지 못하는 PaLM-E 모델의 경우, 가장 자주 사용되지 않는 256개의 토큰을 덮어쓰면 액션 어휘를 표현할 수 있습니다.

기존 토큰을 액션 토큰으로 대체하도록 VLM을 학습하는 것은 심볼 튜닝의 한 형태라는 점에 주목할 필요가 있으며 (Wei et al., 2023), 이는 이전 연구에서 VLM에 잘 작동하는 것으로 나타났습니다.

위에서 설명한 액션 표현을 사용하여 로봇 데이터를 VLM 모델 파인튜닝에 적합하도록 변환합니다, 여기서 입력에는 로봇 카메라 이미지와 텍스트 작업 설명이 포함됩니다 (표준 VQA 형식 "Q: what action should the robot take to [task instruction]? A:"), 출력은 로봇 액션을 나타내는 일련의 숫자/가장 자주 사용되지 않는 토큰으로 형식화됩니다.

Co-Fine-Tuning.

실험에서 보여드릴 것처럼 로봇 성능을 향상시키는 학습 레시피의 핵심 기술적 세부 사항은 로봇 데이터에 대한 나이브한 파인튜닝 대신 원본 웹 데이터와 함께 로봇 데이터를 공동 파인튜닝하는 것입니다.

policy가 로봇 액션뿐만 아니라 웹 스케일 데이터의 추상적인 시각적 개념과 파인튜닝 중 저수준 로봇 액션 모두에 노출되기 때문에 공동 파인튜닝이 더 일반화 가능한 정책으로 이어진다는 것을 알 수 있습니다.

공동 파인튜닝 중에는 로봇 데이터셋의 샘플링 가중치를 높여 각 학습 배치에서 로봇과 웹 데이터의 비율을 균형 있게 조정합니다.

Output Constraint.

RT-2와 표준 VLM의 중요한 차이점 중 하나는 실제 로봇에서 실행하기 위해 유효한 액션 토큰을 출력하기 위해 RT-2가 필요하다는 점입니다.

따라서 RT-2가 디코딩 중에 유효한 액션 토큰을 출력하도록 하기 위해, 모델이 로봇 액션 작업을 요청받을 때 유효한 액션 토큰만 샘플링하여 출력 어휘를 제한하는 반면, 모델은 여전히 표준 비전-언어 작업에서 전체 범위의 자연어 토큰을 출력할 수 있습니다.

3.3. Real-Time Inference

현대 VLM의 크기는 수백억 또는 수천억 개의 매개변수에 달할 수 있습니다 (Chen et al., 2023a; Driess et al., 2023).

이 연구에서 학습된 가장 큰 모델은 55B 매개변수를 사용합니다.

이러한 모델을 일반적으로 실시간 로봇 제어에 사용되는 표준 데스크톱 스타일 기계나 온로봇 GPU에서 직접 실행하는 것은 불가능합니다.

우리가 아는 한, 우리의 모델은 직접 폐루프 로봇 제어에 사용되는 역대 최대 규모로, 효율적인 실시간 추론을 가능하게 하기 위해 새로운 솔루션 세트가 필요합니다.

우리는 멀티 TPU 클라우드 서비스에 RT-2 모델을 배포하고 네트워크를 통해 이 서비스를 쿼리하여 로봇에서 RT-2 모델을 실행할 수 있는 프로토콜을 개발합니다.

이 솔루션을 통해 적절한 제어 빈도를 달성하고 동일한 클라우드 서비스를 사용하는 여러 로봇에게 서비스를 제공할 수 있습니다.

우리가 평가한 가장 큰 모델인 55B 매개변수 RT-2-PaLI-X-55B 모델은 1-3Hz 주파수에서 실행할 수 있습니다.

그 모델의 더 작은 버전은 5B 매개변수로 구성되어 있으며, 약 5Hz의 주파수로 실행될 수 있습니다.

4. Experiments

우리의 실험은 RT-2의 실제 일반화와 출현 능력에 초점을 맞추고 있으며, 다음 질문들에 답하는 것을 목표로 합니다:

1. RT-2는 보이는 작업에서 어떻게 수행되며, 더 중요한 것은 새로운 객체, 배경 및 환경에 대해 일반화하는 것입니까?

2. RT-2의 새로운 기능을 관찰하고 측정할 수 있습니까?

3. 매개변수 수 및 기타 설계 결정에 따라 일반화는 어떻게 달라지나요?

4. RT-2는 비전-언어 모델과 유사하게 chain-of-thought 추론의 징후를 나타낼 수 있습니까?

우리는 우리의 접근 방식과 다양한 조건에서 약 6,000개의 평가 궤적을 가진 여러 베이스라인을 평가하며, 이를 다음 섹션에서 설명합니다.

달리 명시되지 않는 한, 우리는 섹션 3.2장에 설명된 액션 공간을 가진 7DoF 모바일 매니퓰레이터를 사용합니다.

우리는 또한 프로젝트 웹사이트에서 RT-2 실행 예시를 시연합니다.

우리는 사전 학습된 VLM을 활용하는 RT-2의 두 가지 특정 인스턴스를 학습합니다: (1) RT-2-PaLI-X는 5B 및 55B PaLI-X로 제작되었으며 (Chen et al., 2023a), (2) RT-2-PaLM-E는 12B PaLM-E로 제작되었습니다 (Driess et al., 2023).

학습을 위해 Chen et al. (2023a)와 Driess et al. (2023)의 원본 웹 스케일 데이터를 활용합니다, 이 데이터는 시각적 질문 응답, 캡셔닝, 비구조화된 혼합 이미지 및 텍스트 예제로 구성되어 있습니다.

우리는 이를 사무실 주방 환경에서 17개월 동안 13대의 로봇으로 수집한 Brohan et al. (2022)의 로봇 시연 데이터와 결합합니다.

각 로봇 시연 궤적에는 수행된 작업을 설명하는 자연어 명령어가 주석으로 달려 있습니다, 이 명령어는 기술을 설명하는 동사 (예: “pick”, ”open”, “place into”)와 조작된 객체를 설명하는 하나 이상의 명사(예: “7up can”, “drawer”, “napkin”)로 구성됩니다 (사용된 데이터셋에 대한 자세한 내용은 부록 B를 참조하십시오).

모든 RT-2 학습 실행에 대해 우리는 학습률 일정 및 정규화를 포함하여 원본 PaLI-X (Chen et al., 2023a) 및 PaLM-E (Driess et al., 2023) 논문의 하이퍼파라미터를 채택합니다.

자세한 학습 내용은 부록 E에서 확인할 수 있습니다.

Baselines.

우리는 우리의 방법을 다양한 측면에 도전하는 여러 최신 베이스라인과 비교합니다.

모든 베이스라인은 정확히 동일한 로봇 데이터를 사용합니다.

SOTA policy와 비교하기 위해 35M 파라미터 트랜스포머 기반 모델인 RT-1 (Brohan et al., 2022)을 사용합니다.

SOTA 사전 학습된 표현과 비교하기 위해, 우리는 VC-1 (Majumdar et al., 2023a)과 R3M (Nair et al., 2022b)을 사용하며, RT-1 백본을 학습시켜 그 표현을 입력으로 받아 policy를 구현합니다.

VLM을 사용하는 다른 아키텍처와 비교하기 위해, 우리는 MOO (Stone et al., 2023)를 사용합니다, 그것은 VLM을 사용하여 시맨틱 맵을 위한 추가 이미지 채널을 생성한 후, 이를 RT-1 백본에 입력합니다.

자세한 정보는 부록 C에서 제공됩니다.

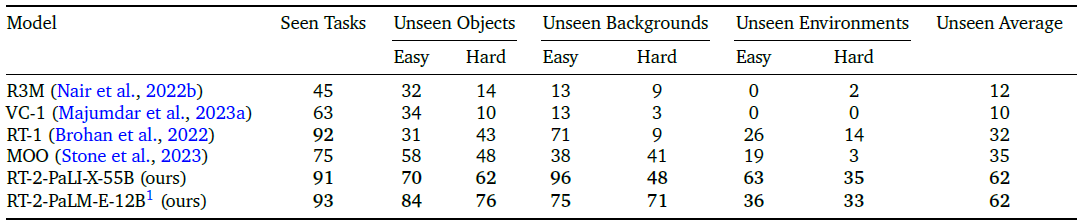

4.1. How does RT-2 perform on seen tasks and more importantly, generalize over new objects, backgrounds, and environments?

분포 내 성능과 일반화 능력을 평가하기 위해 RT-2-PaLI-X 및 RT-2-PaLM-E 모델을 이전 섹션에 나열된 네 가지 베이스라인과 비교합니다.

관찰된 작업 범주에 대해서는 RT-1 (Brohan et al., 2022)과 동일한 관찰된 지침 모음을 사용하며, 이 평가에는 200개 이상의 작업이 포함됩니다: 물건을 고르는 데 36개, 물건을 두드리는 데 35개, 물건을 똑바로 놓는 데 35개, 물건을 옮기는 데 48개, 다양한 서랍을 열고 닫는 데 18개, 서랍에서 물건을 꺼내서 넣는 데 36개.

그러나 이러한 "in-distribution" 평가는 여전히 객체의 배치와 시간 및 로봇 위치와 같은 요소를 다양하게 변화시키기 때문에 환경의 현실적인 변동성에 일반화할 수 있는 기술이 필요하다는 점에 유의하세요.

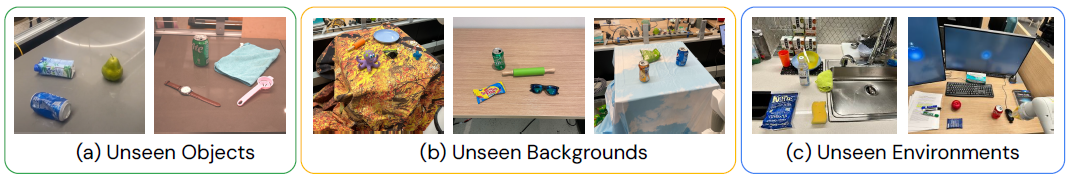

그림 3은 보이지 않는 범주 (객체, 배경 및 환경)로 나누고, 추가로 쉬운 경우와 어려운 경우로 나누는 일반화 평가의 예시를 보여줍니다.

보이지 않는 물체의 경우, 어려운 경우에는 잡기 어렵고 독특한 물체 (예: 장난감)가 포함됩니다.

보이지 않는 배경의 경우, 하드 케이스에는 더 다양한 배경과 새로운 객체가 포함됩니다.

마지막으로, 보이지 않는 환경의 경우 하드 케이스는 모니터와 액세서리가 있는 시각적으로 더 뚜렷한 사무용 책상 환경에 해당하며, 더 쉬운 환경은 주방 싱크대입니다.

이러한 평가는 주로 다양한 시나리오에서 기술을 선택하고 배치하는 데 중점을 둔 280개 이상의 과제로 구성되어 있습니다.

보이지 않는 카테고리에 대한 지침 목록은 부록 F.2에 명시되어 있습니다.

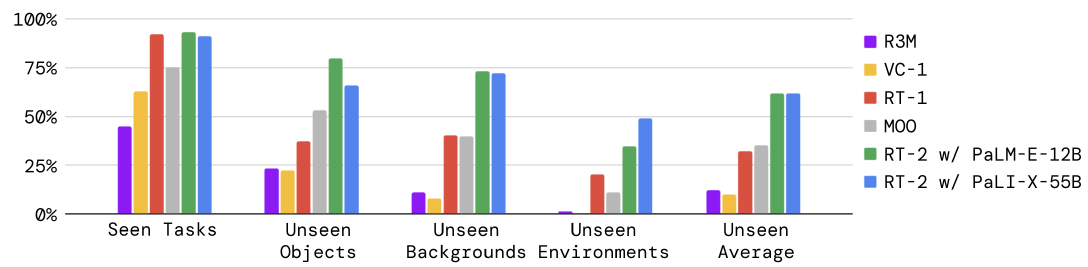

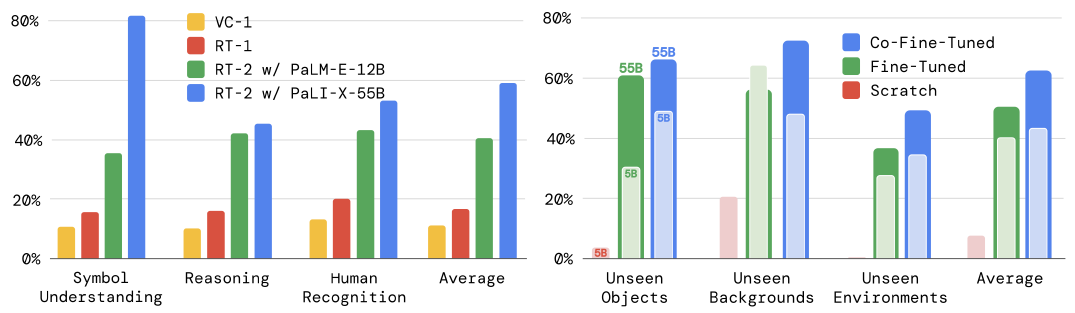

평가 결과는 그림 4와 부록 표 4에 나와 있습니다.

본 작업의 성능은 RT-2 모델과 RT-1 모델 간에 비슷하며, 다른 베이스라인들은 더 낮은 성공률을 달성했습니다.

RT-2 모델과 베이스라인의 차이점은 다양한 일반화 실험에서 가장 두드러지며, 이는 비전-언어-행동 모델의 강점이 인터넷 규모의 사전 학습 데이터에서 보다 일반화 가능한 시각적 및 시맨틱 개념을 전이하는 데 있음을 시사합니다.

여기서 RT-2의 두 인스턴스화는 평균적으로 유사한 성능을 발휘하여 다음 두 베이스라인인 RT-1과 MOO에 비해 약 2배, 다른 베이스라인에 비해 약 6배 더 나은 성능을 보였습니다.

RT-2의 PaLM-E 버전은 더 어려운 일반화 시나리오에서는 RT-2-PaLI-X보다 성능이 뛰어나지만, 더 쉬운 시나리오에서는 성능이 저조하여 평균 성능이 비슷한 것으로 보입니다.

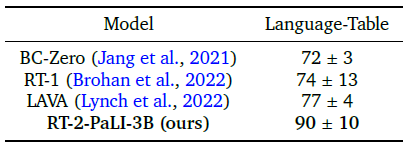

Open Source Language Table Benchmark.

오픈 소스 베이스라인과 환경을 사용하여 추가적인 비교 지점을 제공하기 위해, 우리는 Lynch et al. (2022)의 오픈 소스 언어-표 시뮬레이션 환경을 활용합니다.

우리는 언어-표 데이터셋을 위해 도메인 내 VQA 작업을 포함한 여러 예측 작업에서 작은 PaLI 3B 모델을 공동 파인튜닝하고, 그 결과 policy를 시뮬레이션에서 평가합니다.

액션 예측 작업을 위해, 우리는 행동을 "X Y" 형식의 텍스트로 이산화하고 인코딩합니다, 여기서 X와 Y는 {-10, -9, . . . , +9, +10} 사이의 범위를 가지며, 엔드 이펙터의 델타 2D 데카르트 집합점을 나타냅니다.

크기가 작아졌기 때문에 결과 모델은 다른 베이스라인과 비슷한 속도(5Hz)로 추론을 실행할 수 있습니다.

이 실험의 결과는 표 1에 나와 있습니다.

우리 모델을 사용할 때 베이스라인에 비해 성능이 크게 향상된 것을 관찰했으며, 이는 VLM 기반의 사전 학습과 대형 PaLI 모델의 표현력이 다른 시나리오, 이 경우 다른 로봇과의 시뮬레이션에서도 유익할 수 있음을 나타냅니다.

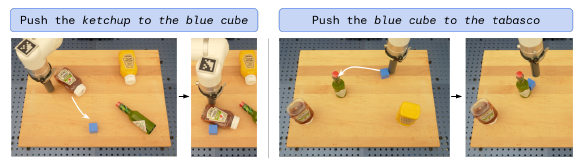

우리는 또한 그림 5에서 질적인 실제 분포 외 행동 행동을 보여주며, 이 환경에서 이전에 볼 수 없었던 새로운 푸시 작업과 객체를 타겟팅하는 것을 보여줍니다.

언어 테이블 실험에 대한 자세한 내용은 부록 B와 D에서 확인할 수 있습니다.

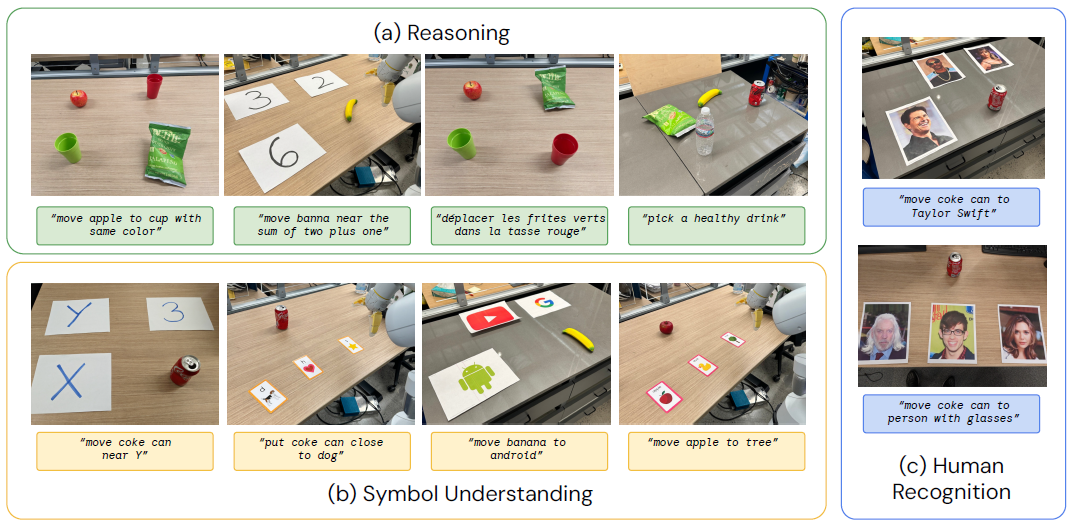

4.2. Can we observe and measure any emergent capabilities of RT-2?

비전-언어-행동 모델의 일반화 능력을 평가하는 것 외에도, 우리는 웹에서 지식을 전달함으로써 이러한 모델이 로봇 데이터에서 입증된 것 이상의 새로운 능력을 가능하게 할 수 있는 정도를 평가하는 것을 목표로 합니다.

우리는 이러한 기능을 인터넷 규모의 사전 학습을 통해 나타난다는 의미에서 emergent라고 부릅니다.

우리는 이러한 전이가 새로운 로봇 모션을 가능하게 할 것으로 기대하지 않지만, 관계와 명사를 포함한 시맨틱 및 시각적 개념이 로봇 데이터에서 보이지 않는 경우에도 효과적으로 전이될 것으로 기대합니다.

Qualitative Evaluations.

먼저, 우리는 RT-2-PaLI-X 모델을 사용하여 비전-언어 개념에서 전달된 다양한 emergent 기능을 실험합니다.

우리는 그림 2에서 이러한 상호작용의 몇 가지 예를 보여줍니다.

우리는 탐구를 통해 RT-2가 장면의 맥락에서 시맨틱 이해와 기본 추론 측면에서 새로운 능력을 계승한다는 것을 발견했습니다.

예를 들어, "put strawberry into the correct bowl" 작업을 수행하려면 딸기와 그릇이 무엇인지에 대한 미묘한 이해뿐만 아니라 딸기가 과일과 함께 사용되어야 한다는 장면을 추론하는 것도 필요합니다.

"pick up the bag about to fall off the table," 작업을 위해 RT-2는 두 가방 사이를 명확하게 구분하고 조심스럽게 놓인 물체를 인식하는 물리적 이해를 보여줍니다.

이 시나리오에서 테스트된 모든 상호작용은 로봇 데이터에서 본 적이 없으며, 이는 비전-언어 데이터에서 시맨틱 지식의 전달을 나타냅니다.

Quantitative Evaluations.

이러한 새로운 기능을 정량화하기 위해 이전 평가에서 상위 두 가지 베이스라인인 RT-1과 VC-1을 가져와 두 가지 모델과 비교합니다: RT-2-PaLI-X 및 RT-2-PaLM-E.

이 실험의 분산을 줄이기 위해, 우리는 A/B 테스트 프레임워크 (Fisher, 1936)를 사용하여 모든 방법을 평가합니다, 여기서 네 가지 모델은 정확히 동일한 조건에서 차례로 평가됩니다.

우리는 RT-2의 emergent 기능을 추론과 시맨틱 이해의 축을 포괄하는 세 가지 범주로 나누었습니다 (각각의 예시는 부록 그림 8에 나와 있습니다).

첫 번째로 심볼 이해라고 하며, 이는 RT-2 policy가 로봇 데이터에 존재하지 않았던 비전-언어 사전 학습에서 시맨틱 지식을 전달하는지 여부를 명시적으로 테스트합니다.

이 카테고리의 예시 지침은 "move apple to 3" 또는 "push coke can on top of heart"입니다.

우리가 추론이라고 부르는 두 번째 범주는 기본 VLM의 다양한 측면을 작업 제어에 적용할 수 있는 능력을 보여줍니다.

이러한 작업에는 시각적 추론 ("move the apple to cup with same color"), 수학("move X near the sum of two plus one"), 다국어 이해 ("mueve la manzana al vaso verde")가 필요합니다.

마지막 범주를 인간 중심의 이해와 인식을 보여주기 위해 "move the coke can to the person with glasses"와 같은 작업을 포함하는 인간 인식 과제라고 부릅니다.

이 평가에 사용된 지침의 전체 목록은 부록 F.2에 명시되어 있습니다.

우리는 부록 H.2의 모든 수치 결과와 함께 이 실험의 결과를 그림 6a에 제시합니다.

우리는 VLA 모델이 모든 카테고리에서 베이스라인을 크게 능가하며, 최고의 RT-2-PaLI-X 모델이 다음 최고의 베이스라인 (RT-1)보다 평균 3배 이상의 성공률을 달성한 것을 관찰했습니다.

우리는 또한 더 큰 PaLI-X 기반 모델이 평균적으로 더 나은 기호 이해, 추론 및 사람 인식 성능을 제공하지만, 더 작은 PaLM-E 기반 모델이 수학적 추론과 관련된 작업에서 우위를 점하고 있다는 점에 주목합니다.

우리는 이 흥미로운 결과를 PaLM-E에 사용된 다양한 사전 학습 혼합물 덕분이라고 생각합니다, 이는 대부분 시각적으로 사전 학습된 PaLI-X보다 수학 계산 능력이 더 뛰어난 모델로 이어집니다.

4.3. How does the generalization vary with parameter count and other design decisions?

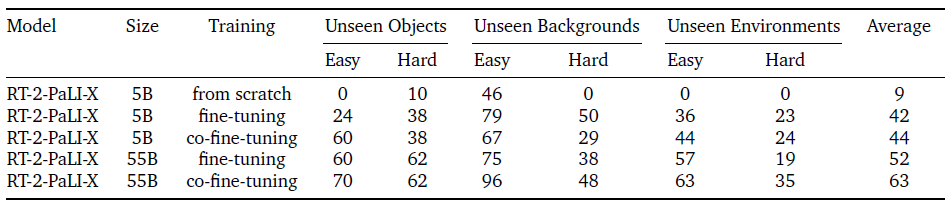

이 비교를 위해 우리는 모델 크기의 유연성 때문에 RT-2-PaLI-X 모델을 사용합니다 (PaLM-E의 특성상 RT-2-PaLM-E는 특정 크기의 PaLM 및 ViT 모델에만 제한됩니다).

특히, 우리는 5B와 55B라는 두 가지 다른 모델 크기와 세 가지 다른 학습 루틴을 비교합니다: VLM 사전 학습의 가중치를 사용하지 않고 모델을 처음부터 학습시키는 것; 로봇 액션 데이터만을 사용하여 사전 학습된 모델을 파인튜닝하는 것; 그리고 이 작업에서 사용된 주요 방법인 공동 파인튜닝 (파인튜닝을 통한 공동 학습)은 원래의 VLM 학습 데이터와 로봇 데이터를 모두 사용하여 VLM 파인튜닝을 수행하는 것입니다.

우리는 주로 이러한 모델의 일반화 측면에 관심이 있기 때문에, 이 일련의 실험에서 본 과제 평가를 제거합니다.

ablation 결과는 그림 6b와 부록 표 6에 나와 있습니다.

먼저, 매우 큰 모델을 처음부터 학습시키면 5B 모델에서도 성능이 매우 떨어지는 것을 관찰할 수 있습니다.

이 결과를 바탕으로, 우리는 처음부터 학습될 때 더 큰 55B PaLI-X 모델의 평가를 생략하기로 결정했습니다.

둘째, 모델을 (크기에 관계없이) 공동으로 파인튜닝하면 단순히 로봇 데이터로 파인튜닝하는 것보다 일반화 성능이 더 향상된다는 것을 알 수 있습니다.

우리는 이것을 원래 데이터를 학습의 파인튜닝 부분 주변에 유지하면 모델이 VLM 학습 중에 배운 이전 개념을 잊지 않을 수 있기 때문이라고 생각합니다.

마지막으로, 다소 놀랍지 않게도, 모델의 크기가 커지면 일반화 성능이 향상된다는 것을 알 수 있습니다.

4.4. Can RT-2 exhibit signs of chain-of-thought reasoning similarly to vision-language models?

LLMs에서 chain-of-thought 프롬프팅 방법 (Wei et al., 2022)에서 영감을 받아, 우리는 언어와 행동을 공동으로 활용할 수 있는 능력을 향상시키기 위해 PaLM-E를 사용한 RT-2 변형을 몇 백 단계만 파인튜닝하여, 더 정교한 추론 행동을 이끌어낼 수 있기를 희망합니다.

데이터를 보강하여 로봇이 자연어로 수행하려는 작업의 목적을 먼저 설명한 다음 실제 작업 토큰을 설명하는 추가 "Plan" 단계를 포함하도록 합니다, 예를 들어 "Instruction: I’m hungry. Plan: pick rxbar chocolate. Action: 1 128 124 136 121 158 111 255."

이 데이터 증강 방식은 VQA 데이터셋 (시각적 추론)과 조작 데이터셋 (액션 생성)을 연결하는 다리 역할을 합니다.

우리는 RT-2가 자연어로 먼저 액션을 계획할 수 있는 장소가 주어지기 때문에 더 정교한 명령에 응답할 수 있다는 것을 질적으로 관찰합니다.

이는 LLM 또는 VLM을 플래너로 사용하는 것이 단일 VLA 모델에서 저수준 policy와 결합될 수 있다는 초기 증거를 제공하는 유망한 방향입니다 (Anne et al., 2022; Driess et al., 2023).

chain-of-thought 추론을 포함한 RT-2의 출시는 그림 7과 부록 I에 나와 있습니다.

5. Limitations

RT-2는 유망한 일반화 특성을 보이지만, 이 접근 방식에는 여러 가지 한계가 있습니다.

첫째, VLM을 통한 웹 스케일 사전 학습을 포함하는 것이 시맨틱 및 시각적 개념에 대한 일반화를 촉진한다는 것을 보여주지만, 로봇은 이러한 추가 경험을 포함함으로써 새로운 액션을 수행할 수 있는 능력을 얻지 못합니다.

모델의 물리적 기술은 여전히 로봇 데이터에서 볼 수 있는 기술 분포에 국한되어 있지만 (부록 G 참조), 새로운 방식으로 기술을 배포하는 방법을 배웁니다.

우리는 이것이 데이터셋이 기술의 축을 따라 충분히 변화하지 않았기 때문이라고 믿습니다.

미래 연구의 흥미로운 방향은 인간의 비디오와 같은 새로운 데이터 수집 패러다임을 통해 새로운 기술을 습득할 수 있는 방법을 연구하는 것입니다.

둘째, 우리는 실시간으로 대규모 VLA 모델을 실행할 수 있음을 보여주었지만, 이러한 모델의 계산 비용이 높으며, 이러한 방법들이 고주파 제어가 필요한 설정에 적용됨에 따라 실시간 추론이 주요 병목 현상이 될 수 있습니다.

향후 연구를 위한 흥미로운 방향은 이러한 모델을 더 높은 속도 또는 더 저렴한 하드웨어에서 실행할 수 있는 양자화 및 distillation 기술을 탐구하는 것입니다.

이는 RT-2를 생성하는 데 사용할 수 있는 일반적으로 사용 가능한 VLM 모델의 수가 적다는 점에서 현재의 또 다른 한계와도 연결됩니다.

더 많은 오픈 소스 모델이 제공되고 독점 모델이 VLA 모델을 구축하는 데 필요한 파인튜닝 API를 개방하기를 바랍니다.

6. Conclusions

이 논문에서는 vision-language model (VLM) 사전 학습과 로봇 데이터를 결합하여 vision-language-action (VLA) 모델을 어떻게 학습할 수 있는지 설명했습니다.

그런 다음 PaLM-E와 PaLI-X를 기반으로 한 두 가지 VLA 인스턴스를 소개했는데, 이를 RT-2-PaLM-E와 RT-2-PaLI-X라고 부릅니다.

이 모델들은 로봇 궤적 데이터와 함께 파인튜닝되어 텍스트 토큰으로 표현되는 로봇 액션을 출력합니다.

우리는 우리의 접근 방식이 매우 우수한 로봇 policy를 제공하며, 더 중요한 것은 웹 규모의 비전-언어 사전 학습에서 물려받은 일반화 성능과 새로운 역량을 크게 향상시킨다는 것을 보여주었습니다.

우리는 이 간단하고 일반적인 접근 방식이 더 나은 비전-언어 모델로부터 직접적인 혜택을 받을 수 있는 로보틱스의 가능성을 보여준다고 믿습니다, 이는 로봇 학습 분야가 다른 분야의 발전과 함께 더욱 발전할 수 있는 전략적 위치에 있습니다.

'Robotics' 카테고리의 다른 글

| Open X-Embodiment: Robotic Learning Datasets and RT-X Models (0) | 2025.03.24 |

|---|---|

| PaLM-E: An Embodied Multimodal Language Model (0) | 2025.03.20 |

| RT-1: Robotics Transformer for Real-World Control at Scale (1) | 2025.03.10 |

| π0: A Vision-Language-Action Flow Model for General Robot Control (0) | 2025.02.20 |

| Cosmos World Foundation Model Platform for Physical AI (0) | 2025.01.10 |