2026. 1. 13. 14:36ㆍRobotics

X-VLA: Soft-Prompted Transformer as Scalable Cross-Embodiment Vision-Language-Action Model

Institute for AI Industry Research (AIR), Tsinghua University, Shanghai AI Lab, Peking University

성공적인 일반론적 Vision-Language-Action (VLA) 모델은 대규모, cross-embodiment, heterogeneous 데이터셋을 사용하여 다양한 로봇 플랫폼에서 효과적인 학습을 수행합니다.

풍부하고 다양한 로봇 데이터 소스의 heterogeneity를 촉진하고 활용하기 위해, 우리는 최소한의 매개변수를 추가한 새로운 소프트 프롬프트 접근 방식을 제안합니다, 이 접근 방식은 cross-embodiment 로봇 학습에 프롬프트 학습 개념을 도입하고 각 데이터 소스에 대해 학습 가능한 임베딩 세트를 별도로 도입하는 것입니다.

이러한 임베딩은 embodiment에 특화된 프롬프트 역할을 하며, 이는 다양한 cross-embodiment 피쳐를 효과적으로 활용하여 VLA 모델에 힘을 실어줍니다.

저희의 새로운 X-VLA는 깔끔한 플로우 매칭 기반 VLA 아키텍처로, 확장성과 단순성을 모두 갖춘 소프트 프롬프트 표준 트랜스포머 인코더에만 의존하고 있습니다.

6개의 시뮬레이션과 3개의 실제 로봇에서 평가된 0.9B instantiation-X-VLA-0.9B는 다양한 벤치마크에서 동시에 SOTA 성능을 달성하여 유연한 손재주부터 embodiments, 환경 및 작업 전반에 걸쳐 빠른 적응에 이르기까지 다양한 기능 축에서 우수한 결과를 입증했습니다.

1. Introduction

로봇 커뮤니티 (Brohan et al., 2023, 2022)에서 오랫동안 다음을 수행할 수 있는 자율 에이전트를 구축하는 것이 핵심 야망이었습니다: (1) 임의의 인간 지시를 유연하게 따르고, (2) 다양한 환경뿐만 아니라 다양한 embodiments에서도 능숙하게 작동합니다.

최근 Large Language Models (LLM) (Achiam et al., 2023; Bai et al., 2023)과 Vision-Language-Models (VLMs) (Li et al., 2024a)의 성공을 고려할 때, 한 가지 유망한 방향은 이러한 고급 아키텍처를 로봇 공학으로 확장하여 정확한 액션 모달리티를 통합함으로써 Vision-Language-Action (VLA) 모델을 탄생시키는 것입니다.

이러한 대형 VLA 모델은 단순한 pick-and-place 작업부터 복잡한 손재주 작업 (Black et al., 2024a; Team et al., 2025; Bjorck et al., 2025)에 이르기까지 강력한 조작 기능을 갖춘 일반화와 결합할 수 있다는 것이 내재된 기대입니다.

VLA 모델, 특히 out-of-distribution (OOD) 도메인에 빠르게 적응하는 능력의 성공은 광범위한 로봇 시스템 아키텍처와 다양한 작업 시나리오를 포괄하는 크고 다양한 로봇 데이터셋을 사용한 사전 학습에 달려 있습니다 (O'Neill et al., 2024; Lin et al., 2025; Tan et al., 2024).

여기서 중요한 도전 과제는 VLA 모델이 하드웨어 구성부터 데이터 수집 전략까지 상당한 이질성에 직면한다는 점입니다 (Wang et al., 2024c).

이러한 이질성은 구현별 액션 스페이스 (Liu et al., 2025b)뿐만 아니라 카메라 설정, 시각적 도메인, 작업 분포와 같은 설정 변형 (Doshi et al., 2024b; Shi et al., 2025b; Zhen et al., 2024b)에서도 나타납니다.

이러한 다양한 차원의 다양성은 embodiments 방식 간에 심각한 분포 변화와 유의미한 시맨틱 불일치를 유발하여 모델을 혼란스럽게 만들고 궁극적으로 불만족스러운 사전 학습 및 적응 성능을 초래합니다 (Zheng et al., 2025; Liu et al., 2025b; Doshi et al., 2024b).

기존의 VLA 방법들은 주로 embodiment에 특화된 액션 스페이스를 수용하기 위해 별도의 액션 디코더 헤드를 할당하며 (Physical Intelligence et al., 2025; Bjorck et al., 2025), 다른 중요한 이질성 소스들은 불가피하게 간과됩니다.

그러나 이러한 이질적인 구성 간의 조정은 고유 수용성 인식 추론과 이질적이고 혼합된 도메인 데이터셋에서 공유 지식을 추출하는 데 매우 중요하며, 이는 지속적으로 해결되지 않은 문제로 남아 있습니다: (1) 하드웨어 플랫폼 간의 불일치, (2) 표준화된 데이터 수집 프로토콜의 부재, (3) embodiment 및 환경 장벽에 걸쳐 발생하는 고유한 도메인 이동.

우리는 VLA 모델이 간단한 소프트 프롬프트 메커니즘을 통해 도메인별 하드웨어 구성을 학습할 수 있도록 함으로써 최소한의 인간 노력으로 이러한 장애물을 효과적으로 극복할 수 있음을 입증합니다 (Lesster et al., 2021).

메타 학습과 멀티태스크 학습의 통찰에서 영감을 받아, 우리는 로봇 공학 분야의 다양한 하드웨어 구성과 데이터 유형을 작업별 피쳐의 틀에 재구성하고, 이를 프롬프트 학습 기법을 통해 효과적으로 포착할 수 있습니다 (Wang et al., 2023; Liu et al., 2023c; Khattak et al., 2023; Liu et al., 2023b; Wu & Shi, 2022).

구체적으로, 앞서 언급한 다양한 이질성 차원을 모델링하기 위해 각 데이터 소스에 학습 가능한 임베딩 세트를 소프트 프롬프트로 할당합니다.

이러한 임베딩은 피쳐 융합의 초기 단계부터 VLA 표현 공간을 구조화하기 위한 이질성 인식 지침을 제공하며, 이는 VLA 모델이 cross-embodiment 변형을 활용하고 통합할 수 있는 향상된 능력을 제공하여 다양한 하드웨어 및 작업 구성 간의 일반화를 개선합니다.

공식적으로, 우리는 X-VLA라고 불리는 이질적인 플랫폼에서 운영되는 일반적인 플로우 매칭 기반 VLA 프레임워크인 소프트 프롬프트 트랜스포머를 소개합니다.

소프트 프롬프트를 통해 X-VLA는 시스템과 데이터의 다양한 구조를 수용하기 위해 명시적으로 학습된 개별 하드웨어 설정에 의해 안내될 수 있습니다.

멀티뷰 이미지, 언어 프롬프트, 고유 수용성 특징을 동시에 인코딩할 수 있는 다재다능한 아키텍처를 갖춘 X-VLA는 표준 트랜스포머 인코더를 적층하여 멀티모달 피쳐 융합 및 정밀한 액션 생성을 수행함으로써 확장 가능한 VLA 학습을 가능하게 합니다.

광범위한 실험을 통해 소프트 프롬프트가 다양한 이질성 차원을 처리하는 데 있어 다른 state-of-the-art (SOTA) 방법보다 우수하다는 것이 입증되었습니다.

X-VLA는 안정적인 학습 과정과 우수한 점근 성능을 보여주며, 더 큰 모델 크기와 혼합 로봇 데이터셋에 유리한 확장 기능을 제공합니다.

우리는 신중하게 설계된 데이터 처리 및 학습 레시피로 학습된 X-VLA의 0.9B 인스턴스인 X-VLA-0.9B를 구현합니다.

전체 학습 파이프라인은 두 단계로 구성됩니다:

1단계: 사전 학습.

우리는 Droid (Khazatsky et al., 2024), Robomind(Wu et al., 2025), Agibot (Bu et al., 2025)의 29만 개 에피소드로 구성된 큐레이팅된 이기종 데이터 혼합물에 대해 X-VLA-0.9B를 사전 학습했으며, 단일 팔부터 이중 수동 설정에 이르기까지 5가지 유형의 로봇 팔에 걸쳐 7개의 플랫폼을 포함하고 있습니다.

소프트 프롬프트를 활용하여 embodiment에 특화된 변형을 흡수함으로써, 모델은 embodiment-agnostic 일반주의 policy를 학습합니다.

2단계: 도메인 적응.

X-VLA-0.9B는 타겟 도메인에 대한 배포 가능한 policy에 맞게 조정되었습니다.

새로운 소프트 프롬프트 세트가 도입되어 사전 학습된 백본이 고정된 상태로 유지되는 동안 새로운 도메인의 하드웨어 구성을 인코딩하고 최적화됩니다.

이러한 프롬프트가 적용되면 policy는 파인튜닝을 통해 새로운 embodiment에 효과적으로 특화됩니다.

광범위한 평가를 통해 embodiments, 환경 및 작업 전반에 걸쳐 강력한 적응력을 입증했으며, 자율 주행 벤치마크 1개를 포함한 6개의 시뮬레이션 벤치마크와 3개의 실제 로봇 플랫폼에서 새로운 SOTA 결과를 달성했습니다.

게다가, 단 1,200번의 시연만으로 실제 세계에서 능숙한 천 접기 조작 작업에서 뛰어난 성능을 발휘하여 평균 2분 이내에 천 하나를 접을 수 있습니다.

놀랍게도 이전에 학습된 프롬프트를 통해 최소한의 학습 비용으로 매개변수 효율적인 파인튜닝 (Hu et al., 2022)을 통해 2단계 적응을 효율적으로 실현할 수 있습니다.

모델 매개변수(9M)의 1%만 조정하면 X-VLA-0.9B는 300×최소 매개변수(3B vs. 9M)가 필요함에도 불구하고 LIBERO에서 93%, Simpler-WidowX에서 54%의 성공률을 달성하여 𝜋0 (Physical Intelligence et al., 2025)과 비슷한 수준입니다.

2. Preliminary

VLA models.

VLA 모델은 로봇 제어를 위해 멀티모달 이해와 액션 생성을 통합하는 모델의 한 종류입니다 (Physical Intelligence et al., 2025; NVIDIA et al., 2025).

일반적으로 VLA 모델은 대규모 이미지 텍스트 말뭉치에서 사전 학습된 VLM에서 초기화한 다음 expert 궤적이 포함된 로봇 데이터셋에서 파인튜닝됩니다: D = {𝜏_𝑗}, 𝜏_𝑗 = {(𝑜_𝑛, 𝑎_𝑛))}, 여기서 𝑜_𝑛는 단계 𝑛 (예: 시각적 입력, 언어 지시, 고유 수용 상태)에서의 멀티모달 관찰을 나타내며, 𝑎_𝑛는 해당 expert의 작업입니다.

학습 objective는 일반적으로 행동 복제로 구성되며, 여기서 𝜃에 의해 매개변수화된 policy 𝜋_𝜃(𝑜_𝑛)는 시연된 액션 청크인 𝐴_𝑛 := [𝑎_𝑛, 𝑎_(𝑛+1), ..., 𝑎_(𝑛+𝑇)) ]𝑇을 예측하기 위해 최적화됩니다, 여기서 𝑇는 청크 크기를 나타냅니다 (Zhao et al., 2023; Chi et al.; Physical Intelligence et al., 2025), 이는 적절한 supervised loss ℓ(·)를 최소화함으로써 다음과 같습니다: L_BC(𝜃) = 𝔼_((𝑜_𝑛, 𝐴_𝑛)~D) [ℓ(𝜋_𝜃(𝑜_𝑛), 𝐴_𝑛)].

Flow-matching policy.

관측 𝑜에서 expert 액션 청크 𝐴를 직접 예측하는 대신, 플로우 매칭 policy는 일반적으로 타겟 액션 청크로 노이즈 샘플을 전송하는 속도 필드를 학습합니다 (Lipman et al., 2023; Physical Intelligence et al., 2025; Black et al., 2025).

예를 들어, 가우시안 노이즈 𝐴^0 ~ N(0, 𝐼)에서 시작하여 Euler-Maruyama 방법과 같은 ODE 솔버를 사용하여 신경망에 의해 매개변수화된 속도 필드 𝑣_𝜃(𝐴_𝑡, 𝑜, 𝑡)를 통해 반복적으로 정제함으로써 액션 𝐴를 생성할 수 있습니다: 𝐴^(𝑡+Δ𝑡) = 𝐴^𝑡 + 𝑣_𝜃(𝐴^𝑡 , 𝑜, 𝑡)Δ𝑡.

여기서 𝑡 ∈ [0, 1]은 연속 시간 변수입니다.

속도 필드를 학습하기 위해 우리는 OT (optimal transport) 경로 (Lipman et al., 2024, 2023)를 사용합니다, 이 경로는 속도를 노이즈와 expert 데이터 사이의 선형 보간 경로와 일치시킵니다:

, 𝐴^𝑡 = (1-𝑡)𝐴^0+𝑡𝐴, U는 균일 분포입니다.

L_BC^FM을 최소화함으로써, policy는 관찰을 조건으로 랜덤 노이즈를 expert 청크로 점진적으로 전송하는 방법을 학습합니다.

Heterogeneity in cross-embodiment training.

𝐻 이종 데이터셋인 D^𝐻 = {D_𝑖}로 구성된 혼합 데이터 레시피에 대한 학습은 일반적인 VLA 모델을 개발하는 데 필수적입니다 (Doshi et al., 2024a; O'Neill et al., 2024).

각 데이터셋인 D_𝑖는 특정 하드웨어 구성인 ℎ_𝑖 ∈ H 하에서 수집되며, 여기서 H는 암 동역학, 제어 인터페이스, 카메라 구성 및 배포 시나리오와 같은 가능한 하드웨어 설정 공간을 나타냅니다.

이는 낮은 수준의 액션 신호와 분포뿐만 아니라 높은 수준의 시각적 이해에서도 상당한 이질성을 초래하여 효과적으로 다루지 않으면 사전 학습과 적응이 저하될 수 있습니다 (Wang et al., 2024c; Zheng et al., 2025).

3. Heterogeneous Soft Prompt Learning

이질성을 해결하기 위해, 우리는 그림 2와 같이 잠재적인 디자인 선택을 탐구하기 위해 포괄적인 실증 연구를 수행합니다.

우리는 Reuss et al. (2025); Bjorck et al. (2025)를 따라 표준 이중 시스템 아키텍처를 시작점으로 설정합니다, 이 아키텍처는 멀티모달 인식을 위한 VLM과 액션 생성을 위한 DiT 스타일 디코더를 활용합니다.

그림 3에서는 AGIBOT-beta (Bu et al., 2025), RoboMind (Wu et al., 2025), 그리고 Droid (Khazatsky et al., 2024)를 포함한 최근의 고품질 소스로부터 이질적인 데이터 혼합을 구성합니다.

이 데이터셋은 단일 팔 설정부터 이중 수동 설정까지 다섯 개의 로봇에 걸친 일곱 가지 하드웨어 설정에 걸쳐 있으며, 일반주의 policy 학습에 필요한 충분한 규모와 다양성을 제공합니다.

우리는 공정한 비교를 보장하기 위해 완전히 정렬된 학습 레시피를 사용하여 모든 방법을 평가합니다.

자세한 학습 내용은 부록 I을 참조하세요.

(a) Domain-speific action projection.

이 전략은 모델 출력에 별도의 프로젝션 헤드를 할당하여 액션 토큰을 embodiment-specific 액션 스페이스에 매핑함으로써 이질성을 해결합니다.

이 접근 방식은 이전의 embodied 파운데이션 모델 (Physical Intelligence et al., 2025; Bjorck et al., 2025; Team et al., 2025; Zheng et al., 2025; Liu et al., 2025b)에서 널리 사용되지만, 그 효과는 최종 액션 생성 단계로 제한됩니다.

따라서 파이프라인 초기에 embodiment-aware 추론을 장려하지 못하고 다양한 카메라 설정 및 작업 분포의 변화와 같은 이질성의 다른 중요한 원인을 간과합니다.

이러한 한계를 극복하기 위해, 우리는 그림 2에 요약된 바와 같이 이질적인 데이터셋에서 사전 학습 안정성을 향상시키는 세 가지 대표적인 전략을 식별합니다.

다음 논의에서 이러한 전략을 분석하고 추가 실험 시도를 부록 E에 보고합니다.

(b) HPT-style projection.

Wang et al. (2024c)에서 영감을 받은 이 접근 방식은 관찰 입력의 도메인 불일치를 완화하고, 서로 다른 도메인의 관찰을 공유된 표현 공간으로 매핑하여 일반주의적 추론을 촉진하는 것을 목표로 합니다.

구체적으로, 도메인별 투영 레이어는 백본에 입력되기 전에 멀티모달 입력 위에 적용되어 정렬됩니다.

(c) Language prompts.

또 다른 전략은 사전 학습된 VLM의 언어 추론 능력을 활용합니다 (Li et al., 2024a; Li et al.).

이 경우, 하드웨어 구성 ℎ_𝑖에 대한 자연어 설명이 추가 입력으로 제공되어 모델이 텍스트 설명을 통해 embodiment-specific 변형을 명시적으로 처리할 수 있습니다.

(d) Soft prompts.

마지막으로, 데이터 소스 간의 이질성을 흡수하기 위해 도메인별 학습 가능한 매개변수인 𝑃^𝐻 = {𝑝_𝑖}를 도입하여 메타 학습 및 멀티태스크 학습 철학 (Finn et al., 2017; Liu et al., 2023c)을 따르는 소프트 프롬프트 방법을 조사합니다.

𝑝_𝑖는 기본 하드웨어 구성을 인코딩할 것으로 예상됩니다: 𝑝_𝑖 ≈ Φ(ℎ_𝑖), 여기서 Φ : H → ℝ^𝑘는 하드웨어 구성에서 프롬프트 공간으로의 잠재 매핑을 나타냅니다.

특히, Φ는 언어 프롬프트 (c)에서처럼 하드 템플릿에 의해 미리 정의되지 않고 랜덤으로 초기화된 후 종단 간 학습을 통해 암묵적으로 최적화됩니다.

이러한 소프트 프롬프트는 액션 생성 초기 단계에서 모델에 주입되어 백본을 embodiment-aware 학습으로 자동 안내합니다.

(b) HPT 스타일의 프로젝션과 (c) 언어 프롬프트는 개념적으로 매력적이지만, 눈에 띄는 한계를 가지고 있습니다.

HPT 스타일의 프로젝션은 관찰 처리 중간에 다양한 프로젝션 레이어를 도입하여 피쳐 분포를 자주 변경하고 사전 학습된 VLM 표현을 손상시키기 쉬우며, 종종 불안정한 학습 역학을 초래합니다.

반면에 언어 프롬프트는 하드웨어 구성에 대한 신중하게 작성된 텍스트 설명에 의존하여 실제로 적응성과 확장성을 크게 저해합니다.

반면, 소프트 프롬프트는 도메인별 하드웨어 구성을 인코딩하기 위한 유연하고 확장 가능한 솔루션을 제공합니다.

그들은 (b)와 (c)의 장점을 결합하여 사전 학습된 표현을 보존하면서도 수작업 주석이 필요 없도록 백본과 원활하게 통합됩니다.

그림 4의 경험적 결과는 소프트 프롬프트가 이질적인 데이터셋에서 훨씬 더 견고하고 안정적인 학습을 지속적으로 달성한다는 것을 확인시켜줍니다.

4. X-VLA: Soft-Prompted Transformer Enhanced VLA model

소프트 프롬프트를 기반으로 이기종 데이터셋에 대한 안정적인 사전 학습과 새로운 도메인에 대한 효율적인 적응을 위해 설계된 깔끔한 VLA 아키텍처인 X-VLA를 소개합니다.

먼저 전체적인 아키텍쳐 설계를 소개한 후, 대규모 사전 학습을 위한 몇 가지 주요 기법을 소개합니다.

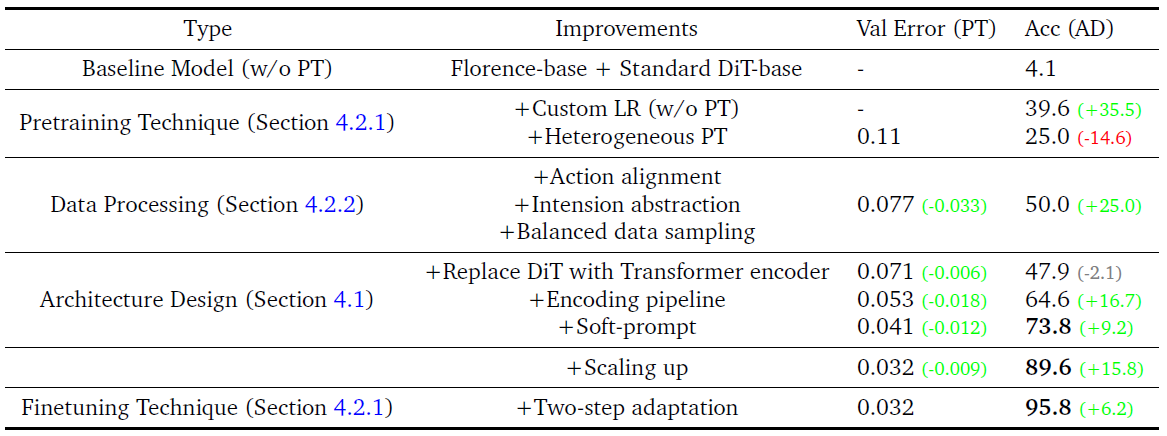

완전한 ablation 경로는 이 섹션에서 소개된 구성 요소의 기여도를 강조하는 표 1에 나와 있습니다.

4.1. Architecture

우리 디자인의 핵심 아이디어는 복잡한 멀티모달 입력을 위한 간소화된 인코딩 파이프라인을 구축하는 것입니다.

소프트 프롬프트 외에도 X-VLA는 (1) 고차원 입력 (멀티뷰 비주얼 및 언어)과 (2) 저차원 상태 (독자 수용 및 액션 토큰)를 처리합니다.

이러한 모달리티 간의 시맨틱과 차원성의 상당한 불일치로 인해, 우리는 이들을 효과적으로 정렬하기 위해 전용 인코딩 전략을 사용합니다, 그 후 vanilla 트랜스포머 스택은 확장 가능한 policy 학습에 충분합니다.

아래에서는 전체 아키텍처가 포함된 인코딩 파이프라인에 대해 자세히 설명하고 추가 설계 탐색은 부록 C와 부록 D에 제공됩니다.

1) High-dimensional observation stream.

고차원 입력에는 멀티뷰 이미지 Img = {img_𝑖}와 작업 objective를 지정하는 언어 𝐿가 포함됩니다.

대부분의 이전 접근 방식 (Physical Intelligence et al., 2025; Octo Model Team et al., 2024; Bjorck et al., 2025)이 모든 뷰와 명령어를 VLM에 직접 입력하는 것과 달리, 우리는 고유한 인코더를 할당하여 스트림을 분리합니다.

사전 학습된 VLM 인코더 (Florence-Large (Xiao et al., 2024) in X-VLA)는 주요 비전 언어 스트림 (고정 뷰 및 지시)에 사용되며, 손목 뷰와 같은 보조 뷰는 공유 비전 백본으로 처리됩니다.

이 디자인은 일반적인 비전 언어 추론과 embodied 추론 사이의 시맨틱 격차를 완화합니다: 고정 카메라 뷰는 고수준 작업 추론을 위한 안정적이고 유익한 컨텍스트를 제공합니다; 반면, 손목 카메라 입력은 노이즈가 많고 빠르게 변화하지만 세밀한 조작을 위한 중요한 단서를 제공하므로 언어 스트림과 별도로 인코딩됩니다.

2) Low-dimensional proprioceptive-action stream.

고유 수용 상태 𝑅_𝑡, 예를 들어 관절 위치와 엔드 이펙터 포즈는 추론과 제어를 위한 embodiment-specific 근거를 제공합니다.

액션 관련 토큰 𝐴_𝑡는 플로우 매칭 생성에 사용되는 노이즈가 있는 액션 샘플로 구성되어 있습니다.

𝑅_𝑡와 𝐴_𝑡는 모두 밀접하게 관련된 물리적 시맨틱을 가진 콤팩트 벡터이기 때문에, 플로우 매칭 파이프라인 내에서 이들을 해당 시간 임베딩 𝑇와 함께 연결합니다.

융합된 임베딩은 가벼운 선형 레이어를 통해 고차원 피쳐 공간에 투영되어 다른 모달리티와의 초기 융합을 가능하게 하고 강력한 고유 수용성-시간적 기반을 보장합니다.

4.2. Customized Training Recipe

X-VLA의 잠재력을 완전히 장려하기 위해, 우리는 X-VLA 학습의 안정성과 효과성을 모두 향상시키기 위해 신중하게 설계된 학습 공학을 소개합니다.

우리는 학습 레시피에 대한 개요를 제공하고 안정적이고 효율적인 학습을 위해 중요한 몇 가지 주요 기술을 개략적으로 설명합니다.

4.2.1. Pretraining and Finetuning Pipeline

사전 학습을 위해 백본 𝜋_𝜃와 소프트 프롬프트 𝑃^𝐻는 플로우 매칭 objective L_BC^FM 하에서 공동으로 최적화됩니다.

자세한 사전 학습 하이퍼파라미터는 부록 G를 참조하세요.

사전 학습 후, 백본은 이종 로봇 전반에 걸쳐 신속하게 적응할 수 있는 embodiment-agnostic 파운데이션이 됩니다.

이 모델을 새로운 하드웨어 구성 ℎ_new를 가진 새로운 도메인에 배포하기 위해, 우리는 가벼운 2단계 적응 절차를 제안합니다:

(1) Prompt warm-up.

우리는 ℎ_new를 위한 새로운 학습 가능한 프롬프트 𝑝_new ∈ ℝ^𝑘 세트를 소개합니다.

프롬프트는 먼저 미리 학습된 가중치를 얼린 상태로 유지하면서 예열됩니다.

이를 통해 프롬프트는 사전 학습된 embodiment-agnostic 피쳐를 활용하여 다음 라운드 공동 학습에 좋은 시작을 제공할 것으로 예상됩니다.

(2) Joint policy adaptation.

그런 다음 백본과 예열 프롬프트를 공동으로 최적화하여 새로운 도메인에 공동으로 적응합니다.

이 두 단계 프로세스를 통해 𝑝_new는 먼저 ℎ_new의 하드웨어별 설정을 인코딩한 다음 효과적인 전문화를 위해 전체 policy를 파인튜닝하여 LLM을 VLM에 적용하는 데 사용된 것과 동일한 철학을 공유합니다 (Liu et al., 2023a; Li et al.).

Custom learning rate (LR).

사전 학습과 적응 모두에서 중요한 안정화 기법 중 하나는 소프트 프롬프트뿐만 아니라 시각적 및 언어적 입력을 인코딩하는 시각-언어 모듈에 대해서도 학습률을 낮추는 것입니다.

이 조정은 사전 학습된 표현으로 인한 재앙적인 드리프트의 위험을 줄여주며, 이는 (Russ et al., 2025; Driess et al., 2025)에서도 언급한 문제입니다, 이는 사전 학습 중에는 더 원활한 최적화를, 새로운 embodiments 방식에 적응할 때는 더 신뢰할 수 있는 전문화를 제공합니다.

비전-언어 모델에 인코딩된 일반 지식과 VLA 모델에 필요한 세밀한 공간 위치 및 맥션 기반을 효과적으로 연결합니다.

4.2.2. Enhanced Data Processing

Aligned action representation.

액션은 VLA 모델의 핵심 supervision 신호이며, 그 품질은 학습 결과를 직접적으로 결정합니다.

따라서 우리는 액션 공간을 end-effector (EEF) 포즈 표현으로 표준화합니다: (1) 카테시안 EEF xyz 위치, (2) 오일러 각도와 쿼터니언 표현에 내재된 불연속성을 피하기 위해 Rotate6D 표현을 사용하여 인코딩된 절대 EEF 회전 (Zhou et al., 2019), 그리고 (3) 그리퍼의 이산화된 이진 상태.

위치와 회전은 mean-squared-error (MSE) loss를 사용하여 최적화되며, 그리퍼 상태는 binary-cross-entropy (BCE) loss를 사용하여 최적화됩니다.

이는 embodiments 방식 전반에 걸쳐 일관성을 보장하여 일반화 가능한 policy 학습에 대한 강력한 supervision을 제공합니다.

Intention abstraction through temporal downsampling.

저수준 액션 궤적은 배치에 필요한 정밀한 조작 신호를 제공하지만, 종종 너무 세분화되어 있고 인간의 랜덤성으로 인해 많은 노이즈가 있는 움직임을 포함할 수 있으므로 사전 학습을 위한 고수준의 접지 및 의도 모델링을 달성하는 데 적합하지 않습니다.

이 문제를 완화하기 위해 일시적으로 데모를 다운샘플링하여 액션 의도의 추상적 표현을 구성합니다.

구체적으로, 파이프라인은 매 시간 단계마다 전체 엔드 이펙터 포즈를 예측하는 대신, 향후 4초 동안 의도된 궤적을 요약하는 30개의 앵커 포인트 시퀀스를 생성하도록 설계되었습니다.

Balanced data sampling strategy.

일반적인 라운드 로빈 데이터 샘플링 전략 (Wang et al., 2024c)과 달리, 우리는 안정적인 학습을 위해서는 신중하게 설계된 데이터 셔플링 파이프라인이 필요하다는 것을 관찰했습니다.

우리는 샘플을 다양한 도메인뿐만 아니라 각 도메인 내의 궤적을 넘나들며 섞습니다, 이를 통해 매 반복마다 다양하고 균형 잡힌 데이터 혼합물에 노출될 수 있습니다.

이는 분포 편향을 효과적으로 완화하고 지배적인 도메인에 대한 과적합을 줄여 대규모 사전 학습 중에 더 원활한 수렴을 촉진합니다.

5. Experiments

이 섹션에서는 다음을 조사하기 위해 광범위한 실험을 수행합니다

1. 스케일링 동작: X-VLA는 모델 크기, 데이터 다양성, 데이터 규모에 따라 스케일링 특성을 나타내나요?

2. 적응 성능: X-VLA는 다양한 특성을 가진 새로운 도메인에 특화될 수 있습니까?

3. 해석 가능성: 소프트 프롬프트가 혼합 데이터 소스의 이질성을 반영하는 의미 있는 표현을 포착합니까?

5.1. Scaling Experiments

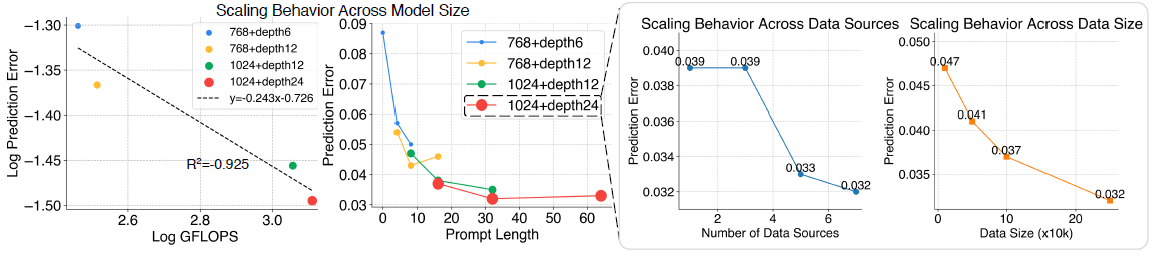

먼저, 세 축을 따라 X-VLA의 스케일링 동작을 연구합니다: (1) 모델 용량, (2) 데이터 다양성, (3) 데이터 볼륨.

표 1에서 볼 수 있듯이, 사전 학습 중에 관찰된 예측 오류는 다운스트림 적응 성능과 강한 상관관계가 있습니다.

따라서 우리는 (플로우 매칭 디노이징 후) 예측된 액션과 보류된 검증 세트에서 실제 동작 사이의 ℓ1 오차를 주요 평가 지표로 채택합니다.

해당 결과는 그림 5에 요약되어 있으며, 추가 학습 세부 사항은 부록 G에 제시되어 있습니다.

특히, 7개의 데이터 소스에서 29만 개의 에피소드를 학습한 가장 큰 테스트 구성인 X-VLA-0.9B (숨겨진 크기 1024, 24개의 트랜스포머 블록)에서도 스케일링 추세가 포화된 징후를 보이지 않습니다.

이는 이 세 축을 따라 추가적인 증가가 추가적인 성능 향상을 가져올 수 있음을 나타냅니다.

자원 제약으로 인해, 우리는 후속 실험의 디폴트 모델로 가장 큰 구성을 채택합니다.

5.2. Adaptation Experiments

지금까지 가장 포괄적인 검증 연구 중 하나인 X-VLA-0.9B를 5개의 시뮬레이션 환경과 3개의 실제 로봇 플랫폼에서 평가했습니다.

더 많은 실험 결과는 부록 D를 참조하세요.

Simulation benchmarks.

우리는 Libero (Liu et al., 2024), Simplar (Li et al., 2025), VLABench (Zhang et al., 2024a), RobotTwin-2.0 (Chen et al., 2025), Calvin (Mees et al., 2022), NAVSIM (Dauner et al., 2024)을 평가합니다.

이 6가지 벤치마크는 단일 팔, 이중 수동 로봇 시스템, 자율 주행, cross-embodiment, 교차 환경, 교차 작업 적응 등 다양한 일반화 축을 평가하는 수백 가지 평가 설정을 포함합니다.

FIVE 벤치마크 전반에 걸쳐 새로운 SOTA를 설정하여 집계된 이전 모델에 비해 상당한 개선을 이루었습니다.

놀랍게도 Simpler-WidowX (96%), Libero (98%), Calvin-1st 단계 등 여러 벤치마크에서 90% 이상의 성공률을 달성했습니다.

우리가 아는 한, 이러한 종합적인 평가와 지속적으로 유의미한 이득을 함께 보고한 이전 모델은 없으며, 이는 향후 고급 모델 개발을 위한 연구의 강력한 베이스라인이 될 수 있는 X-VLA-0.9B의 우수한 성능을 강조합니다 (자세한 내용은 부록 H를 참조하십시오).

Real-world experiments.

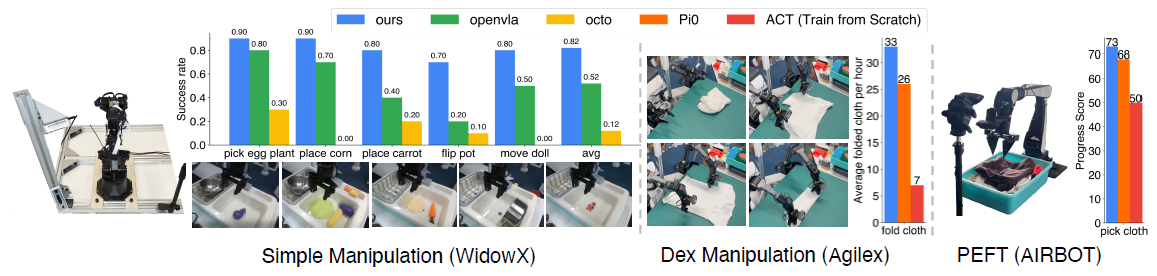

또한 물리적 로봇 플랫폼에서 X-VLA-0.9B를 BridgeData-v2 벤치마크 (Walke et al., 2023)에 따라 평가했으며, 평가 세부 사항은 부록 J에서 확인할 수 있으며 결과는 그림 7에 보고되어 있습니다.

우리의 X-VLA는 각기 다른 기능 축을 테스트하는 데 있어 다른 다섯 가지 작업 모두에서 다른 베이스라인을 능가하며, 이는 우리의 X-VLA의 뛰어난 적응력을 입증합니다.

Dexterous cloth-folding task.

우리는 매우 무질서한 옷을 매끄럽게 다듬고 깔끔하게 접어야 하는 도전적인 손재주 있는 옷 접기 작업을 소개합니다.

이러한 노력을 지원하기 위해, 우리는 신중하게 설계된 파이프라인을 통해 수집된 1,200개의 궤적으로 구성된 이중 수동 Agilex 플랫폼에 고품질의 옷 접이식 데이터셋인 Soft-Fold를 구축합니다.

작업과 데이터셋에 대한 자세한 설명은 부록 F에 나와 있습니다.

중요한 것은 향후 손재주 있는 조작에 대한 연구를 촉진하기 위해 데이터 세트를 공개할 것이라는 점입니다.

이 데이터셋을 활용하여 적응한 결과, 우리의 X-VLA-0.9B 모델은 거의 100%의 성공률과 시간당 33번의 완료된 접힘을 달성했습니다—상당히 크고 고품질의 데이터셋으로 학습된 것으로 추정되는 폐쇄형 소스 𝜋_0 접이식 모델 (Physical Intelligence et al., 2025)과 비교할 수 있습니다.

공정한 비교를 위해 𝜋_0 기반을 파인튜닝하고 소프트폴드에서 ACT (Zhao et al., 2023) 모델을 처음부터 학습시켰지만, X-VLA-0.9B의 처리량과 일치하지 않아 모델의 강력한 손재주 조작 능력을 강조했습니다.

추가적인 질적 결과는 부록 F에 제공되며 웹 데모에 표시됩니다:

Parameter efficient finetuning (PEFT) experiments.

사전 학습된 X-VLA-0.9B 백본이 embodiment-agnostic 피쳐를 인코딩하고 새로운 설정에 효율적으로 적응할 수 있는지 평가하기 위해, 우리는 Low-Rank Adaptation (LoRA)과 같은 PEFT 기법을 채택합니다 (Hu et al., 2022).

우리는 세 가지 벤치마크에서 적응을 테스트합니다: Libero, Simpler-WidowX, 그리고 AIRBOT에서의 옷-집기 작업은 사전 학습 중에 볼 수 없었던 실제 embodiment입니다.

표 3과 표 7은 9M 개의 조정 가능한 매개변수 (전체 모델의 약 1%)만으로도 백본을 강력한 도메인 특화 모델로 조정할 수 있으며, Libero와 Simpler-WidowX 벤치마크에서 각각 93%와 54%의 성공률을 달성했음을 보여줍니다.

이 점수는 완전 파인튜닝 모델과 비교할 수 있으며, 예를 들어 𝜋_0 (Black et al., 2025)은 Libero와 Simpler-WidowX에서 각각 94.2%와 55.7%를 달성하여 X-VLA의 강력한 적응 능력을 입증했습니다.

5.3. In-Depth Analysis

우리는 또한 질적 결과와 양적 결과를 통해 소프트 프롬프트의 효과를 명확히 합니다.

먼저 T-SNE (Maaten & Hinton, 2008)를 사용하여 혼합 데이터 레시피에 대한 사전 학습 후 학습한 소프트 프롬프트를 시각화합니다 (그림 3).

그림 8은 프롬프트가 다양한 하드웨어 구성과 밀접하게 일치하는 잘 구조화된 클러스터를 형성한다는 것을 보여주며, 이는 embodiment-specific 정보를 성공적으로 캡처했음을 나타냅니다.

더 흥미로운 점은 Droid 데이터에서 파생된 두 Franka 설정 (왼쪽과 오른쪽 뷰)이 분리되지 않고 혼합되어 있다는 점입니다, 이는 지정된 메인 뷰만 다를 뿐이기 때문입니다.

이 관찰은 소프트 프롬프트가 단순한 강제 방식으로 데이터 소스를 분할하는 것이 아니라 cross-embodiment 유사성을 활용한다는 것을 시사합니다.

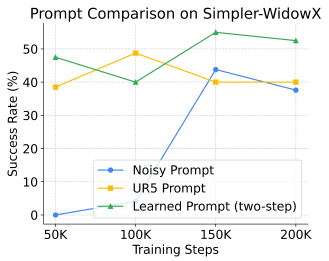

또한, 사전 학습된 소프트 프롬프트가 사전 학습에서 볼 수 없었던 단일 팔 로봇인 WidowX에 효율적으로 적응하는 방법을 평가합니다.

Simpler에서 PEFT 실험을 수행하여 세 가지 설정을 비교합니다: (1) 랜덤으로 초기화된 소프트 프롬프트는 frozen 상태로 유지되었고, (2) 다른 단일 팔 플랫폼 (예: UR5)에서 사전 학습된 프롬프트는 frozen 상태로 유지되었으며, (3) 2단계 적응 메커니즘으로 적응된 소프트 프롬프트는 동결되었습니다.

그림 9에서 학습된 프롬프트가 더 빠르게 수렴하여 마침내 더 높은 성공률에 도달하는 반면, 랜덤 프롬프트는 적응 속도가 느려지고 성능이 저하되는 것은 놀라운 일이 아닙니다.

그러나 UR5와 WidowX의 부분적인 유사성으로 인해 frozen 사전 학습 프롬프트가 초기 단계에서 강력한 전송 이점을 제공한다는 것은 좋은 일이지만, 불가피한 도메인 갭으로 인해 최종 성능이 제한됩니다.

이는 cross-embodiment 전이를 위한 유망한 방법을 강조합니다: 더 다양한 로봇 플랫폼에서 사전 학습을 통해 소프트 프롬프트는 가장 가까운 하드웨어 설정에 맞춰 프롬프트를 검색하여 제로샷/퓨샷 일반화를 가능하게 할 수 있습니다.

6. Conclusion

이 논문에서는 이질적인 로봇 플랫폼에서 작동할 수 있는 일반적인 비전-언어-액션 프레임워크인 X-VLA를 소개합니다.

신중하게 설계된 학습 파이프라인, 적응 방법 및 향상된 데이터 처리를 통해 우리의 가장 큰 모델인 X-VLA-0.9B는 광범위한 벤치마크에서 SOTA 성능을 달성하여 수백 개의 평가 설정에서 상당한 성과를 거두며 새로운 기록을 세웠습니다.

놀랍게도, 최소한의 조정 가능한 매개변수로도 X-VLA-0.9B는 완전히 파인튜닝된 SOTA 모델과 경쟁할 만한 결과를 제공합니다.

중요한 것은 소프트 프롬프트 메커니즘을 통해 X-VLA가 가장 큰 테스트 구성 (0.9억 개의 파라미터, 29만 개의 에피소드, 7개의 데이터 소스)에서도 포화 징후 없이 모델 크기, 데이터 다양성, 데이터 볼륨 등 세 가지 축 모두에서 확장 가능한 학습 트렌드를 보여준다는 점입니다.

이는 더 큰 모델과 데이터 세트로 확장하여 더 강력한 VLA 모델로 나아갈 수 있는 잠재력을 강조합니다.

제한 사항과 향후 작업은 부록 N에서 논의됩니다.