2023. 9. 4. 19:25ㆍView Synthesis

D-NeRF: Neural Radiance Fields for Dynamic Scenes

Albert Pumarola, Enric Corona, Gerard Pons-Moll, Francesc Moreno-Noguer

Abstract

머신러닝과 기하학적 추론을 결합한 신경 렌더링 기술은 희소한 이미지 집합에서 장면의 새로운 뷰를 합성하기 위한 가장 유망한 접근법 중 하나로 부상했습니다.

이 중에서도 5D 입력 좌표(공간 위치 및 뷰 방향을 나타내는)를 볼륨 밀도와 뷰에 의존하는 방출된 radiance로 매핑하도록 심층 네트워크를 학습시키는 Neural radiance fields (NeRF) [31]가 눈에 띕니다.

그러나 생성된 이미지에서 전례 없는 수준의 포토리얼리즘을 달성했음에도 불구하고 NeRF는 서로 다른 이미지에서 동일한 공간 위치를 쿼리할 수 있는 정적 장면에만 적용됩니다.

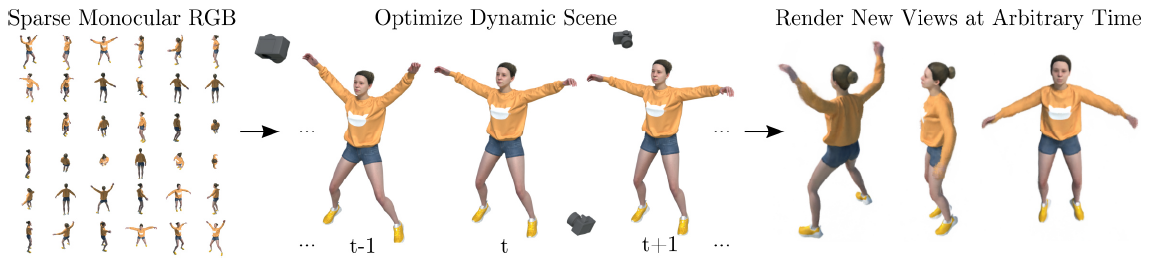

본 논문에서는 neural radiance fields를 동적 영역으로 확장하여 장면 주변을 이동하는 단일 카메라에서 경직되고 경직되지 않은 움직임 하에서 객체의 새로운 이미지를 재구성하고 렌더링할 수 있는 방법인 D-NeRF를 소개합니다.

이를 위해 시간을 시스템에 대한 추가 입력으로 간주하고 학습 프로세스를 두 가지 주요 단계로 나눕니다: 장면을 표준 공간으로 인코딩하는 것과 특정 시간에 이 표준 표현을 변형된 장면으로 매핑하는 것이 있습니다.

두 매핑은 모두 완전히 연결된 네트워크를 사용하여 동시에 학습됩니다.

네트워크가 학습되면 D-NeRF는 카메라 뷰와 시간 변수를 모두 제어하여 새로운 이미지를 렌더링할 수 있으며 따라서 객체 이동을 제어합니다.

우리는 경직되고 관절형이며 경직되지 않은 움직임 하에서 객체가 있는 장면에 대한 접근 방식의 효과를 입증합니다.

1. Introduction

희소 입력 이미지 세트에서 장면의 새로운 사진-사실 뷰를 렌더링하는 것은 증강 현실, 가상 현실, 3D 콘텐츠 제작, 게임 및 영화 산업 등의 많은 응용 분야에 필요합니다.

최근 기하학과 외관을 모두 인코딩하는 장면 표현을 학습하는 신경 렌더링 분야의 발전은 [31, 28, 24, 58, 34, 41], 전통적인 Structure-From-Motion [18, 48, 44], 라이트 필드 사진술 [22] 및 이미지 기반 렌더링 접근법 [6]을 크게 능가하는 결과를 달성했습니다.

예를 들어, Neural Radiance Fields (NeRF)[31]는 단순한 다층 퍼셉트론 네트워크가 5D 입력(공간 위치(x, y, z) 및 카메라 뷰(θ, ɸ))에서 방출된 radiance 값 및 볼륨 밀도로의 매핑을 인코딩할 수 있음을 보여주었습니다.

이렇게 학습된 매핑을 통해 탁월한 사실감을 가진 자유 시점 렌더링이 가능합니다.

후속 작업에서는 Neural Radiance Fields를 심각한 조명 변화를 겪고 있는 야생의 이미지로 확장하고 [28] 신속한 추론을 위해 희소 복셀 필드를 제안했습니다.

유사한 체계가 최근 다중 시점 표면 재구성 [58] 및 학습 표면 라이트 필드 [35]에도 사용되었습니다.

그럼에도 불구하고 이러한 모든 접근 방식은 물체를 움직이지 않는 정적 장면을 가정합니다.

이 논문에서 우리는 이 가정을 완화하고 정지 물체와 이동/변형 물체 모두로 만들어진 동적 장면에 적용할 수 있는 우리가 아는한 최초의 종단 간 신경 렌더링 시스템을 제안합니다.

4D 뷰 합성[3]에 대한 접근 방식이 있지만 우리의 접근 방식은 다음 점에서 다릅니다:

1) 카메라 하나만 있으면 됩니다;

2) 3D 재구성을 미리 계산할 필요가 없습니다;

그리고 3) 우리의 접근 방식은 엔드 투 엔드로 학습될 수 있습니다.

우리의 아이디어는 연속적인 6D 함수로 시스템의 입력을 표현하는 것인데, 3D 위치 및 카메라 뷰 외에도 시간 성분 t도 고려합니다.

(x, y, z, t)에서 밀도 및 radiance로의 매핑을 학습하기 위해 NeRF를 나이브하게 확장하는 것은 장면의 시간적 중복성을 효과적으로 활용하지 않기 때문에 만족스러운 결과를 생성하지 않습니다.

우리의 관찰은 물체가 움직이고 변형될 수 있지만 일반적으로 나타나거나 사라지지 않는다는 것입니다.

고전적인 3D scene flow [51]에서 영감을 받아 우리의 방법을 구축하기 위한 핵심 아이디어인 Dynamic-NeRF (줄여서 D-NeRF)는 두 개의 모듈에서 학습을 분해하는 것입니다.

첫 번째 아이디어는 시간 t에서 장면의 각 지점과 표준 장면 구성 사이의 공간 매핑 (x, y, z, t) → (Δx, Δy, Δz)를 학습합니다.

두 번째 모듈은 튜플 (x + Δx, y + Δy, z + Δz, θ, ɸ)이 주어지면 각 방향과 부피 밀도로 방출되는 장면 radiance를 회귀시킵니다.

두 매핑 모두 컨볼루션 레이어 없이 완전히 연결된 네트워크로 학습됩니다.

그런 다음 학습된 모델은 새로운 이미지를 합성할 수 있으며, 카메라 뷰 및 시간 성분의 연속체 (θ, ɸ, t) 또는 이와 동등하게 장면의 동적 상태를 제어할 수 있습니다 (그림 1 참조).

우리는 관절 운동에서 복잡한 신체 포즈를 수행하는 인간에 이르기까지 매우 다른 유형의 변형을 겪고 있는 장면에 대한 D-NeRF를 철저히 평가합니다.

우리는 학습을 표준 장면으로 분해함으로써 D-NeRF가 카메라 뷰와 시간 구성 요소를 모두 제어하면서 고품질 이미지를 렌더링할 수 있음을 보여줍니다.

부수적으로, 우리의 방법은 시변 기하학을 캡처하고 단일 관점에서만 특정 변형하에서 장면을 관찰함으로써 현저하게 얻어지는 완전한 3D 메쉬를 생성할 수도 있습니다.

2. Related work

Neural implicit representation for 3D geometry.

2D 영역에서 딥러닝의 성공은 3D 영역에 대한 관심을 증가시켰다.

그럼에도 불구하고, 딥러닝에 가장 적합한 3D 데이터 표현은 특히 비강체 기하학의 경우 미해결 문제로 남아 있습니다.

강체 기하학에 대한 표준 표현에는 포인트 클라우드 [49, 39], 복셀 [17, 56] 및 옥트리 [52, 45]가 포함됩니다.

최근 신경망을 통해 3D 데이터를 암묵적인 방식으로 표현하는 데 강한 버스트가 있습니다 [29, 36, 7, 55, 9, 11, 16].

이 접근법의 주요 아이디어는 3D 점 x의 정보(예: 점유, 표면 거리, 색상, 조도)를 신경망 f(x)의 출력으로 설명하는 것입니다.

앞에서 언급한 표현과 비교하여, 신경 암시적 표현은 낮은 메모리 풋프린트에서 연속적인 표면 재구성을 가능하게 합니다.

3D 표현을 위해 암묵적 표현 [29, 36, 7, 55]을 활용하는 첫 번째 작품은 종종 비용이 많이 들거나 야생 장면에서 구하기조차 불가능한 3D ground-truth 기하학에 대한 액세스 요건에 의해 제한되었습니다.

후속 작품은 2D supervision을 허용하는 미분 가능한 렌더링을 도입함으로써 이 요건을 완화했습니다.

예를 들어, [25]는 효율적인 image-to-field supervision을 위해 효율적인 ray 기반 필드 탐색 알고리즘을 제안했습니다.

[34, 57]은 카메라 ray로 3D 점유 필드 표면 교차점의 정확한 도함수를 계산하기 위해 암묵적 기반 방법을 도입했습니다.

[43]에서, 장면을 ray 캐스팅하고 표면 기하학을 추정하기 위해 recurrent neural network이 사용되었습니다.

이러한 기술은 unsupervised 방식으로 3D 형상을 표현할 수 있는 큰 잠재력을 가지고 있지만, 일반적으로 비교적 간단한 기하학으로 제한됩니다.

NeRF[31]는 5D radiance field를 사용하여 강체 장면을 암시적으로 표현함으로써 고해상도 기하학과 사진 현실적으로 새로운 뷰를 촬영할 수 있음을 보여주었습니다.

[28]는 이 방법을 확장하여 야생 이미지에서 다룰 가변 조명 및 일시적 폐색을 처리했습니다.

[24]에서는 복셀 경계 암시적 필드를 사용하여 훨씬 더 복잡한 3D 표면을 표현했습니다.

그리고 [58]는 다시점 카메라 보정의 요구 사항을 완화했으며, Stereo Radiance Fields [10]는 NeRF 내에 클래식 스테레오를 통합하여 NeRF를 여러 장면으로 일반화했습니다.

앞서 언급한 방법 중 어떤 것도 동적이고 변형 가능한 장면을 처리할 수 없습니다.

신경 암시적 함수는 관절형 객체 및 비강성 객체 [33, 13]로 일반화되었지만 완전한 3D ground-truth supervision이 필요합니다.

Neural volumes [26]는 암시적 복셀 워프 필드로 향상된 복셀 기반 표현을 통해 고품질 재구성 결과를 생성했지만 다중 뷰 이미지 캡처 설정이 필요합니다.

우리가 아는 한, D-NeRF는 3D ground-truth supervision이나 다중 시점 카메라 설정 없이 단안 데이터에만 학습된 비강성 및 시간 변동 장면에 대한 신경 암시적 표현을 생성할 수 있는 최초의 접근법입니다.

우리의 연구와 동시에, 다른 그룹들도 NeRF의 동적 일반화를 도입했습니다 [54: Space-time neural irradiance fields, 37: Deformable neural radiance fields, 23: Neural scene flow fields, 47: Non-rigid neural radiance fields].

Novel view synthesis.

새로운 뷰 합성은 여러 이미지에 의해 캡처된 장면의 임의의 뷰 포인트에서 새로운 이미지를 합성하는 것을 목표로 하는 오래된 비전 및 그래픽 문제입니다.

경직된 장면에 대한 대부분의 기존 접근 방식은 Structure-from-Motion [18] 및 bundle adjustment [48]를 사용하여 여러 뷰에서 장면을 재구성하는 것으로 구성되는 반면, 다른 접근 방식은 light-field based photography [22]를 제안합니다.

보다 최근에는 딥러닝 기반 기술 [42, 20, 14, 12, 30]이 희소 이미지 집합에서 신경 부피 표현을 배울 수 있습니다.

그러나 이러한 방법 중 어떤 것도 동적 장면의 새로운 뷰를 합성할 수 없습니다.

대부분의 방법은 동적 3D 텍스처링된 메시를 재구성하여 문제에 접근합니다.

단안 이미지에서 비강성 표면의 3D 재구성은 심각하게 ill-posed로 알려져 있습니다.

Structure-from-Template (SfT) 접근법 [4, 8, 32]은 참조 알려진 템플릿 구성이 주어지면 표면 기하학을 복구합니다.

시간 정보는 일반적으로 이용되는 또 다른 선행 연구입니다.

Non-rigid-Structure-from-Motion (NRSfM) 기법 [46, 2]은 시간 정보를 이용합니다.

그러나 SfT와 NRSFM은 2D-to-3D 일치 또는 2D 포인트 트랙이 필요하여 일반적인 적용 가능성을 비교적 잘 텍스처링된 표면과 가벼운 변형으로 제한합니다.

이러한 한계 중 일부는 동적 장면의 새로운 사진 현실 뷰를 합성하는 데 효과적으로 사용되는 학습 기반 기술에 의해 극복됩니다.

예를 들어, [3, 62, 19]는 동적 장면을 여러 뷰에서 동시에 순간적으로 캡처한 다음 4D 시공간 시각화를 생성합니다.

[15, 38, 61]은 또한 depth를 추정하기 위해 여러 카메라에서 장면을 동시에 캡처하여 누락된 정보가 있는 영역을 완료한 다음 뷰 합성을 수행하는 데 활용합니다.

[59]에서, 프레임당 depth를 추정하는 사전 학습된 네트워크를 사용하여 여러 뷰의 필요성을 회피합니다.

이러한 depth는 광학 흐름 및 프레임에 걸친 일관된 depth 추정과 함께 이미지 간을 보간하고 새로운 뷰를 렌더링하는 데 사용됩니다.

그럼에도 불구하고, 새로운 뷰 합성에서 depth 추정을 분리함으로써 이 접근법의 결과는 depth 맵의 품질뿐만 아니라 광학 흐름의 신뢰성에 크게 의존하게 됩니다.

매우 최근 X-Fields[5]는 서로 다른 뷰, 시간 또는 조명 조건에서 촬영된 이미지 간을 보간하기 위해 신경망을 도입했습니다.

그러나 이 접근법은 동적 장면을 처리할 수 있지만 하나 이상의 뷰가 필요합니다.

3D 표현이 학습되지 않기 때문에 뷰의 변동이 작습니다.

D-NeRF는 3D 재구성이 필요 없고, 종단 간 학습이 가능하며, 인스턴스당 단일 뷰가 필요하다는 점에서 모든 이전 연구와 다릅니다.

D-NeRF의 또 다른 매력적인 특징은 시간 가변 3D 볼륨 밀도와 방출된 radiance를 본질적으로 학습한다는 것이며, 이는 새로운 뷰 합성을 뷰 보간 대신 ray 캐스팅 프로세스로 전환하여 임의의 관점에서 이미지를 렌더링하는 데 현저하게 더 강력합니다.

3. Problem Formulation

단안 카메라로 캡처된 동적 장면의 희소한 이미지 세트를 고려하여, 우리는 임의의 시간에 장면을 암묵적으로 인코딩하고 새로운 뷰를 합성할 수 있는 딥러닝 모델을 설계하는 것을 목표로 합니다(그림 2 참조).

형식적으로, 우리의 목표는 3차원 점 x = (x, y, z)가 주어졌을 때 방출되는 색 c = (r, g, b)와 부피 밀도 σ를 시간 순간 t와 뷰 방향 d = (θ, ɸ)로 조건화하여 출력하는 매핑 M을 학습하는 것입니다.

즉, 우리는 매핑 M : (x, d, t) → (c, σ)를 추정하고자 합니다.

직관적인 해결책은 변환 M을 6D 공간 (x, d, t)에서 4D 공간 (c, σ)로 직접 학습하는 것입니다.

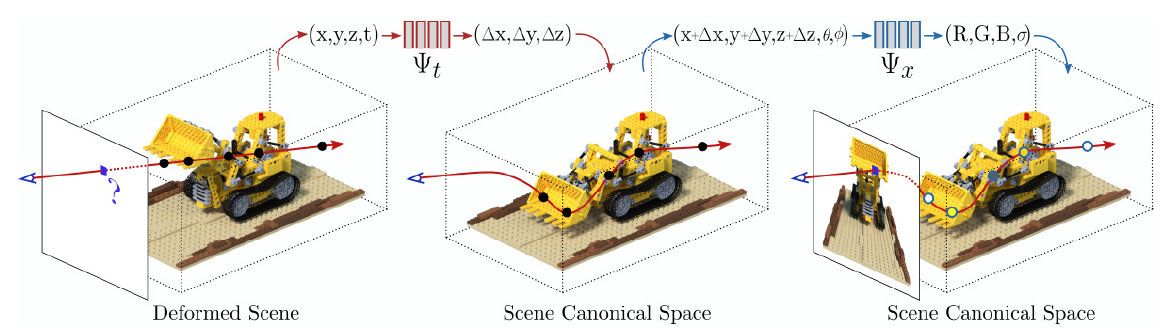

그러나 결과 섹션에서 보여줄 것처럼 매핑 M을 Ψ_x와 Ψ_t로 분할하여 지속적으로 더 나은 결과를 얻으며, 여기서 Ψ_x는 표준 구성의 장면을 나타내고 Ψ_t는 순간 t의 장면과 표준 구성의 장면 사이의 매핑을 나타냅니다.

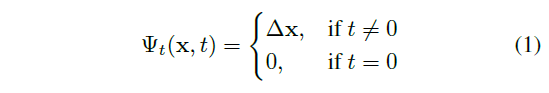

더 정확하게 말하면, 순간 t에서 점 x와 뷰 방향 d가 주어지면 먼저 점 위치를 Ψ_t : (x, t) → Δx와 같이 표준 구성으로 변환합니다.

일반성의 loss없이 표준 장면 Ψ_t : (x, 0) → 0으로 t = 0을 선택했습니다.

이렇게 함으로써 장면은 더 이상 시간 인스턴스 간에 독립적이지 않고 공통의 표준 공간 앵커를 통해 상호 연결됩니다.

그러면 뷰 방향 d 아래에서 할당된 방출된 색과 부피 밀도는 표준 구성 Ψ_x : (x + Δx, d) → (c, σ)와 같습니다.

우리는 t 시점에서 카메라 포즈 T_t ∈ R^(4×4) SE(3)에서 획득된 이미지인 단안 카메라로 캡처된 T RGB 이미지 {I_t, T_t}_(t=1)^T의 희소 집합을 사용하여 Ψ_x 및 Ψ_t를 학습할 것을 제안합니다.

시간 인스턴스당 여러 뷰를 가정할 수 있지만, 방법의 한계를 테스트하고 시간 인스턴스당 하나의 이미지를 가정하고자 합니다.

즉, 우리는 다른 관점에서 특정 구성/변형 상태의 장면을 관찰하지 않습니다.

4. Method

이제 동적 장면의 희소한 이미지 세트에서만 학습된 뷰 합성을 위한 새로운 신경 렌더링인 D-NeRF를 소개합니다.

우리는 NeRF [31]를 기반으로 구축하고 비강체 장면을 처리하기 위해 일반화합니다.

NeRF에는 강성 장면의 여러 뷰가 필요하다는 것을 기억하십시오.

대조적으로 D-NeRF는 순간당 단일 뷰로 학습된 연속적인 비강체 장면에 대한 체적 밀도 표현을 학습할 수 있습니다.

그림 3과 같이 D-NeRF는 두 개의 주요 신경망 모듈로 구성되어 있으며, 이 모듈은 이전 섹션 Ψ_t, Ψ_x에서 설명한 매핑을 매개 변수화합니다.

한편으로는 Canonical Network를 사용하여 MLP (multilayer perceptron) Ψ_x(x, d) → (c, θ)가 표준 구성의 장면을 인코딩하도록 학습되어 주어진 3D 포인트 x와 뷰 방향 d가 방출된 색상 c와 볼륨 밀도 σ를 반환합니다.

두 번째 모듈은 Deformation Network라고 하며 시간 t의 장면과 표준 구성의 장면 사이의 변환을 정의하는 변형 필드를 예측하는 또 다른 MLP Ψ_t(x, t) → Δx로 구성됩니다.

다음으로 이 블록 각각(섹션 4.1), 볼륨 렌더링을 위한 상호 연결(섹션 4.2) 및 학습 방법(섹션 4.3)을 자세히 설명합니다.

4.1. Model Architecture

Canonical Network.

표준 구성을 사용하여 우리는 모든 이미지에서 모든 해당 점의 정보를 결합하는 장면의 표현을 찾고 있습니다.

이렇게 함으로써 특정 관점에서 누락된 정보를 표준 구성에서 가져올 수 있으며, 이는 모든 이미지를 연결하는 앵커 역할을 합니다.

canonical 네트워크 Ψ_x는 표준 구성에서 장면의 부피 밀도와 색상을 인코딩하도록 학습됩니다.

구체적으로, 점의 3D 좌표 x가 주어지면, 우리는 먼저 그것을 256차원 피쳐 벡터로 인코딩합니다.

그 다음 이 피쳐 벡터는 카메라 뷰 방향 d와 연결되고 fully connected layer를 통해 전파되어 표준 공간에서 해당 점에 대해 방출된 색상 c와 부피 밀도 σ를 산출합니다.

Deformation Network.

deformation network Ψ_t는 특정 시간 순간의 장면과 표준 공간의 장면 사이의 변형 필드를 추정하도록 최적화되어 있습니다.

형식적으로 시간 t에서 3D 점 x가 주어지면 Ψ_t는 주어진 점을 표준 공간의 위치로 변환하는 변위 Δx를 x + Δx로 출력하도록 학습됩니다.

모든 실험에서 일반성의 loss 없이 표준 장면을 시간 t = 0의 장면으로 설정합니다:

이전 연구 [40, 50, 31]에서 볼 수 있듯이 신경망에 raw 좌표와 각도를 직접 공급하면 성능이 낮아집니다.

따라서 canonical network와 deformation network 모두에 대해 먼저 x, d 및 t를 더 높은 차원의 공간으로 인코딩합니다.

여기서 γ(p) = < (sin(2^l πp), cos(2^l πp) >_0^L인 [31]과 동일한 위치 인코더를 사용합니다.

우리는 독립적으로 인코더 γ(·)를 각 좌표 및 카메라 뷰 구성 요소에 적용하며, x의 경우 L = 10, d 및 t의 경우 L = 4를 사용합니다.

4.2. Volume Rendering

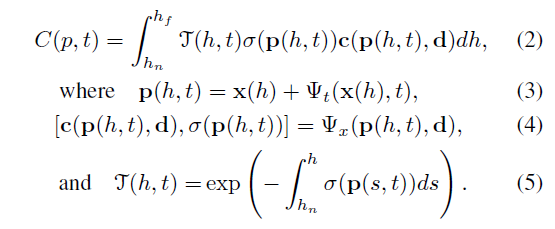

우리는 이제 제안된 6D neural radiance field에서 비강체 변형을 설명하기 위해 NeRF 볼륨 렌더링 방정식을 조정합니다.

x(h) = o + hd를 투영 중심 o에서 픽셀 p로 방출되는 카메라 ray를 따라 점이라고 가정합니다.

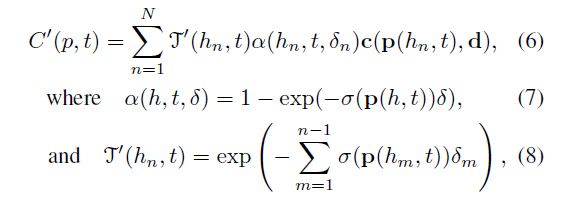

해당 ray에서 h_n과 h_f의 근거리와 원거리 경계를 고려하면, 시간 t에서 픽셀 p의 예상 색상 C는 다음과 같습니다:

3차원 점 p(h, t)는 Deformation Network Ψ_t를 사용하여 표준 공간으로 변환된 카메라 ray x(h)의 점을 나타내고, T(h, t)는 h_n에서 h_f로 방출된 ray가 다른 입자에 부딪히지 않을 누적 확률입니다.

밀도 σ와 색상 c는 Canonical Netowkr Ψ_x에 의해 예측된다는 것에 주목하십시오.

[31]에서와 같이, (2)식과 (5)식의 볼륨 렌더링 적분은 수치 직교를 통해 근사화될 수 있습니다.

임의의 직교 점 집합 {h_n}_(n=1)^N ∈ [h_n, h_f]를 선택하려면 균일하게 배열된 ray bin에서 샘플을 추출하여 계층화된 샘플링 전략을 적용합니다.

픽셀 색상은 다음과 같이 근사화됩니다:

그리고 δ_n = h_(n+1) - h_n은 두 직교 점 사이의 거리입니다.

4.3. Learning the Model

장면의 T RGB 이미지 {I_t}_(t=1)^T와 해당 카메라 포즈 행렬 {T_t}_(t=1)^T에 대한 평균 제곱 오차를 최소화하여 표준 Ψ_x 및 변형 Ψ_t 네트워크의 매개 변수를 동시에 학습합니다.

매 순간마다 단일 카메라만 획득합니다.

각 학습 배치에서 먼저 일부 카메라 위치 T_t에서 해당 RGB 이미지 t의 일부 픽셀 i로 투사되는 ray에 해당하는 임의 픽셀 집합 {p_(t,i)}_(i=1)^N_s를 샘플링합니다.

그런 다음 식 (6)을 사용하여 선택된 픽셀의 색상을 추정합니다.

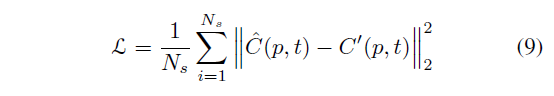

우리가 사용하는 학습 loss는 렌더링된 픽셀과 실제 픽셀 사이의 평균 제곱 오차입니다:

여기서 ^C는 픽셀의 ground-truth 색상입니다.

5. Implementation Details

canonical network Ψ_x와 deformation network Ψ_t 모두 ReLU 활성화 함수가 있는 단순한 8-layers MLP로 구성됩니다.

canonical network의 경우 c와 σ에 최종 시그모이드 비선형성이 적용됩니다.

deformation network의 Δx에는 비선형성이 적용되지 않습니다.

모든 실험에 대해 표준 구성을 식 (1)에서 시행하여 t = 0에서 장면 상태로 설정합니다.

네트워크 수렴을 개선하기 위해 입력 이미지를 타임 스탬프(낮은 이미지에서 높은 이미지로)에 따라 정렬한 다음 더 높은 타임 스탬프를 가진 이미지를 점진적으로 추가하는 커리큘럼 학습 전략을 적용합니다.

이 모델은 N_s = 4096 ray의 배치 크기를 가진 800k 반복 동안 400×400 이미지로 학습되며, 각각은 ray를 따라 64번 샘플링됩니다.

옵티마이저의 경우 학습 속도가 5e - 4, β_1 = 0.9, β_2 = 0.999이고 5e - 5로 지수 감쇠하는 Adam [21]을 사용합니다.

모델은 이틀 동안 단일 Nvidia® GTX 1080으로 학습됩니다.

6. Experiments

이 섹션에서는 시스템에 대한 철저한 평가를 제공합니다.

먼저 모델의 주요 구성 요소, 즉 canonical 및 deformation network를 테스트합니다(섹션 6.1).

그런 다음 D-NeRF를 NeRF 및 표준 매핑을 사용하지 않는 변형인 T-NeRF와 비교합니다(섹션 6.2).

마지막으로 여러 복잡한 동적 장면에서 임의의 시간에 새로운 뷰를 합성할 수 있는 D-NeRF 능력을 보여줍니다(섹션 6.3).

철저한 평가를 수행하기 위해 우리는 큰 변형 하에서 동적 객체와 현실적인 비 램버트 재료를 포함하는 8개의 장면으로 NeRF [31] 강성 벤치마크를 확장했습니다.

[31]의 강성 벤치마크에서와 같이 6개는 상반구에서 샘플링된 시점에서 렌더링되고 2개는 전체 구에서 샘플링된 시점에서 렌더링됩니다.

각 장면에는 액션 시간 범위에 따라 100에서 200개 사이의 렌더링된 뷰가 포함되며 모두 800 × 800 픽셀입니다.

이 8개의 장면에 대해 정의된 학습/유효성 검사/테스트 분할이 있는 경로 추적 이미지를 릴리스합니다.

6.1. Dissecting the Model

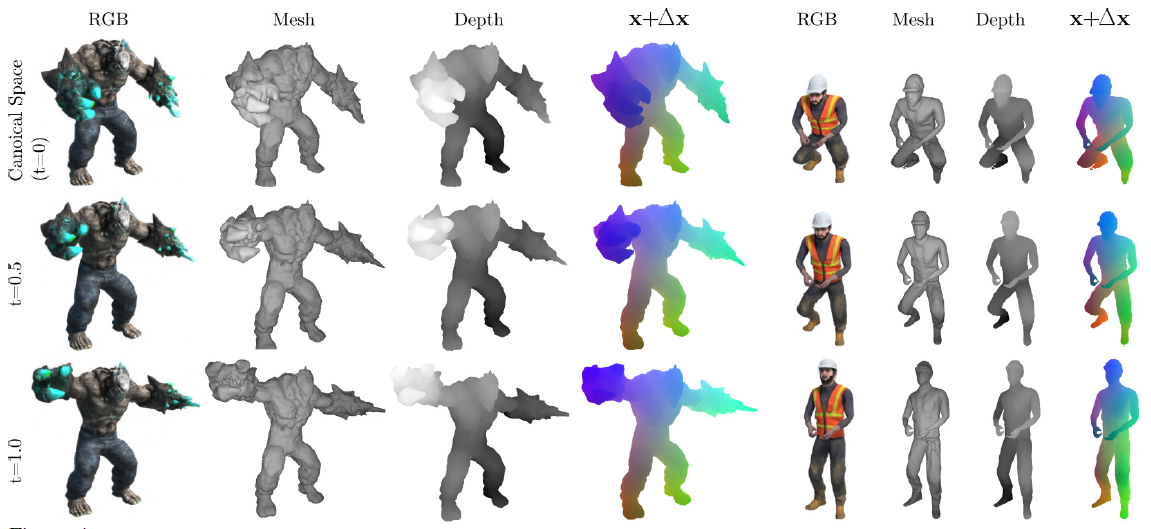

이 하위 섹션에서는 동적 장면을 모델링하고 canonical 및 deformation network라는 두 가지 주요 모듈을 분석할 때의 D-NeRF 동작에 대한 통찰력을 제공합니다.

우리는 처음에 표준 구성으로 장면을 표현하는 canonical network의 능력을 평가합니다.

두 장면에 대한 이 분석 결과는 그림 4의 첫 번째 행(각 경우 1-3열)과 같습니다.

그림은 표준 구성(t = 0)에 대해 RGB 이미지, 3D 점유 네트워크 및 depth 맵을 각각 보여줍니다.

렌더링된 RGB 이미지는 식 (6)을 적용하여 임의의 카메라 위치에서 캐스팅된 ray에 대한 canonical network를 평가한 결과입니다.

학습된 부피 밀도를 더 잘 시각화하기 위해 256^3복셀의 3D 큐브 해상도를 가진 마칭 큐브 [27]를 적용하는 메쉬로 변환합니다.

D-NeRF가 각각 다른 변형 하에서 희소 이미지 세트로만 학습되었을 때도 복잡한 토폴로지 및 텍스처 패턴에 대한 미세한 기하학적 및 외관 세부 사항을 모델링할 수 있는 방법에 주목하십시오.

두 번째 실험에서 우리는 표준 장면을 각 입력 이미지에서 특정 모양에 매핑하는 일관된 변형 필드를 추정하기 위해 네트워크의 용량을 평가합니다.

그림 4의 두 번째와 세 번째 행은 t = 0.5 및 t = 1에 대한 표준 공간에 해당하는 변환 벡터를 적용한 결과를 보여줍니다.

두 예의 네 번째 열은 표준 모양(t = 0)의 색상으로 코딩된 점이 t = 0.5 및 t = 1의 서로 다른 모양 구성에 매핑된 변위 필드를 시각화합니다.

시간에 따른 색상 일치성을 평가하여 변위 필드가 올바르게 추정되었음을 나타냅니다.

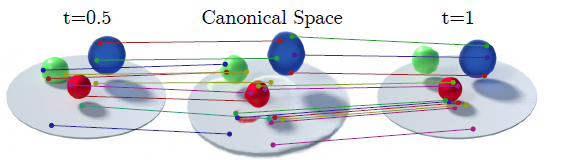

우리가 답하려고 하는 또 다른 질문은 D-NeRF가 그림자/음영 효과와 같은 현상을 어떻게 모델링하는지, 즉, 모델이 동일한 점의 외관 변화를 어떻게 인코딩할 수 있는지입니다.

우리는 이에 답하기 위해 추가적인 실험을 수행했습니다.

그림 5에서 우리는 매우 다른 물질(플라스틱 – 녹색 –, 반투명 유리 – 청색 – 및 금속 – 적색 –)로 만들어진 세 개의 공이 있는 장면을 보여줍니다.

그림은 특정 시간 순간에 표준 구성과 장면 사이의 대응하는 점의 쌍을 표시합니다.

D-NeRF는 표준 구성을 왜곡하여 음영 효과를 합성할 수 있습니다.

예를 들어, 바닥 그림자가 시간에 따라 어떻게 왜곡되는지 관찰하십시오.

빨간색 공의 그림자에 있는 점은 표준 공간의 서로 다른 영역에서 t = 0.5 및 t = 1 맵입니다.

6.2. Quantitative Comparison

다음으로 새로운 뷰 합성 문제에 대한 D-NeRF의 품질을 평가하고 D-NeRF의 중간 표준 구성을 고려하지 않고 5D 입력(x, y, z, θ, ɸ)을 사용하여 장면을 나타내는 원래 NeRF [31] 및 장면을 6D 입력(x, y, z, θ, ɸ, t)으로 나타내는 NeRF의 간단한 확장인 T-NeRF와 비교합니다.

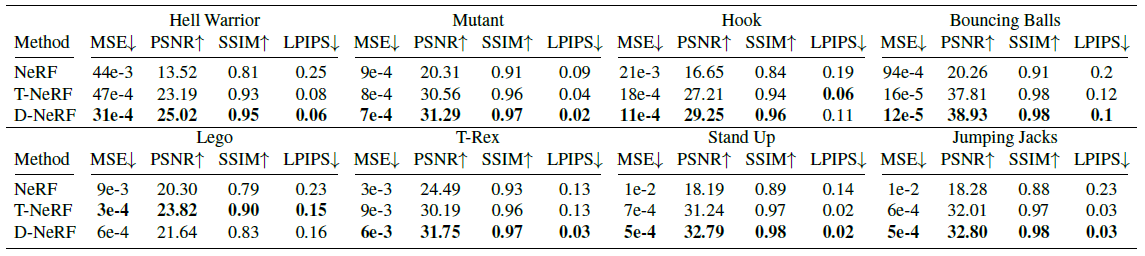

표 1은 데이터 세트의 8가지 동적 장면에 대한 정량적 결과를 요약합니다.

평가를 위해 여러 메트릭을 사용합니다: Mean Squared Error (MSE), Peak Signal-toNoise Ratio (PSNR), Structural Similarity (SSIM) [53] and Learned Perceptual Image Patch Similarity (LPIPS) [60].

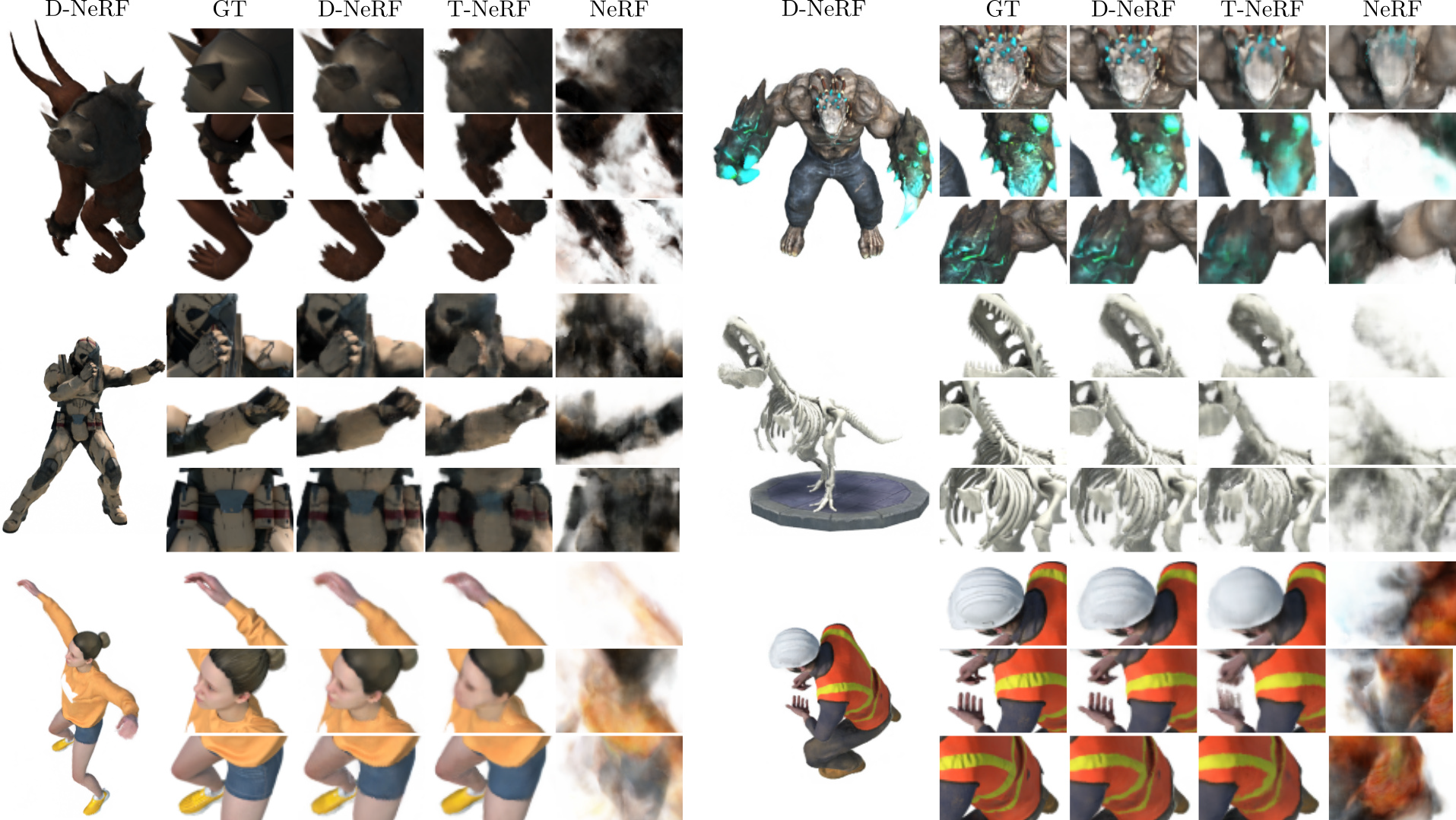

그림 6에서 우리는 시각적 검사를 위해 새로운 뷰 아래에 추정된 이미지의 샘플을 보여줍니다.

예상대로 NeRF는 강성 사례를 위해 설계된 것처럼 역학 장면을 모델링할 수 없으며 항상 모든 변형의 블러 평균 표현으로 수렴합니다.

반면 T-NeRF 베이스라인은 고주파 세부 정보를 검색할 수는 없지만 역학을 상당히 잘 포착할 수 있습니다.

예를 들어, 그림 6의 왼쪽 위 이미지에서는 숄더 패드 스파이크를 인코딩하지 못하고 오른쪽 위 장면에서는 돌과 균열을 모델링할 수 없습니다.

대신 D-NeRF는 새로운 뷰에서 원래 이미지의 높은 세부 정보를 유지합니다.

이는 각 변형 상태가 단일 관점에서만 나타났다는 것을 고려하면 상당히 주목할 만한 것입니다.

6.3. Additional Results

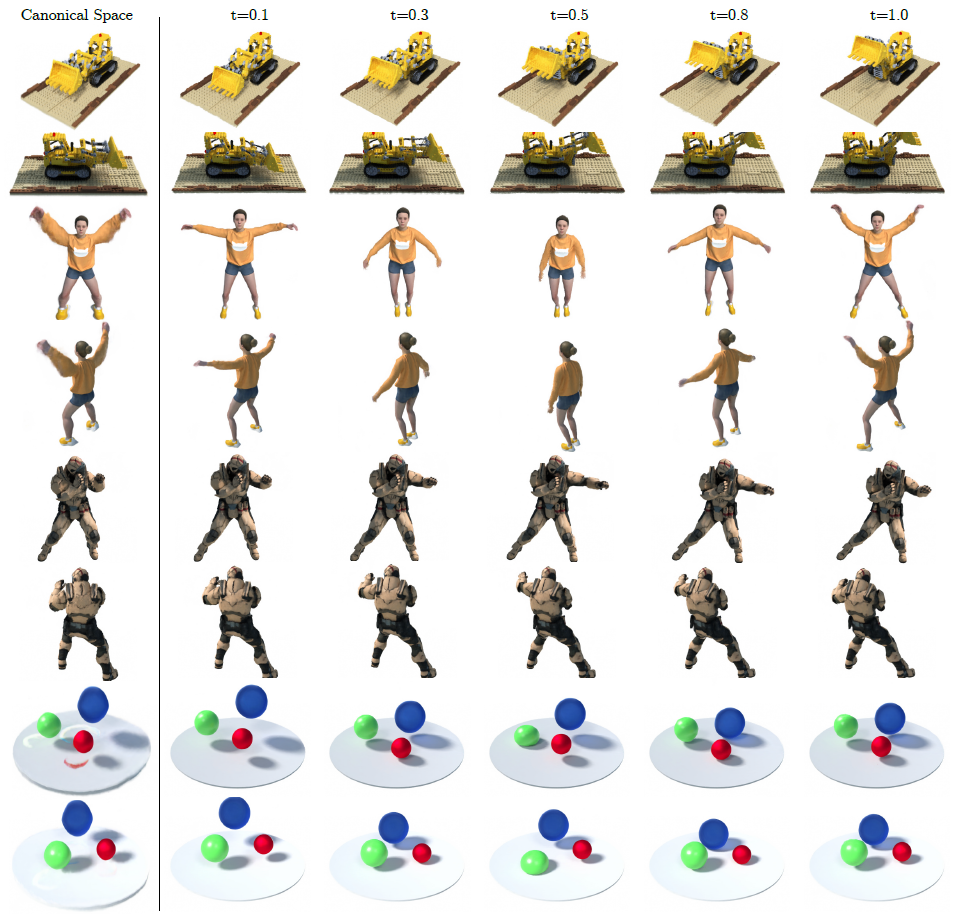

마지막으로 D-NeRF로 처리할 수 있는 광범위한 시나리오를 보여주기 위해 추가 결과를 보여줍니다(그림 7).

첫 번째 열에는 표준 구성이 표시됩니다.

몇 가지 유형의 역학을 처리할 수 있습니다: Tractor 장면의 아티큘레이티드 모션, Jumping Jacks 및 Warrior 장면의 인간 모션, 그리고 여러 개의 Bouncing Balls의 비동기식 모션.

또한 표준 구성은 모든 경우에 샤프하고 깔끔한 장면이며, 두 팔이 블러하게 보이는 점핑 잭스를 기대합니다.

그러나 이는 렌더링된 이미지의 품질을 해치지 않으며, 네트워크가 렌더링 품질을 최대화하기 위해 표준 구성을 왜곡할 수 있음을 나타냅니다.

이는 실제로 네트워크가 쉐이딩을 인코딩할 수 있는 방법에 대한 섹션 6.1 통찰력과 일치합니다.

D-NeRF에는 두 가지 주요 고장 사례가 있습니다:

(i) 카메라 포즈가 불량합니다 (NeRF에서와 마찬가지).

(ii) 시간적으로 연속된 입력 이미지들 사이의 큰 변형은 모델이 일관된 변형 필드로 수렴하는 것을 방지하며, 이는 캡처 프레임 레이트를 증가시킴으로써 해결될 수 있습니다.

7. Conclusion

우리는 동적 장면을 모델링하기 위한 새로운 neural radiance field 접근법인 D-NeRF를 제시했습니다.

우리의 방법은 움직이는 카메라로 획득한 희소한 이미지 세트에서만 종단 간 학습이 가능하며, 사전 계산된 3D priors나 다른 관점에서 동일한 장면 구성을 관찰할 필요가 없습니다.

D-NeRF 뒤의 주요 아이디어는 두 개의 모듈로 시간 변동 변형을 나타내는 것입니다: 표준 구성을 학습하는 것과 표준 공간에 대해 매 순간 장면의 변위 필드를 학습하는 것.

철저한 평가는 D-NeRF가 관절형 물체에서 복잡한 신체 자세를 수행하는 인체에 이르기까지 다양한 유형의 변형을 겪는 장면의 고품질의 새로운 뷰를 합성할 수 있음을 보여줍니다.

'View Synthesis' 카테고리의 다른 글

| 3D Gaussian Splatting for Real-Time Radiance Field Rendering (0) | 2023.10.29 |

|---|---|

| Instruct-NeRF2NeRF: Editing 3D Scenes with Instructions (0) | 2023.09.29 |

| Instant Neural Graphics Primitives with a Multiresolution Hash Encoding (0) | 2023.08.16 |

| DynIBaR: Neural Dynamic Image-Based Rendering (0) | 2023.07.13 |

| MEIL-NeRF: Memory-Efficient Incremental Learning of Neural Radiance Fields (0) | 2023.06.05 |