2024. 8. 5. 11:04ㆍtext-to-3D

SF3D: Stable Fast 3D Mesh Reconstruction with UV-unwrapping and Illumination Disentanglement

Mark Boss, Zixuan Huang, Aaryaman Vasishta, Varun Jampani

Abstract

저희는 단일 이미지에서 0.5초 만에 빠르고 고품질의 텍스처 객체 메쉬 재구성을 위한 새로운 방법인 SF3D를 소개합니다.

대부분의 기존 접근 방식과 달리 SF3D는 메쉬 생성을 위해 명시적으로 학습되어 정점 색상에 의존하지 않고 빠른 텍스처 생성을 가능하게 하는 빠른 UV 언랩 기술을 통합합니다.

이 방법은 재구성된 3D 메쉬의 시각적 품질을 향상시키기 위해 재료 매개변수와 노멀 맵을 예측하는 방법도 학습합니다.

또한 SF3D는 delighting 단계를 통합하여 저주파 조명 효과를 효과적으로 제거하여 재구성된 메쉬를 새로운 조명 조건에서 쉽게 사용할 수 있도록 합니다.

실험은 기존 기술에 비해 SF3D의 우수한 성능을 보여줍니다.

1. Introduction

고품질 객체 메시는 영화, 게임, 전자 상거래 및 AR/VR의 다양한 사용 사례에 필수적입니다.

이 작업에서는 단일 이미지에서 고품질 3D 객체 메시를 생성하는 문제를 다룹니다.

이는 해당 객체의 단일 2D 투영(이미지)에서만 객체의 3D 모양과 텍스쳐에 대한 추론이 필요하기 때문에 ill-posed, 어려운 문제입니다.

단일 이미지 객체 생성을 통해 지루하고 수동적인 객체 생성 프로세스를 단순화할 수 있습니다.

지난 몇 년 동안 트랜스포머 모델 [18, 20, 54], 대규모 합성 데이터 세트 [11] 및 3D 인식 이미지/비디오 생성 모델 [31, 51, 57, 67]의 발전으로 단일 이미지에서 객체 메시 생성의 품질이 크게 향상되었습니다.

특히 트랜스포머 기반 재구성 모델 [18, 20, 54]은 합성 데이터 세트에서만 학습되었음에도 불구하고 실제 이미지에서 경이로운 일반화 기능을 보여줌과 동시에 단일 이미지에서 1초 이내에 3D 자산을 생성합니다.

이러한 빠른 진전에도 불구하고 이러한 피드포워드 빠른 3D 재구성 모델에는 몇 가지 문제가 남아 있습니다 [18, 20, 54].

이러한 기술은 종종 다운스트림 애플리케이션에 사용할 수 없거나 힘든 수동 사후 처리가 필요한 3D 자산을 생성합니다.

저희는 이러한 기술의 몇 가지 주요 문제를 식별하고 단일 이미지에서 더 높은 품질과 더 사용 가능한 3D 자산을 생성하는 동시에 H100 GPU에서 0.5초 이내에 빠른 생성 속도를 유지하는 'Stable Fast 3D' (SF3D)라는 빠른 생성 기술을 제안합니다.

다음으로 이러한 문제와 SF3D에서 이러한 문제를 해결하는 방법을 간략하게 소개합니다.

Light Bake-in.

주어진 입력 이미지에 그림자 또는 다른 조명 효과를 갖는 것이 일반적입니다.

대부분의 기존 작업은 이러한 효과를 텍스처로 베이킹하여 결과적인 3D 자산을 덜 사용할 수 있게 만듭니다.

일관된 조명을 갖는 것은 그래픽 파이프라인에 쉽게 통합하는 데 도움이 됩니다.

SF3D에서는 Spherical Gaussians (SG)을 사용하여 명시적인 조명과 미분 가능한 음영 모델을 통합하여 조명 및 반사 특성을 분해할 것을 제안합니다.

그림 2(위 행)는 SF3D의 샘플 결과를 보여주며, 여기서 라이트 베이크인은 종래 기술에 비해 상당히 감소합니다.

Vertex Coloring.

대부분의 3D 생성 모델에서 발견한 또 다른 문제는 객체 텍스처를 표현하기 위해 정점 색칠을 사용하여 높은 정점 수를 가진 메시를 생성한다는 것입니다.

이로 인해 결과적인 3D 자산을 게임과 같은 응용 프로그램에서 사용하기에 비효율적입니다.

핵심 문제는 UV 언래핑의 추가 처리 시간으로 전체 객체 생성보다 오래 걸릴 수 있다는 것입니다.

예를 들어 xatlas [72] 및 geogram [27]은 단일 자산에 대해 각각 최대 30초 또는 10초가 걸릴 수 있습니다.

이를 해결하기 위해 0.5초 생성 시간을 달성하기 위해 병렬화 가능한 고속 상자 투영 기반 UV 언래핑 기술을 제안합니다.

정점 색칠 vs. UV 언래핑에 의존하는 효과는 그림 2(가운데 행)에서 볼 수 있으며, 여기서 TripoSR은 10배 더 높은 다각형 수를 요구함에도 불구하고 SF3D보다 적은 세부 정보를 캡처합니다.

Marching Cubes Aritfacts.

피드포워드 네트워크는 종종 Marching Cubes (MC) [35] 알고리즘을 사용하여 메시로 변환되는 Triplane-NeRF [9]와 같은 볼륨 표현을 생성합니다.

MC는 'stairstepping’ 아티팩트를 유발할 수 있으며, 이는 볼륨 해상도를 높임으로써 다소 감소할 수 있습니다.

그러나 이는 큰 계산 오버헤드를 초래합니다.

이와 대조적으로, SF3D는 고해상도 트리플레인을 위해 보다 효율적인 아키텍처를 사용하고 학습된 정점 변위 및 노멀 맵을 사용하여 DMTet [46]을 사용하여 메시를 생성하여 더 부드러운 메시 표면을 생성합니다.

그림 2는 TripoSR과 비교하여 SF3D 메시의 부드러움을 보여줍니다.

Lack of Material Properties.

이전 피드포워드 기술의 세대는 다른 조명을 사용하여 렌더링할 때 종종 지루해 보입니다.

이는 주로 광 반사에 영향을 미칠 수 있는 출력 생성에 명시적인 재료 특성이 없기 때문입니다.

이를 해결하기 위해 공간적으로 변화하지 않는 재료 특성을 예측합니다.

이 추가는 그림 2(아래 행)에서 서로 다른 생성된 객체를 렌더링할 때 분명합니다.

이러한 발전으로 SF3D는 형상(낮은 다각형이지만 매끄러운)과 텍스처(재료 특성이 있는 조명 분리 UV 맵) 모두에서 다운스트림 애플리케이션에 몇 가지 바람직한 특성을 가진 단일 이미지에서 고품질의 3D 메쉬를 생성할 수 있습니다.

3D 자산은 크기가 작으며(1MB 미만) 0.5초 만에 생성할 수 있습니다.

text-to-3D 메쉬 생성을 위해 빠른 Text-to-Image (T2I) 모델 [45]을 SF3D와 결합하여 약 1초 만에 메쉬를 생성할 수 있습니다.

실험 결과는 기존 작업에 비해 SF3D로 더 높은 품질의 결과를 보여줍니다.

간단히 말해, SF3D는 단일 이미지에서 빠르고 고품질의 3D 객체 생성을 위한 포괄적인 기술을 제공하여 실제 애플리케이션에서 속도와 사용성을 모두 해결합니다.

2. Related Work

3D Reconstruction using Image Generation Priors.

디퓨전 모델 [19, 50]은 다양한 작업 [2, 3, 15, 43, 44, 56]에 대한 강력한 생성 모델임이 입증되었습니다.

Zero123 [31] 및 다른 작업 [11, 25, 51, 80]과 같은 여러 작업은 3D 생성을 위해 생성 모델을 적용함으로써 이러한 디퓨전 모델에서 객체 priors를 활용합니다.

Score Distillation Sampling (SDS) [41]은 2D 디퓨전 모델을 사용하여 3D 표현을 최적화하는 데 자주 사용됩니다.

그러나 이미지 prior에만 의존한다고 해서 항상 일관된 멀티뷰 결과가 생성되는 것은 아닙니다.

이 문제는 후속 작업 [32, 37, 47, 49]에서 객체의 여러 뷰를 동시에 생성하여 개선되었습니다.

또 다른 접근 방식은 3D 인식을 명시적으로 도입하거나 멀티뷰 디퓨전 프로세스 [2, 14, 26, 33, 34, 36, 49, 57, 62, 79]를 사용하여 3D 객체를 생성하는 것입니다.

디퓨전 모델은 비디오 또는 멀티뷰 이미지를 비교적 빠르게 생성할 수 있지만 단일 이미지에서 3D 메시를 생성하려면 3D 재구성 단계가 필요합니다.

빠른 기술을 사용하더라도 객체를 생성하는 데 몇 분이 걸릴 수 있습니다.

저희의 작업은 image-to-3D의 경우 0.5초 내에 빠른 생성 속도에 초점을 맞춥니다.

Feed-Forward 3D Reconstruction.

최근 LRM [20]과 후속 작업 [18, 54]은 대규모 합성 데이터 세트에서 학습된 피드포워드 네트워크를 사용하여 빠르고 안정적인 3D 생성이 가능하다는 것을 입증했습니다.

이러한 작업은 대규모 트랜스포머 모델을 사용하여 볼륨 표현으로 트리플레인을 직접 예측하는 데 사용되며, NeRF [38]를 사용하여 레이 마칭할 수 있습니다.

이를 통해 학습에는 렌더링 loss만 필요하기 때문에 이러한 모델을 멀티뷰 데이터 세트에서 학습할 수 있습니다.

일련의 후속 작업은 멀티뷰 데이터 세트에 대한 의존성을 해결하기 위한 것입니다 [23, 58, 65].

이를 통해 생성-prior 기반 접근 방식에 비해 몇 초 만에 이미지에서 메시를 생성할 수 있습니다.

Gaussian Splatting [24]을 표현으로 사용하거나 메시 예측 [60, 63, 66, 68, 73, 81]을 직접 통합하는 여러 후속 작업이 등장했습니다.

또 다른 방법 그룹은 triplanes [59]를 직접 생성하거나, LRM을 denoiser [69]로 사용하거나, 조건화 [61]로 사용하여 디퓨전 모델을 피드포워드 모델과 통합합니다.

단일 이미지 재구성이 어려운 작업이기 때문에 여러 모델이 멀티뷰 디퓨전 모델의 광범위한 prior를 활용하여 객체의 여러 뷰를 생성한 다음 피드포워드 모델이 사용하여 3D 출력 [28, 53, 60, 63, 66, 68, 70, 73, 76, 81]을 생성합니다.

일반적으로 이러한 모델은 장면의 광채를 학습하여 조명 정보가 객체에 구워지는 것을 의미합니다.

LDM [66]은 음영 정보를 캡처하기 위해 추가 음영 색상을 학습하여 이를 해결하려고 합니다.

그러나 학습을 위해서는 supervision 신호로 ground truth 알베도 색상에 액세스해야 합니다.

LDM과 비교하여 저희의 방법은 조명 모델도 학습하여 일반 멀티뷰 데이터 세트에 대한 학습을 가능하게 하고 더 많은 재료 특성을 예측합니다.

저희는 또한 빠른 UV 언랩핑을 처리하기 때문에 이전 작업과 달리 3D 생성 시간을 짧게 유지하면서 정점 색상에 의존할 필요가 없습니다.

Material Decomposition.

물체의 광도만 예측하면 재조명이 설득력 있는 결과를 얻지 못한다는 단점이 있습니다.

단일 장면 최적화의 현재 작업은 종종 NeRF [38] 또는 Gaussian Splatting [24]을 기반으로 하며 여러 입력 이미지(> 50)를 빛과 재료로 분해합니다 [4–6, 13, 17, 39, 75].

이러한 방법은 종종 Physically Based Rendering (PBR) [7] 음영 모델의 재료 특성을 예측합니다.

UniDream [33] 또는 Fantasia3D [10]과 같은 최근 작업은 SDS loss를 사용하여 재료 특성을 최적화하여 공동 3D 모양 및 재료 생성을 다룹니다.

그러나 이 최적화는 수렴하는 데 몇 시간이 걸립니다.

또 다른 작업 세트는 디퓨전 모델을 사용하여 기존 객체 [55, 78]를 텍스처링하는 것을 목표로 합니다.

저희 작업은 빠른 생성 속도로 자연 조명을 받는 단일 이미지에서 균일한 재료 특성을 가진 텍스처링된 객체를 생성합니다.

3. Method

저희는 단일 객체 이미지를 de-lit 알베도와 재료 특성을 가진 텍스처링되고 UV로 포장되지 않은 3D 모델로 변환하는 SF3D를 제안합니다.

서론 부분에서 설명했듯이 SF3D를 사용하여 그림 2에 나타난 문제를 해결하고 추가적인 품질 향상을 도입하는 것을 목표로 합니다.

Preliminaries.

저희의 방법은 단일 이미지에서 Triplane [9] 기반 3D 표현을 출력하는 대규모 트랜스포머 기반 네트워크를 학습하는 TripoSR [20, 54]을 기반으로 합니다.

TripoSR은 명시적인 3D supervision 없이 멀티뷰 이미지 데이터 세트로 학습됩니다.

TripoSR에서 이미지는 DINO [8]을 사용하여 인코딩되고 트랜스포머 네트워크를 통과하여 64 × 64 해상도로 3D 트라이플레인을 생성합니다.

그런 다음 트라이플레인 피쳐는 RGB 색상으로 디코딩되고 학습을 위해 표준 NeRF [38] 렌더링을 사용하여 여러 뷰로 렌더링됩니다.

TripoSR은 뷰 독립적인 색상만 학습하고 반사 개체를 모델링할 수 없습니다.

TripoSR (및 다른 유사한 네트워크)의 몇 가지 문제가 서론에서 설명됩니다 (그림 2).

SF3D Overview.

SF3D를 사용하면 다양한 측면에서 출력 품질을 향상시키기 위해 TripoSR [54]에 대한 몇 가지 개선 사항을 제안합니다.

그림 3과 같이 SF3D는 5가지 주요 구성 요소를 가지고 있습니다:

1. 앨리어싱 아티팩트를 줄이는 데 도움이 되는 고해상도 트라이플레인을 예측하는 향상된 트랜스포머 네트워크(그림 왼쪽 상단);

2. 재료 추정 네트워크(왼쪽 아래)는 재료 특성을 예측하여 물체의 반사 특성을 처리하는 데 도움이 됩니다.

3. 그림자 없이 균일한 물체를 출력하는 데 도움이 되는 조명 분리 문제를 해결하기 위한 조명 예측(오른쪽 아래);

4. 더 적은 메쉬 추출 아티팩트로 더 부드러운 출력 모양을 만드는 데 도움이 되는 정점 오프셋 및 표면 노멀 (오른쪽 상단) 예측을 통한 메쉬 추출 및 개선;

그리고 5. 저폴리 메시 및 고해상도 텍스처를 생성하는 데 도움이 되는 빠른 UV 언래핑 및 내보내기 모듈(오른쪽)입니다.

다음으로 이러한 각 모듈에 대해 자세히 설명합니다.

3.1. Enhanced Transformer

먼저, 그림 3에 표시된 바와 같이, 저희는 트랜스포머에 사용되는 DINO [8]에서 개선된 DINOv2 [40] 네트워크로 전환하여 트랜스포머에 대한 이미지 토큰을 얻었습니다.

저희는 TripoSR 및 기타 네트워크 [18, 20]에서 사용되는 저해상도 (64x64) 트라이플레인이 특히 고주파 및 고대조 텍스처 패턴을 가진 시나리오에서 눈에 띄는 아티팩트를 도입하는 것을 관찰했습니다.

그림 4(중간)는 이러한 앨리어싱 아티팩트를 보여줍니다.

트라이플레인 해상도는 이러한 아티팩트의 존재와 직접적인 상관관계가 있으며, 이는 해상도를 증가시켜 완화할 수 있는 앨리어싱 문제로 식별됩니다.

증가된 용량은 또한 지오메트리를 개선합니다.

나이브하게 트라이플레인 해상도를 증가시키면 트랜스포머 복잡성이 2차적으로 증가합니다.

저희는 최근 PointInfinity [22] 작업에서 영감을 얻어 고해상도 트라이플레인을 출력하는 향상된 트랜스포머 네트워크를 제안합니다.

PointInfinity는 더 높은 해상도의 트라이플레인 토큰에 대한 셀프 어텐션을 피함으로써 복잡성이 입력 크기와 관련하여 선형으로 유지되는 아키텍처를 제안합니다.

이를 추가하여 저희는 1024개 채널로 96 × 96 해상도의 트라이플레인을 생성합니다.

저희는 출력 피쳐를 차원에 걸쳐 셔플링하여 트라이플레인 해상도를 더욱 높였고, 그 결과 384 × 384 해상도의 40 채널 피쳐를 생성했습니다.

아키텍처에 대한 자세한 내용은 부록에서 확인할 수 있습니다.

그림 4(오른쪽)는 더 높은 해상도의 트라이플레인으로 더 적은 앨리어싱 아티팩트를 보여줍니다.

3.2. Material Estimation

반사 물체의 출력 메시 외관을 향상시키기 위해 SF3D는 금속 및 거칠기 매개변수의 재료 특성도 출력합니다.

이상적으로는 3D 출력 위치에서 공간적으로 변하는 재료 특성을 추정하고 싶지만, 이는 본질적으로 어렵고 ill-posed 학습 문제로 공간적으로 변하는 재료를 가진 고품질 3D 데이터가 많이 필요합니다.

이러한 문제를 극복하기 위해 전체 물체에 대한 단일 금속 및 거칠기 값을 추정하여 재료 추정 문제를 단순화할 것을 제안합니다.

공간적으로 변하지 않는 이 재료는 주로 homogeneous 물체에 적용되지만 메시 예측의 시각적 품질을 크게 향상시킨다는 것을 발견했습니다.

특히 그림 3에 나와 있듯이 입력 이미지에서 금속 및 거칠기 값을 예측하는 'Materal Net'을 제안합니다.

Material Net 사전 학습을 위해 합성 학습 데이터 세트에서 PBR 재료 특성을 가진 3D 물체의 하위 집합을 선택하고 다양한 조명과 관점에서 렌더링했습니다.

재료 값을 직접 회귀하면 네트워크가 항상 0.5의 거칠기 값과 0의 금속 값을 예측하는 학습 붕괴로 이어지는 경우가 많다는 것을 관찰했습니다.

해결책으로 베타 분포의 매개 변수를 예측하고 학습 중 log-likelihood를 최소화하는 확률적 예측 접근 방식을 제안합니다.

이는 모호한 재료 추정 작업의 불확실성을 허용하여 학습을 안정화하고 직접 회귀로 관찰된 붕괴를 방지합니다.

SF3D의 추론 및 학습 중에는 분포를 샘플링하지 않고 분포의 모드를 계산합니다.

우리는 먼저 이미지를 frozen CLIP image encoder [42]에 통과시켜 의미론적으로 의미 있는 잠재를 추출하고 3개의 히든 레이어와 512개의 너비를 가진 2개의 개별 MLP에 통과시켜 분포에 대한 매개변수를 출력함으로써 Material Net을 구현합니다.

3.3. Illumination Modeling

우리는 다양한 셰이딩(예: 그림자)을 설명하기 위해 입력 이미지의 조명을 명시적으로 추정할 것을 제안합니다.

그렇지 않으면 3D 출력은 그림 2에 표시된 것처럼 RGB 색상에 베이킹 인 조명 효과가 있을 것입니다.

이를 위해 추정된 삼중 평면에서 spherical Gaussian (SG) 조명 맵을 예측하는 Light Net (그림 3 오른쪽 하단)을 제안합니다.

여기서의 근거는 삼중 평면이 입력 객체의 전역 구조와 모양을 인코딩하며 객체 표면의 3D 공간 관계와 조명 변화를 고려해야 한다는 것입니다.

우리는 트랜스포머의 96 × 96 해상도 삼중 평면을 사용하여 2개의 CNN 레이어에 통과시킨 다음, 3개의 히든 레이어와 모든 레이어에 대한 피쳐 차원 512로 맥스 풀과 최종 MLP를 제공합니다.

Light Net은 양의 값을 보장하기 위해 소프트플러스 활성화를 통해 24개 SG에 대한 그레이스케일 진폭 값을 출력합니다.

이러한 SG의 축과 선명도 값은 고정된 상태로 유지되며 전체 구를 덮도록 설정됩니다.

이러한 진폭 값을 통해 NeRD [4]에서 사용된 것과 유사한 지연된 물리적 기반 렌더링 접근 방식을 구현할 수 있습니다.

우리의 방법은 또한 Hasselgren et al. [17]와 Voleti et al. [57]의 연구에서 영감을 받아 학습 단계에서 조명 복조 loss L_Demod를 통합합니다.

이 loss 함수는 완전히 흰색 알베도를 가진 물체의 조명이 입력 이미지의 밝기와 거의 일치하도록 보장합니다.

복조 loss는 학습된 조명과 학습 데이터에서 관찰된 조명 조건 간의 일관성을 강화합니다.

이는 외관과 음영 사이의 모호성을 해결하기 위한 편향으로 볼 수 있습니다 [1].

3.4. Mesh Extraction and Refinement

그림 3 (오른쪽 상단)은 이 모듈을 보여줍니다.

우리는 미분 가능한 Marching Tetrahedron (DMTet) [46] 기법을 사용하여 추정된 삼중면을 메시로 변환합니다.

introduction (그림 2)에서 설명한 바와 같이 Marching Cubes (MC)는 일반적으로 결과 메시에 여러 계단 아티팩트를 생성합니다.

우리는 해결책으로 메시를 개선하기 위해 두 개의 새로운 MLP 헤드를 제안합니다.

하나는 정점 오프셋 v_o ∈ R^3을 예측하고, 다른 하나는 세계 공간 정점 normals ^n ∈ R^3을 예측합니다.

MeshLRM [60]에서 영감을 받아 이 두 네트워크에 소형 분할 디코더 MLP도 구현하여 성능과 효율성에 도움이 되는 것으로 입증되었습니다.

우리는 정점 오프셋이 사면체 격자의 아티팩트를 줄일 수 있고 세계 공간 normal이 평평한 메시 삼각형에 세부 사항을 추가할 수 있다는 것을 발견했습니다.

normal 예측이 처음에는 신뢰할 수 없다는 점을 감안하여 기하학 normal n ∈ R^3과 예측 사이의 구형 선형 보간(slerp)을 사용하여 학습을 안정화합니다.

이 slerp는 초기 5K 학습 단계에서 사용됩니다.

메시 추정을 정규화하기 위해 몇 가지 학습 loss를 사용합니다: normal consistency loss L_(Nrm consistency), threestudio [16]에서 구현한 Laplacian smoothness loss L_Laplacian, 정점 오프셋 regularization L_Offset = v_o^2입니다.

정규 예측을 supervising하기 위해 기하학적 normal replication loss L_(Nrm repl) = 1 - n · ˆn을 사용하며, 여기서 · 는 도트 곱과 normal smoothness loss로 3D에서 normal 예측의 평활성을 보장합니다.

이 loss는 쿼리 위치 x ∈ R^3 주위에 작은 오프셋 ϵ ∈ R^3을 추가함으로써 달성됩니다.

그런 다음 loss는 L_(Nrm smooth) = (ˆn(x)) - ˆn(x + ϵ))^2로 정의됩니다.

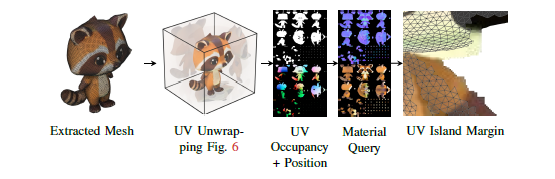

3.5. Fast UV-Unwrapping and Export

SF3D의 마지막 단계는 해당 UV atlas와 함께 최종 3D 메시를 출력하는 export 파이프라인입니다.

우리의 export 파이프라인은 3D 모델을 효율적이고 효과적으로 처리하기 위해 여러 단계를 따릅니다.

이러한 단계에 대한 개요는 먼저 빠른 UV-unwrapping을 수행하는 그림 5에 나와 있습니다.

그런 다음 알베도 및 일반 쿼리에 사용되는 UV atlas의 세계 위치와 점유율을 구웁니다.

그 결과 최종 텍스처링된 3D 메시가 탄생합니다.

전체 export 프로세스는 150ms만 소요됩니다.

UV unwrapping은 전통적으로 계산 집약적인 프로세스입니다.

기존 방법은 UV unwrapping에 몇 초가 필요하며, 이는 2초 미만의 생성 속도를 목표로 할 때 비현실적입니다.

이러한 비효율성을 해결하기 위해 Cube 프로젝션 기반 unwrapping 방법을 제안합니다.

이 접근 방식의 주요 장점은 병렬 처리가 가능하다는 것입니다: 메시의 각 면은 표면 normal을 기준으로 투영할 큐브 면을 독립적으로 결정할 수 있습니다.

UV unwrapping 프로세스는 그림 6에 나와 있습니다.

우리는 먼저 가장 지배적인 축을 기준으로 출력 메시를 큐브 프로젝션 좌표 시스템과 정렬합니다.

각 메시 면이 적절한 큐브 방향을 선택한 후 잠재적인 폐색을 해결합니다.

폐색을 관리하지 않으면 서로 다른 면이 동일한 UV 좌표를 공유하여 텍스처에 아티팩트를 초래할 수 있습니다.

우리는 2D triangle-triangle 교차 테스트를 수행하여 UV atlas에서 폐색을 감지합니다.

우리는 삼각형 중심에 근접하여 삼각형을 필터링하여 프로세스를 효율적으로 만듭니다.

교차점이 감지되면 평면의 depth를 기준으로 교차하는 삼각형을 정렬하여 첫 번째 교차점을 유지하고 다른 삼각형을 다른 UV atlas 영역으로 재배치하도록 표시합니다.

첫 번째 교차점은 UV atlas의 상단 3분의 1에 배치되고 두 번째 교차점은 왼쪽 하단 영역에 배치됩니다.

나머지 삼각형은 atlas의 오른쪽 하단 섹션에 있는 그리드로 구성됩니다.

또한 radial z 탄젠트 방향을 따라 각 섬을 회전하여 음영 이음새를 최소화합니다.

그런 다음 그림 6과 같이 각 면을 UV atlas의 위치에 할당합니다.

그런 다음 UV atlas에 UV unwrapping으로 세계 위치와 점유 데이터를 베이크합니다.

이를 통해 트리플 평면에서 차트 내 세계 위치를 쿼리하고 알베도 및 표면 normal을 추가 텍스처로 디코딩할 수 있습니다.

우리는 탄젠트 벡터와 비탄젠트 벡터를 사용하여 세계 공간 normal 맵을 탄젠트-공간 normal 맵으로 변환합니다.

우리는 UV 섬 경계에서 가시적인 이음새를 방지하기 위해 UV atlas에 여백을 추가합니다.

이는 반복적인 프로세스를 통해 달성됩니다: 각 반복에서 커널의 유효한 영역을 사용하여 점유된 영역을 기반으로 3 × 3 부분 컨볼루션을 수행합니다.

그런 다음 3×3 맥스 풀링 연산을 사용하여 UV atlas의 점유된 영역을 확장하여 원래 영역을 보존하면서 새로 확장된 영역에 평균값을 배치합니다.

이 반복적인 확장을 통해 텍스처가 바깥쪽으로 부드럽게 블렌딩되도록 보장합니다.

이미지 추정기의 금속 및 거칠기 값을 통합하고 모든 것을 GLB 파일로 포장하여 효율적인 렌더링과 다양한 애플리케이션에서 사용할 수 있도록 준비했습니다.

3.6. Overall Training and Loss Functions

메시 렌더링으로 직접 방법을 학습한 결과 만족스럽지 않은 결과를 얻었습니다.

따라서 NeRF 작업에 대해 사전 학습했습니다.

이 사전 학습에 따라 NeRF 렌더링을 미분 가능한 메시 렌더링 및 SG 기반 셰이딩으로 대체하여 메시 학습으로 전환했습니다.

빛 추정이 도입된 상황에서 더 큰 배치 크기를 사용하면 수렴에 도움이 된다는 것을 발견했습니다.

배치 크기 192, 렌더링 해상도 128 × 128로 학습을 시작하여 10K 단계에 대한 학습을 시작합니다.

후속 단계에서는 배치 크기를 128로 줄이고 해상도를 256 × 256으로 높여 20K 단계에 계속합니다.

마지막 단계는 배치 크기가 96인 512 × 512 해상도에서 80K 단계를 포함합니다.

loss 함수는 모든 메시 학습 단계에서 일관되게 유지됩니다.

우리는 주로 이미지 기반 메트릭을 사용하여 렌더링 및 음영 재구성 ˆI와 GT 이미지 I을 비교합니다.

여기에는 MSE L_MSE 및 LPIPS [77] L_LPIPS loss가 포함됩니다.

또한 GT 마스크 M과 MSE loss로 정의된 예측 불투명도 ˆM 사이에 마스크 loss L_Mask를 통합합니다.

그런 다음 렌더링, 메시 정규화 및 음영에 대한 세 가지 loss 공식을 정의합니다:

총 loss는

로 정의됩니다.

4. Results

Datasets.

비교를 위해 평가를 위한 기본 데이터 세트로 GSO [12]와 OmniObject3D [64]를 선택합니다.

비교를 위해 GSO에서 278개의 랜덤 장면을 선택하고 OmniObject3D에서 308개의 장면을 선택합니다.

우리는 객체 주변에 16개의 뷰를 렌더링하고 조건화 뷰로 정면을 선택합니다.

Baselines.

우리는 단일 이미지에서 빠른 3D 객체 재구성을 위한 여러 최근 방법과 비교합니다.

우리는 주로 다양한 기술에 걸쳐 일관된 평가 프로토콜을 유지하기 위해 빠른 재구성 모델에 중점을 둡니다.

또한 주로 메시를 출력으로 간주하고 메시에서 평가를 수행합니다.

우리는 모든 베이스라인에 대한 공식 구현을 사용하며 모든 방법을 동일한 프로토콜로 평가합니다.

비교를 위해 소스 코드 릴리스와 함께 몇 가지 최근 및 동시 작업을 선택했습니다.

특히 OpenLRM [18], TripoSR [54], LGM [53], CRM [59], InstantMesh [68] 및 ZeroShape [21]와 비교합니다.

OpenLRM의 경우 대형 Objaverse 1.1 모델을 선택했습니다.

비교를 위해 H100 GPU를 사용합니다.

Evaluations.

런타임 비교를 위해 메시를 최종 출력으로 간주하고 입력 이미지에서 최종 메시로 이동하는 데 필요한 전체 실행 시간을 계산합니다.

그런 다음 형상 품질에 대해 별도의 평가를 수행합니다.

여러 모델이 intrinsic 및 extrinsic 카메라 매개 변수에 조건을 붙일 수 없으므로 정렬 단계를 수행할 것을 제안합니다.

메시를 정규화하고, 브루트포스 회전 정렬 테스트를 수행하며, 가장 낮은 Chamfer Distance (CD)로 회전을 선택합니다.

그런 다음 Iterative Closest Point (ICP)을 사용하여 다른 정렬 단계를 실행하여 회전과 변환을 더욱 최적화합니다.

그런 다음 이 정렬 후 CD 및 F-score (FS)의 표준 형상 메트릭을 계산합니다.

이 정렬은 여전히 대칭 객체를 잘못 정렬하여 렌더링할 수 있습니다.

따라서 부록에서 지시 렌더링 메트릭만 보고합니다.

Triangle Counts.

각 방법은 기본 구성으로 실행됩니다.

삼각형 수는 3D 메시를 기준으로 크게 달라지므로 여기에서 단일 메시에 대한 삼각형 수를 보고합니다: InstantMesh 57.3K, CRM 24.1K, LGM 42.1K, TripoSR 32.1K, OpenLRM 662K, Ours 27.4K.

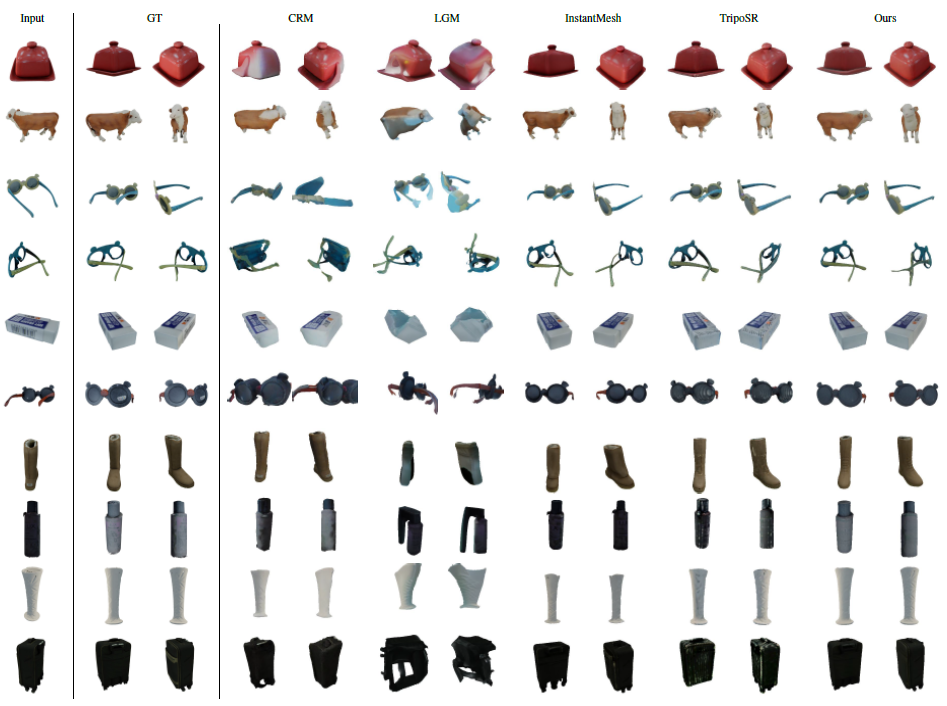

Results.

표 1에서 우리는 우리의 방법을 모든 베이스라인과 비교합니다.

여기서 우리의 방법은 CD와 F-score 모두에서 모든 현재 및 동시 베이스라인을 능가합니다.

이는 우리의 모델이 다른 베이스라인보다 다각형 수가 적더라도 우리의 방법이 정확한 모양을 재구성할 수 있음을 나타냅니다.

그림 7의 시각적 비교를 통해 SF3D의 정확한 모양 재구성은 3D 자산의 시각적 품질로도 잘 변환된다는 것을 알 수 있습니다.

여기서 SF3D는 안경 우물과 같은 미세한 지오메트리도 처리하고 SOTA 방법보다 더 상세한 텍스처로 일관된 모양을 생성한다는 점에 유의할 필요가 있습니다.

또한 결과는 그림 8에서 볼 수 있듯이 합리적인 재료 특성과 알베도를 보여줍니다.

이는 물체가 자연 조명 하에서만 렌더링되기 때문에 매우 어려운 문제입니다.

조명에 대한 지식 없이 재료 특성을 추정하는 것은 매우 모호한 문제입니다.

Inference Speed vs. Reconstruction Quality.

그림 9에서 우리는 다양한 기법에 대한 추론 속도 대 재구성 품질을 그림으로 그립니다.

가장 성능이 좋은 방법은 왼쪽 상단 모서리에 위치해야 합니다.

우리의 방법은 TripoSR보다 약간 느리지만 재구성 정확도는 SF3D의 경우 훨씬 더 좋습니다.

또한 그림 7에서 볼 수 있듯이 우리의 재구성은 덜 뚜렷한 마칭 큐브 아티팩트로 더 부드러운 음영을 가지고 있다는 점에 주목할 필요가 있습니다.

따라서 최종 겉보기 자산 품질은 우리의 방법보다 훨씬 더 높습니다.

Ablations.

우리는 표 2의 추가 사항을 기본 모델과 비교하여 평가합니다.

우리의 방법은 TripoSR을 기반으로 하므로 초기 베이스라인으로 사용합니다.

파인튜닝 단계로 메시 학습과 재등화를 추가하면 'SF3D w/o Enhanced Transformer'가 이미 TripoSR에서 개선되어 메시 기반 학습의 사용을 입증할 수 있음을 알 수 있습니다.

이러한 개선은 주로 효율적인 렌더링으로 인해 학습 중 더 높은 해상도 supervision이 가능하고 정점 오프셋에서 더 부드러운 메시가 가능하기 때문입니다.

향상된 트랜스포머를 사용하여 고해상도 트리플레인을 추가하면 SF3D는 베이스라인을 훨씬 능가합니다.

Limitations and Outlook.

그림 7(맨 위 행)에서 볼 수 있듯이 컵의 알베도가 완벽하게 일치하지 않습니다.

이는 어두운 반점에 유용한 정보가 포함되지 않는 LDR 입력과 관련이 있습니다.

또한 거칠기와 금속 특성은 균일하기 때문에 공간적으로 변화하는 서로 다른 여러 재료를 포함하는 물체에 대한 유용성이 제한됩니다.

또한 우리의 방법은 명시적인 supervision 없이 재료 예측과 즐거움을 도입합니다.

이러한 매개 변수에 대한 명시적인 supervision이 필요하지 않기 때문에 우리의 방법은 실제 데이터 세트에 대한 학습으로 확장될 수 있으며, 향후 작업을 위해 남겨둘 것입니다.

마찬가지로 UV unwrapping은 기존 데이터 세트를 활용하여 추가 개선을 할 수 있습니다.

5. Conclusion

저희는 uv로 포장되지 않은 텍스처 객체 재구성 방법에 대한 빠른 단일 뷰인 SF3D를 소개합니다.

빠른 추출 파이프라인 외에도 피드포워드 기반 3D 재구성 방법에 대한 몇 가지 아키텍처 개선 사항을 소개하여 모델이 매우 상세한 지오메트리와 텍스처를 생성하는 데 도움이 됩니다.

광범위한 평가에서 저희는 저희 방법이 속도와 품질 모두에서 기존 베이스라인과 동시 베이스라인을 능가한다는 것을 보여줍니다.