2025. 6. 9. 11:01ㆍRobotics

3D-VLA: A 3D Vision-Language-Action Generative World Model

Haoyu Zhen, Xiaowen Qiu, Peihao Chen, Jincheng Yang, Xin Yan, Yilun Du, Yining Hong, Chuang Gan

Abstract

최근의 vision-language-action (VLA) 모델은 2D 입력에 의존하며, 3D 물리 세계의 넓은 영역과의 통합이 부족합니다.

또한, 그들은 지각에서 action으로의 직접적인 매핑을 학습하여 action 예측을 수행하며, 세상의 방대한 역학 관계와 action과 역학 간의 관계를 무시합니다.

대조적으로, 인간은 미래 시나리오에 대한 상상력을 묘사하여 그에 따라 action을 계획하는 월드 모델을 가지고 있습니다.

이를 위해, 우리는 생성적 월드 모델을 통해 3D 인식, 추론, action을 원활하게 연결하는 새로운 embodied 파운데이션 모델 제품군을 도입하여 3D-VLA를 제안합니다.

구체적으로, 3D-VLA는 3D 기반 large language model (LLM) 위에 구축되며, embodied 환경과 상호작용하기 위해 일련의 상호작용 토큰이 도입됩니다.

또한 생성 능력을 모델에 주입하기 위해 일련의 embodied 디퓨전 모델을 학습하고 이를 목표 이미지와 포인트 클라우드를 예측하기 위해 LLM에 정렬합니다.

3D-VLA를 학습하기 위해 기존 로봇 데이터셋에서 방대한 3D 관련 정보를 추출하여 대규모 3D embodied 명령어 데이터셋을 큐레이션합니다.

held-in 데이터셋에 대한 실험 결과, 3D-VLA는 embodied 환경에서 추론, 멀티모달 생성 및 계획 기능을 크게 향상시켜 실제 응용 분야에서의 잠재력을 보여줍니다.

1. Introduction

요즘에는 인간 뇌의 다재다능함을 반영하여 이미지를 입력으로 받아 2D 공간에서 일련의 추론 작업을 수행할 수 있는 비전-언어 모델 (Liu et al., 2023; Alayrac et al., 2022; Li et al., 2023b)이 확산되고 있습니다.

이러한 2D 파운데이션 모델은 또한 이미지에 따라 고수준 계획 또는 저수준 액션을 생성할 수 있는 RT-2 (Brohan et al., 2023a) 및 PALM-E (Driess et al., 2023a)와 같은 최신 embodied 파운데이션 모델의 기초를 마련합니다.

그러나 그들은 인간이 2D 이미지를 넘어 훨씬 더 풍부한 3D 물리적 세계에 위치해 있다는 사실을 무시합니다 - 그들은 환경에 대한 3D 이해를 바탕으로 추론하고, 계획하고, 행동합니다 (Palmer, 1975; Plyshyn, 2003; Marr, 2010).

인간과 유사한 지능형 embodied 에이전트가 동일한 3D 이해 능력을 갖추는 것이 중요합니다.

한 걸음 더 나아가, 최근 연구들 (Huang et al., 2023b; Hong et al., 2024)은 3D 환경에서 계획하고 행동할 수 있는 embodied 파운데이션 모델을 개발하고 있습니다.

그러나 이러한 모델들은 주로 지각에서 액션으로의 직접적인 매핑을 학습하며, 월드의 역학과 액션과 월드 역학 간의 관계에 대한 더 넓은 이해가 부족합니다.

반면에, 인간은 3D 내부 표현을 기반으로 미래의 사건을 시뮬레이션하는 월드 모델을 가지고 있습니다.

미래 상태에 대한 상상력과 기대를 묘사함으로써 예측된 목표를 향한 액션을 더 잘 계획할 수 있습니다.

이러한 인간과 유사한 3D 월드 모델을 구축하기 위해서는 필연적으로 도전 과제가 존재합니다.

첫째, 기존의 파운데이션 모델은 언어 생성에 중점을 두고 있으며, 언어를 넘어서는 모달리티를 상상하고 미래 상태를 시뮬레이션하여 액션 생성을 촉진할 수 없습니다, 이는 월드 모델의 중요한 측면입니다.

둘째, 기존의 embodied 데이터셋은 주로 2D 이미지나 동영상을 포함하고 있으며, 3D 공간에서 추론하고 계획하는 데 필요한 3D 관련 주석이 부족합니다.

이를 위해, 우리는 생성적 월드 모델을 통해 3D 인식, 추론, 액션을 원활하게 연결하는 새로운 embodied 파운데이션 모델 제품군을 도입하여 3D-VLA를 제안합니다.

특히, 우리는 3D large language model (Hong et al., 2023) 위에 3D-VLA를 구축하여 모델에 3D 이해 능력을 갖추게 합니다.

embodied 작업은 언어 생성만으로는 수행할 수 없으며 동적 장면, 조작된 객체 및 장면과 상호 작용하기 위한 액션을 더 깊이 탐구해야 하므로, 우리는 LLM 어휘에 특별한 상호 작용 토큰 (예: 장면, 객체, 액션 토큰)을 추가합니다.

이 추가된 토큰을 통해 우리 모델은 더 다양한 embodied 작업을 수행하고 인터리브된 3D 텍스트 데이터를 지원할 수 있습니다.

embodied 파운데이션 모델에서 멀티모달 생성 능력의 부적절성을 인식하고, 우리는 목표 생성 능력을 3D-VLA에 도입할 것을 제안합니다.

먼저 RGBD-to-RGBD 및 point-to-point 생성을 위한 일련의 embodied 디퓨전 모델을 사전 학습합니다.

다양한 모달리티의 디퓨전 디코더와 LLM 임베딩 공간을 효율적으로 연결하기 위해, 우리는 3D-VLA에서 멀티모달 목표 생성을 정렬하는 프로젝터를 사용합니다.

멀티모달 신호를 전략적으로 통합하여 생성의 모달리티 유형을 지정합니다.

이러한 생성적 월드 모델을 구축하기 위한 또 다른 과제는 데이터 부족입니다.

사용 중인 embodied 데이터셋 (Padalkar et al., 2023; Brohan et al., 2022; Jang et al., 2022)은 주로 3D 관련 정보가 부족한 2D 이미지로 구성되어 있습니다.

따라서 우리는 대규모 3D embodied 명령어 튜닝 데이터셋을 큐레이션합니다.

구체적으로, 먼저 로봇 조작과 인간-객체 상호작용을 특징으로 하는 실제 및 합성 데이터를 포함하는 다양한 데이터 세트를 수집합니다.

depth 데이터가 부족한 데이터셋의 경우, depth 추정기를 사용하여 필요한 3D 세부 정보를 추가하고 이를 3D 포인트 클라우드에 투영합니다.

또한, 기성 모델을 사용하여 3D 관련 주석을 추출하고 언어 설명을 풍부하게 하는 파이프라인을 설계합니다.

이와 같이, 우리는 2M 3D-언어-액션 데이터 쌍을 수집하며, 그림 1과 같이 작업 캡션, 행동 예측, 위치 추정, 멀티모달 목표 생성 등 다양한 작업을 다룹니다.

요약하자면, 다음과 같은 기여가 있습니다:

• 3D 인식, 추론, 액션을 생성적 월드 모델과 통합한 새로운 3D 비전-언어-액션 embodied 파운데이션 모델 제품군인 3D-VLA를 제안합니다.

• 기존 embodied 데이터셋에 3D 관련 정보가 없는 상황을 해결하기 위해 대규모 3D embodied 명령어 튜닝 데이터셋을 만듭니다.

• 환경과 더 잘 상호작용하기 위해 상호작용 토큰을 추가합니다.

목표 이미지와 포인트 클라우드 생성을 위한 디퓨전 모델을 추가로 학습합니다.

프로젝터를 활용하여 LLM 출력 피쳐와 디퓨전 모델을 효율적으로 정렬합니다.

• 우리의 3D-VLA는 이미지, depth, 포인트 클라우드 측면에서 목표 생성, 목표 기반 계획, embodimetn 액 예측 등 다양한 작업을 수행할 수 있습니다.

이러한 새로운 embodied 작업에서 베이스라인 모델을 큰 차이로 능가합니다.

또한 전통적인 언어 기반 작업에서도 베이스라인 모델을 능가합니다.

2. Related Works

Multimodal Language Models

최근의 멀티모달 언어 모델은 비전과 언어 이해를 포함한 다양한 분야에서 괄목할 만한 발전을 이루었습니다 (Li et al., 2022; 2023b; Liu et al., 2023c; Huang et al., 2023c; Peng et al., 2023; Zhu et al., 2023), 인터리브 이미지와 텍스트 이해 (Alayrac et al., 2022), 인터리브 이미지와 텍스트 생성 (Dong et al., 2023).

일부 더 통합된 모델은 텍스트, 이미지, 비디오, 오디오의 임의의 조합으로 입력을 인식하고 출력을 생성할 수 있습니다 (Wu et al., 2023; Lu et al., 2023).

그러나 이러한 모델 중 어느 것도 3D 입력을 인식하거나 3D 입력에 따른 액션을 출력할 수 없습니다.

Vision-Language-Action Models

이전의 비전-언어 모델은 주로 2D 피쳐를 활용했기 때문에 3D 공간 이해 능력이 부족했습니다 (Driess et al., 2023b; Brohan et al., 2022; 2023).

반면에, 우리 모델은 일반 월드 모델의 목표 objective에 맞춰 예측되는 3D 피쳐에 의해 가이드됩니다.

우리는 포인트 클라우드와 같은 3D 피쳐를 액션 토큰 생성에 처음으로 활용하여 액션 플래닝 정확도를 크게 향상시켰습니다.

또한, 이 파이프라인은 실제 시나리오에서 응용될 수 있는 잠재력을 가지고 있습니다.

3D Foundation Models

우리 논문은 MLLM에 3D 피쳐를 통합한 3D 파운데이션 모델과 밀접한 관련이 있습니다 (Hong et al., 2023; Chen et al., 2023b; Qi et al., 2023; Xu et al., 2023; Huang et al., 2023a; Zhou et al., 2023; Guo et al., 2023; Li et al., 2024).

이 연구들은 3D 피쳐를 이해하기 위해 파운데이션 모델을 활용하는 데 성공적으로 진전되었습니다.

그러나 그들은 주로 3D 장면의 현재 관측 가능한 상태를 분석하고 추론하는 데 중점을 두므로, 즉각적인 인식을 넘어 확장되는 미래의 피쳐를 예측하는 데 한계가 있습니다.

그들과 대조적으로, 우리는 인식 가능한 장면을 이해하는 것뿐만 아니라 특정 목표에 의해 유도되는 인식 불가능한 멀티모달 피쳐를 예측하는 것을 목표로 합니다.

이 기능을 통해 우리 모델은 3D 월드와 상호작용할 수 있는 액션 토큰을 더욱 생성할 수 있습니다.

3. 3D Embodied Instruction Tuning Dataset

최근 인터넷에서 수십억 개 규모의 데이터셋을 활용한 VLM은 다양한 작업에서 뛰어난 숙련도를 입증했습니다.

마찬가지로, 비디오-액션 쌍으로 구성된 백만 수준의 데이터셋은 로봇 제어를 위한 embodied VLM의 파운데이션을 마련합니다.

그러나 그들은 대부분 depth나 3D 주석을 제공하지 않으며, 3D 공간 추론과 상호작용을 포함해야 하는 로봇 운영에서 정밀한 제어를 제공하지 않습니다.

3D 정보가 없으면 로봇이 "place the farthest cup into the middle drawer"와 같이 3D 공간 추론이 필요한 명령을 이해하고 실행하는 것은 어렵습니다.

이 격차를 해소하기 위해, 우리는 모델을 학습시키기 위해 충분한 3D 관련 정보와 쌍을 이룬 텍스트 명령어를 제공하는 대규모 3D embodied 명령어 튜닝 데이터셋을 구축합니다.

우리는 기존의 embodied 데이터셋에서 3D 언어-행동 쌍을 추출하는 파이프라인을 설계하여 포인트 클라우드, depth 맵, 3D 바운딩 박스, 로봇의 7D 액션 및 텍스트 설명에 대한 주석을 얻습니다.

세부 사항은 다음과 같이 요약됩니다.

3.1. Dataset Collection

우리의 데이터는 다양한 출처에서 선별되었습니다.

여기에서 개요를 제공하며, 자세한 내용은 부록에서 확인할 수 있습니다:

Robot Datasets:

우리는 Open-X Embodiment 데이터셋 (Padalkar et al., 2023)에서 12개의 데이터셋 (Brohan et al., 2022; Jang et al., 2022; Walke et al., 2023; Lynch et al., 2023; Feng et al., 2023; Chen et al., 2023a; Dass et al., 2023; Mandlekar et al., 2019; Mees et al., 2023; Shah et al., 2023; Sawhney et al., 2021; Sermanet et al., 2023)을 선택했습니다.

그들은 현실 세계에서 언어 지침이 있는 고품질 이미지를 가지고 있지만, 더 심층적인 정보와 3D 주석이 부족합니다.

우리는 또한 Dobb-E (Shafiullah et al., 2023)와 RH20T (Fang et al., 2023)와 같은 우수한 depth 정보를 가진 데이터셋을 선택합니다.

또한, 우리는 두 개의 시뮬레이터 환경, 즉 RLBench (James et al., 2020)와 Calvin (Mees et al., 2022)에서 수집한 데이터셋을 사용합니다.

Human Object Interaction Datasets:

인간/손의 상호작용은 로봇의 의사결정과 모방에 도움이 되는 시연을 제공할 수 있습니다.

따라서 우리는 depth 정보가 없는 Epic-Kitchens (Damen et al., 2018)와 같은 데이터셋과 HOI4D (Liu et al., 2022)와 같이 더 나은 3D 주석을 가진 데이터셋을 포함한 여러 인간-객체 상호작용 데이터셋을 활용합니다.

3.2. Visual Annotations

Estimating depths and optical flows.

embodied 작업에 대한 비디오 데이터셋의 95% 이상이 3D 정보를 제공하지 않는다는 점을 감안하여, 우리는 이러한 데이터셋의 각 비디오 프레임에 ZoeDepth (Bhat et al., 2023)를 사용합니다.

또한 비디오 데이터를 더 잘 활용하기 위해 옵티컬 플로우 추정을 위해 RAFT (Teed & Deng, 2020)를 사용합니다.

옵티컬 플로우는 우리가 생성하는 데이터를 정제하는 데 도움이 됩니다.

따라서 카메라 포즈가 변하지 않는 비디오 세그먼트의 경우, 옵티컬 플로우를 사용하여 움직이지 않는 배경 픽셀을 추정합니다.

우리는 동일한 비디오의 여러 프레임에 걸쳐 이러한 배경의 depth 맵을 정렬하고, 각 프레임의 depth 맵에 계수를 곱하여 depth 일관성을 보장합니다.

depth 맵을 얻은 후, 카메라 intrinsics와 포즈를 사용하여 RGB-D 이미지를 3D 포인트 클라우드로 직접 리프트할 수 있습니다.

Generating 3D annotations.

우리는 여러 가지 3D 관련 주석을 생성하는 것을 목표로 합니다: 상상의 결과물인 객체, 목표 이미지, depth 또는 포인트 클라우드의 3D 바운딩 박스와 3D 공간에서의 로봇 액션.

먼저 장면 속 객체의 3D 바운딩 박스를 추출합니다.

이러한 정보는 3D 모델이 3D 정보를 캡처하고 조작된 객체를 주의 깊게 관찰하여 더 나은 의사 결정을 내리는 데 도움이 될 수 있습니다.

소스로 사용되는 embodied 데이터셋은 로봇이 실행하는 명령을 설명하기 위한 텍스트 지침을 제공합니다.

spaCy (Honnibal & Montani, 2017)를 사용하여 명령어를 구문 분석하여 조작된 객체를 포함한 모든 명사 청크를 얻습니다.

사전 학습된 grounding 모델 (예: Grounded-SAM (Ren et al., 2024))을 사용하여 각 객체의 2D 마스크를 얻습니다.

이 2D 마스크는 3D로 리프트할 때 포인트 클라우드의 일부에 해당하므로 공간에 있는 모든 물체의 3D 바운딩 박스를 얻을 수 있습니다.

마스크를 선택할 때, 중요한 옵티컬 플로우 영역에서 가장 높은 신뢰도 값을 기준으로 조작된 객체를 선택합니다.

depth와 포인트 클라우드를 재구성하기 때문에 향후 프레임에서 이미지, depth, 포인트 클라우드를 실제 목표로 사용할 수 있습니다.

액션의 경우 제공된 데이터셋에서 7가지 DoF 액션을 사용합니다.

3.3. Language Annotations

(Li et al., 2023a; Peng et al., 2023)에서 영감을 받아, 우리는 이전에 생성한 3D 주석 (바운딩 박스, 목표 이미지 / depth / 포인트 클라우드, 액션)을 포함하는 토큰(예: <image></image>; <pcd></pcd>)으로 구성된 조밀한 언어 주석을 생성할 것을 제안합니다, 이는 그림 2의 프롬프트와 같습니다.

우리는 토큰이 포함된 사전 정의된 언어 템플릿을 사용하여 이러한 3D 주석을 프롬프트와 답변으로 구성합니다.

(Hong et al., 2023)에 이어, 우리는 프롬프트를 다양화하기 위해 ChatGPT 기반 프롬프트를 사용합니다.

구체적으로, 우리는 ChatGPT와 주석이 달린 객체 및 바운딩 박스에 대한 지침을 제공합니다.

우리는 또한 GPT가 생성하도록 지시받은 데이터 유형에 대해 가이드하기 위해 2-3개의 몇 가지 사람이 작성한 시연을 제공합니다.

ChatGPT는 정보를 요약하고 템플릿에서 생성된 프롬프트를 보다 다양한 형태로 다시 작성해야 합니다.

미리 정의된 템플릿이 없는 작업의 경우, ChatGPT는 이러한 작업의 언어 입력 및 출력으로 프롬프트와 답변을 직접 생성하도록 요청받습니다.

부록에서 모든 유형의 데이터를 생성하기 위한 자세한 템플릿과 프롬프트를 보여줍니다.

4. Methods

4.1. Overview

이 섹션에서는 embodied 환경에서 3D 추론, 목표 생성 및 의사 결정을 위한 월드 모델인 3D-VLA를 소개합니다.

그림 2에서 볼 수 있듯이, 우리는 먼저 3D-LLM (Hong et al., 2023) 위에 백본을 구축하고, 일련의 상호작용 토큰을 추가하여 모델의 3D 월드와의 상호작용 능력을 더욱 향상시킵니다.

다음으로, 먼저 embodied 디퓨전 모델을 사전 학습하고 프로젝터를 사용하여 LLM과 디퓨전 모델을 정렬함으로써 목표 생성 능력을 3D-VLA에 주입합니다.

4.2. 3D-VLA

4.2.1 Backbone

첫 번째 단계에서는 3D-LLM (Hong et al., 2023)의 방법론을 따라 3D-VLA base 모델을 개발합니다.

우리가 수집한 데이터셋은 멀티모달 LLM을 처음부터 학습하는 데 필요한 10억 수준의 규모가 아니기 때문에, 우리는 멀티뷰 피쳐를 활용하여 3D 장면 피쳐를 생성함으로써 3D-LLM의 접근 방식을 따릅니다.

이를 통해 적응 없이 사전 학습된 VLM에 시각적 피쳐를 원활하게 통합할 수 있습니다.

한편, 3D-LLM의 학습 데이터셋은 대부분 객체 (Deitke et al., 2022)와 실내 장면 (Dai et al., 2017; Ramakrishnan et al., 2021)으로 구성되며, 이는 우리의 embodied 설정과 직접적으로 일치하지 않습니다.

따라서 3D-LLM 사전 학습된 모델을 로드하지 않기로 결정했습니다.

대신, 우리는 BLIP2-PlanT5_XL (Li et al., 2023b)을 사전 학습된 모델로 사용합니다.

학습 중에는 토큰의 입력 및 출력 임베딩과 Q-Former의 가중치를 모두 해제합니다.

4.2.2 Interaction Tokens

모델의 3D 장면에 대한 이해도를 높이고 이러한 환경 내에서 상호 작용을 촉진하기 위해 새로운 상호 작용 토큰 세트를 소개합니다.

먼저, 모델이 조작되거나 참조되는 객체를 더 잘 포착할 수 있도록 구문 분석된 문장에서 객체 명사를 둘러싸는 객체 토큰 <obj> </obj>를 통합합니다 (예: <obj> a chocolate bar </obj> [loc tokens] on the table).

둘째, 공간 정보를 언어로 더 잘 표현하기 위해 참조된 객체를 그라운딩하기 위한 위치 토큰 집합 <loc0-255>를 고안했으며, 이는 AABB 형태의 3D 바운딩 박스에 대한 6개의 토큰으로 표현됩니다.

셋째, 우리의 프레임워크로 역학을 더 잘 인코딩하기 위해 정적 장면의 임베딩을 둘러싸기 위해 <scene> </scene> 토큰을 도입합니다.

장면 토큰을 합성함으로써 3D-VLA는 동적 장면을 이해하고 3D 장면과 텍스트를 인터리브하는 입력을 관리할 수 있었습니다.

우리는 로봇 액션을 나타내는 확장된 전문 토큰 세트로 아키텍처를 더욱 강화합니다.

로봇의 액션은 7개의 자유도를 가지며, 팔의 의도된 절대 위치, 회전, 그리퍼 개방성을 나타내기 위해 <aloc0-255>, <arot0-255>, <gripper0/1>과 같은 개별 토큰으로 표현됩니다.

이 작업들은 토큰 <ACT_SEP>로 구분됩니다.

4.3. Injecting Goal Generation Ability into 3D-VLA

이 섹션에서는 이미지, depth, 포인트 클라우드 측면에서 3D-VLA가 목표 생성을 어떻게 수행하는지 소개합니다.

인간은 월드 모델 구축의 핵심 측면인 액션 예측이나 의사 결정을 용이하게 하기 위해 장면의 최종 상태를 미리 시각화합니다.

또한 예비 실험 중에 ground-truth 최종 상태를 제공하면 모델의 추론 및 계획 능력을 향상시킬 수 있다는 사실도 발견했습니다.

그러나 이미지, depth, 포인트 클라우드를 생성하기 위해 MLLM을 학습하는 것은 간단하지 않습니다.

첫째, SOTA 비디오 디퓨전 모델은 embodied 설정에 맞게 조정되지 않았습니다.

예를 들어, Runway (Esser et al., 2023)에 "open the drawer"라는 지침이 주어지면 미래 프레임을 생성하도록 요청할 때, 전체 장면은 뷰 변경, 예상치 못한 물체 변형, 이상한 텍스처 교체, 레이아웃 왜곡 등과 관련하여 크게 변경됩니다.

마찬가지로, DreamLLM (Dong et al., 2023) 방법을 사용하여 인터넷 데이터로 학습된 stable diffusion을 직접 freeze하면 출력이 붕괴될 수 있습니다.

둘째, 다양한 모달리티의 디퓨전 모델을 하나의 파운데이션 모델에 통합하는 방법은 여전히 도전 과제로 남아 있습니다.

따라서 이미지, depth 및 포인트 클라우드를 생성하는 기능을 3D-VLA에 도입할 것을 제안합니다.

먼저 이미지, depth, 포인트 클라우드와 같은 다양한 모달리티 측면에서 embodied 디퓨전 모델을 사전 학습한 다음, 정렬 단계를 통해 이러한 디퓨전 모델의 디코더를 3D-VLA의 임베딩 공간에 정렬합니다.

4.3.1 Pretraining Embodied Diffusion Models for Goal Generation

embodied 환경에서 목표 생성을 위한 현재 디퓨전 모델의 한계를 해결하기 위해 RGB-D to RGB-D, 포인트 클라우드 to 포인트 클라우드 디퓨전 모델을 학습합니다.

우리는 큐레이팅된 3D-언어 비디오 데이터를 활용하여 초기 상태 모달리티를 지침에 따라 편집하여 해당 최종 상태 모달리티를 생성하는 조건부 디퓨전 모델을 학습합니다.

이 모델들에 대한 구체적인 학습 세부 사항은 다음과 같습니다: RGBD to RGBD 생성을 위해, 사전 학습된 VAE (Kingma & Welling, 2013)의 잠재 공간에서 작동할 때 잠재 디퓨전에 의한 이미지 생성의 효율성과 품질을 고려하여 Stable Diffusion V1.4 (Rombach et al., 2022)를 사전 학습된 모델로 사용합니다.

우리는 RGB 잠재와 depth 잠재를 이미지 조건으로 concat합니다.

마찬가지로 point-to-point 생성의 경우 사전 학습된 모델로 Point-E (Nichol et al., 2022)를 사용하여 포인트 클라우드 조건 입력을 추가합니다.

4.3.2 Bringing LLM and Goal Generation

디퓨전 모델을 사전 학습한 후, 우리는 모달리티의 잠재 공간을 조건화하여 목표를 생성할 수 있는 다양한 디코더를 갖추고 있습니다.

사전 학습된 디코더를 LLM에 원활하게 통합하여 3D-VLA가 입력 지침에 따라 사전 학습된 모달리티와 관련하여 목표를 생성할 수 있도록 하는 방법에 대한 과제가 남아 있습니다.

LLM과 다양한 모달리티의 디퓨전 모델 간의 격차를 해소하기 위해 3D-VLA에 정렬 단계를 개발했습니다.

먼저 <image> </image> 및 <pcd> </pcd>와 같은 추가 특별 토큰을 소개합니다.

이 토큰들은 디코더에게 출력할 모달 콘텐츠의 유형을 알려주기 위해 복잡하게 설계되었습니다.

둘러싸이는 토큰들 사이에서, 우리는 로봇이 실행할 명령어를 생성하는 과정에서 LLM을 supervise합니다, 여기에는 객체 토큰과 위치 토큰이 포함될 수 있습니다, 예를 들어, <image> pick up the <obj> apple </obj> [loc tokens] </image>.

이를 바탕으로 Large Language Model (LLM)의 디코더 피쳐와 임베딩을 DM 프레임워크 공간에 매핑할 수 있는 트랜스포머 기반 프로젝터를 적용할 수 있습니다.

모델이 멀티모달 데이터를 이해하고 생성하는 능력을 향상시키고, 고급 언어 이해와 멀티모달 목표 생성 간의 연결을 확립하는 데 중요한 역할을 합니다.

3D-VLA 학습을 더 효율적으로 만들고 치명적인 망각을 피하기 위해 LoRA (Hu et al., 2021)를 활용하여 다양한 디퓨전 모델을 파인튜닝합니다.

동시에 새로 도입된 특수 토큰 임베딩, 해당 임베딩 출력 선형 레이어, 그리고 전체 프로젝터만 학습합니다.

우리는 LLM과 DM 디노이징 loss를 모두 최소화합니다.

5. Experiments

3D-VLA는 3D 월드에서 추론과 그라운딩을 수행하고, 멀티모달 목표 콘텐츠를 상상하며, 로봇 조작을 위한 액션을 생성할 수 있는 다재다능한 3D 기반 생성 월드 모델입니다.

이 섹션에서는 3D-VLA를 세 가지 측면에서 평가합니다: 3D 추론 및 현지화, 멀티모달 목표 생성, 구체화된 행동 계획.

5.1. 3D Reasoning and Localization

Tasks.

우리의 주요 초점은 더 큰 역동성과 더 높은 수준의 상호작용을 특징으로 하는 로봇과 관련된 장면에 맞춰져 있으며, 이는 더 높은 수준의 추론과 위치 파악 능력을 필요로 합니다.

우리는 로보틱스 분야에서 이러한 능력을 학습하기 위해 3D embodied 명령어 튜닝 데이터셋에 여러 가지 작업을 구축합니다.

작업에는 1) RoboVQA 데이터셋 (Sermanet et al., 2023)에 대한 구체화된 QA; 2) 11개의 Open-X 데이터셋 (Padalkar et al., 2023)에 대한 작업 캡셔닝이 포함됩니다, 여기서 초기 및 최종 장면을 입력하고 에이전트에게 무슨 일이 일어났는지 추론하도록 요청합니다; 3) RT-1 데이터셋 (Brohan et al., 2022)에 대한 QA는 에이전트에게 특정 작업 (액션 토큰으로 표시됨)이 실행될 경우 어떤 일이 발생할지 묻는 질문입니다; 4) 11개의 Open-X 데이터셋에 대한 밀집 캡셔닝, 에이전트가 3D 바운딩 박스로 지정된 콘텐츠에 캡셔닝을 해야 하는 경우; 5) 에이전트가 로봇 조작 지침에 언급된 객체를 위치 지정해야 하는 11개의 Open-X 데이터셋에 대한 위치 지정.

우리는 보류된 데이터셋을 사용하여 이러한 작업에 대해 3D-VLA를 평가합니다.

Baselines.

우리는 3D-VLA를 BLIP2 (Li et al., 2023b), OpenFlamingo (Alayrac et al., 2022), LLaVA (Liu et al., 2023)를 포함한 3D-LLM 및 2D 비전-언어 모델과 비교합니다.

우리는 이러한 베이스라인을 두 가지 방식으로 구현합니다: 1) 이러한 새로운 작업에서 공개된 학습된 모델을 테스트하는 제로샷 전송; 2) 2D-이미지-액션-언어 쌍 (즉, Open-X 및 RoboVQA 데이터셋에서 선택된 11개의 데이터셋)에서 공개된 모델을 학습하는 held-in 평가.

로컬화 작업의 경우, 우리는 2D 그라운딩 MLLM, 즉 Kosmos-2 (Peng et al., 2023a) 및 CoVLM (Li et al., 2023a)과 비교합니다.

특히, 이러한 모델을 사용하여 2D 바운딩 박스를 제로샷 방식으로 감지한 다음 depth 투영을 사용하여 3D 바운딩 박스로 전송합니다.

Result analysis.

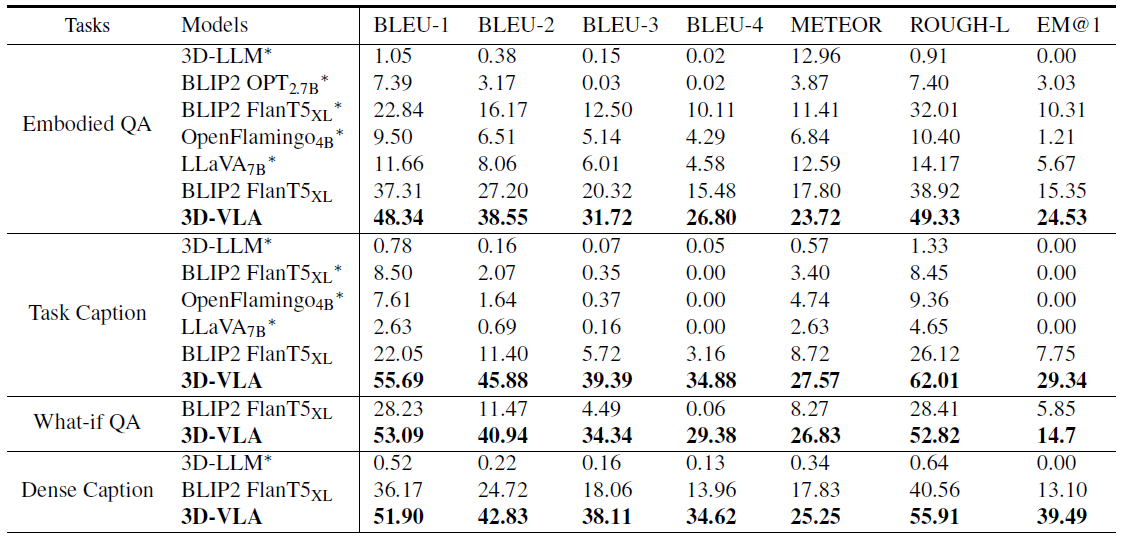

표 1에서 3D-VLA는 언어 추론 작업에서 모든 2D VLM 방법을 능가합니다.

우리는 이를 추론에 더 정확한 공간 정보를 제공하는 3D 정보의 활용 덕분이라고 생각합니다.

또한, 우리 데이터셋에는 여러 가지 3D 위치 추정 주석이 포함되어 있기 때문에 3D-VLA는 관련 객체를 위치 추정하는 방법을 학습하여 모델이 추론을 위해 주요 객체에 더 집중하는 데 도움이 됩니다.

게다가, 우리는 3D-LLM이 이러한 로봇 추론 작업에서 성능이 좋지 않다는 것을 발견했으며, 이는 로봇 관련 3D 데이터셋을 수집하고 학습할 필요성을 보여줍니다.

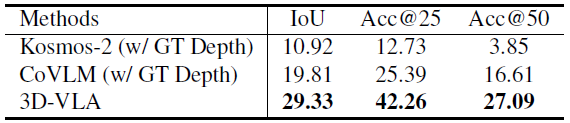

표 2에서 3D-VLA는 로컬화 성능 측면에서 2D 기본 방법에 비해 현저한 우수성을 보여줍니다.

이 발견은 상당한 양의 3D 주석을 제공하는 주석 프로세스의 효율성을 입증하는 강력한 증거로 작용하여 모델 내에서 강력한 3D 위치 지정 기능을 획득하는 데 도움이 됩니다.

5.2. Multi-modal Goal Generation

Tasks.

우리는 Open-X 테스트 세트에서 3D-VLA의 RGB 목표와 포인트 클라우드 목표 생성 능력을 정량적으로 평가합니다.

우리는 학습 과정에서 3D-VLA가 보지 못하는 Open-X 테스트 세트에서 4000개의 에피소드를 랜덤으로 샘플링했습니다.

Baselines.

이미지 생성을 위해 3D-VLA를 세 가지 유형의 이미지 생성 방법과 비교합니다: 1) 이미지 편집 방법 Instruct-P2P (Brooks et al., 2023); 2) 목표 이미지/비디오 생성 방법 SuSIE (Black et al., 2023); 3) 이미지 생성 능력 NeXT-GPT를 갖춘 LLM (Wu et al., 2023).

포인트 클라우드 생성의 경우, text-to-3D 디퓨전 모델인 Point-E (Nichol et al., 2022)와 비교합니다.

Qualitative results.

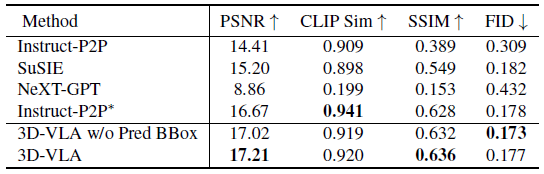

이미지 목표 생성 결과는 표 3에 나와 있습니다.

로봇 도메인으로 직접 제로샷 전송을 수행하는 기존 생성 방법 (표 3의 행 1, 2, 3)과 비교했을 때, 3D-VLA는 대부분의 지표 측면에서 유망한 성능을 달성합니다.

이는 로봇 공학 응용을 위해 특별히 설계된 데이터셋을 사용하여 월드 모델을 학습하는 것의 중요성을 강조합니다.

우리가 사용한 동일한 로봇 데이터셋 (표의 4행)으로 학습된 Instruct-P2P*와 직접 비교해도 3D-VLA는 일관되게 그 성능을 능가합니다.

이는 대형 언어 모델을 3D-VLA에 통합하면 로봇 조작 지침을 보다 포괄적이고 통찰력 있게 이해할 수 있어 목표 이미지 생성 성능이 향상된다는 것을 강조합니다.

또한, 입력 프롬프트 (5행)에서 예측된 바운딩 박스를 제외하면 성능이 약간 저하되는 것을 관찰할 수 있습니다.

이 관찰은 모델이 전체 장면을 이해하는 데 도움이 되는 중간 예측 바운딩 박스를 사용하는 것의 효과를 확인시켜 주며, 모델이 주어진 지침에서 언급된 특정 객체에 더 많은 주의를 기울일 수 있게 하여 궁극적으로 최종 목표 이미지를 상상하는 능력을 향상시킵니다.

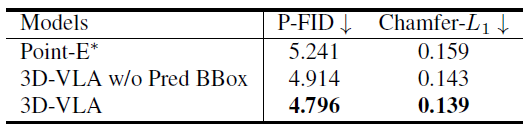

포인트 클라우드 생성 결과는 표 4에 나와 있습니다.

중간 예측 바운딩 박스가 있는 3D-VLA가 가장 우수한 성능을 발휘합니다.

이 결과는 지시와 장면을 모두 이해하는 맥락에서 대규모 언어 모델과 정확한 객체 위치 파악의 중요성을 강화합니다.

Quantitative results.

그림 3의 첫 번째 행에서는 RT-1 (Brohan et al., 2022) 및 Jaco Play (Dass et al., 2023) 데이터셋의 테스트 세트에서 생성된 RGB-D 목표 이미지를 시각화합니다.

이러한 샘플은 학습 과정에서 볼 수 없습니다.

초기 장면과 지침을 고려할 때 3D-VLA 모델은 배경 요소를 변경하지 않고 유지하면서도 상호작용 대상 객체를 정확하게 식별하고 제공된 지침에 따라 식별된 객체의 상태를 올바르게 수정할 수 있는 능력을 일관되게 보여줍니다.

생성된 RGB-D 목표 이미지는 시각적 외관과 시맨틱 내용 면에서 실제 목표와 밀접하게 일치합니다.

통제된 실험 설정 외에도 인터넷이나 일상 생활에서 촬영한 장면을 포함하도록 테스트를 확장했습니다.

이러한 다양하고 통제되지 않은 환경에서 우리의 3D-VLA 모델은 일관되고 견고하게 그 효능을 입증했습니다.

5.3. Embodied Action Planning

Tasks.

우리는 로봇 팔 액션 예측을 위한 3D-VLA의 능력을 두 가지 벤치마크, 즉 RLBench (James et al., 2020)와 CALVIN (Mees et al., 2022)에서 평가합니다.

평가를 위해 RLBench에서 세 가지 작업을 선택합니다.

또한, 모델의 일반화 능력을 테스트하기 위해 보이지 않는 작업으로 pick-up-cup 작업에서 var1을 선택합니다.

CALVIN의 경우, 에이전트가 5개의 작업을 순차적으로 수행해야 하는 장기적인 멀티태스크 언어 제어 설정 하에서 모델을 평가합니다.

우리는 A, B, C, D 장면에서 에이전트를 학습시키고 D 장면에서 테스트합니다.

Baselines.

RLbench의 경우, 우리는 우리의 모델 3D-VLA를 LanCon-Learn (Silva et al., 2021)과 비교합니다, 이 접근 방식은 명령 조건 입력을 기반으로 액션을 예측할 수 있는 멀티태스크 접근 방식입니다.

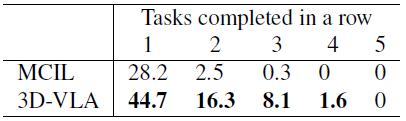

CALVIN의 경우, 조건부 sequence-to-sequence 변분 오토인코더인 MCIL (Lynch & Sermanet, 2020)과 비교합니다.

Result analysis.

표 5에 나타난 바와 같이, 3D-VLA는 RLBench 액션 예측 내 대부분의 작업에서 베이스라인 성능을 초과하거나 일치하여 계획 능력을 보여줍니다.

베이스라인은 기록 관찰, 객체 상태 및 현재 상태 정보를 사용하는 반면, 오픈 루프 제어를 통해서만 실행된다는 점에 주목할 필요가 있습니다.

또한, 우리의 일반화 능력은 pick-up-cup 작업에서 입증되었습니다.

표 6에서 3D-VLA는 CALVIN에서도 유망한 결과를 얻었습니다.

우리는 이러한 우월성을 관심 대상을 위치 파악하고 액션을 추론하는 데 풍부한 정보를 제공하는 목표 상태를 상상할 수 있는 능력에 기인한다고 생각합니다.

6. Conclusion

이 논문에서는 embodied 환경에서 추론, 이해, 생성 및 계획을 수행할 수 있는 생성 월드 모델인 3D-VLA를 소개합니다.

우리는 모델을 학습시키기 위해 2M 3D-언어-행동 데이터 쌍을 포함하는 데이터 세트를 구성하기 위해 새로운 데이터 생성 파이프라인을 고안했습니다.

이러한 데이터를 통해 작업 캡션, 로컬화, 목표 이미지/포인트 클라우드 생성, 액션 예측 등 다양한 작업을 수행할 수 있습니다.

우리 모델은 3D-LLM을 백본으로 사용하며 환경과 상호작용하기 위해 상호작용 토큰을 도입합니다.

우리는 embodied AI를 위해 image to image 학습하고 point to point 디퓨전 모델을 제공합니다.

그들은 LLM의 멀티모달 생성 능력을 향상시키기 위해 LLM과 프로젝터를 통해 더욱 정렬됩니다.

이 실험은 또한 3D-VLA가 2D 베이스라인보다 embodied 작업에서 더 강력한 능력을 가지고 있음을 보여줍니다.

'Robotics' 카테고리의 다른 글

| OpenVLA: An Open-Source Vision-Language-Action Model (0) | 2025.06.30 |

|---|---|

| Navigation World Models (0) | 2025.06.25 |

| NoMaD: Goal Masked Diffusion Policies for Navigation and Exploration (ICRA 2024 Best Paper) (0) | 2025.04.14 |

| Open X-Embodiment: Robotic Learning Datasets and RT-X Models (0) | 2025.03.24 |

| PaLM-E: An Embodied Multimodal Language Model (0) | 2025.03.20 |