2025. 4. 14. 11:28ㆍRobotics

NoMaD: Goal Masked Diffusion Policies for Navigation and Exploration

Ajay Sridhar, Dhruv Shah, Catherine Glossop, Sergey Levine

Abstract

낯선 환경에서의 내비게이션을 위한 로봇 학습은 작업 지향적인 내비게이션 (즉, 로봇이 찾은 목표에 도달하는 것)과 작업에 구애받지 않는 탐색 (즉, 새로운 환경에서 목표를 찾는 것) 모두에 대한 policy들을 제공해야 합니다.

일반적으로 이러한 역할은 하위 목표 제안, 계획 또는 별도의 탐색 전략을 사용하는 등 별도의 모델에 의해 처리됩니다.

이 논문에서는 목표 지향 탐색과 목표 비의존 탐색을 모두 처리하기 위해 단일 통합 디퓨전 policy를 학습하는 방법을 설명합니다, 후자는 새로운 환경을 탐색할 수 있는 기능을 제공하고, 전자는 사용자가 지정한 목표를 찾은 후 도달할 수 있는 기능을 제공합니다.

우리는 이 통합된 policy가 새로운 환경에서 시각적으로 표시된 목표를 탐색할 때 생성 모델의 하위 목표 제안을 사용하는 접근 방식이나 잠재 변수 모델을 기반으로 한 이전 방법에 비해 전반적으로 더 나은 성과를 가져온다는 것을 보여줍니다.

우리는 여러 그라운드 로봇의 데이터를 기반으로 학습된 대규모 트랜스포머 기반 policy와 디퓨전 모델 디코더를 사용하여 목표 조건부 내비게이션과 목표에 구애받지 않는 내비게이션을 유연하게 처리함으로써 우리의 방법을 구현합니다.

실제 모바일 로봇 플랫폼에서 수행된 우리의 실험은 다섯 가지 대체 방법과 비교하여 보이지 않는 환경에서도 효과적인 내비게이션을 보여주며, SOTA 접근 방식보다 작은 모델을 사용함에도 불구하고 성능이 크게 향상되고 충돌률이 낮아지는 것을 보여줍니다.

Ⅰ. Introduction

로봇 학습은 목표나 다른 작업 명세를 조건으로 할 때 다양한 행동을 수행할 수 있는 멀티태스크 policy를 획득하는 강력한 도구를 제공합니다.

이러한 policy는 유연성뿐만 아니라 다양한 작업과 도메인의 데이터를 활용하고 이러한 설정에서 지식을 공유함으로써 더 성능이 뛰어나고 일반화할 수 있는 policy를 획득할 수 있기 때문에 매력적입니다.

그러나 실제 환경에서는 로봇이 환경이 낯설거나 탐색이 필요하거나 사용자가 제공한 방향이 불완전하여 어떤 작업을 수행해야 할지 모르는 상황에 직면할 수 있습니다.

이 연구에서는 사용자가 시각적으로 (즉, 사진을 통해) 목적지를 지정할 수 있고, 로봇이 환경을 검색하여 목적지를 찾아야 하는 로봇 내비게이션 분야에서 이 문제의 특히 중요한 사례를 연구합니다.

이러한 환경에서는 사용자 지정 작업을 수행하도록 학습된 표준 멀티태스크 policy만으로는 충분하지 않습니다: 또한 로봇이 원하는 작업을 수행하는 방법 (즉, 관심 있는 대상을 찾는 방법)을 알아내기 전에 다양한 작업 (예: 환경 검색을 위한 다양한 가능한 목적지)을 시도할 수 있는 방법도 필요합니다.

이전 연구들은 종종 이 문제를 해결하기 위해 하이레벨 계획 [1], 계층적 강화 학습 [2], 생성 모델 [3]과 같이 적절한 탐색 작업을 생성하는 별도의 하이레벨 policy 또는 목표 제안 시스템을 학습시켰습니다.

그러나 이는 추가적인 복잡성을 초래하며 종종 작업별 메커니즘을 필요로 합니다.

대신 과제에 특화된 행동과 과제에 구애받지 않는 행동을 모두 표현할 수 있는 고도로 표현력 있는 단일 policy를 학습하고, 과제를 해결하기 위해 필요에 따라 과제에 구애받지 않는 행동을 탐색하고 전환할 수 있을까요?

이 논문에서는 고차원 시각 관측 스트림을 인코딩하기 위한 트랜스포머 백본과 미래 action 시퀀스를 모델링하기 위한 디퓨전 모델을 결합하여 이러한 policy를 설계하고, 새로운 환경에서 시각적 탐색 및 목표 추구라는 특정 문제에 대해 이를 예시합니다.

우리의 주요 통찰은 이러한 아키텍처가 높은 용량 (인식 모델링과 제어 모두)과 복잡한 멀티모달 분포를 나타낼 수 있는 능력을 제공하기 때문에 작업별 및 작업에 구애받지 않는 경로를 모델링하는 데 독특하게 적합하다는 것입니다.

우리 작업의 주요 기여는 이전에 보지 못한 환경에서 로봇 내비게이션을 위한 새로운 아키텍처인 Navigation with Goal Masked Diffusion, NoMaD입니다, 이 아키텍처는 통합 디퓨전 policy를 사용하여 탐색적 작업에 구애받지 않는 행동과 목표 지향적 작업별 행동을 그래프 검색, 경계 탐색, 고도로 표현력 있는 policy를 결합한 프레임워크로 공동으로 표현합니다.

우리는 도전적인 실내외 환경에서 무방향 및 목표 조건 실험 모두에서 NoMaD의 성능을 평가하고, SOTA 기술에 비해 개선된 성능을 보고하며, 동시에 계산 효율성도 15배 더 높였습니다.

우리가 아는 한, NoMaD는 목표 조건부 action 디퓨전 모델을 성공적으로 구현한 최초의 사례이며, 작업에 구애받지 않는 행동과 작업 지향적 행동 모두를 위한 통합 모델입니다.

Ⅱ. Related Work

새로운 환경을 탐색하는 것은 종종 효율적인 매핑 문제로 간주되며, 로봇을 새로운 영역으로 가이드하기 위한 정보 최대화 측면에서 제기됩니다.

일부 이전 탐사 방법은 로봇의 제어 action을 생성하기 위해 로컬 전략을 사용하는 반면, 다른 방법은 프론티어 방법을 기반으로 한 전역 전략을 사용합니다 [8–10].

그러나 신뢰할 수 있는 depth 정보 없이는 고충실도 지오메트릭 맵을 구축하는 것이 어려울 수 있습니다.

이전 연구 [1, 11, 12]에서 영감을 받아, 우리는 탐색 문제를 (i) 다양한 단기적 행동을 취할 수 있는 학습된 통제 policy와 (ii) 장기적 목표 추구 policy를 사용하는 위상 그래프를 기반으로 한 고급 계획자로 분해합니다.

여러 이전 연구들은 시뮬레이션에서 특권 정보를 활용하거나 실제 경험을 통해 직접 학습함으로써 로봇 탐사를 위한 학습 기반 접근 방식을 제안했습니다 [13–16].

이러한 policy는 보장 범위를 최대화하기 위해 강화 학습을 통해 학습되었으며, 시맨틱적으로 풍부한 영역, 내재적 리워드 [13, 14, 18, 19] 또는 잠재 변수 및 어포던스 모델과 함께 계획을 사용하여 학습되었습니다 [17, 20, 21].

그러나 시뮬레이션으로 학습된 policy는은 실제 환경으로 잘 전달되지 않는 경향이 있으며 [16, 22], 우리의 실험 결과, 실제 데이터로 학습된 최고의 탐색 policy조차도 복잡한 실내외 환경에서 성능이 떨어지는 것으로 나타났습니다 [16, 22].

NoMaD와 가장 가까운 관련 작업은 ViNT로, 별도의 고용량 하위 목표 제안 모델과 함께 목표 조건부 내비게이션 policy를 사용합니다 [3].

하위 목표 제안 모델은 로봇의 현재 관찰을 조건으로 후보 서브골 이미지를 생성하는 300M 매개변수 이미지 디퓨전 모델 [23]로 구현됩니다.

NoMaD는 디퓨전 모델을 다르게 사용합니다: 이러한 생성을 기반으로 디퓨전과 조건을 갖춘 하위 목표 이미지를 생성하는 대신, 우리는 디퓨전을 통해 로봇의 관찰을 조건으로 한 action을 직접 모델링합니다.

경험적으로, 무방향 탐사에서 NoMaD가 ViNT 시스템을 25% 이상 능가한다는 것을 발견했습니다.

또한 NoMaD는 고차원 이미지를 생성하지 않기 때문에 15배 이상 적은 매개변수가 필요하므로 덜 강력한 온보드 컴퓨터(예: NVIDIA Jetson Orin)에서 직접 실행할 수 있는 더 작고 효율적인 접근 방식을 제공합니다.

탐사를 위한 로봇 action 시퀀스를 예측하는 데 있어 중요한 과제는 멀티모달 action 분포를 모델링하는 데 어려움이 있다는 점입니다.

이전 연구에서는 양자화된 행동의 자기회귀 예측 [24–27], 잠재 변수 모델 [17, 21], 암묵적 policy 표현 [28], 그리고 가장 최근에는 계획 및 통제를 위한 조건부 디퓨전 모델 [29–34] 등 다양한 action 표현을 탐구하여 이 문제를 해결했습니다.

상태 또는 관측 조건 디퓨전 모델 [30, 31]은 미래의 상태/관측을 추론하는 데 드는 비용과 추가 복잡성 없이 복잡한 action 분포를 모델링할 수 있기 때문에 특히 강력합니다.

NoMaD는 로봇의 관찰과 선택적 목표 정보 모두에 대한 action 분포를 추가로 조건화하여 이 공식을 확장하여 목표 조건 모드와 무방향 모드 모두에서 작동할 수 있는 "diffusion policy"의 첫 번째 인스턴스를 제공합니다.

Ⅲ. Preliminaries

우리의 objective는 로봇의 현재 및 과거 RGB 관측값을 입력 o_t := o_(t-P:t)로 받아 향후 action a_t := a_(t:t+H)에 대한 분포를 출력하는 시각적 내비게이션을 위한 제어 policy π을 설계하는 것입니다.

policy는 또한 내비게이션 작업을 지정하는 데 사용할 수 있는 목표 o_g의 RGB 이미지에 접근할 수 있습니다.

목표 o_g가 주어지면 π는 목표를 향해 진전을 이루는 action을 취해야 하며, 결국 목표에 도달해야 합니다.

보이지 않는 환경에서는 목표 이미지 o_g를 사용할 수 없을 수 있으며, π는 안전하고 합리적인 내비게이션 action (예: 장애물 피하기, 복도 따라가기 등)를 취하면서 환경 내 유효한 행동에 대한 충분한 커버리지를 제공하여 환경을 탐색해야 합니다.

장기 탐사와 목표 추구를 용이하게 하기 위해, 우리는 ViKiNG [35]과 환경 M에 대한 위상 기억을 가진 쌍 π(o_t)의 설정을 따르고, 로봇이 미개척 지역으로 이동하여 환경을 탐험하도록 장려하는 고급 플래너를 사용합니다.

Visual goal-conditioned policies:

시각적 입력을 위한 목표 조건 policy를 학습하기 위해, 우리는 트랜스포머 아키텍처를 기반으로 한 대용량 policy 학습에 대한 많은 선행 연구를 따릅니다 [3, 36–38].

구체적으로, 우리는 로봇의 시각적 관찰 o_t와 목표 o_g를 처리하기 위한 백본으로 Visual Navigation Transformer (ViNT) [3] policy를 사용합니다.

ViNT는 EfficientNet-B0 인코더 [39] ψ(o_i)를 사용하여 각 관찰 이미지 i ∈ {t - P, . . . , t}를 독립적으로 처리하고, 목표 융합 인코더 ϕ(o_t, o_g)를 사용하여 입력을 토큰화합니다.

이 토큰들은 멀티 헤드 어텐션 레이어 f(ψ(o_i), ϕ(o_t, o_g))를 사용하여 처리되어 최종 컨텍스트 벡터 c_t를 얻기 위해 concat된 일련의 컨텍스트 벡터를 얻습니다.

그런 다음 컨텍스트 벡터를 사용하여 관찰과 목표 d(o_t, o_g) = f_d(c_t) 사이의 시간적 거리를 예측합니다, 여기서 f_a, f_c는 완전히 연결된 레이어입니다.

policy는 ground truth action과 시간적 거리에 대한 회귀에 해당하는 maximum likelihood objective를 사용하여 지도 학습을 통해 학습됩니다.

ViNT는 목표 조건 탐색에서 SOTA 성능을 보여주지만, 무방향 탐색을 수행할 수 없으며 외부 하위 목표 제안 메커니즘이 필요합니다.

NoMaD는 ViNT를 확장하여 목표 조건부 내비게이션과 무방향 내비게이션을 모두 가능하게 합니다.

Exploration with topological maps:

목표 조건 policy는 유용한 어포던스와 충돌 회피 행동을 보일 수 있지만, 오랜 기간 동안 추론이 필요한 대규모 환경에서는 탐색하기에 불충분할 수 있습니다.

대규모 환경에서 장기적인 탐색과 목표 추구를 용이하게 하기 위해, 우리는 ViKiNG [35]의 설정을 따르고 policy를 로봇의 환경 경험에 대한 위상 그래프 형태로 에피소드 메모리 M과 통합합니다.

M은 policy의 목표 조건 거리 예측에 따라 로봇의 시각적 관찰에 해당하는 노드와 두 노드 사이의 탐색 가능한 경로에 해당하는 엣지를 가진 그래프 구조로 표현됩니다.

큰 환경을 탐색할 때 로봇의 시각적 관찰만으로는 목표까지의 긴 지평선 궤적을 계획하기에 충분하지 않을 수 있습니다.

대신 로봇은 위상 맵 M을 사용하여 목표로 가이드하는 일련의 하위 목표를 계획할 수 있습니다.

이전에 보지 못한 환경을 탐험할 때, 우리는 로봇이 목표를 찾기 위해 환경을 탐색하는 동안 온라인으로 M을 구성합니다.

이 그래프 기반 프레임워크는 무방향 커버리지 탐색 외에도 임의로 멀리 떨어져 GPS 위치, 지도상 위치, 언어 지침 등으로 지정될 수 있는 고수준 목표 G에 도달할 수 있는 기능도 지원합니다.

이 연구에서는 다양한 하위 목표를 제안하고 보이지 않는 환경을 탐색하는 NoMaD의 능력을 테스트하는 프론티어 기반 탐색에 중점을 둡니다.

우리는 주로 이전 연구 [35]의 설정을 따르며, 학습된 policy를 NoMaD와 교환합니다.

Ⅳ. Method

목표 조건 탐색과 개방형 탐색을 위해 별도의 policy를 사용하는 이전 연구와 달리, 우리는 두 행동 모두에 대해 단일 모델을 학습하는 것이 더 효율적이고 일반화될 수 있다고 가정합니다 [3].

두 행동 모두에 걸쳐 공유 policy를 학습하면 모델이 조건부 추론과 무조건 추론 모두에 사용할 수 있는 action a_t보다 더 표현력 있는 사전 정보를 학습할 수 있습니다.

이 섹션에서는 목표 도달 및 무방향 탐색 모두에 사용할 수 있는 목표 조건부 디퓨전 policy인 제안된 NoMaD 아키텍처에 대해 설명합니다.

NoMaD 아키텍처에는 두 가지 주요 구성 요소가 있습니다: (i) 어텐션 기반 목표-마스킹은 선택적 목표 이미지 o_g에 policy를 조건화 (또는 마스킹)하는 유연한 메커니즘을 제공하며, (ii) 로봇이 취할 수 있는 충돌 없는 action에 대해 표현적인 prior 정보를 제공하는 디퓨전 policy를 제공합니다.

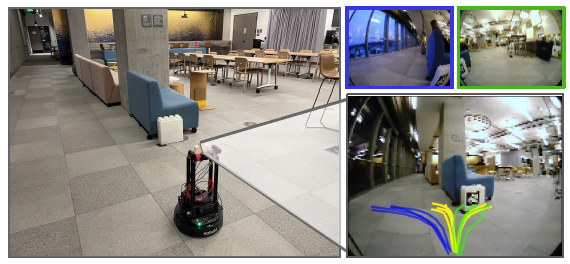

그림 2는 NoMaD 아키텍처의 개요를 보여주며, 아래에서 각 구성 요소를 자세히 설명합니다.

A. Goal Masking

목표 도달 및 무방향 탐색을 위한 공유 policy를 학습하기 위해, 우리는 c_t = f(ψ(o_i), ϕ(o_t, o_g),m)과 같은 이진 "goal mask" m을 도입하여 섹션 III에서 설명한 ViNT 아키텍처를 수정합니다.

m을 사용하여 목표 토큰 ϕ(o_t, o_g)를 마스킹하여 policy의 목표 조건 경로를 차단할 수 있습니다.

우리는 c_t의 다운스트림 계산이 목표 토큰에 집중하지 않도록 목표 마스크 m = 1을 설정하여 마스크 어텐션을 구현합니다.

우리는 m = 0으로 설정하여 목표 토큰이 c_t의 다운스트림 계산에서 관찰 토큰과 함께 사용되도록 마스크되지 않은 어텐션을 구현합니다.

학습 중에 목표 마스크 m은 확률 p_m의 베르누이 분포에서 샘플링됩니다.

학습 중에는 목표 도달 및 무방향 탐색에 해당하는 동일한 수의 학습 샘플에 해당하는 고정된 p_m = 0.5를 사용합니다.

테스트 시 원하는 동작에 해당하는 m을 설정합니다: m = 1은 무방향 탐사를 의미하고, m = 0은 사용자가 지정한 목표 이미지에 도달하는 것을 의미합니다.

우리는 이 간단한 마스킹 전략이 목표 도달 및 무방향 탐색을 위한 단일 policy를 학습하는 데 매우 효과적이라는 것을 발견했습니다.

B. Diffusion Policy

목표 마스킹은 목표 이미지에서 policy를 편리하게 조정할 수 있게 해주지만, 특히 목표가 제공되지 않을 때 이로 인해 발생하는 action에 대한 분포는 매우 복잡할 수 있습니다.

예를 들어, 교차로에서 policy는 좌우 회전에는 높은 확률을 할당해야 하지만 충돌을 초래할 수 있는 모든 action에는 낮은 확률을 할당해야 할 수도 있습니다.

action 시퀀스에 대한 복잡하고 멀티모달 분포를 모델링하기 위해 단일 policy를 학습하는 것은 어렵습니다.

이러한 복잡한 분포를 효과적으로 모델링하기 위해 디퓨전 모델 [23]을 사용하여 조건부 분포 p(a_t|c_t)를 근사합니다, 여기서 c_t는 목표 마스킹 후 얻은 관찰 컨텍스트입니다.

우리는 가우시안 분포에서 일련의 미래 action a_t^K를 샘플링하고, 원하는 노이즈-프리 출력 a_t^0이 형성될 때까지 노이즈 수준이 감소하는 일련의 중간 action 시퀀스 {a_t^K, a_t^(K-1), ... , a_t^0}을 생성하기 위해 디노이징의 K 반복을 수행합니다.

반복적인 디노이징 과정은 식 (1)을 따릅니다, 여기서 k는 디노이징 단계의 수, ϵ_θ는 θ로 매개변수화된 노이즈 예측 네트워크, α, γ 및 σ는 노이즈 스케줄의 함수입니다.

노이즈 예측 네트워크 ε_θ는 마스크 m에 의해 결정된 바와 같이 목표 정보를 포함할 수도 있고 포함하지 않을 수도 있는 관찰 컨텍스트 c_t에 따라 조건화됩니다.

우리는 디퓨전 과정과 시각 인코더의 실시간 제어 및 종단 간 학습을 가능하게 하는 디노이징 과정의 출력에서 c_t를 제외하고 조건부 (공동이 아닌) action 분포를 모델링한다는 점에 유의하세요.

학습 중에는 실제 action 시퀀스에 노이즈를 추가하여 ε_θ을 학습합니다.

예측된 노이즈는 mean squared error (MSE) loss를 통해 실제 노이즈와 비교됩니다.

C. Training Details

NoMaD 모델 아키텍처는 그림 2에 나와 있습니다.

우리는 GNM과 SACSoN 데이터셋, 다양한 환경에서 수집된 대규모 heterogeneous 데이터셋, 보행자가 풍부한 환경을 포함한 로봇 플랫폼을 사용하여 100시간이 넘는 실제 경로를 통해 NoMaD를 학습시킵니다 [40, 41].

NoMaD는 다음 loss 함수를 사용하여 지도 학습을 통해 종단 간 학습됩니다:

, 여기서 ψ, ϕ은 관찰 및 목표 이미지를 위한 시각적 인코더에 해당하고, f는 트랜스포머 레이어에 해당하며, θ는 디퓨전 과정의 매개변수에 해당하고, f_d는 시간 거리 예측기에 해당합니다.

λ = 10-4는 시간적 거리 loss의 상대적 가중치를 제어하는 하이퍼파라미터입니다.

학습 중에는 목표 도달 및 무방향 탐사 샘플의 수에 해당하는 목표 마스킹 확률 p_m = 0.5를 사용합니다.

디퓨전 policy는 Square Cosine 노이즈 스케줄러 [42]와 K = 10 디노이징 단계로 학습됩니다.

우리는 디노이징 반복 k를 균일하게 샘플링하고, 반복 k에서 정의된 분산을 가진 해당 노이즈 ϵ_k도 샘플링합니다.

노이즈 예측 네트워크인 ϵ_θ는 15개의 컨볼루션 레이어가 있는 1D 조건부 U-Net [29, 31]으로 구성되어 있습니다.

우리는 학습률이 10^-4인 AdamW 옵티마이저 [43]를 사용하고 배치 크기가 256인 30개의 에포크 동안 NoMaD를 학습합니다.

우리는 학습 과정을 안정화하고 ViNT의 다른 하이퍼파라미터를 따르기 위해 코사인 스케줄링과 워밍업을 사용합니다 [3].

ViNT 관측 인코더의 경우, EfficientNet-B0 [39]를 사용하여 관측치와 목표를 256차원 임베딩으로 토큰화한 다음, 4개의 레이어와 4개의 헤드를 가진 트랜스포머 디코더를 사용합니다.

Ⅴ. Evaluation

우리는 6가지 실내외 환경에서 NoMaD를 평가하고, 다음 질문에 답하기 위해 실험을 공식화했습니다:

Q1. NoMaD는 실제 환경에서 시각적 탐색 및 목표 달성을 위한 이전 연구와 어떻게 비교됩니까?

Q2. 작업에 구애받지 않는 공동 policy와 작업별 policy는 개별 행동 policy와 어떻게 비교됩니까?

Q3. 시각적 인코더와 목표 마스킹의 선택이 NoMaD 성능에 얼마나 중요합니까?

A. Benchmarking Performance

Q1을 이해하기 위해, 우리는 NoMaD를 6개의 도전적인 실제 환경에서 탐사 및 항해를 위한 6개의 성과 베이스라인과 비교합니다.

우리는 ViNT [3]의 실험 설정을 따르며, (i) 목표 위치를 찾기 위해 새로운 환경을 효과적으로 탐색하거나 (ii) 이전에 탐색된 환경에서 이미지로 표시된 목표에 도달할 수 있는 방법을 평가합니다, 여기서 로봇은 policy를 사용하여 일시적인 기억으로서 위상 그래프를 생성합니다.

모든 베이스라인은 20개의 에포크 동안 GNM과 SACSoN 데이터셋을 결합하여 학습되며, 각 베이스라인에 대해 안정적인 학습을 보장하기 위해 최소한의 하이퍼파라미터 튜닝을 수행합니다.

각 베이스라인의 평균 성공률과 실험당 평균 충돌 횟수를 보고합니다.

VIB:

우리는 저자들이 잠재 목표 모델을 사용하여 탐색을 수행하는 것을 사용합니다 [17], 이 모델은 variational information bottleneck (VIB)을 사용하여 관찰에 기반한 액션 분포를 모델링합니다.

Masked ViNT:

우리는 관찰 맥락 c_t를 유연하게 조건화하기 위해 목표 마스킹을 ViNT policy [3]와 통합합니다.

이 베이스라인은 분포를 모델링하는 대신 c_t를 조건으로 미래 액션의 포인트 추정치를 예측합니다.

Autoregressive:

이 베이스라인은 멀티모달 액션 분포를 더 잘 표현하기 위해 이산화된 액션 공간에 대한 자기회귀 예측을 사용합니다.

우리의 구현은 액션 분포, 목표 마스킹, 그리고 동일한 시각적 인코더 디자인의 범주적 표현을 사용합니다.

Subgoal Diffusion:

우리는 목표 조건 policy와 이미지 디퓨전 모델을 결합하여 후보 서브골 이미지를 생성하는 ViNT 시스템 [3]을 저자들이 구현한 것을 사용하여, 이를 통해 policy가 탐색 액션을 예측합니다.

이것은 우리가 비교한 가장 잘 발표된 베이스라인이지만, NoMaD보다 15배 더 큰 모델을 사용합니다.

Random Subgoals:

위의 ViNT 시스템의 변형으로, 서브골 디퓨전을 대체하여 후보 서브골에 대한 학습 데이터를 랜덤으로 샘플링하고, 이를 목표 조건 policy에 전달하여 탐색 액션을 예측합니다.

이 베이스라인은 이미지 디퓨전을 사용하지 않으며, NoMaD와 비슷한 매개변수 수를 가지고 있습니다.

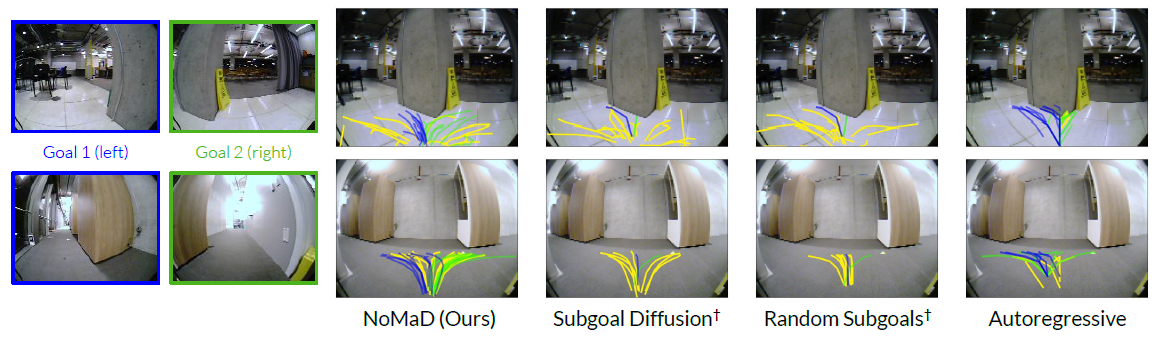

표 I는 5가지 어려운 실내외 환경에서의 실험 결과를 요약한 것입니다.

VIB와 Masked ViNT는 우리가 테스트한 모든 환경에서 어려움을 겪고 있으며, 종종 충돌로 끝나는 경우가 많습니다, 이는 멀티모달 액션 분포를 효과적으로 모델링하는 데 어려움이 있기 때문일 수 있습니다.

자기회귀 베이스라인은 더 표현력이 뛰어난 policy 클래스를 사용하며 이러한 베이스라인을 능가하지만 복잡한 환경에서는 어려움을 겪습니다.

또한 배포된 policy는 이산화된 액션 공간으로 인해 환경의 동적 장애물에 대응하는 데 있어 육포적이고 느린 경향이 있습니다 (실험용 보충 동영상 참조).

NoMaD는 모든 베이스라인을 일관되게 능가하며 원활하고 반응성 있는 policy를 제공합니다.

탐색적 목표 발견의 경우, NoMaD는 효율성과 충돌 회피 측면에서 최고로 발표된 베이스라인 (서브골 디퓨전)을 25% 이상 능가하며, 가장 어려운 환경을 제외한 모든 환경에서 성공합니다.

알려진 환경에서의 내비게이션을 위해, 토폴로지 그래프를 사용하여 NoMaD는 가장 잘 발표된 베이스라인의 성능과 일치하며, 동시에 15배 더 작은 모델이 필요하고 완전히 최신 상태로 실행됩니다.

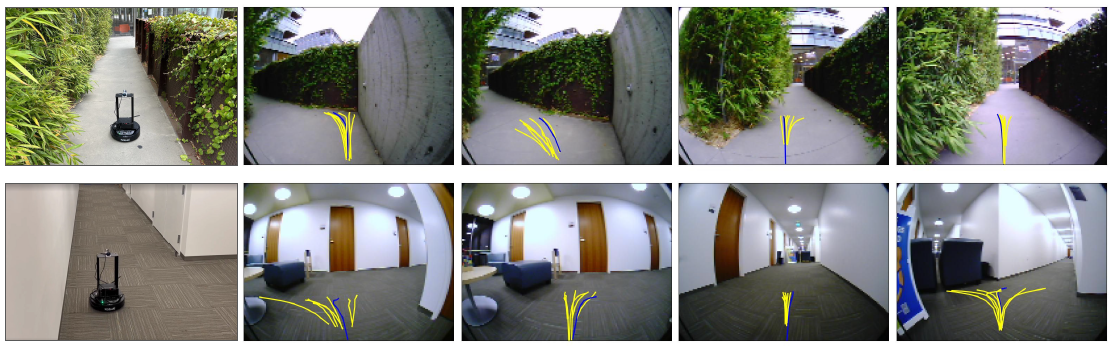

그림 4는 목표를 찾기 위해 알려지지 않은 실내외 환경을 탐색하는 NoMaD policy의 예시적인 전개를 보여줍니다.

베이스라인 간의 policy 예측을 분석한 결과 (그림 5 참조), 자기회귀 policy 표현은 (원칙적으로) 멀티모달 분포를 표현할 수 있지만 예측은 대부분 단일 모달로, policy가 평균 액션 분포를 학습하는 것과 동등하다는 것을 발견했습니다.

서브골 디퓨전 베이스라인은 여러 모드를 잘 나타내는 경향이 있지만, 그다지 견고하지는 않습니다.

NoMaD는 멀티모달 분포를 일관되게 포착하며, 목표 이미지를 조건으로 할 때 정확한 예측을 수행합니다.

B. Unified v/s Dedicated Policies

과제별 및 과제에 구애받지 않는 기능을 갖춘 policy가 제공하는 유연성을 바탕으로, Q2는 목표 마스킹이 policy가 학습하는 개별 액션에 미치는 영향을 이해하는 것을 목표로 합니다.

구체적으로, 우리는 공동으로 학습된 NoMaD 모델의 성능을 목표 조건부 및 무방향 모델과 비교합니다.

각 베이스라인의 평균 성공률을 보고합니다.

Diffusion Policy:

우리는 NoMaD 및 m = 0과 동일한 시각 인코더를 사용하여 디퓨전 policy [31]를 학습합니다.

이것은 VIB와 IBC를 모두 능가하는 최고의 탐사 베이스라인입니다.

ViNT Policy:

우리는 관찰과 목표를 바탕으로 미래 액션의 포인트 추정치를 예측하는 ViNT 내비게이션 policy [3]의 저자들이 발표한 체크포인트를 사용합니다.

이것은 최고의 내비게이션 베이스라인입니다.

위의 통합 NoMaD policy와 비교해보면, 유사한 모델 용량을 가지고 있음에도 불구하고 목표 마스킹으로 학습된 통합 policy가 목표 조건 탐색을 위한 ViNT policy와 무방향 탐색을 위한 DP policy의 성능과 일치한다는 것을 알 수 있습니다.

이는 이 두 가지 행동에 대한 학습이 공유된 표현과 어포던스를 학습하는 것을 포함하며, 단일 policy가 작업에 구애받지 않는 행동과 작업 지향적 행동 모두에서 실제로 우수할 수 있음을 시사합니다.

C. Visual Encoder and Goal Masking

우리는 Q3를 이해하기 위해 시각적 인코더와 목표 마스킹 아키텍처의 변형을 탐구합니다.

CNN과 ViT 백본을 기반으로 한 두 가지 대체 시각 인코더 설계를 고려하고, 목표 마스킹을 다양한 방식으로 구현합니다.

각 베이스라인의 평균 성공률과 실험당 평균 충돌 횟수를 보고합니다.

Early/Late Fusion CNN:

컨볼루션 인코더와 MLP를 사용하여 관찰 및 목표 이미지를 인코딩하고, 목표 임베딩에 드롭아웃과 다른 MLP 블록을 사용하여 목표에 대한 관찰 컨텍스트 c_t를 유연하게 조건화합니다.

드롭아웃 후 얻은 c_t는 NoMaD와 동일한 방식으로 디퓨전 모델을 조건화하는 데 사용됩니다.

학습 중에 관찰 및 목표 인코더에 그래디언트를 전파하기 위해 직관적인 추정기 [44]를 사용합니다.

목표는 최종 MLP 레이어 전후의 관측값과 결합할 수 있습니다.

ViT:

관찰 이미지와 목표 이미지를 6 × 6 패치로 나누고, 비전 트랜스포머 [45]를 사용하여 이를 관찰 컨텍스트 c_t로 인코딩합니다.

우리는 어텐션 마스크를 사용하여 목표 패치가 정보를 전달하는 것을 차단합니다.

표 III에 요약된 바와 같이, 우리는 디퓨전 policy를 학습하는 데 있어 시각적 인코더의 선택이 중요하다는 것을 발견했습니다.

NoMaD는 ViT 및 CNN 기반 아키텍처를 모두 능가하여 충돌을 피하면서 목표에 성공적으로 도달했습니다.

초기 융합을 사용한 CNN은 후기 융합을 능가하며, 이전 연구 [3, 38]에서 유사한 분석을 확인했지만 목표 정보를 효과적으로 조건화하는 데 어려움을 겪고 있습니다.

대용량임에도 불구하고 ViT 인코더는 디퓨전과 함께 엔드투엔드 학습에서 최적화 문제로 인해 좋은 policy를 학습하는 데 어려움을 겪었습니다.

Ⅵ. Discussion

우리는 과제에 구애받지 않는 탐색과 과제 지향적 탐색을 모두 수행할 수 있는 목표 조건부 디퓨전 policy의 첫 번째 사례인 NoMaD를 발표했습니다.

우리의 통합 내비게이션 policy는 마스크드 어텐션 접근 방식을 갖춘 대용량 트랜스포머 인코더를 사용하여 내비게이션의 목표 이미지와 같은 작업을 유연하게 조건화하고, 디퓨전 모델을 사용하여 관찰에 따라 조건화된 액션을 모델링합니다.

우리는 이전에 보지 못한 실내외 환경에서 장거리 탐사와 내비게이션의 맥락에서 이 통합 모델의 성능을 연구하며, 이전에 보지 못한 환경에서 SOTA 기술에 비해 성능이 25% 이상 향상되었으며, 동시에 15배 적은 계산 자원이 필요함을 보여줍니다.

우리의 실험은 통합 policy가 새로운 환경에서 더 효과적인 탐색을 제공할 수 있다는 개념 증명을 제공하지만, 우리 시스템은 향후 연구에서 해결할 수 있는 여러 가지 한계가 있습니다.

내비게이션 작업은 일반적이지만 사용자가 사용하기에 가장 자연스러운 방식이 아닌 목표 이미지를 통해 지정됩니다.

우리의 접근 방식을 언어와 공간 좌표를 포함한 다양한 목표 양식을 수용할 수 있는 완전한 내비게이션 시스템으로 확장하면 우리의 접근 방식을 더 폭넓게 적용할 수 있을 것입니다.

또한, 우리의 탐사 방법은 고급 계획을 위해 표준 프론티어 기반 탐사 전략을 사용하며, 우리의 policy를 활용하여 프론티어에서 탐사합니다.

시맨틱과 prior 지식에 기반한 전략과 같이 탐색할 지역을 지능적으로 선택하면 성능이 더욱 향상될 수 있습니다.

이러한 방향들이 우리의 policy 대표성을 통해 더욱 실용적이고 유능한 시스템으로 이어지기를 바랍니다.

'Robotics' 카테고리의 다른 글

| Navigation World Models (0) | 2025.06.25 |

|---|---|

| 3D-VLA: A 3D Vision-Language-Action Generative World Model (0) | 2025.06.09 |

| Open X-Embodiment: Robotic Learning Datasets and RT-X Models (0) | 2025.03.24 |

| PaLM-E: An Embodied Multimodal Language Model (0) | 2025.03.20 |

| RT-2: Vision-Language-Action Models Transfer Web Knowledge to Robotic Control (0) | 2025.03.17 |