2021. 3. 19. 15:46ㆍView Synthesis

Stereo Magnification: Learning view synthesis using multiplane images

TINGHUI ZHOU, RICHARD TUCKER, JOHN FLYNN, GRAHAM FYFFE, NOAH SNAVELY

알려진 이미지에서 장면의 새로운 뷰를 생성하는 뷰 합성 문제는 부분적으로 가상 및 증강 현실의 강력한 응용 프로그램으로 인해 최근 관심을 끌었습니다.

본 논문에서, 우리는 뷰 합성에 대한 흥미로운 시나리오를 탐구한다: VR 카메라와 현재 널리 보급된 듀얼 렌즈 카메라 폰을 포함하여 좁은 기준의 스테레오 카메라에 의해 캡처된 이미지에서 뷰를 외삽한다.

우리는 이 문제를 스테레오 확대라고 부르고, 다중 평면 이미지(MPI)라고 부르는 새로운 레이어 표현을 활용하는 학습 프레임워크를 제안합니다.

우리의 방법은 또한 조회수 추정을 학습하기 위해 방대한 새로운 데이터 소스를 사용합니다 : YouTube의 온라인 비디오.

이러한 비디오에서 마이닝된 데이터를 사용하여 입력 스테레오 이미지 쌍에서 MPI를 예측하는 심층 네트워크를 학습합니다.

이 추론된 MPI는 입력 기준선을 훨씬 넘어서는 뷰를 포함하여 장면의 다양한 새로운 뷰를 합성하는 데 사용할 수 있습니다.

우리는 우리의 방법이 최근 몇 가지 뷰 합성 방법과 비교가 잘 된다는 것을 보여주고 좁은 기준 스테레오 이미지를 확대하여 응용 프로그램을 보여준다.

1. Introduction

사진은 지난 10년 동안 격변을 겪었습니다.

휴대폰 카메라는 지속적으로 포인트 앤 슛 카메라를 대체했으며 특정 시나리오에서 디지털 SLR과의 경쟁이 되었습니다.

이러한 변화는 더 나은 하드웨어와 높은 동적 범위 이미징과 같은 컴퓨터 사진 기능을 통해 휴대폰 카메라의 이미지 품질이 향상되면서 주도되었습니다 [Hasinoff et al. 2016] 및 합성 디 포커스 [Apple 2016; Google 2017b].

이러한 최근 혁신의 상당수는 기존 카메라의 기능을 복제하려고 했습니다.

그러나 휴대폰은 또한 여러 렌즈 및 깊이 센서와 같은 새로운 종류의 센서를 빠르게 획득하여 기존 사진을 뛰어 넘는 애플리케이션을 가능하게 합니다.

특히 듀얼 렌즈 카메라가 점점 보편화되고 있습니다.

스테레오 카메라는 사진만큼이나 오랫동안 사용되어 왔지만 최근에는 iPhone 7과 같은 여러 듀얼 카메라 폰이 시장에 나왔습니다.

이러한 카메라는 1cm 정도의 매우 작은 기준선(뷰 사이의 거리)을 갖는 경향이 있습니다.

우리는 또한 최근에 거의 눈 거리를 두고있는 한 쌍의 카메라에서 스테레오 이미지와 비디오를 캡처하는 여러 "가상 현실 지원"카메라가 등장하는 것을 보았습니다 [Google 2017a].

스테레오 카메라의 확산에 동기를 부여한 본 논문에서는 이러한 좁은 기준선 이미지 쌍에서 새로운 뷰를 합성하는 문제를 탐구합니다.

많은 이전 작업이 주어진 뷰 세트 사이의 보간 문제를 탐구했지만 [Chen and Williams 1993], 우리는 두 입력 이미지를 훨씬 넘어서는 뷰를 외삽하는 문제에 초점을 맞춥니다.

이러한 뷰 외삽법은 사진에 많은 응용 분야를 가지고 있습니다.

예를 들어, 휴대폰에서 기준선이 좁은 (~1cm) 스테레오 쌍을 가져 와서 IPD로 분리된 (~6.3cm) 스테레오 쌍으로 외삽하여 매력적인 3D 스테레오 효과가 있는 사진을 만들 수 있습니다.

또는 VR180 카메라로 캡처한 IPD로 분리된 스테레오 쌍을 가져 와서 길이가 0.5m인 선을 따라 전체 뷰 세트로 외삽하여 작은 범위의 머리 움직임으로 전체 시차를 가능하게 할 수 있습니다.

입력 뷰 쌍에서 이러한 뷰 외삽을 스테레오 배율이라고합니다.

위의 예에서는 기준선을 원래 기준선의 최대 약 8배까지 크게 확대했습니다.

스테레오 확대 문제는 어렵습니다.

여러 뷰를 고려하는 일반적인 뷰 보간 시나리오와 달리 입력으로 뷰가 두 개뿐입니다.

까다로운 장면을 반사와 투명도로 처리할 수 있기를 바랍니다.

마지막으로, 가려져서 어느 입력 뷰에서도 보이지 않는 픽셀을 렌더링할 수 있는 용량이 필요합니다.

이러한 문제를 해결하기 위해 우리의 접근 방식은 뷰 보간을 위한 딥러닝에 대한 최근 작업에 따라 많은 양의 시각적 데이터에서 뷰 외삽을 수행하는 방법을 배우는 것입니다 [Flynn et al. 2016; Kalantari et al. 2016].

그러나 우리의 접근 방식은 이전 작업과 주요 측면에서 다릅니다.

먼저, 각 출력 뷰를 개별적으로 예측해야 하는 이전 작업과 달리 한 쌍의 입력 뷰에서 한 번 예측한 다음 재사용하여 많은 출력 뷰를 예측할 수있는 장면 표현을 찾습니다.

둘째, 하나 또는 두 개의 입력 뷰에 숨겨진 표면을 효과적으로 캡처할 수 있는 표현이 필요합니다.

우리는 이러한 두 가지 속성을 모두 가진 다중 평면 이미지(MPI)라고 하는 계층화된 표현을 제안합니다.

마지막으로 작업과 일치하는 학습 데이터가 필요합니다.

단순히 스테레오 쌍을 수집하는 것만으로는 충분하지 않습니다, 왜냐하면 학습을 위해서는 입력 스테레오 쌍에서 약간 떨어진 추가 뷰가 ground-truth로 필요하기 때문입니다.

이러한 데이터에 대한 간단하고 놀라운 소스 (예 : YouTube의 온라인 비디오)를 제안하고 우리 작업에 적합한 대규모 데이터를 대규모로 채굴할 수 있음을 보여줍니다.

실험에서 우리는 최근 view synthesis 방법에 대한 접근 방식을 비교하고 여러 가지 ablation 연구를 수행합니다.

우리의 방법은 홀드 아웃 테스트 세트에서 더 나은 수치 성능을 달성하고 모든 대상 뷰를 합성하기 위해 추론된 장면 표현이 공유되기 때문에 공간적으로 더 안정적인 출력 이미지를 생성함을 보여줍니다.

또한 학습된 모델이 재학습 없이 다른 데이터 세트로 일반화되고 휴대폰 및 스테레오 카메라로 캡처한 스테레오 이미지의 좁은 기준선을 확대하는 데 효과적임을 보여줍니다.

간단히 말해, 우리의 기여는 다음과 같습니다:

• 스테레오 확대를 위한 학습 프레임 워크 (좁은 기준선 스테레오 이미지에서 외삽 뷰).

• 다중 평면 이미지, 뷰 합성을 수행하기 위한 새로운 장면 표현.

• 뷰 합성, 특히 뷰 외삽 학습을 위한 온라인 비디오의 새로운 사용.

2. Related Work

뷰 합성에 대한 고전적인 접근 방식.

뷰 합성 (즉, 하나 이상의 장면 뷰를 입력으로 취하고 새로운 뷰 생성)은 많은 이미지 기반 렌더링 시스템의 핵심을 형성하는 컴퓨터 그래픽의 고전적인 문제입니다.

많은 접근법이 보간 설정에 초점을 맞추고 조밀한 이미지에서 광선을 보간하여 작동합니다 ("라이트 필드 렌더링") [Gortler et al. 1996; Levoy and Hanrahan 1996] 또는 희소한 뷰에서 장면 지오메트리 재구성 [Debevec et al. 1996; Hedman et al. 2017; Zitnick et al. 2004].

이러한 방법은 고품질의 새로운 뷰를 생성하지만 해당 입력 픽셀/레이를 합성하여 수행하며 일반적으로 다중 (>2) 입력 뷰에서만 잘 작동합니다.

3D 스테레오 스코픽 비디오를 무안경 자동 다중 디스플레이에 적합한 멀티 뷰 비디오로 변환하는 것을 포함하여 스테레오 이미지로부터 뷰 합성도 고려되었습니다 [Chapiro et al. 2014; Didyk et al. 2013; Kellnhofer et al. 2017; Riechert et al. 2012]와 마이크로베이스 라인 스테레오 쌍에서 4D 광장 합성 [Zhang et al. 2015], 여러 개의 작은 기준선 뷰에서 기하학을 재구성하는 일반화 [Ha et al. 2016; Yu and Gallup 2014].

스테레오 이미지에도 초점을 맞추고 있지만 우리가 제시하는 기술은 단일 뷰 및 다중 뷰 설정에도 적용할 수 있습니다.

또한 이전 작업보다 훨씬 더 큰 외삽을 목표로합니다.

학습 기반 뷰 합성.

최근에는 연구자들이 합성을 뷰 위해 강력한 딥러닝 기술을 적용했습니다.

뷰 합성은 많은 장면의 이미지를 캡처하고, 각 장면의 일부 뷰를 Ground Truth로 보류하고, 하나 이상의 주어진 뷰에서 누락된 뷰를 예측하는 모델을 훈련하고, 이러한 예측 뷰를 비교함으로써 자연스럽게 학습 문제로 공식화될 수 있습니다. 학습이 최적화를 추구하는 손실 또는 목표와 같은 사실에 근거합니다.

최근 연구에서는 뷰 합성 학습을 위한 여러 심층 네트워크 아키텍처, 장면 표현 및 응용 시나리오를 탐색했습니다.

Flynn et al. [2016]은 입력 이미지 세트에서 체적 표현을 예측하고 거리 장면 이미지를 사용하여 모델을 훈련시키는 DeepStereo라는 뷰 보간 방법을 제안했습니다.

Kalantari et al. [2016] Lytro 카메라로 캡처한 라이트 필드 사진 [Lytro 2018]을 대상 보간 시점에 대한 컬러 이미지를 예측하기 위한 트레이닝 데이터로 사용합니다.

이 두 가지 방법 모두 대상 뷰의 좌표계에서 표현을 예측합니다.

따라서 이러한 방법은 원하는 각 대상 뷰에 대해 훈련된 네트워크를 실행해야 하므로 실시간 렌더링이 어렵습니다.

우리의 방법은 장면 표현을 한 번 예측하고 이를 재사용하여 다양한 출력 뷰를 실시간으로 렌더링합니다.

또한 이러한 이전 방법은 우리처럼 외삽보다는 보간에 중점을 둡니다.

다른 최근 연구에서는 스테레오 쌍을 합성하는 문제를 조사했습니다 [Xie et al. 2016], 큰 카메라 움직임 [Zhou et al. 2016] 또는 라이트 필드 [Srinivasan et al. 2017] 극단적인 외삽 형태인 단일 이미지에서.

우리의 작업은 점점 더 일반적으로 사용되는 좁은 기준선 스테레오 쌍의 시나리오에 중점을 둡니다.

이 뷰 시나리오는 잠재적으로 단일 뷰 시나리오보다 더 다양한 장면과 더 큰 외삽에 대한 일반화를 허용합니다.

예를 들어, Srinivasan 등의 최근 단일 뷰 방법은 꽃의 매크로 샷과 같은 비교적 동질적인 데이터 세트만 고려하고 Lytro 카메라의 작은 기준선까지 외삽하는 반면, 우리의 방법은 다양한 세트에서 작동할 수 있습니다, VR 헤드셋에서 약간의 머리 움직임을 허용하기에 충분한 전망을 추정합니다.

마지막으로, 컴퓨터 비전의 다양한 작업은 하나 이상의 이미지에서 깊이, 모양 또는 광학 흐름을 예측하는 것과 같은 다른 작업에 대한 간접적 형태의 감독으로 뷰 합성을 사용했습니다 [Garg and Reid 2016; Godard et al. 2017; Liu et al. 2017; Tulsiani et al. 2017; Vijayanarasimhan et al. 2017; Zhou et al. 2017].

그러나 뷰 합성은 그러한 작업의 명시적인 목표가 아닙니다.

뷰 합성을 위한 장면 표현.

뷰 합성 작업에서 장면을 모델링하기 위해 다양한 장면 표현이 제안되었습니다.

우리는 한 번 예측한 다음 런타임에 여러 뷰를 렌더링하는 데 재사용할 수 있는 표현에 가장 관심이 있습니다.

이러한 기능을 달성하기 위해 표현은 종종 체적이거나 다른 형태의 레이어링을 포함합니다.

예를 들어, 계층화된 깊이 이미지(LDI)는 여러 계층의 깊이 맵과 관련 색상 값을 사용하여 장면을 나타내는 깊이 맵의 일반화입니다 [Shade et al. 1998].

이러한 레이어를 통해 사용자는 뒤에 있는 가려진 오브젝트의 전경 지오메트리를 "둘러 볼" 수 있습니다.

Zitnick et al.은 입력 별 이미지 깊이 맵을 사용하여 장면을 표현하지만 고품질 보간을 달성하기 위해 깊이 불연속성 주변의 알파 매트 레이어를 해결합니다 [2004].

아마도 우리의 표현에 가장 가까운 것은 Penner와 Zhang [2017]의 표현일 것입니다.

그들은 명시적으로 자신감을 모델링하여 부드러움을 얻는 반면, 우리는 다른 합성 및 렌더링 방법으로 이어지는 투명성을 모델링합니다.

또한 장면의 하나의 표현을 구축하는 반면, 각 입력 뷰에 대한 표현을 생성한 다음 그 사이를 보간합니다.

우리의 표현은 또한 Wang과 Adelson [1994]의 움직이는 이미지 시퀀스를 인코딩 하기 위한 고전적인 계층 표현과 Wetzstein 등 [2011]의 계층형 감쇠기와 관련이 있습니다, 실제 물리적으로 인쇄된 투명 필름을 사용하여 라이트 필드 디스플레이를 구성합니다.

마지막으로 Holroyd et al [2011]은 우리와 비슷한 표현을 하지만 물리적인 형태를 탐구합니다.

우리가 사용하는 다중 평면 이미지 (MPI) 표현은 경계 또는 반사/투명 물체 주변의 혼합 픽셀을 표현하기 위한 다중 레이어 처리 및 레이어링의 "부드러움"을 포함하여 이전 방법의 여러 매력적인 속성을 결합합니다.

결정적으로 우리는 딥 네트워크를 통한 학습에도 적합하다는 것을 알았습니다.

3. Approach

알려진 카메라 매개 변수가 있는 두 개의 이미지 I1 및 I2가 주어지면 우리의 목표는 동일한 장면의 새로운 뷰를 합성하고 특히 입력 뷰를 넘어서 추정하는데 적합한 전역 장면 표현을 추론하기 위해 심층 신경망을 학습하는 것입니다.

이 섹션에서는 먼저 장면 표현과 그 특성을 설명한 다음 이러한 표현을 예측하는 학습을 위한 파이프 라인과 목표를 제시합니다.

이 논문에서는 스테레오 입력에 초점을 맞추고 있지만 우리의 접근 방식은 단일 또는 다중 입력 뷰를 사용하는 보다 일반적인 뷰 합성 설정에 적용할 수 있습니다.

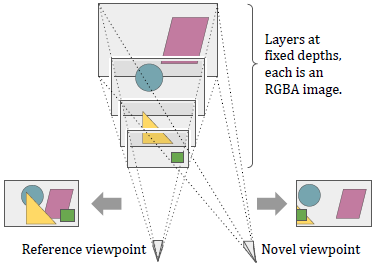

3.1. Multiplane image representation

우리가 채택한 글로벌 장면 표현은 기준 좌표 프레임에 대해 고정된 depth 범위에 있는 정면 평행 평면 세트입니다, 여기서 각 평면 d는 RGB 컬러 이미지 C_d와 알파/투명도 맵 α_d를 인코딩합니다.

다중 평면 이미지(MPI)라고 하는 우리의 표현은 이러한 RGBA 레이어 {(C_1, α_1),. . . , (C_D, α_D)}, 여기서 D는 depth 평면의 수입니다.

MPI는 Shade et al. [Shade et al. 1998]의 LDI (Layered Depth Image) 표현과 관련이 있습니다, 그러나 우리의 경우 각 레이어의 픽셀은 특정 depth로 고정되어 있으며 레이어 당 알파 채널을 사용하여 가시성을 인코딩합니다.

MPI에서 렌더링하기 위해 레이어는 표준 "오버" 알파 합성 작업을 사용하여 뒤에서 앞 순서로 구성됩니다.

그림 2는 MPI를 보여줍니다.

MPI 표현은 DeepStereo에서 사용되는 "selection-plus-color" 레이어와도 관련이 있습니다 [Flynn et al. 2016], Penner와 Zhang [2017]의 체적 표현에도 적용됩니다.

MPI는 가려진 요소를 포함한 지오메트리와 텍스처를 표현하는 능력과 알파를 사용하여 부분적으로 반사되거나 투명한 물체를 캡처하고 부드러운 가장자리를 처리 할 수 있기 때문에 MPI를 선택했습니다.

평면 수를 늘리면 (우리가 불일치 공간에서 해상도를 높이는 것으로 생각할 수 있음) MPI가 더 넓은 범위의 depth를 나타낼 수 있고 더 많은 카메라 움직임을 허용합니다.

또한 MPI에서 뷰를 렌더링하는 것은 매우 효율적이며 실시간 응용 프로그램을 허용할 수 있습니다.

우리의 표현은 Walt Disney Studios에서 발명되고 전통적인 애니메이션에 사용된 다중 비행기 카메라를 상기합니다 [Wikipedia 2017].

두 시스템 모두에서 장면은 카메라에서 서로 다른 거리에 있는 부분적으로 투명한 일련의 레이어로 구성됩니다.

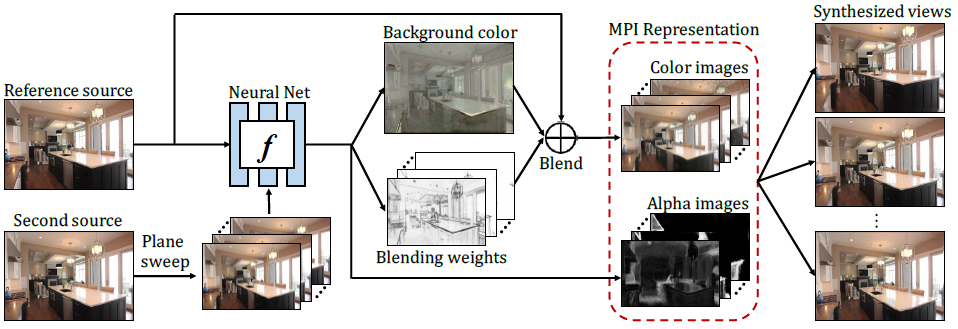

3.2. Learning from stereo pairs

이제 스테레오 쌍에서 MPI를 추론하는 신경망을 학습하기 위한 파이프 라인 (그림 3 참조)을 설명합니다.

입력 이미지 I_1 및 I_2 외에도 해당 카메라 매개 변수 c_1=(p_1, k_1) 및 c_2=(p_2, k_2)를 입력으로 사용합니다.

예측된 장면의 기준 좌표 프레임은 첫 번째 입력 이미지 I_1의 카메라 중심에 배치됩니다(즉, p_1이 동일 포즈로 고정됨).

학습 세트는 ⟨I_1, I_2, I_t, c_1, c_2, c_t⟩ 튜플의 큰 세트로 구성되며, 여기서 I_t 및 c_t=(p_t, k_t)는 각각 대상 GroundTruth 이미지와 카메라 매개 변수를 나타냅니다.

⟨I_1, I_2, c_1, c_2⟩를 입력으로 사용하여 MPI 표현을 추론하는 f_θ(·)로 표시되는 신경망을 학습하는 것을 목표로합니다, 그러면 MPI가 c_t에서 렌더링될 때 대상 이미지 I_t을 재구성 해야합니다.

Network input.

두 번째 입력 이미지 I_2에서 포즈 정보를 인코딩하기 위해 D 고정 depth 평면 세트에서 I_2를 참조 카메라로 재투영하는 평면 스위프 볼륨(PSV)을 계산합니다.

필수는 아니지만 출력 MPI의 depth 평면과 일치하도록 이러한 depth 평면을 선택합니다.

이 평면 스윕 계산은 재투영된 이미지 스택 {^I_2^1,. . . , ^I_2^D}, 색상 채널을 따라 연결하여 H×W×3D 텐서 I_2^가 됩니다.

네트워크에 대한 입력 텐서 (크기 H×W×3(D+1))를 얻기 위해 I_2^를 I_1과 더 연결합니다.

직관적으로 PSV 표현을 통해 네트워크는 I_1을 I_2의 각 평면 재투영과 간단히 비교하여 장면 지오메트리를 추론할 수 있습니다, 특정 픽셀의 장면 depth는 일반적으로 I_1과 재투영된 I_2가 일치하는 depth 평면에 있습니다.

많은 스테레오 알고리즘이 이 원리로 작동하지만 여기서는 네트워크가 뷰 합성 목표를 통해 이러한 관계를 자동으로 학습하도록 합니다.

Network Output.

네트워크 출력의 직접적인 선택은 각 depth 평면에 대한 별도의 RGBA 이미지입니다, 여기서 컬러 이미지는 장면 모양을 캡처하고 알파 맵은 가시성과 투명도를 인코딩합니다.

그러나 그러한 산출물은 매우 과도하게 매개 변수화 될 것이며 우리는 더 간결한 산출물이 유익하다는 것을 발견했습니다.

특히, 장면의 색상 정보는 전경 이미지와 배경 이미지 두 개로 잘 모델링 될 수 있다고 가정합니다, 전경 이미지는 단순히 참조 소스 I_1이고 배경 이미지는 네트워크에 의해 예측되며 숨겨진 표면의 모양을 포착하기 위한 것입니다.

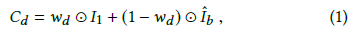

따라서 각 depth 평면에 대해 각 RGB 이미지 C_d를 전경 이미지 I_1 및 예측된 배경 이미지의 픽셀 당 가중 평균으로 계산합니다. ^I_b :

여기서 ⊙는 Hadamard 곱을 나타내며 혼합 가중치 w_d도 네트워크에 의해 예측됩니다.

직관적으로 I_1은 전경 콘텐츠가 지배적인 더 가까운 평면에서 더 높은 가중치를 갖는 반면, ^I_b는 참조 뷰에서 가려진 표면을 캡처하도록 설계되었습니다.

네트워크가 알파 및 블렌딩 가중치를 활용하여 다른 depth에서 다른 부분을 선택적으로 부드럽게 사용할 수 있으므로 배경 이미지 자체가 자연 이미지일 필요는 없습니다.

실제로, 새로운 뷰에서 사용되지 않는 특정 배경 이미지의 영역이 있을 수 있습니다.

요약하면 네트워크는 다음 수량을 출력합니다.

1) 각 평면에 대한 알파 맵 α_d,

2) 글로벌 RGB 배경 이미지 ^I_b 및

3) 각 픽셀에서 전경 레이어와 배경 레이어의 상대적인 비율을 나타내는 각 평면에 대한 블렌딩 가중치 이미지 w_d.

해상도가 W×H 인 D depth 레이어를 각각 예측하면 총 출력 매개 변수 수는 WH·(2D+3) (vs. MPI를 직접 예측하는 경우 WH·4D)입니다.

그런 다음 이러한 수량을 MPI로 변환할 수 있습니다.

3.3. Differentiable view synthesis using MPIs

참조 프레임에 대한 MPI 표현이 주어지면 각 평면의 RGBA 이미지에 평면 변환(역 호모 그래피)을 적용한 다음 변환된 이미지를 단일 이미지로 알파 구성하여 새로운 뷰 It^을 합성 할 수 있습니다, 앞뒤 순서로.

평면 변환과 알파 구성은 모두 구분할 수 있으며 나머지 학습 파이프 라인에 쉽게 통합할 수 있습니다.

Planar transformation.

여기에서는 각 MPI RGBA 평면을 대상 시점으로 반전시키는 평면 변환을 설명합니다.

변환할 MPI 평면(즉, 소스)의 형상을 n·x+a=0으로 설정합니다, 여기서 n은 평면 법선을 나타내고 x=[us, vs, 1]^T는 소스 픽셀 동종 좌표, a 평면 오프셋.

소스 MPI 평면은 기준 소스 카메라와 정면 평행하므로 n=[0, 0, 1] 및 a=-ds이며, 여기서 ds는 소스 MPI 평면의 깊이입니다.

소스에서 대상 카메라로의 리지드 3D 변환 매트릭스 매핑은 3D 회전 R 및 변환 t로 정의되며 소스 및 대상 카메라 내장 함수는 각각 ks 및 kt로 표시됩니다.

그런 다음 대상 MPI 평면의 각 픽셀 (ut, vt)에 대해 표준 역 호모 그래피 [Hartley and Zisserman 2003]를 사용하여

를 얻습니다.

따라서 소스 이미지에서 대응 [us, vs]를 검색하여 각 대상 픽셀 [ut, vt]에 대한 색상 및 알파 값을 얻을 수 있습니다.

[us, vs]는 정확한 픽셀 좌표가 아닐 수 있으므로 4 그리드 이웃 사이의 쌍 선형 보간을 사용하여 리샘플링된 값을 얻습니다 ([Jaderberg et al. 2015; Zhou et al. 2016] 참조).

Alpha compositing.

각 MPI 평면에 평면 변환을 적용한 후 표준 오버 연산을 사용하여 컬러 이미지를 뒤에서 앞 순서로 알파 합성하여 예측 대상 뷰를 얻습니다 [Porter and Duff 1984].

3.4. Objective

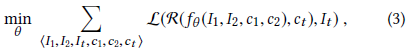

MPI 추론 및 렌더링 파이프 라인이 주어지면 뷰 합성 목표를 충족하는 MPI를 예측하도록 네트워크를 훈련시킬 수 있습니다.

공식적으로 ⟨I1, I2, It, c1, c2, ct⟩ 튜플의 훈련 세트에 대해 다음과 같이 네트워크 매개 변수를 최적화합니다:

여기서 R(·)은 추론된 MPI fθ(I1, I2, c1, c2)를 사용하여 대상 카메라 ct에서 새로운 뷰를 합성하는 3.3 절에 설명된 렌더링 파이프 라인을 나타내고 L(·)은 합성된 사이의 손실 함수의 뷰와 GroundTruth입니다.

이 작업에서는 심층 특성 일치 손실 ("지각 손실"이라고도 함 [Dosovitskiy and Brox 2016; Johnson et al. 2016; Zhang et al. 2018])을 사용하고 특히 정규화된 VGG-19 [Simonyan and Zisserman 2014] [Chen and Koltun 2017]의 레이어 일치 :

여기서 {ϕl}은 VGG-19의 레이어 집합 (conv1_2, conv2_2, conv3_2, conv4_2 및 conv5_2)이고 가중치 하이퍼 파라미터 {λl}은 각 레이어의 뉴런 수의 역으로 설정됩니다.

3.5. Implementation details

달리 명시하지 않는 한, 우리는 각각 1m 및 100m에서 근거리 및 원거리 평면과 함께 등거리 거리 (역 깊이)로 설정된 D=32 평면을 사용합니다.

Network architecture.

완전한 컨볼루션 인코더-디코더 아키텍처를 사용합니다 (자세한 사양은 표 1 참조).

인코더 경로는 VGG-19 [Simonyan and Zisserman 2014]와 유사한 설계를 따르며 디코더는 미세한 텍스처 세부 사항을 캡처하기 위해 하위 레이어에서 건너뛰기 연결을 사용하는 deconvolution (분수 분할 회선) 레이어로 구성됩니다.

확장된 회선[Chen et al. 2018; Yu and Koltun 2016]은 또한 중간 레이어 conv4_1,2,3에서 피쳐 맵의 공간 해상도를 유지하면서 더 큰 장면 컨텍스트를 모델링하는데 사용됩니다.

각 계층 다음에는 ReLU 비선형성 및 계층 정규화 [Ba et al. 2016] 마지막 레이어를 제외하고 tanh가 사용되고 레이어 정규화가 적용되지 않습니다.

각각의 마지막 레이어 출력 (32개의 알파 이미지, 32개의 블렌딩 가중치 이미지, 1개의 배경 RGB 이미지)은 해당 유효 범위 (예 : 알파 이미지의 경우 [0, 1])와 일치하도록 추가로 조정됩니다.

Training details.

우리는 TensorFlow에서 시스템을 구현합니다 [Abadi et al. 2016].

학습률 0.0002, β1=0.9, β2=0.999, 배치 크기 1의 600K 반복에 대해 ADAM 솔버 [Kingma and Ba 2014]를 사용하여 네트워크를 훈련시킵니다.

훈련 중에 이미지와 MPI는 1024×576의 공간 해상도를 갖지만 테스트시 임의의 해상도에 모델을 완전 컨볼루션 방식으로 적용할 수 있습니다.

Tesla P100 GPU에서 훈련하는데 약 1주가 걸립니다.

4. Data

훈련을 위해서는 상대적인 카메라 포즈 및 내장 기능과 함께 3장의 이미지가 필요합니다.

이러한 데이터 세트를 처음부터 만들려면 장면 당 3개 이상의 적절한 시점에서 다양한 장면의 동시 사진을 신중하게 캡처해야 합니다.

대신, 우리는 그러한 데이터의 기존 소스를 확인했습니다. 즉, 움직이는 카메라에서 촬영한 YouTube의 비디오 클립입니다.

이러한 비디오에서 프레임을 샘플링하면 다양한 기준선에서 촬영한 동일한 장면의 여러 뷰로 구성된 매우 많은 양의 데이터를 얻을 수 있습니다.

이 접근 방식이 작동하려면 움직이는 카메라에서 촬영되었지만 정적 장면에서 모션 블러 또는 롤링 셔터 왜곡과 같은 최소한의 아티팩트를 사용하고 제목과 오버레이 같은 다른 편집 효과 없이 적절한 비디오 클립을 식별할 수 있어야합니다.

마지막으로 적절한 클립이 주어지면 각 프레임에 대한 카메라 매개 변수를 추정해야 합니다.

YouTube의 많은 비디오는 우리의 목적에 유용하지 않지만 여러 비디오 카테고리에서 놀랍도록 많은 양의 적합한 콘텐츠를 발견했습니다.

그러한 카테고리 중 하나는 RealEstate 영상입니다.

일반적인 RealEstate 동영상에는 실내 및 실외 장면 (방 또는 계단의 내부, 집의 외부 뷰, 주변 지역의 장면 등)의 일련의 샷이 포함됩니다.

샷은 일반적으로 부드러운 카메라 움직임과 장면 움직임이 거의 또는 전혀 없습니다.

따라서 우리는 다중 뷰 학습 이미지의 크고 다양한 소스로 RealEstate 비디오에서 데이터 세트를 구축하기로 결정했습니다.

따라서 이 섹션의 나머지 부분에서는 시퀀스의 각 프레임에 대한 카메라 위치, 방향 및 시야와 함께 1~10초 길이의 7,000개 이상의 비디오 클립으로 구성된 데이터 세트를 설명합니다.

이 데이터 세트를 구축하기 위해 YouTube에서 적합한 클립을 채굴하기 위한 파이프 라인을 고안했습니다.

이 파이프 라인은 네 가지 주요 단계로 구성됩니다.

1) 다운로드할 후보 동영상 세트 식별,

2) 각 비디오에서 카메라 추적기를 실행하여 각 프레임의 초기 카메라 포즈를 추정하고 비디오를 별개의 샷/클립으로 세분화합니다.

3) 전체 번들 조정을 수행하여 각 클립에 대해 고품질 포즈를 도출합니다.

4) 나머지 부적합한 클립을 제거하기 위한 필터링.

4.1. Identifying videos

RealEstate 동영상을 독점적으로 또는 거의 독점적으로 게시한 여러 YouTube 채널을 수동으로 찾고 YouTube API를 사용하여 각 채널에 나열된 동영상 ID를 검색했습니다.

이를 통해 약 1,500개의 후보 동영상 세트가 생성되었습니다.

4.2. Identifying and tracking clips with SLAM

각 비디오를 개별 클립으로 세분화하고 중요한 카메라 동작이 있는 클립을 식별하려고합니다.

우리는 야생에서 임의의 비디오에 대한 카메라 추적을 수행하기 위해 쉽게 사용할 수 있는 도구를 거의 찾지 못했습니다.

처음에 우리는 Colmap [Schönberger and Frahm 2016]과 같이 컴퓨터 비전에서 개발된 움직임으로부터의 구조 방법을 사용하려고 했습니다.

이러한 방법은 사진 컬렉션에 최적화되어 있으며 비디오 시퀀스에 적용할 때 속도가 느리고 실패하기 쉬운 것으로 나타났습니다.

대신 우리는 로봇 커뮤니티에서 개발된 SLAM(Simultaneous Localization and Mapping)을 위한 최신 알고리즘을 우리의 목적에 맞게 조정할 수 있음을 발견했습니다.

Visual SLAM 방법은 일련의 프레임을 입력으로 취하고 이 재구성과 일치하는 방식으로 현재 프레임의 관점을 추정하면서 장면의 희소 또는 반 밀도 3D 재구성을 구축하고 유지합니다.

우리는 ORB-SLAM2 시스템을 사용합니다 [Mur-Artal and Tardós 2015], 다른 방법도 적용할 수 있습니다 [Engel et al. 2018; Forster et al. 2014].

SLAM 알고리즘은 컷과 디졸브가 있는 여러 샷이 포함된 비디오를 처리하도록 설계되지 않았으며, 일반적으로 현재 프레임 포즈의 정확성에만 관심이 있습니다 - 특히 장면이 시간이 지남에 따라 다듬어지기 때문에 이전 프레임은 업데이트되지 않으며 세상의 현재 상태와 일치하지 않게 됩니다.

이러한 문제를 해결하기 위해 우리의 접근 방식은 다음과 같습니다.

1. 비디오의 연속 프레임을 정상적으로 ORB-SLAM2에 공급합니다.

2. 알고리즘이 카메라 추적을 시작했다고 보고하면 클립의 시작을 표시합니다.

3. ORB-SLAM2가 K=6개의 연속 프레임을 추적하지 못하거나 최대 시퀀스 길이 L에 도달하면 클립이 종료된 것으로 간주합니다.

4. 최종 장면 모델을 일정하게 유지하고 클립의 모든 프레임을 다시 처리하여 각 카메라에 대해 일관된 포즈를 추정합니다.

5. ORB-SLAM2를 다시 초기화하여 후속 프레임에서 새 클립 추적을 시작할 준비를 합니다.

이러한 방식으로 ORBSLAM2를 사용하여 프레임을 추적할 뿐만 아니라 샷 경계를 감지하는 방법으로 추적 실패를 사용하여 비디오를 클립으로 분할합니다.

ORB-SLAM2를 포함한 SLAM 방법에는 시야(임의의 온라인 비디오에서는 알 수 없음)와 같은 알려진 카메라 내장 기능이 필요하기 때문에 우리는 단순히 시야를 90도라고 가정합니다.

이 가정은 좋은 클립을 식별하기 위해 놀랍게도 잘 작동했습니다.

마지막으로 속도를 위해 이 단계에서는 저해상도 버전의 비디오를 처리합니다.

위 처리의 결과는 예비 카메라 매개 변수 세트와 함께 각 비디오에 대한 클립 또는 시퀀스 세트입니다.

4.3. Refining poses with bundle adjustment

다음으로 표준 구조-모션 파이프 라인을 사용하여 각 시퀀스를 더 높은 해상도로 처리하여 각 프레임에서 특징을 추출하고, 이러한 특징을 프레임 간에 일치시키고, Ceres 비선형 최소 제곱 최적화 프로그램을 사용하여 전역 번들 조정을 수행합니다 [Agarwal et al . 2016].

ORB-SLAM2에서 찾은 포즈를 사용하여 카메라를 초기화하고 매개 변수가 초기 값에서 너무 멀어지지 않도록 하는 최적화에 약한 패널티를 추가합니다.

각 시퀀스의 출력은 조정된 카메라 포즈 세트, 예상 시야각 및 장면을 나타내는 희소점 구름입니다.

출력 예는 그림 4에 나와 있습니다.

이 프로세스의 한 가지 어려움은 글로벌 씬 스케일을 결정할 수 있는 방법이 없으므로 재구성된 카메라 포즈가 클립 당 임의의 스케일에 달한다는 것입니다.

3.5절에 설명된 것처럼 표현이 특정 깊이의 레이어를 기반으로 하기 때문에 MPI로 장면을 표현할 때 이러한 모호성이 중요해집니다.

따라서 추정된 3D 포인트 클라우드를 사용하여 각 시퀀스를 "스케일-정규화"하여 가장 가까운 장면 지오메트리가 카메라에서 대략 고정된 거리가 되도록 스케일링합니다.

특히 각 프레임에 대해 해당 프레임 카메라의 모든 포인트 깊이 중에서 5번째 백분위 수 깊이를 계산합니다.

시퀀스의 모든 카메라에서 이 깊이를 계산하면 "근접 평면" 깊이 세트가 제공됩니다.

이 수심 세트의 10번째 백분위 수가 1.25m가 되도록 시퀀스의 크기를 조정합니다. (우리의 MPI 표현은 1m의 근거리 평면을 사용합니다.)

4.4. Filtering and clipping

소스 비디오에 크로스 페이드가 포함된 경우 일부 프레임에 두 장면이 혼합되어 표시될 수 있습니다.

각 클립의 시작과 끝에서 10개의 프레임을 삭제하여 대부분의 이러한 프레임을 제거합니다.

때때로 시퀀스에 대한 예상 카메라 포즈가 부드러운 트랙을 형성하지 않아 카메라를 정확하게 추적할 수 없음을 나타낼 수 있습니다.

카메라 위치 pi가 인접한 두 카메라 위치의 평균에 충분히 가까우면 프레임을 매끄럽게 정의합니다, 특히 ∥pi-(pi+1+pi-1)/2∥<0.2×∥pi+1pi-1∥.

각 시퀀스에 대해 모든 프레임이 매끄러운 가장 긴 연속 하위 시퀀스를 찾고 나머지는 버립니다.

마지막으로 30 프레임 미만의 나머지 시퀀스를 모두 버립니다.

약 1500개의 비디오 입력 세트에서이 파이프 라인은 총 ~750K 프레임으로 ~7,000개의 시퀀스 세트를 생성합니다.

4.5. Choosing training triplets

그림 4는 입력 비디오 프레임 [a] (여기에는 두 개의 프레임만 표시됨)과 모션 파이프 라인의 구조에서 생성된 스파스 포인트 클라우드 [b] 및 카메라 트랙 [c]을 포함하여 이 처리 결과의 예를 보여줍니다.

섹션 3.2에 설명된 대로, 우리의 애플리케이션에는 I1과 I2로부터의 외삽인 경우를 포함하여 튜플 ⟨I1, I2, It, c1, c2, ct⟩가 필요합니다.

먼저 각 시퀀스에서 길이가 10인 임의의 하위 시퀀스 [d]를 선택하여 데이터 세트에서 튜플을 샘플링하고, 스트라이드 (선택한 프레임 간 간격)는 1부터 10까지 임의로 선택합니다.

이 하위 시퀀스에서 두 개의 서로 다른 프레임과 포즈를 입력 I1, I2, c1 및 c2 [e]로 선택하고 세 번째 프레임을 대상 It, ct로 선택합니다.

선택한 프레임에 따라 대상 프레임은 입력에서 외삽 [f] (I1과 I2 사이 거리의 최대 9배까지) 또는 입력에서 보간 [g]이 필요할 수 있습니다.

훈련 중에 특정 거리에서 이미지를 생성하는데 과도하게 맞추지 않도록 소스 이미지와 관련된 다양한 위치에서 뷰를 예측하는 방법을 선택했습니다.

5. Experiments and Results

이 섹션에서는 방법의 성능을 평가하고 여러 뷰 합성 기준선과 비교합니다.

테스트 세트는 훈련 세트와 겹치지 않는 1,329개의 시퀀스로 구성됩니다.

각 시퀀스에 대해 평가를 위해 삼중항 (소스 프레임 2개와 대상 프레임 1개)을 무작위로 샘플링합니다.

먼저 모델에서 추론한 MPI 표현을 시각화한 다음 다른 최근 뷰 합성 방법과의 자세한 비교를 제공합니다.

우리는 다양한 절제 연구를 통해 모델 설계를 추가로 검증하고 마지막으로 여러 응용 프로그램을 통해 방법의 유용성을 강조합니다.

정량적 평가를 위해 표준 SSIM 및 PSNR 메트릭을 사용합니다 [Wang et al. 2004].

5.1. Visualizing the multiple images

그림 5에서 네트워크에서 추론한 MPI 표현의 예를 시각화합니다.

훈련 중 각 MPI 평면에 대한 직접적인 색상이나 알파 근거가 없음에도 불구하고, 추론된 MPI는 장면 지오메트리를 고려하여 레이어 방식(가까운 곳에서 멀리)으로 장면 모양을 캡처할 수 있습니다, 표현에서 참신한 뷰를 사실적으로 렌더링 할 수 있습니다.

또한 등록된 비디오 시퀀스의 중앙 두 프레임을 입력으로 사용하고 추론된 MPI를 사용하여 이전 및 미래 프레임을 합성하는 그림 6에서 MPI 표현의 뷰 외삽 기능을 보여줍니다.

이러한 렌더링된 시퀀스의 애니메이션에 대한 추가 비디오를 참조하십시오.

5.2. Comparision with Kalantari et al.

우리는 우리의 모델을 Kalantari et al. [2016], 최첨단 학습 기반 뷰 합성 방법.

우리의 방법에 비해 중요한 차이점은 Kalantari et al. 씬의 각 새로운 뷰에 대해 독립적인 렌더링 프로세스가 있으며, 새 뷰가 쿼리될 때마다 전체 추론 파이프 라인을 다시 실행해야합니다, 이는 실시간 애플리케이션에서 계산적으로 금지됩니다.

대조적으로, 우리의 방법은 최소한의 계산 (역 호모 그래피+알파 합성)으로 모든 새로운 관점을 실시간으로 렌더링할 수 있는 장면 레벨 MPI 표현을 예측합니다.

우리는 데이터에 대해 두 가지 방법의 변형을 훈련하고 테스트합니다.

1) 동일한 네트워크 아키텍처 (4개의 컨볼루션 레이어) 및 원본 논문의 픽셀 재구성 손실;

2) 지각 손실이 있는 네트워크 아키텍처 (연결 건너 뛰기가 더 깊음).

공정한 비교를 위해 입력에서 평면 스위프 볼륨을 구성하기 위해 입력 평면과 동일한 수의 입력 평면을 사용합니다.

다양한 깊이 평면 수의 효과에 대한 논의는 섹션 5.4를 참조하십시오.

표 2는 테스트 세트에서 각 방법에 대한 평균 SSIM 및 PSNR 유사성 메트릭을 보여줍니다.

한 방법이 다른 방법보다 일관되게 우수한지 측정하기 위해 각 검정 삼중항에 대한 방법의 순위를 매기고 각 방법의 평균 순위를 계산합니다.

예를 들어 PSNR의 평균 순위가 1.0이면 이 방법이 항상 PSNR 점수가 가장 높음을 의미합니다.

우리는

1) 네트워크 아키텍처는 원래 Kalantari 논문에서 사용된 단순한 4계층 네트워크보다 훨씬 더 효과적입니다.

2) VGG 지각 손실은 픽셀 재구성 손실에 대한 성능을 개선하는 데 도움이됩니다 (설명은 섹션 5.4 참조).

3) 우리 모델은 두 가지 Kalantari 변형 (네트워크 아키텍처의 VGG) 중 더 나은 성능을 발휘하여 MPI 표현에서 렌더링 된 새로운 뷰의 고품질을 나타냅니다.

또한 동일한 장면의 연속 뷰 시퀀스를 렌더링할 때 결과가 Kalantari보다 공간적으로 일관되고 프레임 간 아티팩트가 더 적게 생성되는 경향이 있습니다.

우리는 Kalantari 모델과 달리 모든 대상 뷰를 렌더링하기 위해 공유되는 단일 장면 수준 MPI 표현을 추론하여 주변 뷰를 렌더링할 때 암시적으로 부드러움을 부과하기 때문이라고 가정합니다.

렌더링된 시퀀스에서 Kalantari에 대한 방법의 질적 비교는 비디오를 참조하십시오.

5.3. Comparison with extrapolation methods

우리는 Zhang et al의 비 학습 관점 외삽 접근법과 비교합니다 [2015], 이는 DAPS (disparity-assisted phase based synthesis)를 사용하여 마이크로베이스 라인 스테레오 쌍에서 4D 광장을 재구성합니다.

공정한 비교를 위해 RealEstate 데이터에 대해 훈련된 모델을 HCI 라이트 필드 데이터 세트에 직접 적용합니다 [Wanner et al. 2013].

그림 7에서 볼 수 있듯이 우리의 모델은 미세 조정없이 HCI 데이터 세트에서 잘 일반화되며 Zhang et al. 우리의 방법이 왜곡 아티팩트를 덜 도입하는 깊이 경계 주변.

우리는 Zhang et al. 작은 뷰 외삽에서는 잘 수행되지만 외삽 거리가 증가함에 따라 객체 경계 주변에서 더 빠르게 분해됩니다.

우리는 또한 외모 흐름을 훈련 시켰습니다 [Zhou et al. 2016] 데이터 셋에 있지만 렌더링된 뷰는 왜곡되는 직선과 같은 중요한 아티팩트를 나타냈습니다.

이 방법은 장면 렌더링보다 객체 중심 합성에 더 적합하며 훈련된 네트워크가 각 입력 이미지에서 개별적으로 작동하기 때문에 뷰 간의 상관 관계를 완전히 활용할 수 없습니다.

5.4. Ablation studies

Perceptual loss.

지각 손실의 효과를 설명하기 위해 최종 모델을 RGB 픽셀 공간에서 L1 손실을 사용하여 훈련된 기준 모델과 비교합니다.

그림 8에서 볼 수 있듯이 지각 손실을 사용하여 훈련된 최종 모델은 기준선보다 합성된 결과에서 객체 구조 및 텍스처 세부 사항을 더 잘 보존합니다.

지각 손실이 있는 훈련의 이점은 표 2의 정량적 평가를 통해 추가로 확인됩니다.

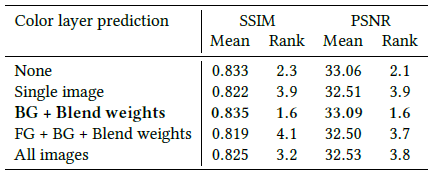

Color layer prediction.

섹션 3.2에서는 네트워크가 예측한 "배경"이미지와 참조 소스 이미지의 가중 평균으로 각 MPI 평면에 대한 색상 값을 생성할 것을 제안합니다.

여기에서 색상 예측 형식의 여러 변형을 비교합니다 (표현 유연성 수준을 높이는 순서):

(1) 없음. 네트워크는 컬러 이미지나 혼합 가중치를 예측하지 않습니다. 참조 소스 이미지는 각 MPI 평면에서 컬러 이미지로 사용됩니다.

(2) 단일 이미지. 네트워크는 모든 MPI 평면에 대해 공유되는 단일 색상 이미지를 예측합니다.

(3) 배경+혼합 가중치 (우리가 선호하는 형식). 네트워크는 배경 이미지와 혼합 가중치를 예측합니다. 참조 소스는 전경 이미지로 사용됩니다.

(4) 전경+배경+가중치 혼합. 이전 변형과 달리 참조 소스를 전경 이미지로 사용하는 대신 네트워크는 배경과 혼합할 추가 전경 이미지를 예측합니다.

(5) 모든 이미지. 네트워크는 각 MPI 평면에서 컬러 이미지를 직접 출력합니다.

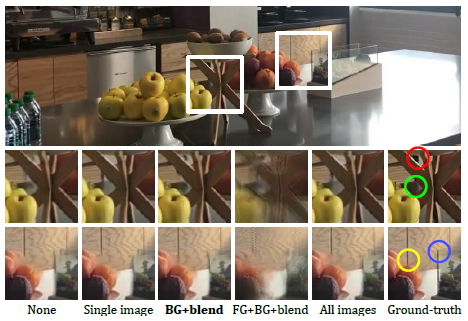

표 3에서 이러한 변형의 성능을 비교하고 그림 9에서 정성적 예를 보여줍니다.

"BG+혼합 가중치"가 다른 변형보다 약간 우월하지만 모든 변형("FG+BG+혼합 가중치" 제외)은 경쟁력 있는 결과를 생성합니다.

"없음" 및 "단일 이미지"변형은 대상 뷰에 참조 이미지에서는 가려지지만 두 번째 입력 이미지에서는 보이는 세부 정보가 포함된 영역에서 어려움을 겪습니다.

"BG+blending weights"형식은 모든 MPI 평면이 동일한 색상 데이터를 가질 필요가 없기 때문에 이러한 영역을 더 잘 나타낼 수 있습니다.

"FG+BG+blending weights"변형은 전경 이미지가 제한되지 않기 때문에 약간 더 강력하며, 각 평면에 대해 별도의 컬러 이미지가 있는 "모든 이미지"변형은 다음과 같은 장면을 완전히 표현할 수 있는 유일한 변형입니다, 2보다 큰 깊이 복잡성

그러나 우리의 실험에서 이 마지막 두 가지 변종은 모두 "없음"보다 약간 더 나빴습니다.

우리는 더 큰 출력 공간과 더 적은 참조 이미지 사용으로 인해 이러한 출력 형식으로 학습이 더 어려워지고 상대적으로 작은 카메라 움직임이 필요한 깊이 복잡성을 제한한다고 가정합니다.

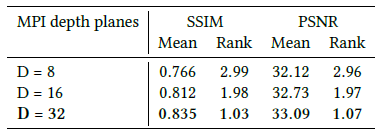

Number of depth planes.

표 4에서 볼 수 있듯이 추론된 MPI 표현에 더 많은 깊이 평면이 사용됨에 따라 모델 성능이 향상됩니다.

현재 메모리 제약으로 인해 32개의 플레인으로 제한되어 있지만 향후 하드웨어 또는 대체 네트워크로 이를 극복할 수 있습니다.

그림 10에서 볼 수 있듯이 참조 뷰와 렌더링된 뷰 사이의 오프셋이 클수록 장면을 정확하게 렌더링하는데 더 많은 평면이 필요합니다.

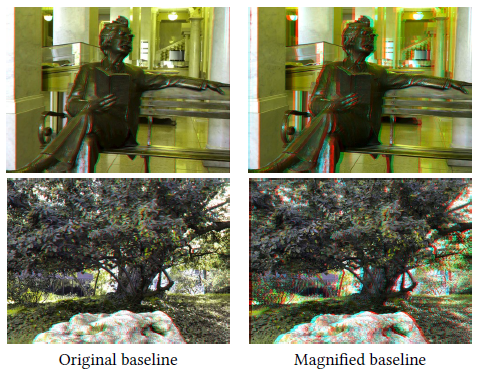

5.5. Applications

이 섹션에서는 훈련된 모델의 두 가지 애플리케이션을 설명합니다.

1) 휴대 전화 카메라에서 좁은 기준선 스테레오 쌍을 가져와 평균 인간 IPD (interpupillary-distance) 간격 스테레오 쌍으로 외삽하고

2) 대형베이스 라인 스테레오 카메라에서 이미지 쌍을 가져와 소스 이미지 사이와 그 너머의 뷰에 대한 "1D 라이트 필드"를 추정합니다.

Cell phone image pairs → IPD stereo pairs.

캡처한 두 뷰를 모두 저장하는 앱을 사용하여 기준선이 ~1.4cm인 최근 듀얼 렌즈 카메라 폰인 iPhone X로 이미지 쌍을 캡처했습니다.

두 카메라의 초점 거리가 다르기 때문에 앱은 더 좁은 시야 이미지와 일치하도록 더 넓은 각도 이미지를 자릅니다.

각 이미지 쌍에 대해 공칭 값을 초기화로 사용하여 카메라 내장 기능을 개선하는 보정 절차를 실행했습니다.

그런 다음 모델(RealEstate 데이터 학습)을 적용하여 기준선을 ~6.3cm (배율 4.5배)로 확대했습니다.

여러 결과가 그림 11에 입체 이미지로 표시되고 보조 비디오에는 흔들림 애니메이션으로 표시됩니다.

그림 11은 외삽된 이미지가 더 매력적인 3D 감각을 제공하는 방법을 강조하고 모델이 RealEstate 장면의 비정형적인 새로운 시나리오 (예 : 첫 번째 예의 Mark Twain 조각)로 일반화할 수 있는 방법을 보여줍니다.

마지막으로, 우리의 방법이 흥미로운 재료 (예 : 첫 번째 장면의 반사 유리 및 광택 바닥)를 처리할 수 있습니다.

Stereo pairs to extended 1D lightfield.

또한 큰 기준선 스테레오 쌍을 취하고 연속적인 "1D 라이트 필드"(즉, 소스 뷰를 통과하는 선을 따라 일련의 뷰)를 합성하는 방법을 보여줍니다.

이 응용 프로그램의 경우 기준선이 7.7cm인 Fujifilm FinePix Real 3D W1 스테레오 포인트 앤 슛 카메라로 촬영한 스테레오 쌍을 다운로드하고 기준선이 26.7cm인 연속 뷰 세트 (배율 ∼3.5x).

그림 12는 입체 사진으로 입력 및 출력의 예를 보여줍니다; 결과 시퀀스의 애니메이션에 대한 추가 비디오를 참조하십시오.

이 입력 기준선, 확대 계수 및 장면 콘텐츠는 우리 모델에 대한 어려운 사례를 나타내며 배경에서 늘어나는 것과 같은 아티팩트를 관찰할 수 있습니다.

그럼에도 불구하고 결과는 소스 이미지의 그럴듯한 보간 및 외삽을 보여줍니다.

6. Discussion

크고 다양한 데이터 세트에 대해 학습한 다중 평면 이미지를 기반으로한 뷰 합성 시스템은 실내 및 실외 장면을 모두 처리할 수 있습니다.

우리는 훈련 데이터 세트와는 완전히 다른 장면에 성공적으로 적용했습니다.

학습된 MPI는 부분적으로 반사되거나 투명한 표면을 나타내는데 효과적입니다.

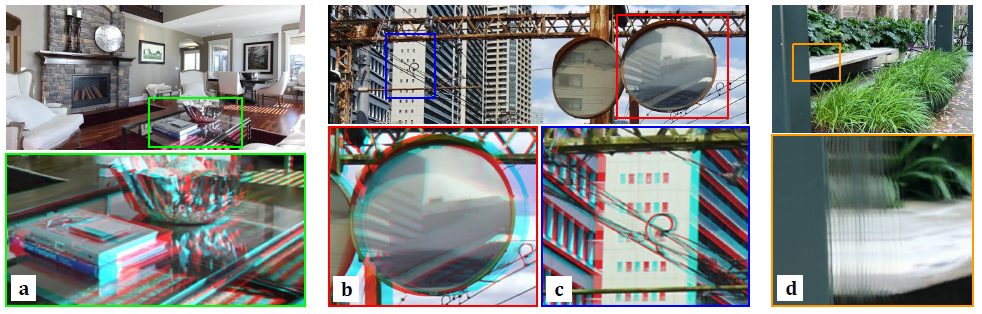

그림 13 (a)와 (b)는 입체 배율로 입체 사진으로 렌더링된 이러한 표면의 두 가지 예를 보여줍니다.

우리의 방법에는 특정한 한계가 있습니다.

복잡한 배경 앞에 미세한 디테일이 표시되면 모델을 올바른 깊이에 배치하기가 어려울 수 있습니다.

그림 13 (c)는 오버 헤드 케이블이 서로 다른 두 깊이 사이에서 점프하는 것처럼 보이는 경우를 보여줍니다.

이것은 깊이 결정이 너무 국부적으로 이루어지고 있음을 시사할 수 있습니다.

그림 13 (d)는 MPI 표현의 한계를 넘어서 외삽한 결과를 보여줍니다.

인접한 레이어 간의 차이가 1 픽셀을 초과하면 가장자리가 중복되어 "카드 스택" 효과가 나타날 수 있습니다.

결론적으로 새로운 표현, 훈련 설정 및 비디오 데이터에서 뷰 외삽을 학습하는 방법을 제시했습니다.

우리는 이 프레임 워크가 두 개 이상의 입력 이미지 또는 하나의 이미지로부터 외삽하고 여러 차원에서 뷰 이동을 허용하는 라이트 필드를 생성하는 등 다양한 작업으로 일반화할 수 있다고 믿습니다.