2022. 3. 23. 16:47ㆍ3D Vision

Mesh R-CNN

Georgia Gkioxari, Jitendra Malik, Justin Johnson

Abstract

2D 지각의 급속한 발전으로 인해 실제 영상의 물체를 정확하게 감지하는 시스템이 생겨났습니다.

그러나 이 시스템은 세계의 3D 구조를 무시하고 2D로 예측한다.

동시에, 3D 형상 예측의 진보는 대부분 합성 벤치마크와 분리된 물체에 초점을 맞추고 있습니다.

우리는 이 두 분야에서 진보를 통합한다.

우리는 실제 이미지에서 물체를 감지하여 각 물체의 완전한 3D 형상을 제공하는 삼각형 메쉬를 제작하는 시스템을 제안한다.

Mesh R-CNN이라고 하는 우리의 시스템은 메쉬의 정점과 에지에 걸쳐 작동하는 그래프 컨볼루션 네트워크로 다듬어진 거친 복셀 표현을 먼저 예측하여 다양한 위상 구조의 메쉬를 출력하는 메쉬 예측 분기로 마스크 R-CNN을 강화한다.

우리는 단일 이미지 형상 예측에 대한 이전 작업을 능가하는 ShapeNet의 메시 예측 분기를 검증한다.

다음으로 Pix3D에 풀 Mesh R-CNN 시스템을 도입하여 공동으로 물체를 검출하고 3D 모양을 예측합니다.

1. Introduction

지난 몇 년 동안 2D 물체 인식의 급속한 발전이 있었습니다.

이제 객체[19, 30, 55, 61]를 정확하게 인식하고, 2D 바운딩 박스[13, 47] 또는 마스크[18]로 지역화하고, 2D 키포인트 위치[3, 18, 65]를 어수선한 실제 이미지에서 예측할 수 있는 시스템을 구축할 수 있습니다.

뛰어난 성능에도 불구하고 이러한 시스템은 한 가지 중요한 사실을 무시합니다: 바로 세계와 그 안에 있는 사물이 3D이며 XY 이미지 평면을 넘어 확장된다는 것입니다.

동시에, 심층 네트워크를 통한 3D 형상 이해에 있어 상당한 발전이 있었습니다.

복셀[5], 포인트 클라우드[8] 및 메시[69]와 같은 다양한 3D 형상 표현을 위해 네트워크 아키텍처의 메뉴가 개발되었습니다; 각 표현은 각각의 장점과 단점을 가지고 있습니다.

그러나 이러한 다양하고 창의적인 기술 집합은 주로 렌더링된 객체로 구성된 ShapeNet [4]와 같은 합성 벤치마크에서 개발되었습니다, 이 벤치마크들은 ImageNet [52] 및 COCO[37]와 같은 2D 객체 인식에 사용되는 자연 이미지 벤치마크보다 훨씬 덜 복잡합니다.

우리는 이제까지 서로 다른 연구 방향들이 결합될 때가 되었다고 믿는다.

우리는 (현재의 2D 인식 방법과 마찬가지로) 많은 물체, 폐색 및 다양한 조명 조건을 가진 제약 없는 실제 이미지에서 작동할 수 있지만 (현재의 3D 형상 예측 방법과 마찬가지로) 세상의 풍부한 3D 구조를 무시하지 않는 시스템을 구축하기 위해 노력해야 합니다.

이 논문에서는, 이 목표를 향한 첫걸음을 내딛습니다.

우리는 최첨단 2D 인식 및 3D 형상 예측 방법을 활용하여 실제 RGB 영상을 입력하고, 영상 내 물체를 감지하며, 검출된 각 물체의 완전한 3D 형상을 제공하는 카테고리 라벨, 분할 마스크 및 3D 삼각형 메시를 출력하는 시스템을 구축합니다.

Mesh R-CNN이라고 하는 우리의 방법은 2D 인식을 위한 최첨단 Mask R-CNN[18] 시스템을 기반으로 하며, 고해상도 삼각형 메쉬를 출력하는 메쉬 예측 분기로 강화한다.

예측된 메시는 다양한 실제 물체의 3D 구조를 포착할 수 있어야 합니다.

따라서 예측 메시는 다양한 시각적 자극에 대응하여 복잡성, 위상 및 형상을 동적으로 변화시켜야 한다.

그러나, 딥 네트워크를 사용한 메시 예측에 대한 이전 연구[23, 57, 69]는 고정 메시 템플릿에서 변형되어 고정 메시 토폴로지로 제한됩니다.

그림 1과 같이 여러 개의 3D 형상 표현을 활용하여 이러한 한계를 극복했습니다. 먼저 메쉬로 변환되고 매우 정확한 메쉬 예측을 제공하도록 다듬어진 거친 복셀화 객체 표현을 예측합니다.

그림 2에서 볼 수 있듯이, 이 하이브리드 접근방식을 통해 메시 R-CNN은 미세 객체 구조를 캡처하면서 임의의 토폴로지의 메시를 출력할 수 있습니다.

2개의 데이터 세트에 대한 접근 방식을 벤치마킹합니다.

먼저, 복셀 예측과 메시 정교화의 하이브리드 접근 방식이 이전 작업보다 큰 폭으로 우수한 ShapeNet [4]의 메시 예측 분기를 평가한다.

둘째, 395개의 IKEA 가구 모델을 다양한 장면, 잡동사니, 폐색 등의 실제 이미지에 맞춘 최신 Pix3D 데이터 세트[60]에 풀 Mesh R-CNN 시스템을 도입했습니다.

지금까지 Pix3D는 완벽하게 잘린 이미지 세그먼트(41, 60, 73) 또는 Pix3D 모델의 합성 렌더링 이미지를 사용하여 ShapeNet에서 학습받은 모델의 형상 예측을 평가하는 데 주로 사용되어 왔습니다[76].

반면, Mesh R-CNN을 사용하여 Pix3D에서 모든 카테고리의 물체를 공동으로 검출하여 완전한 3D 형상을 추정할 수 있는 시스템을 최초로 학습했습니다.

2. Related Work

이 시스템은 단일 RGB 이미지를 입력하고 검출된 객체 인스턴스 세트를 출력하며 각 객체에 대해 삼각형 메시를 사용합니다.

우리의 작업은 2D 객체 인식과 3D 형상 예측의 최근 발전과 가장 직접적으로 관련이 있습니다.

우리는 또한 다른 3D 인식 작업에 대한 작업으로부터 더 폭넓게 이끌어냅니다.

2D Object Recognition

2D 객체 인식 방법은 객체별로 예측되는 정보의 유형과 전체 시스템 아키텍처에서 모두 다릅니다.

Object detector는 객체별 바운딩 박스 및 범주 레이블 [12, 13, 36, 38, 46, 47]을 출력하고, Mask R-CNN [18]은 인스턴스 세그맨테이션 마스크를 추가로 출력합니다.

우리의 방법은 이 작업 라인을 확장하여 객체당 완전한 3D 메쉬를 출력합니다.

Single-View Shape Prediction

최근의 접근법은 단일 영상 3D 재구성에 다양한 형상 표현을 사용한다.

일부 방법은 알려진 모양의 방향 [10, 20] 또는 3D 포즈 [31, 44, 66]를 예측합니다.

다른 접근법은 3D 점[8, 34], 패치[15, 70] 또는 기하학적 원소의 집합[9, 64, 67]으로 새로운 3D 형태를 예측하며, 다른 접근법은 심층 네트워크를 사용하여 부호 거리 함수를 모델링합니다[42].

이러한 방법은 복잡한 형상을 유연하게 나타낼 수 있지만, 방수 메쉬 출력을 추출하기 위해 후처리에 의존합니다.

일부 방법은 정규 복셀 그리드[5, 71, 72]를 예측합니다; 직관적이긴 하지만 고해상도 출력으로 확장하려면 복잡한 8진수[50, 62] 또는 내포 형상 아키텍처[49]가 필요합니다.

다른 것들은 삼각형 메쉬를 직접 출력하지만 고정된 [56, 57, 69] 또는 검색된 메쉬 템플릿[51]에서 변형되어 표현 가능한 토폴로지를 제한한다.

우리의 접근 방식은 복셀 예측과 메시 변형의 혼합을 사용하여 임의의 토폴로지를 유연하게 나타낼 수 있는 고해상도 출력 형태를 가능하게 한다.

일부 방법은 3D 주석 없이 3D 모양을 재구성합니다 [23, 25, 48, 68, 75].

이것은 중요한 방향이지만, 2D 인식에 대한 강력한 감독이 성공했기 때문에 현재 우리는 완전한 감독 사례만을 고려하고 있습니다.

Multi-View Shape Prediction

고전적인 쌍안 스테레오[17, 53]에서 형태 우선[1, 2, 6, 21] 및 현대 학습 기법[24, 26, 54]에 이르기까지 사물과 장면의 다중 뷰 재구성에 대한 광범위한 연구가 있다.

이 작업에서는 단일 이미지 형태 재구성에 초점을 맞춥니다.

3D Inputs

우리의 방법은 2D 이미지를 입력하고 의미 라벨과 3D 모양을 예측합니다.

depth 센서의 가용성이 증가함에 따라, RGB-D 영상[16, 58]과 포인트 클라우드[14, 32, 45, 59, 63]와 같은 3D 입력에서 의미 레이블을 예측하는 방법에 대한 관심이 높아지고 있다.

3D 입력을 방법에 포함시키면 형상 예측의 충실도를 높일 수 있을 것으로 예상합니다.

Datasets

2D 인식의 발전은 ImageNet[52] 및 COCO[37]와 같은 주석이 달린 대규모 데이터 세트에 의해 주도되었습니다.

3D 형태 예측을 위한 데이터 세트는 3D 주석을 수집하기 어렵기 때문에 2D 데이터 세트에 비해 뒤처졌습니다.

ShapeNet [4]는 합성 이미지를 제공하기 위해 렌더링되는 CAD 모델의 대규모 데이터 세트입니다.

IKEA 데이터 세트[33]는 IKEA 객체의 CAD 모델을 실제 이미지에 맞춥니다; Pix3D[60]는 이 아이디어를 더 큰 이미지 및 모델 세트로 확장합니다.

Pascal3D [74]는 CAD 모델을 실제 이미지에 정렬하지만, CAD 모델과 테스트 세트가 동일한 작은 모델 세트를 공유하므로 형상 재구성에 적합하지 않습니다.

KITTI [11]는 3D 바운딩 박스를 사용하여 야외 거리 장면에 주석을 달지만 모양 주석을 제공하지 않습니다.

3. Method

우리의 목표는 단일 이미지를 입력하고, 모든 물체를 감지하고, 감지된 물체별로 카테고리 라벨, 바운딩 박스, 분할 마스크 및 3D 삼각형 메시를 출력하는 시스템을 설계하는 것입니다.

우리의 시스템은 어수선한 실제 이미지를 처리할 수 있어야 하며 엔드 투 엔드로 학습할 수 있어야 합니다.

다양한 복잡한 실제 객체를 수용하기 위해 출력 메쉬를 고정 토폴로지로 제한해서는 안 됩니다.

우리는 최첨단 2D 지각과 3D 형태 예측을 결합함으로써 이러한 목표를 달성합니다.

특히 SOTA 2D 인식 시스템인 Mask R-CNN [18]을 기반으로 합니다.

Mask R-CNN은 엔드 투 엔드 영역 기반 object detector입니다.

단일 RGB 영상을 입력하고 탐지된 각 개체에 대한 바운딩 박스, 범주 레이블 및 분할 마스크를 출력합니다.

이미지는 처음에 백본네트워크(예를 들어 ResNet-50-FPN [35])를 통해 전달되며 다음으로 Region Proposal Network(RPN)[47]는 객체 분류 및 마스크 예측 브랜치로 처리되는 객체 제안을 제공합니다.

Mask R-CNN의 성공 중 일부는 입력 이미지와 최종 예측 분기에서 사용되는 피쳐 간의 정렬을 유지하면서 이미지 피쳐에서 영역 피쳐를 추출하는 RoIAlign 덕분입니다.

우리는 3D 형상을 예측할 때 유사한 형상 정렬을 유지하는 것을 목표로 합니다.

복셀 분기와 메시 정제 분기로 구성된 새로운 메시 예측기를 사용하여 3D 형상을 추론한다.

복셀 분기는 먼저 객체의 coarse 3D 복셀화를 추정하여 초기 삼각형 메시로 변환합니다.

그런 다음 메시 미세화 분기는 메시의 가장자리에 걸쳐 작동하는 그래프 컨볼루션 레이어 시퀀스를 사용하여 이 초기 메시의 정점 위치를 조정합니다.

복셀 분기와 메시 미세 조정 분기는 Mask R-CNN의 기존 상자 및 마스크 분기와 상동입니다.

모두 RPN 제안에 대응하는 입력 이미지 정렬 기능으로 간주됩니다.

아래에서 자세히 설명하는 복셀 및 메시 손실은 상자 및 마스크 손실에 추가되며 전체 시스템이 엔드 투 엔드로 학습됩니다.

출력은 예측 객체 점수, 마스크 및 3D 모양과 함께 상자 세트입니다.

이 시스템을 Mesh R-CNN이라고 부릅니다(그림 3 참조).

이제 복셀 분기 및 메시 정제 분기로 구성된 메시 예측 변수와 관련된 손실을 자세히 설명하겠습니다.

3.1. Mesh Predictor

우리 시스템의 핵심에는 물체의 바운딩 박스에 정렬된 컨볼루션 피쳐를 수신하고 물체의 완전한 3D 형상을 제공하는 삼각형 메시를 예측하는 메시 예측기가 있습니다.

Mask R-CNN과 마찬가지로 영역별 및 정점별 정렬 연산자(RoIAlign 및 VertAlign)를 통해 모든 처리 단계에서 사용되는 피쳐와 입력 이미지 간의 대응 관계를 유지합니다.

우리의 목표는 모든 객체의 인스턴스별 3D 모양을 이미지 내에 캡처하는 것입니다.

따라서 예측된 각 메쉬에는 인스턴스 고유의 토폴로지(일반, 정점 수, 면, 연결된 컴포넌트)와 지오메트리(기하 위치)가 있어야 합니다.

형상 추론 연산의 시퀀스를 배치하여 다양한 메쉬 토폴로지를 예측한다.

첫째, 복셀 분기는 Mask R-CNN의 마스크 분기와 유사하게 각 개체의 모양을 상향식 복셀화 예측합니다.

이러한 예측은 메시로 변환되고 메시 미세 조정 헤드에 의해 조정되어 최종 예측 메시가 제공됩니다.

메시 예측 변수의 출력은 각 물체에 대한 삼각형 메시 T = (V, F)입니다.

V = {v_i ∈ R^3}은 정점 위치의 집합이고 F ⊆ V x V x V는 삼각형 면의 집합이다.

3.1.1 Voxel Branch

복셀 분기는 검출된 각 물체의 coarse 3D 형태를 제공하는 복셀 점유 확률의 그리드를 예측합니다.

Mask R-CNN의 마스크 예측 분기의 3D 아날로그로 볼 수 있습니다: 이미지 평면에서 물체의 형상을 나타내는 M x M 그리드를 예측하는 것이 아니라 물체의 완전한 3D 모양을 제공하는 G x G x G 그리드를 예측합니다.

Mask R-CNN과 마찬가지로 RoIAlign에 따른 입력 피쳐 맵에 작은 완전 컨볼루션 네트워크[39]를 적용하여 입력 피쳐와 예측 복셀 간의 대응 관계를 유지한다.

이 네트워크는 입력의 각 위치에 대한 복셀 점유율 점수 열을 제공하는 G 채널과 함께 피쳐 맵을 생성합니다.

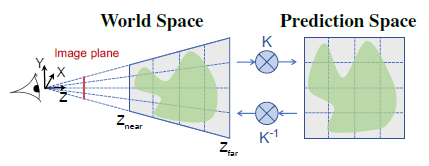

3D에서는 물체가 카메라에서 멀어질수록 작아지기 때문에 이미지와 예측 사이의 픽셀 단위 대응성을 유지하는 것이 복잡합니다.

그림 4와 같이, 우리는 카메라의 (알려진) 고유 행렬을 사용하여 좌골 모양의 복셀을 예측함으로써 이것을 설명한다.

Cubify: Voxel to Mesh

복셀 분기는 객체의 coarse 모양을 제공하는 점유 확률의 3D 그리드를 생성합니다.

보다 세밀한 3D 형상을 예측하기 위해 복셀 예측을 삼각형 메시로 변환하여 메시 미세화 분기에 전달하고자 합니다.

Cubify라고 하는 조작으로 이 갭을 메웁니다.

복셀 점유 확률과 복셀 점유율을 이진화하기 위한 임계값을 입력합니다.

점유된 각 복셀은 정점 8개, 모서리 18개 및 면 12개가 있는 입방체 삼각형 메시로 대체됩니다.

인접한 점유 복셀간의 공유 정점과 엣지가 결합되어 공유된 내부면이 제거된다.

따라서 위상이 복셀 예측에 따라 달라지는 방수 메시가 생성됩니다.

Cubify는 효율적이고 일괄 처리되어야 합니다.

이것은 단순한 것이 아닙니다, 부록 A에서 이를 실현하는 방법에 대한 기술적인 구현 세부사항을 제공합니다.

대체적으로 마칭 큐브 [40]는 복셀 그리드로부터 등서면을 추출할 수 있지만, 훨씬 더 복잡하다.

Voxel Loss

복셀 분기는 예측 복셀 점유 확률과 참 복셀 점유율 사이의 이진 교차 엔트로피를 최소화하도록 훈련된다.

3.1.2 Mesh Refinement Branch

복셀 분기의 큐브화된 메시는 coarse 3D 형태만 제공하며 의자 다리와 같은 미세한 구조를 정확하게 모델링할 수 없습니다.

메시 미세화 분기는 이 초기 입체화된 메시를 처리하여 일련의 미세화 단계를 통해 정점 위치를 미세화합니다.

[69]와 마찬가지로 각 미세화 단계는 정점에 대한 이미지 피쳐를 추출하는 정점 정렬, 메시 에지를 따라 정보를 전파하는 그래프 컨볼루션 및 정점 위치를 업데이트하는 정점 미세화의 세 가지 작업으로 구성됩니다.

네트워크의 각 층은 메쉬 정점별로 3D 위치 v_i와 특징 벡터 f_i를 유지한다.

Vertex Alignment는 각 메시 정점에 대해 영상 정렬 피쳐 벡터를 생성합니다.

카메라의 고유 행렬을 사용하여 각 정점을 이미지 평면에 투영합니다.

피쳐 맵이 주어지면, 투영된 각 정점 위치에서 bilinearly 보간 영상 피쳐를 계산한다[22].

메시 정제 브랜치의 첫 번째 단계에서 VertAlign은 각 정점에 대해 초기 특징 벡터를 출력한다.

후속 단계에서는 VertAlign 출력이 이전 단계의 정점 피쳐와 연결됩니다

Graph Convolution [29]는 메시 에지를 따라 정보를 전파합니다.

입력 정점 특징 {f_i}이 주어지면 업데이트된 특징 f'_i=ReLU(W_0 f_i + ∑_(j∈N(i)) W_1 f_j)를 계산한다, 여기서 N(i)은 메시에서 i번째 정점의 인접 관계를 제공하고 W_0과 W_1은 학습된 가중치 행렬이다.

메시 미세화 분기의 각 단계는 여러 그래프 컨볼루션 레이어를 사용하여 로컬 메시 영역에 대한 정보를 집약합니다.

Vertex Refinement는 업데이트된 정점 위치 v'_i = v_i + tanh(W_vert [f_i; v_i])를 계산합니다, 여기서 W_vert는 학습된 가중치 행렬입니다.

이렇게 하면 메쉬 형상이 업데이트되어 토폴로지가 고정된 상태로 유지됩니다.

메쉬 정제 브랜치의 각 스테이지가 정점 미세화로 종료되어 중간 메쉬 출력을 생성하며, 다음 스테이지에 의해 한층 더 미세화된다.

Mesh Losses

삼각 메시에서 기본적으로 작동하는 손실을 정의하는 것은 어렵기 때문에 대신 유한한 점 집합에 대해 정의된 손실 함수를 사용합니다.

표면을 조밀하게 샘플링하여 포인트 클라우드 메시를 표현합니다.

따라서 포인트 클라우드 손실은 모양에 대한 손실에 가깝습니다.

[57]과 유사하게, 우리는 포인트(및 그 정규 벡터)를 메쉬 표면에서 균일하게 샘플링하기 위해 미분 가능한 메쉬 샘플링 연산을 사용한다.

이를 위해 효율적인 일괄 샘플러를 구현합니다; 자세한 내용은 부록 B를 참조하십시오.

이 연산을 사용하여 실측 메시에서 포인트 클라우드 P^gt를 샘플링하고 모델의 각 중간 메시 예측에서 포인트 클라우드 P^i를 샘플링한다.

정규 벡터를 가진 2개의 포인트 클라우드 P, Q가 주어졌을 때, Λ_(P, Q) = {(p, arg min_q |p - q|) : p ∈ P}는 Q에서 p의 가장 가까운 이웃인 쌍(p, q) 세트이며, p에 대한 정규값으로 한다.

포인트 클라우드 P와 Q 사이의 chamfer 거리는

에 의해 주어지고 (absolute) normal 거리는

에 의해 주어집니다.

chamfer와 normal 거리는 두 포인트 클라우드 사이의 불일치 위치와 규범에 불이익을 주지만, 이러한 거리를 최소화하면 퇴화 메시가 발생한다(그림 5 참조).

고품질 메시 예측에는 추가 형상 정규화기가 필요합니다, 이를 위해 E ⊆ V x V가 예측된 메쉬의 에지인 에지 손실

를 사용합니다.

또는 라플라시안 손실[7]도 평활도 제약을 가한다.

i번째 단 메시 손실은 L_cham(P^i, P^gt), L_norm(P^i, P^gt) 및 L_edge(V^i, E^i)의 가중치 합이다.

메시 정제 분기는 모든 정제 단계에서 이러한 손실의 평균을 최소화하도록 훈련됩니다.

4. Experiment

Mesh Predictor를 ShapeNet [4]에서 벤치마킹하여 SOTA 접근 방식과 비교합니다.

그런 다음 Pix3D 데이터세트 챌린지에서 야생의 3D 형상 예측 작업을 위해 전체 Mesh R-CNN을 평가합니다[60].

4.1. ShapeNet

ShapeNet[4]은 WordNet[43]에 이어 의미 범주로 구성된 질감 CAD 모델로 표현되는 3D 모양 모음을 제공하며, 3D 모양 예측의 벤치마크로 널리 사용되고 있습니다.

ShapeNetCore.v1의 서브셋과 [5]의 렌더링된 이미지를 사용합니다.

각 메쉬를 최대 24개의 랜덤 뷰 포인트에서 렌더링하여 137x137 크기의 RGB 이미지를 제공합니다.

우리는 [69]에서 제공하는 학습/테스트 분할을 사용합니다, [69]는 학습에 35,011 모델 (840,189 이미지)과 테스트에 8,757 모델 (210,051 이미지)을 할당합니다, 학습과 테스트에 사용된 모델은 분리됩니다.

학습 모델의 5%를 검증 세트로 예약합니다.

이 데이터 집합의 작업은 빈 배경에 렌더링된 ShapeNet 모델의 단일 RGB 이미지를 입력하고 카메라 좌표계의 객체에 대한 3D 메시를 출력하는 것입니다.

학습 중에 시스템은 이미지와 메시 쌍으로 감독됩니다.

Evaluation

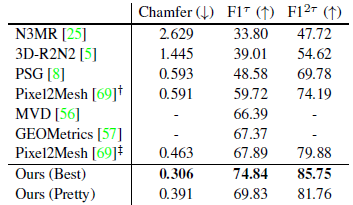

우리는 최근 연구에 사용된 평가 지표를 채택한다[56, 57, 69].

예측 및 실측 메시의 표면에서 무작위로 10,000개의 점을 균일하게 샘플링한다, 그리고 다양한 거리 임계값에서 Chamfer 거리(식 1), 정규 일관성 및 F1^τ(식 1 - 식 2)을 계산하는 데 사용합니다, 이것은 τ에서의 정밀도(ground-truth 점 τ 내의 예측점)와 τ에서의 회수(ground-truth 점 τ 내의 예측점)의 조화 평균이다.

Chamfer 거리에는 작을수록 좋고 다른 모든 메트릭에는 높으면 좋습니다.

통상적인 일관성을 제외하고, 이러한 메트릭은 메쉬의 절대적인 스케일에 의존합니다.

표 1에서 우리는 [69]를 따르고 0.57의 배수로 스케일을 조정한다; 다른 모든 결과의 경우, 우리는 [8]을 따라 스케일을 조정하여 ground-truth 메시 바운딩 박스의 가장 긴 가장자리의 길이가 10이 되도록 한다.

Implementation Detail

우리의 백본피처 추출기는 ImageNet 상에서 ResNet-50이 사전에 훈련되어 있습니다.

이미지는 단일 객체를 나타내므로 복셀 브랜치는 전체 conv5_3 피쳐 맵을 수신하고 24x24로 크기를 조정하여 48x48x48 복셀 그리드를 예측합니다.

VertAlign 연산자는 128차원 벡터에 투영하기 전에 conv2_3, conv3_4, conv4_6, conv5_3의 피쳐 연결합니다.

메시 미세화 분기에는 3단계가 있으며, 각 단계에는 6개의 그래프 컨볼루션 레이어(치수 128)가 3개의 잔존 블록으로 구성되어 있습니다.

우리는 Adam [27]을 사용하여 8개의 Tesla V100 GPU에서 배치당 32개의 이미지와 10^-4의 학습 속도로 25 에폭을 학습한다.

큐비피 임계값을 0.2로 설정하고 손실의 가중치를 λ_voxel = 1, λ_cham = 1, λ_norm = 0 및 λ_edge = 0.2로 설정합니다.

Baselines

단일 이미지 형상 예측을 위해 이전에 발표된 방법과 비교한다.

N3MR [25]은 3D 감독 없이 차별화 가능한 렌더러를 통해 메시에 맞는 약하게 감독된 접근 방식입니다.

3D-R2N2 [5] 및 MVD [56] 출력 복셀 예측.

PSG [8]는 포인트 클라우드를 예측합니다.

부록 D는 OccNet [42]과 추가로 비교됩니다.

Pixel2Mesh [69]는 초기 타원체를 변형 및 세분화하여 메시를 예측한다.

GEOMetrics [57]는 적응형 면 분할로 [69]를 확장합니다.

둘 다 Chamfer 거리를 최소화하도록 학습되지만 [69]는 예측 메시 정점을 사용하여 계산하고 [57]은 예측 메시로부터 균일하게 표본 추출된 점을 사용한다.

테스트 시간 평가와 일치하기 때문에 후자를 채택하고 있습니다.

우리와 달리, 이 방법들은 0속의 연결된 메시만을 예측할 수 있다.

학습 레시피와 백본 아키텍처는 이전 작업마다 다릅니다.

따라서 방법과 공정한 비교를 위해 모델의 여러 ablated 버전과 비교한다(정확한 자세한 내용은 부록 C 참조):

· Voxel-Only: Voxel 분기에서 입방체화된 메시로 끝나는 당사의 메서드 버전입니다.

· Pixel2Mesh+: Pixel2Mesh [69]를 재실행했습니다; 백본이 깊어지고 트레이닝 레시피가 향상되어 정점 위치가 아닌 샘플로 챔퍼를 최소화했기 때문에 오리지널 모델보다 성능이 우수합니다.

· Sphere-Init: Pixel2Mesh+와 비슷하지만 고해상도 구면 메시에서 초기화되어 분할 없이 정점 미세화의 3단계를 수행합니다.

· Ours (light): 단계당 3개의 그래프 컨볼루션 레이어가 있는 작은 비잔차 메시 미세화 분기를 사용합니다. Pix3D에 이 경량 디자인을 채용합니다.

기본적으로 Voxel-Only는 메쉬 미세화 분기를 생략하는 방법 버전이며, Pixel2Mesh+와 Sphere-Init은 복셀 예측 분기를 생략한다.

Best vs Pretty

앞서 [69](섹션 4.1) 언급한 바와 같이 형상 재구성을 위한 표준 지표는 메시 품질과 잘 상관관계가 없다.

그림 5는 형상 정규화 없이 학습된 모델이 불규칙한 크기의 면과 많은 자체 교차로 인해 매우 퇴화됨에도 불구하고 측정기준에 의해 선호되는 메시를 제공한다는 것을 보여준다.

이러한 퇴화 메시는 텍스처가 어려워 다운스트림 애플리케이션에는 도움이 되지 않을 수 있습니다.

형상 정규화가 메시 품질과 정량적 지표 모두에 미치는 영향이 강하기 때문에 동일한 형상 정규화로 학습한 방법만 정량적으로 비교할 것을 제안한다.

따라서 모든 ShapeNet 모델의 두 가지 버전을 학습합니다: 정량적 퍼포먼스의 상한으로 기능하는 λ_edge = 0의 Best 버전 및 λ_edge = 0.2로 설정함으로써 정량적 퍼포먼스와 메쉬 품질 사이에서 균형을 이루는 Pretty 버전.

Comparison with Prior Work

표 1은 Pretty 모델과 Best 모델을 단일 이미지에서 형상 예측에 관한 이전 작업과 비교한 것입니다.

0.57 메시 스케일링 팩터와 임계값 θ = 10^-4 on 유클리드 거리를 사용하여 [69]의 평가 프로토콜을 사용한다.

Pixel2Mesh의 경우, 우리는 오픈 소스 사전 학습 모델의 성능뿐만 아니라 논문 [69]에 보고된 성능을 제공합니다.

표 1은 메시 예측기의 설계를 검증하면서 이전 작업보다 훨씬 더 우수한 성능을 발휘한다는 것을 보여줍니다.

Ablation Study

4.2. Pix3D

이제 Pix3D[60]로 넘어가겠습니다, Pix3D는 10069의 실제 이미지와 395개의 독자적인 3D 모델로 구성되어 있습니다.

여기서는 알려진 개체 범주에 대한 3D 모양을 공동으로 감지하고 예측하는 작업을 수행합니다.

Pix3D는 표준 학습/테스트 분할을 제공하지 않기 때문에 자체 분할을 2개 준비하고 있습니다.

첫 번째 분할인 S1은 트레이닝용 7539개의 이미지와 테스트용 2530개의 이미지를 랜덤으로 할당합니다.

S1은 ShapeNet에 비해 고유한 객체 모델이 적지만 동일한 모델이 다양한 외관(예: 색상, 텍스처), 다른 방향, 다른 조명 조건, 다른 컨텍스트 및 다양한 흡착으로 나타날 수 있기 때문에 어려움이 있습니다.

이는 공백 배경에 객체가 나타나는 ShapeNet과 매우 대조적입니다.

두 번째 분할인 S2는 더욱 까다롭습니다: 학습과 테스트 세트에 등장하는 3D 모델이 분리되도록 보장합니다.

이 분할에 성공하려면 S1에 있는 변형뿐만 아니라 알려진 범주의 새로운 3D 형태에 대한 일반화가 필요합니다: 예를 들어 모델은 학습 중에 부엌 의자를 볼 수 있지만 테스트 중에 안락의자를 인식해야 합니다.

이 분할은 Pix3D만의 주석 구조로 가능하기 때문에 2D 인식과 3D 형상 예측 모두 흥미로운 과제가 되고 있습니다.

Evaluation

AP^box, AP^mask 및 AP^mesh와 같은 2D 인식에 사용된 지표에서 영감을 얻은 지표를 채택한다.

첫 번째 2개는 Intersection-over-Union(IoU) 0.5에서 COCO 객체 검출 및 인스턴스 분할 평가에 사용되는 표준 메트릭입니다.

AP^mesh는 3D 형상 예측을 평가한다: 이는 0.5에서 F1^0.3에 대한 범주별 정밀도-호출 곡선 아래의 평균 영역이다.

Pix3D에는 완전한 주석이 붙어 있지 않기 때문에 평가에서는 ground-truth 영역을 포함한 박스 IoU > 0.3의 예측만을 고려합니다.

이렇게 하면 비주석 객체에 해당하는 올바른 예측에 대해 모델에 불이익을 주는 것을 피할 수 있습니다.

Implementation details

백본 CNN으로 ResNet-50-FPN [35]를 사용하고 있습니다; 박스 브랜치와 마스크 브랜치는 Mask R-CNN과 동일합니다.

복셀 분기는 마스크 분기와 유사하지만 24x24 복셀 예측을 제공하는 메모리 제약으로 인해 풀링 해상도가 12(마스크의 경우 14)로 감소합니다.

섹션 4.1의 메쉬 정제 분기에 경량 설계를 채택했습니다.

8개의 Tesla V100 GPU(GPU당 2개의 이미지)에서 이미지당 64개의 배치 크기로 12에폭을 학습합니다.

SGD를 모멘텀과 함께 사용하여 첫 번째 1K 반복에서 학습 속도를 0.002에서 0.02로 선형적으로 증가시킨 다음 8K 및 10K 반복에서 10배 감소시킨다.

COCO에서 인스턴스 분할을 위해 사전 검증된 모델에서 초기화합니다.

입방체화 임계값을 0.2로 설정하고 손실 가중치를 λ_namel = 3, λ_cham = 1, λ_norm = 0.1 및 λ_edge = 1로 설정했으며 체중 감쇠 10^-4를 사용한다. 검출 손실 가중치는 Mask R-CNN과 동일하다.

Comparison to Baselines

섹션 1에서 설명한 바와 같이 Pix3D에서 야생에서의 조인트 검출과 형상 추론을 최초로 실시했습니다.

접근 방식을 검증하기 위해 전체 메시 예측기를 Voxel-Only, Pixel2Mesh+ 및 Sphere-Init 분기로 대체하여 Mesh R-CNN의 ablated 버전과 비교한다(섹션 4.1 참조).

그렇지 않으면 모든 기준선에서 동일한 아키텍처와 학습 방법이 사용됩니다.

표 3(위)은 S1의 퍼포먼스를 나타내고 있습니다.

우리는 다음과 같이 관찰한다: (a) Mesh R-CNN은 모든 기준선을 능가하며, 차상위보다 전체 및 대부분의 범주에 걸쳐 10.6%의 AP^mesh가 개선된다. Tool 및 Misc에는 테스트 세트 인스턴스가 거의 없기 때문에(각각 11과 20), AP에 노이즈가 있습니다.

(b) Mesh R-CNN은 Sphere Init 대비, 책장(+21.6%), 테이블(+16.7%), 의자(+7.3%) 등 복잡한 형상을 가진 물체에서 큰 이득을 보여줍니다.

(c) Voxel-Only는 성능이 매우 낮습니다 - 이는 예측이 coarse하기 때문에 예상된 것입니다.

표 3(아래)은 보다 까다로운 S2 분할의 성능을 보여줍니다.

여기에서는 다음과 같이 관찰합니다:

(a) S1에 비해 전체 2D 인식 성능(AP^box, AP^mask)이 크게 저하되어 야생에서 새로운 형상을 인식하는 것이 어렵다는 것을 알 수 있습니다.

(b) Mesh R-CNN은 소파, 옷장 및 도구를 제외한 모든 범주에서 형상 예측을 위한 모든 기준선을 능가한다.

(c) 옷장, 도구 및 기타에 대한 절대 성능은 학습과 테스트 모델 간의 상당한 형상 차이와 학습 데이터 부족으로 인해 모든 방법에 대해 작습니다.

표 4는 COCO와 ImageNet의 프리트레이닝을 비교하여 메시 프레딕터의 다양한 아키텍처를 비교하고 있습니다.

COCO vs. ImageNet 초기화에서는 2D 인식(AP^mask 88.4 vs. 87.0) 및 3D 형상 예측(AP^mesh 51.1 vs. 48.4)이 향상됩니다.

하나의 메시 정제 단계(AP^meah 51.1 vs. 48.6)만 사용하면 형상 예측이 저하된다.

그림 2, 7, 8은 Mesh R-CNN의 예측 예를 보여줍니다.

우리의 방법은 이미지당 여러 물체를 감지하고, 의자 다리와 같은 미세한 디테일을 재구성하고, 책장이나 책상 같은 구멍이 있는 물체의 다양하고 복잡한 메시 토폴로지를 예측할 수 있다.

Discussion

공동 2D 인식 및 3D 형상 추론을 위한 새로운 시스템인 Mesh R-CNN을 제안한다.

ShapeNet에서의 접근법을 검증해, Pix3D에서의 메리트를 나타내고 있습니다.

Mesh R-CNN은 야생에서 처음으로 3D 형상 예측을 시도한 것입니다.

예를 들어 COCO에 비해 감독되는 대규모 데이터가 없음에도 불구하고, Mesh R-CNN은 유망한 결과를 보여준다.

Mesh R-CNN은 객체 중심 접근법입니다.

향후 작업에는 3D 배치, 즉 3D 장면에서 물체의 상대적 자세에 대한 추론이 포함됩니다.

'3D Vision' 카테고리의 다른 글

| GET3D: A Generative Model of High Quality 3D Textured Shapes Learned from Images (0) | 2023.02.01 |

|---|---|

| Pyramid Stereo Matching Network (0) | 2022.03.25 |

| DeepSDF: Learning Continuous Signed Distance Functions for Shape Representation (0) | 2022.03.18 |

| Occupancy Networks: Learning 3D Reconstruction in Function Space (0) | 2022.03.10 |

| Pixel2Mesh : Generating 3D Mesh Models from Single RGB Images (0) | 2022.03.04 |