2023. 3. 23. 11:33ㆍView Synthesis

NerfDiff: Single-image View Synthesis with NeRF-guided Distillation from 3D-aware Diffusion

Jiatao Gu, Alex Trevithick, Kai-En Lin, Josh Susskind, Christian Theobalt, Lingjie Liu, Ravi Ramamoorthi

Abstract

단일 이미지에서 새로운 뷰 합성은 입력과 의미론적, 물리적 일관성을 동시에 유지하면서 객체와 장면의 폐쇄된 영역을 추론해야 한다.

기존 접근 방식은 로컬 이미지 피쳐에 대한 Neural Radiance Fields (NeRF)를 조건화하고, 입력 이미지 평면에 점을 투영하며, 볼륨 렌더링을 수행하기 위해 2D 피쳐를 집계한다.

그러나 심각한 폐색 상태에서 이 투영은 불확실성을 해결하지 못하여 세부 정보가 부족한 블러 렌더링을 초래한다.

본 연구에서는 테스트 시간에 일련의 가상 뷰를 합성하고 세분화하여 3D-aware conditional diffusion model (CDM)의 지식을 NeRF로 distilling하여 이 문제를 해결하는 NerfDiff를 제안한다.

또한 CDM 샘플에서 3D 일관된 가상 뷰를 동시에 생성하고 개선된 가상 뷰를 기반으로 NeRF를 미세 조정하는 새로운 NeRF-guided distillation 알고리즘을 제안한다.

우리의 접근 방식은 ShapeNet, ABO 및 Clevr3D를 포함한 까다로운 데이터 세트에서 기존 NeRF 기반 및 지오메트리가 없는 접근 방식을 크게 능가한다.

1. Introduction

새로운 뷰 합성은 가상 및 증강 현실, 몰입형 사진 촬영, 디지털 복제품 생성을 포함한 컴퓨터 그래픽 및 비전 응용 프로그램의 핵심 구성 요소이다.

객체 또는 장면의 몇 가지 입력 뷰가 주어지면 다른 뷰 방향에서 새로운 뷰를 합성하려고 합니다.

이 문제는 새로운 관점이 폐색과 보이지 않는 영역을 설명해야 하기 때문에 어렵다.

이 문제는 image based rendering (IBR)의 초기 작업으로 거슬러 올라가는 긴 역사를 가지고 있다.

그러나 IBR 방법은 차선의 결과만 생성할 수 있으며 종종 장면별로 다르다.

최근 neural radiance fields (NeRF)는 고품질의 새로운 뷰 합성 결과를 보여주었지만, NeRF는 장면을 과적합시키기 위해 수십 또는 수백 개의 이미지가 필요하며 새로운 장면을 추론할 수 있는 일반화 기능이 없다.

이 작업은 단일 이미지에서 새로운 뷰 합성에 초점을 맞추고 있다.

이를 시도하기 위해 일반화 가능한 NeRF 모델이 제안되었으며, 이 모델에서 NeRF 표현은 3D 포인트의 투영 및 해당 이미지 피쳐의 수집에 의해 조건화된다.

이러한 접근 방식은 특히 입력 근처의 카메라에 대해 좋은 결과를 산출한다.

그러나 타겟 뷰가 입력에서 멀리 떨어져 있으면 이러한 접근 방식은 블러 결과를 산출한다.

새로운 뷰에서 보이지 않는 큰 영역의 불확실성은 입력 이미지에 투영하여 해결할 수 없다.

뚜렷한 작업 라인은 입력 뷰에 따라 조건화된 새로운 뷰를 예측하기 위해 2D 생성 모델을 활용하여 단일 이미지 뷰 합성의 불확실성 문제를 해결한다.

그러나 이러한 접근 방식은 부분적으로 3D 일관성 있는 이미지만 합성할 수 있다.

본 논문에서는 단일 뷰 입력이 주어진 다중 뷰 일관성 있고 고품질 이미지를 합성하기 위한 학습-미세 조정 프레임워크인 NerfDiff를 제안한다.

구체적으로, 학습 단계에서, 우리는 카메라-우주 삼중면 기반 NeRF를 일련의 장면에 대한 3D-aware conditional diffusion model (CDM)과 함께 공동으로 학습한다.

미세 조정 단계에서 입력 이미지가 주어진 NeRF 표현을 초기화한다.

그런 다음 NeRF 렌더링 출력에 따라 CDM에 의해 예측된 가상 이미지 세트에서 매개 변수를 미세 조정한다.

CDM 출력을 직접 사용하여 NeRF 매개 변수를 최적화하는 나이브한 미세 조정 전략은 CDM 출력이 다중 뷰 불일치하는 경향이 있기 때문에 하위 렌더링으로 이어질 것이라는 것을 발견했다.

따라서, 우리는 NeRF 표현을 업데이트하고 다중 뷰 diffusion 프로세스를 교대로 안내하는 NeRF-guided distillation을 제안한다.

이러한 방식으로 단일 이미지 뷰 합성의 불확실성은 CDM에서 보이지 않는 정보를 입력하여 해결할 수 있다; 그 동안 NeRF는 CDM을 다중 뷰 일관된 diffusion을 위해 안내할 수 있다.

제안된 파이프라인의 예는 그림 2에 나와 있습니다.

우리는 세 가지 까다로운 벤치마크에 대한 접근 방식을 평가한다.

우리의 결과는 제안된 NerfDiff가 기존의 모든 베이스라인을 크게 능가하여 다중 뷰 일관성으로 고품질 생성을 달성한다는 것을 나타낸다.

비디오 결과는 보충 자료를 참조하십시오.

우리는 주요 기여를 다음과 같이 요약한다:

• 우리는 이미지 조건 NeRF와 CDM을 공동으로 학습하고, 테스트 시간에 멀티 뷰 일관된 diffusion 프로세스(§ 4.3,§ 4.4)를 사용하여 학습된 NeRF를 미세 조정하는 새로운 프레임워크인 NerfDiff를 개발한다.

• 우리는 카메라 정렬 삼중 평면을 기반으로 한 효율적인 이미지 조정 NeRF 표현을 소개하는데, 이는 CDM(§ 4.1)에서 효율적인 렌더링과 미세 조정을 가능하게 하는 핵심 구성 요소이다.

• 볼륨 렌더링을 2D diffusion 모델로 통합하여 새로운 뷰(4.2 참조)에 대한 일반화를 용이하게 하는 3D 인식 CDM을 제안한다.

2. Related Work

2.1. Diffusion models for 3D generation

diffusion 기반 생성 모델은 최근 이미지 합성에 관한 SOTA 모델이 되었으며 text-to-image 및 text-to-video 생성과 같은 매우 제한적인 작업을 처리하는 데 놀라운 결과를 보여주었다.

최근에는 diffusion 모델이 3D 생성 작업에서도 효과적인 것으로 입증되었다.

한편, 많은 방법은 포인트 클라우드, 복셀 및 필드를 포함한 3D 공간에서 diffusion을 직접 적용할 것을 제안한다.

그들 중 일부는 3D 공간에서 파생된 잠재 공간에서 diffusion을 학습한다.

그러나 이러한 접근 방식의 분명한 한계는 실제 환경에서 얻기 어려운 diffusion 프로세스를 학습하기 위해 3D ground truth가 필요하다는 것이다.

다른 한편, 몇몇 작품들은 2D 공간에서의 diffusion으로부터 3D 표현을 학습할 것을 제안한다.

예를 들어 Li et al. (2022)은 2-뷰 diffusion 모델을 기반으로 기하학을 학습한다; Anciukevicius et al. (2022)은 각 diffusion 단계에 대한 중간 3D 표현을 생성하고 렌더링하는 아키텍처를 설계한다.

우리의 방법과 동시에, 일련의 작업은 사전 학습된 2D diffusion 모델에서 직접 3D 표현을 학습하는 score distillation을 제안했다.

2.2. Single-view Novel View Synthesis

Methods beyond Neural Fields

단일 뷰 3D 재구성에 대한 대부분의 초기 시도는 물체의 기하학적 구조를 추정하기 위해 지상 실측 훈련 데이터에 의존했다.

이러한 방법은 일반적으로 이미지를 depth로 매핑하거나 3D 모양으로 직접 매핑합니다.

일부 방법은 미분 가능한 렌더링을 사용하여 실제 3D supervision 없이 3D 재구성 추정치를 제공하지만, 이러한 방법은 모양이 아닌 형상만 재구성하는 것으로 제한되었다.

최근에는 다른 방법으로 멀티뷰 일관성과 관계없이 새로운 뷰를 렌더링할 수 있다.

예를 들어 ENR은 3D 복셀 피쳐를 RGB로 디코딩하기 위해 투영이 있는 컨볼루션을 사용한다.

더 복잡한 장면을 타겟으로, SynSin은 미분 가능한 포인트 클라우드 렌더러와 인페인터를 사용하여 보이지 않는 영역을 추정한다.

InfiniteNature는 카메라 궤적을 따라 새로운 뷰를 반복적으로 그리기 위해 추정된 depth를 활용한다.

GeoFree 및 Pixelsynth와 같은 다른 작품들은 장면의 보이지 않는 영역을 추론하기 전에 자동 회귀를 사용한다.

마지막으로, Sajjadi et al. (2022) 및 Suhail et al. (2022)과 같은 라이트 필드 기반 방법은 입력 이미지 및 쿼리 ray의 피쳐에 트랜스포머를 조건화하여 색상을 직접 출력하거나 잠재 공간으로 직접 반전시킨다.

Methods based on Neural Fields

많은 방법은 이 작업에 신경장(예: neural radiance fields (NeRF))을 사용할 것을 제안한다.

예를 들어, SinNeRF는 pseudo 지오메트리를 사용하여 입력 이미지 근처에 새로운 뷰를 렌더링한다.

한편, Sitzmann et al. (2019a); Rematas et al. (2021); Jang & Agapito (2021); M¨uler et al. (2022b)은 전역 잠재 코드를 통합하고 테스트 시간 튜닝을 적용하여 이러한 코드를 개선한다.

이 과정은 3D NeRF 기반 GAN의 잠재 공간으로 반전되는 것과 매우 유사하다.

테스트 시 카메라 포즈(추정)가 필요하므로 고품질 결과를 방해합니다.

또한, 전역 병목 현상은 미세한 세부 사항을 포착하는 데 방해가 되며, 입력 뷰의 최적화로 인해 이러한 방법 또한 폐색을 적절하게 처리할 수 없다.

마지막으로, 이미지 조건화 방법(예: pixelNeRF 및 VisionNeRF)은 NeRF를 조건화하기 위해 로컬 이미지 피쳐를 직접 활용하며 우리의 방법과 가장 관련이 있다.

pixelNeRF와 마찬가지로 우리의 방법은 테스트 시 포즈 주석 없이 뷰 합성을 수행할 수 있다.

우리는 다음 섹션에서 이러한 유형의 방법에 대한 배경을 제공합니다.

3. Background

3.1. Image-conditioned NeRF

Neural Radiance Fields (NeRF)은 새로운 관점 합성에 현저하게 효과적인 것으로 입증되었다.

NeRF는 공간 위치 x ∈ R^3 및 ray 방향 d ∈ S^2가 주어지면 암시적 함수 f_θ : (x, d) → (c, σ)를 정의하며, 여기서 θ는 각각 학습 가능한 매개 변수, c 및 σ는 색상 및 밀도이다.

포즈 이미지 I을 렌더링하려면 각 픽셀 r(t) = x_o + td(여기서 x_o는 카메라 원점)를 통해 카메라 ray를 행진하고 볼륨 렌더링 적분의 근사치를 통해 색상을 계산합니다:

, 여기서 ω(t) = e^(-∫σ_θ(r(s))ds) σ_θ(r(t)), t_n, t_f는 각각 ray의 근거리와 원거리 경계이다.

다중 뷰 이미지를 사용할 수 있는 경우 표준 MSE loss로 θ를 쉽게 최적화할 수 있습니다:

, 여기서 R(I)는 I를 구성하는 ray의 집합이다.

고주파 세부 정보를 캡처하기 위해 NeRF는 사인파 위치 함수 ξ_pos(x); ξ_pos(d)로 x와 d를 인코딩한다.

최근 연구에 따르면 트리플 플레인과 같은 로컬 구조로 인코딩 피쳐는 품질 loss 없이 훨씬 빠른 추론 속도를 달성한다.

NeRF의 학습, 즉 식 (2)의 최적화는 충분한 다중 뷰 제약 조건을 제공하기 위해 카메라 매개 변수와 함께 수십 또는 수백 개의 이미지가 필요하다.

그러나 현실적으로 이러한 멀티뷰 데이터는 쉽게 접근할 수 없다.

따라서 이 작업은 절대 카메라 포즈를 알지 못한 채 단일 이미지에서 neural radiance fields를 복구하는 데 중점을 둔다.

이 문제는 제한이 적기 때문에 타겟 장면과 유사한 대규모 장면 세트에서 학습한 3D 유도 편향이 필요하다.

이 철학에 따라 픽셀 정렬 NeRF는 로컬 2D 이미지 피쳐로 3D 정보를 인코딩하여 학습된 표현이 많은 장면에서 학습된 후 보이지 않는 장면으로 일반화할 수 있다.

PixelNeRF

PixelNeRF를 예로 들어보자.

입력 이미지 I^s가 주어지면, PixelNeRF는 먼저 피쳐 볼륨 W = e_ψ(I^s)를 추출한다, 여기서 e_ψ는 학습 가능한 이미지 인코더이다.

그런 다음, 입력 카메라 공간의 모든 3D 포인트 x ∈ R^3에 대해, x를 알려진 intrinsic 행렬을 가진 P(x) ∈ [-1, 1]^2로 이미지 평면에 투영한 다음, 피쳐 볼륨을 ξW(x) = W(P(x))로 쌍선형 보간함으로써 해당 이미지 피쳐를 얻는다.

이미지 피쳐는 색상과 밀도를 추론하기 위해 위치 x 및 뷰 방향 d와 결합됩니다.

다음으로, NeRF와 유사하게, 카메라 ray의 색상은 볼륨 렌더링(예 1)을 통해 계산됩니다.

이러한 모델은 일련의 장면에 걸쳐 학습되며, 각 장면에 대해 재구성을 위한 학습 쌍(I^s, I)을 형성하려면 적어도 두 개의 뷰가 필요하다:

, 여기서 I_(θ, W)는 볼륨 렌더링 이미지입니다.

Challenges

그러나 기존의 단일 이미지 NeRF 접근 방식은 특히 심각한 폐색이 존재하는 경우 높은 충실도 렌더링 결과를 생성하지 못한다.

이는 합성된 폐쇄 영역이 여러 가능성을 나타낼 수 있기 때문에 단일 이미지 뷰 합성은 충분히 제한되지 않은 문제이기 때문이다.

따라서 MSE loss(예: (3))는 단일 이미지 NeRF가 가능한 모든 솔루션에서 평균 픽셀 값으로 회귀하도록 하여 부정확하고 블러 예측을 산출한다.

3.2. Geometry-free View Synthesis

불확실성 문제를 설명하기 위해, Dupont et al. (2020), Rombach et al. (2021b), Sajadi et al. (2022) 및 보다 최근의 조건적 diffusion 모델(3DiM)과 같은 2D 생성 모델을 사용하여 예측 p(I|I^s)를 명시적으로 모델링한다.

3DiM을 예로 들어 보겠습니다.

입력 뷰에서 조건화하는 가우시안 노이즈 타겟 이미지의 디노이즈하는 조건적 노이즈 예측기 ε_ɸ를 학습한다.

또한 해당 카메라가 포즈를 취한다.

이러한 모델은 디노이징 loss로 최적화될 수 있습니다:

, 여기서 Z_t = α_t I + σ_t ε, ε ~ N(0, 1), α_t^2 + σ_t^2 = 1은 I에 대한 노이즈가 있는 타겟이다.

Song & Ermon (2019)에서 보듯이, 디노이저는 분포 ε_ɸ(Z_t, I^s) ~ -σ_t ∇_Z_t log p_ɸ(Z_t|I^s)의 score 함수에 대한 근사치를 제공한다.

테스트 시 학습된 score ε_ɸ가 반복적으로 적용되고 노이즈 이미지를 세분화하여 새로운 뷰를 합성한다.

Challenges

지오메트리가 없는 모델은 일반적으로 입력 뷰 조건화와 타겟 뷰가 픽셀 단위로 정렬되지 않는 "정렬 문제"로 어려움을 겪으며 표준 UNet 기반 diffusion 모델을 적용할 때 하위 일반화로 이어진다.

Watson et al. (2022)은 입력 뷰에서 정보를 수집하기 위해 교차 어텐션을 사용하여 이 문제를 완화하려고 시도했다.

그러나 이를 위해서는 대용량의 모델이 필요하며, 이러한 수정에도 불구하고 복잡한 장면과 out-of-distribution 카메라에 대한 일반화 가능성이 여전히 더 필요하다.

또한 디노이징은 3D가 아닌 각 뷰에 대해 독립적으로 2D로 수행되기 때문에 샘플링 단계에서 CDM의 합성된 새로운 뷰는 다중 뷰 불일치하는 경향이 있다.

4. NerfDiff

두 세계의 장점을 모두 달성하기 위해 본 논문에서는 단일 이미지 뷰 합성을 위해 이미지 조건 NeRF에 diffusion 모델의 힘을 통합하는 NerfDiff라고 하는 학습 미세 조정 2단계 접근법을 제시한다.

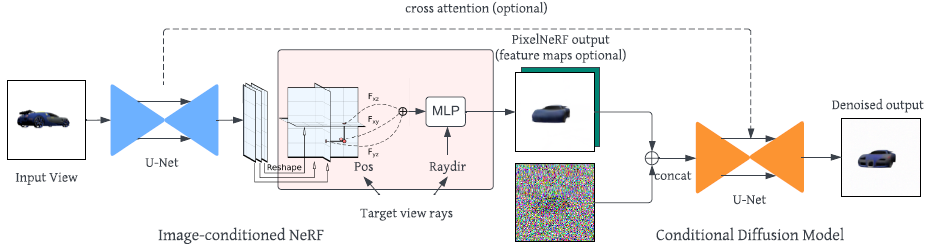

우리는 그림 2에서 제안된 두 단계의 파이프라인을 설명한다.

다음에서는 먼저 로컬 트리플 플레인 기반의 향상된 단일 이미지 NeRF(§ 4.1)와 단일 이미지 NeRF 출력(§ 4.2) 위에 구축된 3D 인식 CDM으로 구성된 NerfDiff를 소개한다.

제안된 모델의 개요는 그림 3에 제시되어 있다.

이 두 구성 요소는 동일한 학습 세트(§ 4.3)에서 공동으로 최적화됩니다.

테스트 시간에, 우리는 2단계 미세 조정을 채택한다.

또한 CDM 샘플링으로 인한 불일치 문제를 완화하기 위해 NeRF-Guided Distillation (NGD) 알고리즘을 제시하여 미세 조정 성능을 향상시킨다(§ 4.4).

4.1. Single-image NeRF with Local Triplanes

NerfDiff는 NeRF를 조절하기 위해 입력 이미지에서 직접 추출한 효율적인 카메라 정렬 삼면을 기반으로 한다.

§ 3.1에서 언급된 것처럼, 대부분의 기존 단일 뷰 모델은 이미지 평면 투영을 통해 추출된 피쳐를 쿼리합니다: P : R^3 → [-1, 1]^2.

이 작업의 한 가지 문제는 3D 포인트의 depth 정보가 추출된 피쳐에 포함되지 않는다는 것이다; 즉, 동일한 카메라 ray를 따라 있는 모든 포인트가 2D 이미지의 동일한 위치로 투영되므로 동일한 피쳐를 갖는다.

따라서, 동일한 카메라 ray를 따라 포인트를 구별하기 위해, 기존 방법은 이미지 피쳐를 포인트 x의 표현으로 전역 공간 위치 ξ_pos(x)의 위치 인코딩과 연결해야 한다.

그러나 이 3D 표현은 효율적이지 않다.

따라서 x의 색과 밀도를 추론하기 위해 이미지 피쳐와 공간 정보를 융합하기 위한 심층 MLP 네트워크가 필요하며, 이는 렌더링 프로세스를 느리게 한다.

Chan et al. (2021)에서 영감을 받아 이미지 피쳐 W를 카메라 정렬 삼면으로 재구성하는 효율적인 3D 표현을 제안한다: {W_xy, W_xz, W_yz}.

그런 다음 각 3D 점은 세 가지 평면 내에서 이중 선형 보간을 통해 고유한 피쳐 벡터를 수신합니다:

, 여기서 ~x = [P(x), 2·(x_z - t_n) / (t_f - t_n) - 1] ∈ [-1, 1]^3, t_n, t_f는 입력 카메라(식 (1))의 근거리 및 원거리 경계입니다.이 표현은 xz, yz 평면에서 depth 정보를 할당할 수 있다는 점에서 표현하기 때문에 표현을 확대하기 위해 추가 위치 인코딩 ξ_pos(x)가 필요하지 않으며, 심층 MLP 네트워크는 얕은 MLP 네트워크로 대체될 수 있다.

이를 통해 고해상도 이미지 렌더링이 효율적일 뿐만 아니라(§ 4.2) 빠른 NeRF 미세 조정이 가능하며, 이는 § 4.4에서 자세히 설명될 것입니다.

또한 입력 이미지의 카메라 공간에서 트리플 플레인을 모델링하는 것은 다음과 같은 이점이 있습니다:

(1) 트리플 플레인은 픽셀 NeRF와 마찬가지로 로컬 이미지 피쳐를 자연스럽게 보존할 수 있다.

(2) 기존 트리플 플레인 기반 방법과 다른 전역 좌표계 및 전역 카메라 포즈를 가정할 필요가 없다.

이미지 인코더의 경우 Yu et al. (2021)에 사용된 사전 학습된 ResNet이 아닌 UNet 아키텍처를 채택한다.

U-연결 및 셀프 어텐션 블록 덕분에, 출력 계층 피쳐 W = e_ψ(I)는 차단된 뷰를 예측하는 데 필수적인 로컬 및 전역 정보를 모두 포함하며, 이는 Lin et al. (1987)의 피쳐 추출기와 유사하게 작동한다.

자세한 내용은 그림 3을 참조하십시오.

4.2. 3D-aware Conditional Diffusion Models

단일 이미지 NeRF는 다중 뷰 일관성 있는 이미지를 생성하는 반면, 불확실성 문제(§ 3.1)로 인해 출력이 블러해지는 경향이 있다.

불확실성 문제를 해결하기 위해 3D 인식 CDM을 생성 프로세스를 통해 불확실성을 해결하는 NerfDiff의 두 번째 부분으로 모델링한다.

특히 CDM은 단일 이미지 NeRF의 렌더링을 타겟 뷰에 맞게 반복적으로 세분화하는 방법을 학습한다.

기하학적 구조가 없는 기존 방법과 비교하여, 우리는 단일 이미지 NeRF를 적용하여 입력 뷰 이미지를 조건화로 사용하는 대신 타겟 뷰 이미지를 조건화로 렌더링함으로써 "정렬" 문제를 피한다.

그림 3에 표시된 것처럼 노이즈가 많은 이미지가 렌더링된 이미지와 연결되는 표준 조건부 UNet 아키텍처를 채택한다.

Watson et al. (2022)과 유사하게, 우리는 또한 조건화를 강화하기 위해 CDM UNet과 인코더 UNet 사이에 교차 어텐션 블록을 사용할 수 있다.

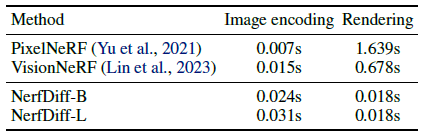

삼중 평면 렌더링의 효율성(표 3 참조)을 통해 NeRF를 CDM과 함께 학습할 수 있으며, 그렇지 않으면 너무 오래 걸릴 수 있습니다.

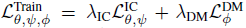

4.3. Training Phase

각 장면이 적어도 두 개의 뷰를 갖는 장면 모음을 고려할 때, 우리는 식 (3)과 (4)를 결합하여 종단 간 학습을 한다:

는 단일 이미지 NeRF와 CDM을 공동으로 최적화한다.

단일 이미지 NeRF의 학습은 광도 오류 L_(θ,ψ)^IC와 CDM 디노이징 loss L_ɸ^DM 모두로부터 supervision을 받는다.

자세한 내용은 그림 2(왼쪽)를 참조하십시오.

4.4. Fine-tuning Phase

3D 인식 CDM은 단일 이미지 NeRF의 불확실성 문제를 해결하여 합성 이미지를 더 선명하게 만들지만, 2D diffusion 프로세스가 각 새로운 뷰에 독립적으로 적용되기 때문에 다중 뷰 일관성을 손상시킨다.

다중 뷰 일관성 있고 고품질의 결과를 합성하기 위해, 우리는 CDM의 지식을 distill하기 위해 테스트 시간에 새로운 미세 조정 전략을 제안한다.

그림 2(오른쪽)에 표시된 것처럼, 보이지 않는 장면의 입력 뷰 I^s가 주어지면, 우리는 학습된 단일 이미지 NeRF 및 3D 인식 CDM으로 일련의 "가상 뷰"를 생성한다.

그런 다음 생성된 가상 뷰를 사용하여 삼중 평면 매개 변수 W = e_ψ(I^s) 및 MLP 매개 변수 θ(그림 3의 분홍색 상자)를 미세 조정한다.

여기서 우리는 W를 학습 가능한 매개 변수로 취급한다.

가상 뷰가 관심 영역을 포함할 때 최적의 성능을 발휘합니다.

NeRF Guided Distillation

나이브한 최적화 전략은 Mildenhall et al. (2020)(식. (2))의 전략과 동일하다, 즉, CDM에서 샘플링된 "가상 뷰"로 타겟을 대체한다.

우리는 일관성 없는 CDM 예측이 NeRF 모델 최적화에서 충돌을 일으키기 때문에 이러한 나이브한 최적화는 일반적으로 심각한 부동 아티팩트로 노이즈가 많은 결과를 초래한다는 것을 발견했다.

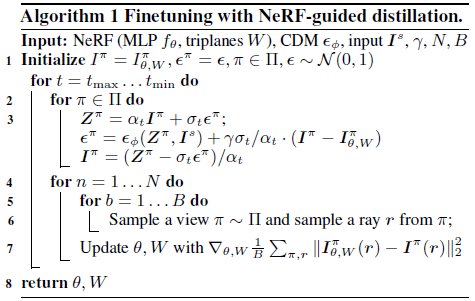

대신, 우리는 NeRF distillation과 diffusion 샘플링을 번갈아 하는 NeRF Guided Distillation (NGD)을 제안한다.

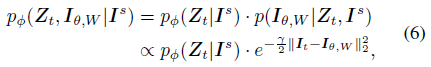

classifier guidance에서 영감을 받아 각 가상 뷰 I에 대한 공동 분포를 고려하여 3D 일관성을 다중 뷰 diffusion에 통합한다:

, 여기서 I_t = (Z_t - σ_t ε_ɸ (Z_t, I^s)) / α_t는 중간 시간 단계에서 예측된 타겟 이미지이다.

두 번째 항은 주어진 NeRF에서 다중 뷰 제약 조건을 도입한다.

따라서 목표는 공동 분포에서 가장 가능성이 높은 가상 뷰(Z_t)를 샘플링하면서 식 (6)를 최대화하는 NeRF 매개 변수(θ, W)를 찾는 것이다.

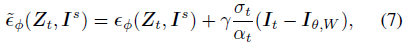

실제로, 우리는 각 diffusion 단계 t에서 반복 기반 업데이트 규칙을 채택한다.

CDM으로 가상 뷰를 생성하기 위해, 우리는 식 (6)에서 도출된 수정된 diffusion score를 따른다:

, 여기서 ~ε_ɸ는 일반 DDIM 샘플링에 사용됩니다.

γ = α_t^2 / σ_t^2(SNR)의 경우 수정된 score 식 (7)을 따르는 것은 디노이즈된 이미지를 NeRF 렌더링으로 대체하는 것과 같습니다.

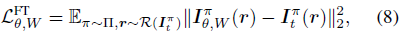

NeRF를 distilling하기 위해, 우리는 NeRF 매개 변수와 관련하여 이 공동 분포의 log likelihood를 직접 최대화하는데, 이는 모든 가상 뷰에서 디노이즈된 이미지 I_t와 NeRF 렌더링 I_(θ, W) 사이의 MSE loss를 최소화하는 것과 같다:

여기서 ∏는 입력에 대한 상대 카메라 포즈에 대한 prior 분포이고 I_t^π, I_(t,W)^π는 상대 카메라 π에 해당하는 이미지이다.

계산을 줄이기 위해 모든 뷰에서 배치 크기가 B인 ray r을 샘플링하고 해당 픽셀만 supervise하며 N 단계에 대해 미세 조정한다.

알고리즘 세부사항은 알고리즘 1에 나와 있습니다.

Relationship to SDS

우리의 방법은 최근에 제안된 score distillation sampling (SDS)과 유사점을 공유한다.

SDS도 diffusion 모델을 3D로 distill하지만 근본적인 차이가 있다.

SDS에서 랜덤 스케일 노이즈는 랜덤 각도에서 NeRF의 출력에 주입된다.

그런 다음 노이즈가 있는 이미지는 2D diffusion 모델에 의해 디노이즈되어 supervision을 제공한다.

대조적으로, 우리의 방법은 가상 뷰 세트를 초기화하고 NeRF를 사용하여 각 뷰의 diffusion 프로세스를 안내한다(그리고 교대로 이 diffusion을 기반으로 NeRF를 세분화한다).

결과적으로, 우리의 파이프라인은 자연스럽게 감소하는 노이즈 스케줄에 따라 모든 뷰에 대한 전체 diffusion 궤적을 완성한다.

부록 E에서 우리는 SDS가 우리의 방법보다 실질적으로 더 나쁜 추가 비교와 잠재적인 이유를 보여준다.

5. Experiments

5.1. Experimental Settings

Datasets

우리는 SRN-ShapeNet, Amazon-Berkeley Objects 및 Clevr3D의 세 가지 벤치마크에서 각각 단일 범주, 범주에 구애받지 않고 다중 개체 설정에서 새로운 뷰 합성을 테스트하기 위해 NerfDiff를 평가한다.

SRN-ShapeNet에는 두 가지 범주가 있습니다: Cars와 Chairs.

데이터세트 세부 정보는 부록 A에 나와 있습니다.

Baselines

단일 이미지 뷰 합성에서 SOTA 성능을 고려하여 픽셀 정렬 방법 VisionNeRF를 비교의 주요 베이스라인으로 선택한다.

우리는 또한 미세 조정 단계("우리의 (w/o NGD)"로 표시됨) 없이 제안된 단일 이미지 NeRF를 평가한다.

또한 NeRF guidance("우리의 (CDM)") 없이 CDM 예측의 질적 결과를 보여준다.

또한 SRN, CodeNeRF, FE-NVS 및 기하학적 자유 접근법 LFN 및 3DiM과 같은 다른 방법에 대해 공개적으로 사용 가능한 결과를 포함한다.

Evaluation Metrics

우리는 단일 이미지가 주어진 생성된 이미지와 타겟 뷰를 비교하고 상대적인 타겟 카메라가 입력으로 포즈를 취함으로써 모델과 베이스라인을 평가한다.

4가지 표준 메트릭을 보고합니다: PSNR, SSIM, LPIPS 및 FID.

PSNR은 픽셀당 평균 제곱 오차를 측정하는 반면 SSIM은 구조적 유사성을 측정한다; LPIPS는 이미지 간의 지각 유사성을 반영하는 심층 메트릭이다.

마지막으로 FID는 모든 테스트 장면의 렌더링된 이미지와 실제 이미지 간의 유사성을 측정한다.

다중 모드 특성으로 인해 생성 프레임워크는 일반적으로 평균 픽셀 값에 대한 근접성을 우선시하는 PSNR과 관련하여 성능이 좋지 않습니다.

5.2. Main Results

우리는 두 가지 변형 크기(NerfDiff-B:~400M 매개 변수, NerfDiff-L:~1B 매개 변수)로 결과를 보여준다.

구현 세부사항에 대한 자세한 내용은 부록 B에 나와 있습니다.

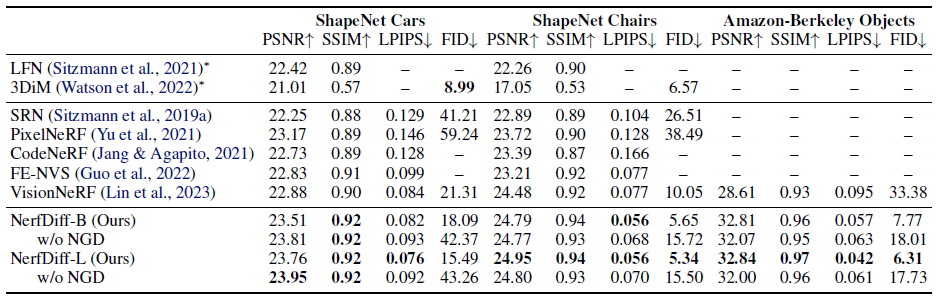

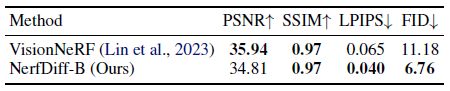

Quantitative evaluation

표 1과 2는 세 가지 데이터 세트 모두에서 제안된 모델과 SoTA 기하학적 자유 및 단일 뷰 NeRF 방법을 정량적으로 비교한 것이다.

베이스라인의 정량적 점수는 공식 문서에서 복사된다.

제안된 NerfDiff(NGD 미세 조정 유무)는 PSNR 및 SSIM의 모든 베이스라인을 크게 능가하여 로컬 3면 표현으로 정확한 픽셀 수준 세부 정보를 합성하는 모델의 능력을 보여준다.

또한 LPIPS에서 제안된 NerfDiff는 폐색 뒤에서 지각적으로 정확한 완성을 만드는 능력을 나타내는 이전의 모든 접근 방식보다 낫다.

마지막으로, FID와 관련하여, 우리의 방법은 모든 단일 뷰 NeRF 방법을 능가하며, 순수하게 2D이기 때문에 ShapeNet-Cars에서 3DiM보다 나쁜 점수만 가지고 있다.

원본 논문에서 언급한 바와 같이 3DiM은 Shapet Net-Chairs의 배포 외 테스트 카메라에 잘 일반화할 수 없으므로 성능이 저하됩니다.

대조적으로, 3D 인식 CDM을 사용하여 우리의 접근 방식은 보이지 않는 관점을 쉽게 처리할 수 있다.

또한 제안된 NGD 미세 조정은 경우에 따라 PSNR을 약간 손상시키면서 결과의 선명도를 크게 향상시켜 FID 및 LPIPS 점수를 향상시킨다.

또한 모델 크기를 확장하면 더 높은 지각 품질을 얻을 수 있다.

Qualitative evaluation

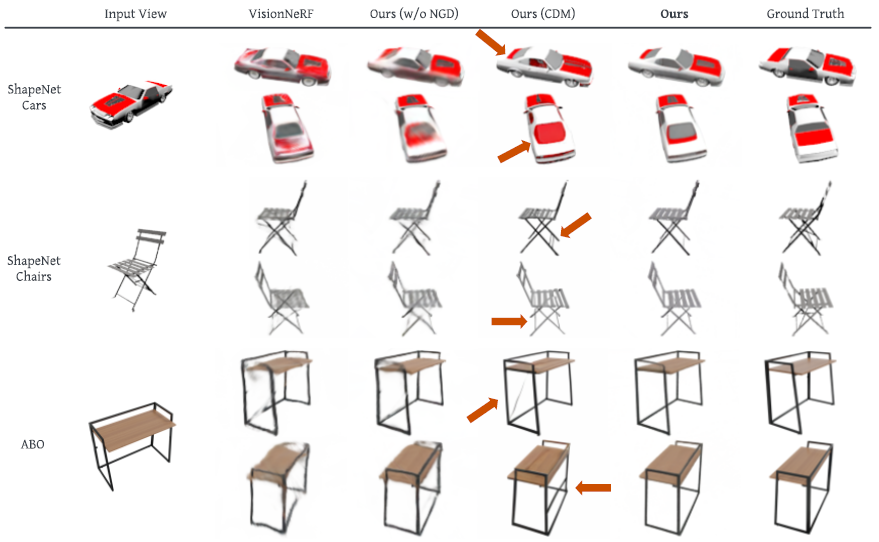

그림 4는 주요 베이스라인인 VisionNeRF와 두 가지 축소 모델에 대한 접근 방식의 질적 비교를 보여줍니다.

우리의 방법은 ShapeNet 및 ABO에서 ablate된 모델 단일 이미지 NeRF 및 VisionNeRF보다 훨씬 자세한 결과를 생성한다.

투영된 이미지 피쳐에 의존하기 때문에 이러한 방법은 폐색 뒤의 불확실성을 처리할 수 없으므로 평균 픽셀 값을 회귀시켜 블러 렌더링을 초래한다.

그림 4의 빨간색 화살표에서 알 수 있듯이 CDM 결과는 뷰 간에 더 잘 정렬되지 않고 일관성이 없습니다.

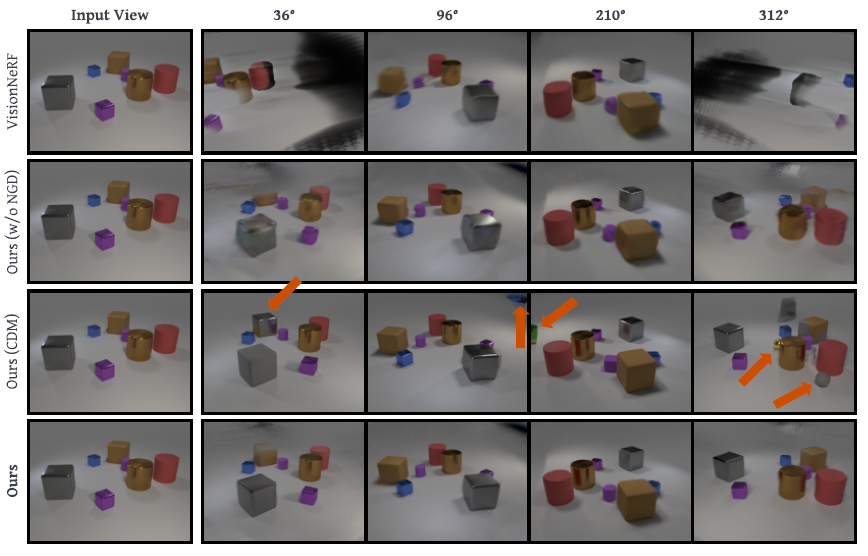

그림 5는 Clevr3D에 대한 추가적인 질적 결과를 보여줍니다.

우리의 방법은 일관되고 고품질의 렌더링을 다시 보여준다.

동시에 VisionNeRF는 카메라 분포를 지나치게 적합시키고 입력에 가까운 시점을 합성하지 못한다(자세한 내용은 부록 B 참조).

CDM 결과는 개체가 나타났다 사라졌다 하는 것과 다시 일치하지 않습니다.

우리 방법의 멀티뷰 일관성과 높은 충실도를 보여주는 비정형이고 광범위한 비디오 결과는 보충 자료를 참조하십시오.

5.3. Ablation Studies

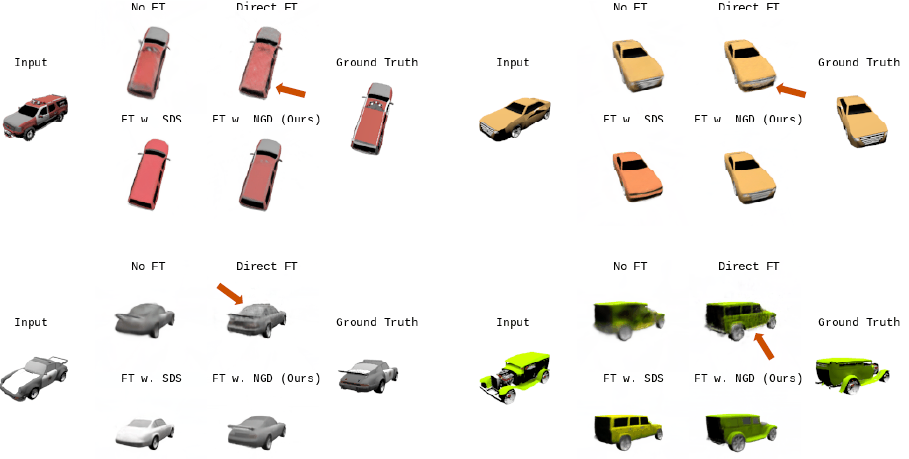

Shapenet-Cars 데이터 세트에서 ablation을 제공하여 모델의 주요 설계 선택을 검증함으로써 ablation 결과를 그림 4의 ShapeNet Cars 결과와 직접 비교할 수 있다.

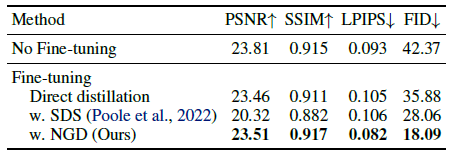

표 4에서는 CDM 기반 미세 조정 및 다양한 CDM 기반 미세 조정 전략이 없는 모델을 비교합니다.

결과에서 볼 수 있듯이 CDM으로 미세 조정하면 무조건 FID가 개선됩니다.

그러나 우리의 NGD 샘플링만이 SOTA 조건부 SSIM과 LPIPS를 산출할 것이다.

NGD와 비교한 샘플링 베이스라인인 Direct Extruation 및 SDS에 대한 자세한 내용은 부록 E를 참조하십시오.

또한 그림 6은 질적 비교를 제공한다.

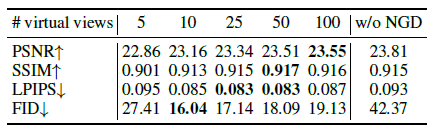

다음으로 표 5에서 미세 조정을 위한 가상 뷰 수에 대한 축소도 제공합니다.

가상 뷰가 너무 적은 경우(예: 5개) NeRF는 디노이즈된 이미지에 지나치게 적합하여 하위 렌더링을 생성한다.

우리는 50개의 가상 뷰가 효율성과 성능 사이의 좋은 균형을 제공한다는 것을 발견했다.

6. Discussion

Limitations

우리가 제안한 방법은 두 가지 주요 제한 사항이 있다.

첫째, 우리는 학습 시간에 적어도 두 개의 장면 뷰가 필요하다.

둘째로, 우리의 미세 조정 프로세스는 시간이 많이 소요되어 실시간 도메인에서 적용이 제한된다.

향후 작업에서 이러한 문제를 해결할 수 있습니다.

Future work

향후 연구를 위해 text-to-3D 파이프라인의 충실도를 향상시키기 위해 제안된 NGD를 조사할 수도 있다.

또한 Waymo Open Dataset과 같은 더 복잡한 데이터 세트를 탐색할 수 있으므로 본 논문에서와 같이 폐색 처리라는 어려운 작업을 대규모 사전 학습된 2D diffusion 모델에 맡길 수 있다.

또한 3D GAN의 맥락에서 미세 조정 전략을 통합하면 반전 성능과 3D 편집 기능도 향상될 수 있다.

마지막으로 대칭과 같은 priors를 적절하게 통합하는 방법을 찾는 것도 흥미로울 수 있다.

7. Conclusion

우리는 3D 인식 CDM을 3면 기반 이미지 조건 NeRF로 distill하는 단일 이미지 뷰 합성을 위한 생성 프레임워크인 NerfDiff를 소개했다.

또한 NeRF 렌더링을 개선하는 동시에 CDM에서 여러 뷰를 샘플링하기 위해 NeRF-guided distillation을 도입했다.

우리의 방법은 여러 도전적인 벤치마크에서 SOTA 결과를 달성했다.